简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

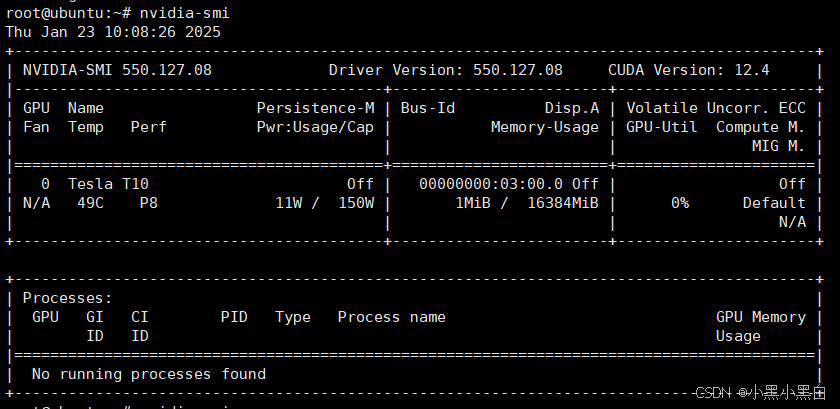

R730安装Tesla T10显卡驱动,显卡直通给ESXI虚拟机里开放的Ubuntu服务器,排除了各种情况,各种操作后reboot重启Ubuntu服务器也不管用,后面想到重启了R730服务器就可以了。nvidia-smi NVIDIA-SMI has failed because it couldn't communicate with the NVIDIA driver. Make sure t

linux系统docker部署ollama,ollama本地部署Modelfile文件构建,ollama运行Hugging Face模型,ollama自有模型是通过量化的,ollama默认Q4_K_M量化,ollama模型创建,对显存要求不高,如果显存未拉满,可以考虑去Hugging Face上下载未量化或者更高精度的量化模型,然后构建成ollama模型运行。进入ollama官网,进入对应模型详情

ollama不支持GPU张量并行,于是打算把ollama替换到vllm平台进行推理。但研究了发现由于vllm是预分配显存,--gpu_memory_utilization参数设置比例,待机会占用不少显存,没跑推理时显卡待机功耗就比较高,实测T10显卡每张卡大概50几W功耗,而ollama的OLLAMA_KEEP_ALIVE默认是5分钟空闲会释放模型显存,还能自定义时间,到一定时间未调用推理,会主动

异常信息:java.lang.NoSuchMethodError: com.sun.mail.util.TraceInputStream.<init>(Ljava/io/InputStream;Lcom/sun/mail/util/MailLogger;)V2020-11-05 16:33:49.859 [task-7] ERROR o.s.a.i.SimpleAsyncUncaugh

centos7快速搭建mongodb集群1、服务器环境centos7上mongodb 4.0.4集群三台服务器IP分别是:172.30.255.100、172.30.255.101、172.30.255.102。2、mongdb数据库的安装及配置点击下载:mongodb-linux-x86_64-4.0.4.tgz,密码:mongo404如下操作是分别在三台机器进行1、首先分别在三台...

安装oracle时./runInstaller报错:Could not execute auto check for display colors using command /usr/bin/xdpyinfo. Check if the DISPLAY variable is set.具体错误信息如下:[oracle@glxybd database]$ ./runInstallerSta...

linux系统docker部署ollama,ollama本地部署Modelfile文件构建,ollama运行Hugging Face模型,ollama自有模型是通过量化的,ollama默认Q4_K_M量化,ollama模型创建,对显存要求不高,如果显存未拉满,可以考虑去Hugging Face上下载未量化或者更高精度的量化模型,然后构建成ollama模型运行。进入ollama官网,进入对应模型详情

ollama不支持GPU张量并行,于是打算把ollama替换到vllm平台进行推理。但研究了发现由于vllm是预分配显存,--gpu_memory_utilization参数设置比例,待机会占用不少显存,没跑推理时显卡待机功耗就比较高,实测T10显卡每张卡大概50几W功耗,而ollama的OLLAMA_KEEP_ALIVE默认是5分钟空闲会释放模型显存,还能自定义时间,到一定时间未调用推理,会主动

ollama不支持GPU张量并行,于是打算把ollama替换到vllm平台进行推理。但研究了发现由于vllm是预分配显存,--gpu_memory_utilization参数设置比例,待机会占用不少显存,没跑推理时显卡待机功耗就比较高,实测T10显卡每张卡大概50几W功耗,而ollama的OLLAMA_KEEP_ALIVE默认是5分钟空闲会释放模型显存,还能自定义时间,到一定时间未调用推理,会主动

逗号分隔值(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。纯文本意味着该文件是一个字符序列,不含必须像二进制数字那样被解读的数据。CSV文件由任意数目的记录组成,记录间以某种换行符分隔;每条记录由字段组成,字段间的分隔符是其它字符或字符串。如果不想看源码分析,想直接看代码请跳到最后!!!分..