简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

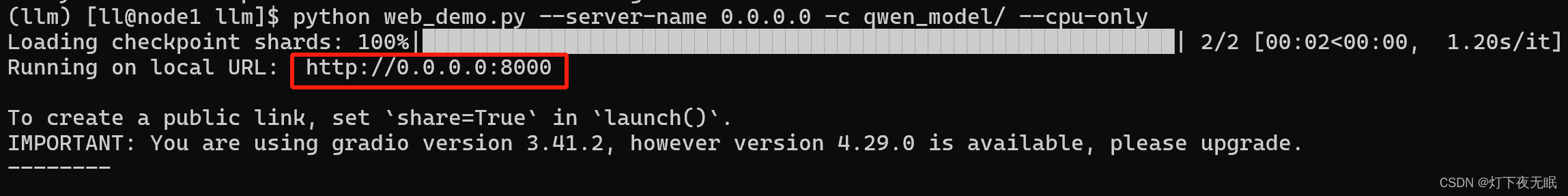

模型微调过程会使用CPU,且占用内存大概22G左右;参照官方文档:https://github.com/QwenLM/Qwen/blob/main/README_CN.md。创建环境,建议单独创建一个新环境,避免与现有环境冲突,创建后要先安装pytorch,再安装项目依赖模块。提前安装好git跟git lfs,否则可能拉取不到模型文件,git lfs主要用于大文件拉取。项目文件以及环境安装好后,继

构建机器学习模型过程中,往往会涉及很多步骤:数据处理、特征构造、特征筛选、算法选取等等;

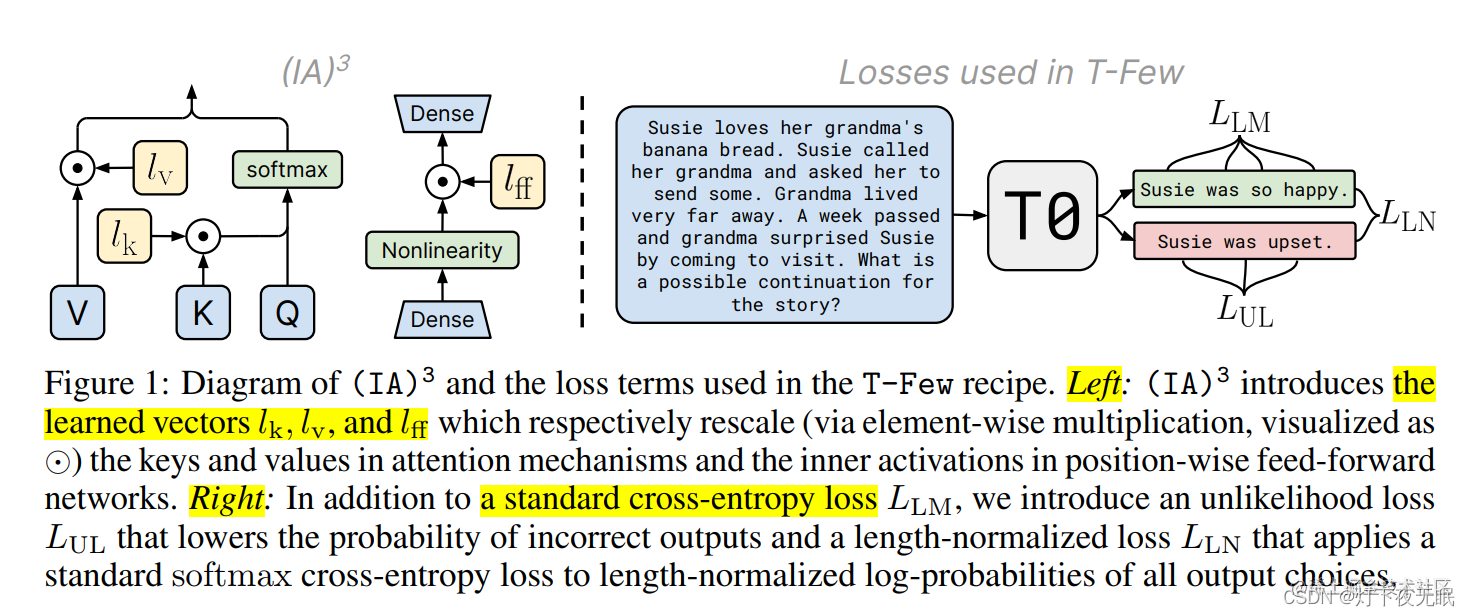

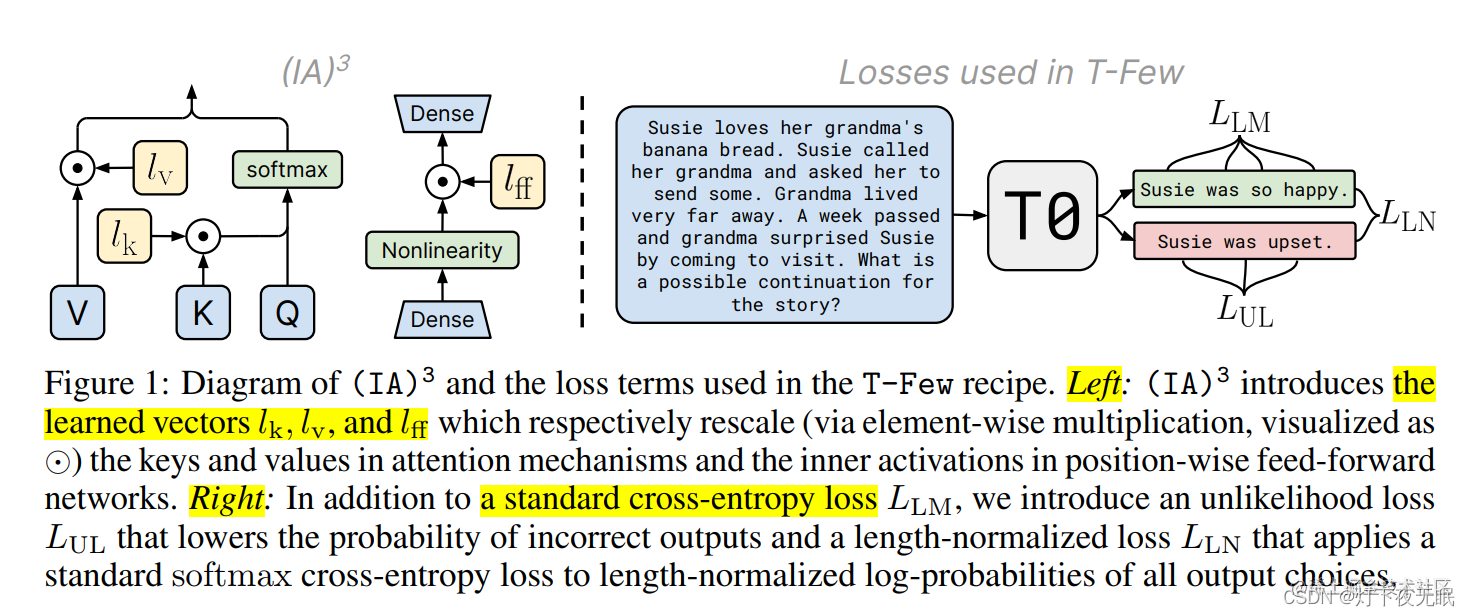

IA3(论文:Few-Shot Parameter-Efficient Fine-Tuning is Better and Cheaper than In-Context Learning),通过学习向量来对激活层加权进行缩放,从而获得更强的性能,同时仅引入相对少量的新参数,如下图左边所示,它的诞生背景是为了改进 LoRA。给定注入 IA3 参数的目标层,可训练参数的数量可以根据权重矩阵的大小确定

在P-Tuning中,通常会为输入序列添加一个或多个可学习的向量(虚拟token),这些向量作为额外的“prompt”嵌入到模型的输入序列中,用于指导模型生成与特定任务相关的输出。随着技术的发展,P-Tuning已经迭代到了多个版本(如P-Tuning v1/v2等),每个版本可能有其独特的设计和优化策略。初始化模型:加载预训练的大规模语言模型,并设置模型为只训练部分参数,即只更新prompt t

# 导入包from selenium import webdriver# 连接驱动器,这里用的是谷歌,版本必须对应driver = webdriver.Chrome(executable_path='chromedriver.exe')# 发送请求,selenium只有get请求driver.get('https://www.taobao.com')# 获取搜索框,输入关键字,并自动点击搜索in_

介绍transformer一些主要组件的基本使用,几乎所有的NLP任务都可以套用这些基础组件来完成。6、Trainer、TrainingArguments基本使用。2、tokenizer基本使用。3、datasets基本使用。5、evaluate基本使用。1、pipline基本使用。4、model基本使用。

在P-Tuning中,通常会为输入序列添加一个或多个可学习的向量(虚拟token),这些向量作为额外的“prompt”嵌入到模型的输入序列中,用于指导模型生成与特定任务相关的输出。随着技术的发展,P-Tuning已经迭代到了多个版本(如P-Tuning v1/v2等),每个版本可能有其独特的设计和优化策略。初始化模型:加载预训练的大规模语言模型,并设置模型为只训练部分参数,即只更新prompt t

利用spark的分布式优势,一次性批量将7000多万的数据写入到redis中。执行时间可能跟资源环境有关,测试整个过程大概只需要5分钟左右,非常快速。

构建机器学习模型过程中,往往会涉及很多步骤:数据处理、特征构造、特征筛选、算法选取等等;

IA3(论文:Few-Shot Parameter-Efficient Fine-Tuning is Better and Cheaper than In-Context Learning),通过学习向量来对激活层加权进行缩放,从而获得更强的性能,同时仅引入相对少量的新参数,如下图左边所示,它的诞生背景是为了改进 LoRA。给定注入 IA3 参数的目标层,可训练参数的数量可以根据权重矩阵的大小确定