简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

中国有超过5000万家小微企业,却几乎都面临同一个困境:遇到法律问题时,请律师太贵、自己处理不懂、通用AI只会说废话。本文深度评测了最新发布的AI律师「吾律」,聚焦小微企业最高频的四大法律场景——账款回收、合同纠纷、劳动用工、合规审查,通过真实模拟案例演示吾律如何帮你"把事办了",而不只是"告诉你可以办"。

中国有超过5000万家小微企业,却几乎都面临同一个困境:遇到法律问题时,请律师太贵、自己处理不懂、通用AI只会说废话。本文深度评测了最新发布的AI律师「吾律」,聚焦小微企业最高频的四大法律场景——账款回收、合同纠纷、劳动用工、合规审查,通过真实模拟案例演示吾律如何帮你"把事办了",而不只是"告诉你可以办"。

“需求→代码→文档”全流程自动化,飞算JavaAI如何为团队节省70%初始开发成本?

“需求→代码→文档”全流程自动化,飞算JavaAI如何为团队节省70%初始开发成本?

AI Ping的智能路由会实时监测各供应商的健康状态,一旦检测到异常(延迟超标、错误率上升、服务宕机等),会自动切换到其他正常的供应商,整个过程对调用方是无感知的。大模型API按Token计费,每家的定价策略都不一样,有的按输入输出分开算,有的打包计费,还有各种优惠活动。当所有供应商的性能都被透明化地展示出来,形成公开的排行榜,就会产生"倒逼效应"——你的延迟比别人高、稳定性比别人差,排行榜上一目

AI Ping的智能路由会实时监测各供应商的健康状态,一旦检测到异常(延迟超标、错误率上升、服务宕机等),会自动切换到其他正常的供应商,整个过程对调用方是无感知的。大模型API按Token计费,每家的定价策略都不一样,有的按输入输出分开算,有的打包计费,还有各种优惠活动。当所有供应商的性能都被透明化地展示出来,形成公开的排行榜,就会产生"倒逼效应"——你的延迟比别人高、稳定性比别人差,排行榜上一目

现在正有福利,除了免费的MCP以外,此链接注册送30刀,适用所有产品。基于爬虫API,小白也能快速上手。

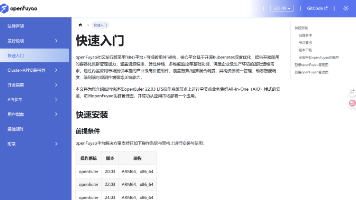

摘要:openFuyao推出AI推理加速方案,针对大模型时代面临的算力挑战提供创新解决方案。通过智能路由(降低延迟40%)、全局KVCache(提升命中率45%)、PD分离(提高吞吐量55%)三大核心技术,结合NPU自动化管理(缩短部署时间80%),实现端到端性能优化。该方案支持昇腾NPU/GPU异构算力,具备开箱即用特性,9分钟完成NPU集群部署,并集成DeepSeek等主流模型。典型场景测试显

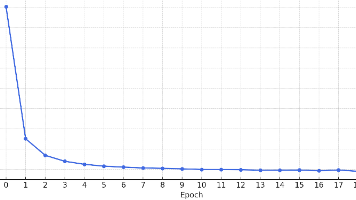

每一帧生成一个归一化的 progress 值ct∈01ct∈01,代表该帧在动作序列中的相对进度;在训练阶段,通过真实动作序列长度LLL,为每一帧分配cttLcttL;在推理阶段,当模型生成的ct≥1.0ct≥1.0时,即认为动作序列结束;counter 会作为输入特征的一部分嵌入 decoder,每一步预测一个新的 counter 值。

前端应用中的缓存机制分为多层,包括浏览器 HTTP 缓存、Service Worker + Cache Storage、客户端本地存储、应用内存缓存和前端状态管理库缓存。每层缓存各司其职,协同工作以提升性能与用户体验。HTTP 缓存通过强缓存和协商缓存减轻服务器压力;Service Worker 支持离线访问和动态更新;本地存储(如 localStorage、IndexedDB)用于持久化数据;内