简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

一般的高校实验室,的确是可能存在显存不足的情况,特别是全量训练或者微调时问题尤为突出。此时想让实验室新购置设备更是遥遥无期,估计开会还没讨论出结果,好多炼丹侠的deadline就到了。

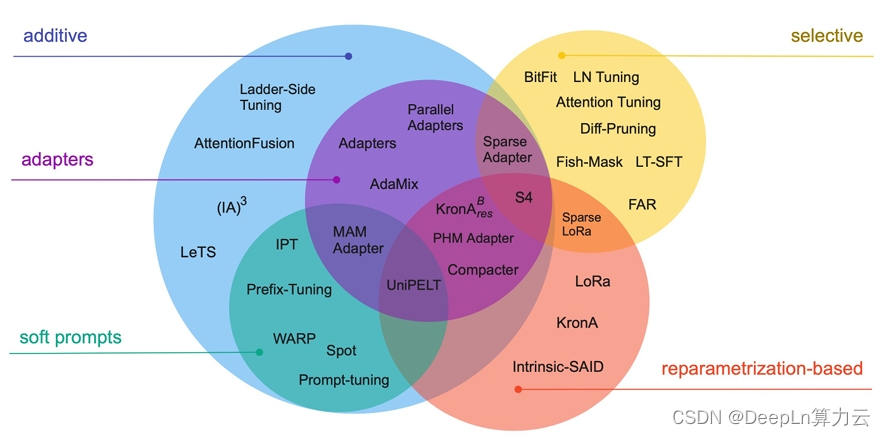

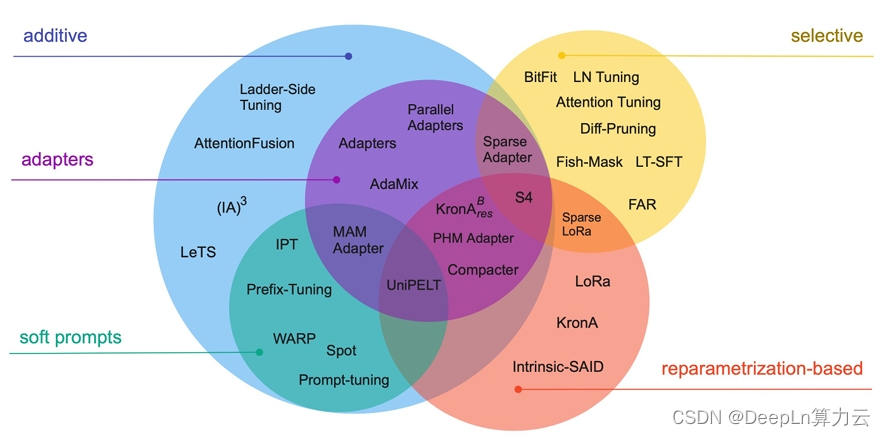

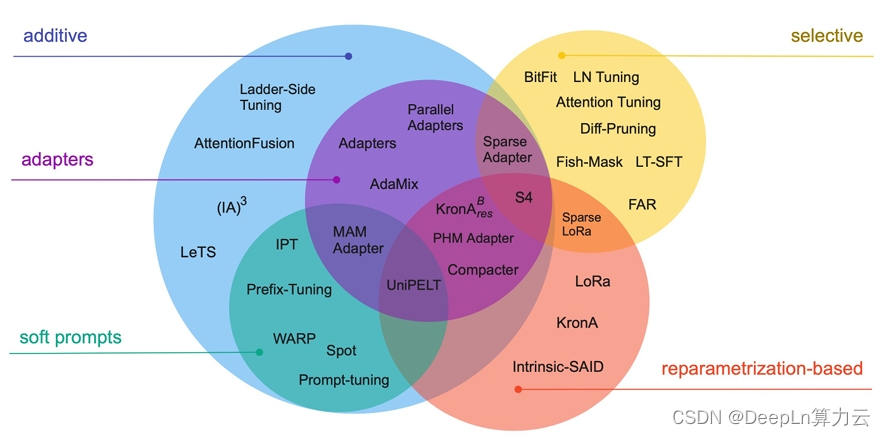

参数高效微调是在对大型语言模型进行微调时的一种重要策略,它旨在改进模型性能的同时,尽量减少对额外参数的需求。通过冻结大部分参数,显存占用下降了5个G左右。训练时间由原来的50.53分钟降低到37.08分钟。

参数高效微调是在对大型语言模型进行微调时的一种重要策略,它旨在改进模型性能的同时,尽量减少对额外参数的需求。通过冻结大部分参数,显存占用下降了5个G左右。训练时间由原来的50.53分钟降低到37.08分钟。

将模型中的32位浮点数转换为8位整数。这种转换通过使用缩放因子(scale)和偏移量(offset)完成。不仅缩减了数据存储的空间,还能在推理时降低计算资源的消耗。

新集群内A10040G、RTX800048G、V10032G等显卡测试期间将免费一周

A100和RTX8000都2元档白菜价,32G显存的V100做到了1元档,以使深度学习和数据科学变得更加触手可及。

百张NVIDIA TESLA P4专业运算卡免费用,相信他高达8G的GPU显存能满足大多数学生群体的训练需求。

本文展示了单机多卡和多机多卡的情况下,在FunHPC乐算云上完成基于Llama factory使用LoRA(Low-Rank Adaptation)技术对Llama3.1-70B-Chinese-Chat模型进行微调的过程。总体的推理效果不错。

主打超高算力、简单易用、高性价比,A100每卡时2.98元,4090每卡时1.98元,更有数十种优质算力可选,这么划算的云端算力,还不赶快来体验~

参数高效微调是在对大型语言模型进行微调时的一种重要策略,它旨在改进模型性能的同时,尽量减少对额外参数的需求。通过冻结大部分参数,显存占用下降了5个G左右。训练时间由原来的50.53分钟降低到37.08分钟。