简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最后一个问题,你如何看待未来的Java全栈开发趋势?我认为,随着云原生和AI技术的发展,Java全栈开发会更加注重性能优化和自动化运维。同时,前端技术也在不断进步,比如Vue3和React的生态越来越成熟,开发者可以更高效地构建高质量的应用。在这次面试中,张伟展示了他对Java全栈开发的全面理解,涵盖了从基础语言、框架到微服务和安全机制等多个方面。Java版本前端框架后端框架数据库微服务安全如果你

腾讯云CPU版1元限时体验活动它来了。AI时代依赖的就是算力资源,当我们还在因为自己电脑配置跟不上而苦恼的时候,不妨试一下HAI。2C2G的云服务器如何安装dify。之前苦于没有大模型的支持,这次活动就打算基于 HAI 实例上的DeepSeek R1模型,和 Dify 一起构建一个智能导诊助手。HAI 的出现,除了提供了大模型需要的CPU/GPU和内存等计算资源外,在某些应用场景下也提供了大模型的

在ChatGPT和DeepSeek未出现之前,智能这个词的概念已经逐渐展现在运营商的各个领域。其整体业务流程是通过在掌上营业厅预置一些比较常见的套餐、流量问题,去引导客户触发这些问题。当下是AI的时代,未来是AI Agent的时代,在大模型知识引擎构建智能客服的过程中,感受了低代码的魅力,除了卓越的UI交互体验,简单易懂的功能也使我从零基础快速入门上手。对于普通开发者来说,腾讯云大模型知识引擎提供

在一些AI代码编辑器刚出现的时候,其AI编码能力颠覆了我对传统coding的认知。只需要将需求告诉AI编辑器,他就会帮我快速生成一个项目,然后通过不断使用提示词去优化,最后实现一个符合个人要求的应用。但是在体验之后发现,除了频繁通过提示词优化会产生高昂的使用费用之外,还会有经常因为网络问题限制调用。正在因为这件事苦恼的时候,腾讯云AI代码助手携手DeepSeek R1满血版来了。通过对腾讯云AI代

最近热衷于找一些好玩的MCP,集成在cursor中,给大模型外挂许多有趣的功能,在开发的代码的同时,在IDE中可以获得更多的乐趣。什么是MCP?本地如何开发MCP ServerMCP实战 | cursor 如何一句话操作 gitHub 代码库cursor 如何调用 MCP server 实现天气查询自定义 MCP Server,在 cursor 中连接本地 MySQL 实现了统计分析Pages M

最近接触了不少构建智能体的平台,所以就考虑是否有开源的平台可以让我深入学习一下智能体,所以就了解到了Dify。Dify 是一个开源的 LLMOps(大模型运维)平台,专为构建、管理和部署基于大语言模型(LLM)的 AI 应用而设计。它不仅让开发者能快速创建 AI 应用,还能为企业提供稳定的推理能力和可扩展的 RAG(检索增强生成)方案。简单来说,Dify 让 AI 应用的开发变得像搭积木一样简单,

在ChatGPT和DeepSeek未出现之前,智能这个词的概念已经逐渐展现在运营商的各个领域。其整体业务流程是通过在掌上营业厅预置一些比较常见的套餐、流量问题,去引导客户触发这些问题。当下是AI的时代,未来是AI Agent的时代,在大模型知识引擎构建智能客服的过程中,感受了低代码的魅力,除了卓越的UI交互体验,简单易懂的功能也使我从零基础快速入门上手。对于普通开发者来说,腾讯云大模型知识引擎提供

在上一篇文章LLM学习笔记:如何理解LLM中的Transformer架构中,我们了解了在GPT、stable diffusion以及情感分析等AI领域常见的 Transformer 架构,概括下来就是:Transformer 是一种用于处理和生成序列数据的深度学习架构,其内部的各种机制(例如 Self-Attention)使计算机能够更好地理解和生成自然语言。那么,对于开发者来说,该如何使用这种架

cursor 如何调用 MCP server 实现天气查询,今天的 MCP Server 是关于github的,通过github mcp server,我们可以在大模型中链接github,并实现很多常见的操作。在日常代码开发中,很多时候都要使用 github, 不妨可以来试一试 github mcp server 提高工作效率。

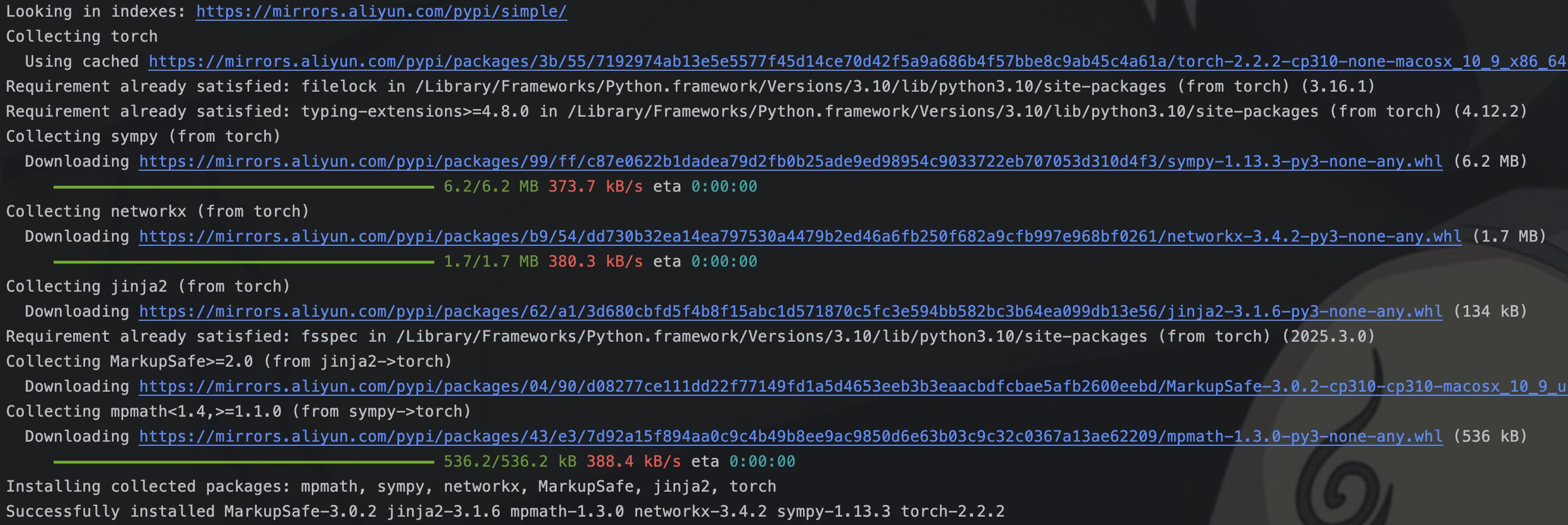

在上一篇文章Dify学习笔记01:什么是Dify中,我们了解并体验了一下 dify 的云服务。正好还有一台腾讯云的轻量应用服务器,所以本篇文章就开始在服务器上安装 dify。dify 提供了两种安装方式:docker-compose 和 源码安装。但是本地源码安装,还需要自行安装。所以这里就是用 docker-compose 来完成安装。本篇文章主要是在腾讯云服务器上部署 dify 的一个教程,对