简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

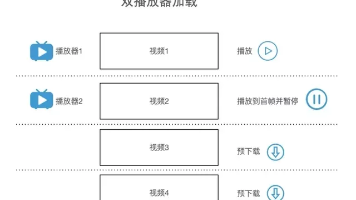

短视频秒播优化全链路解析 摘要:视频秒播是提升用户体验的核心指标,本质是将首帧耗时压缩至用户无感知范围(200-500毫秒)。优化需覆盖全链路:地址获取(提前下发播放链接)、网络传输(智能预加载关键数据)、播放器处理(预渲染解复用)和渲染展示。针对不同场景需差异化策略,如短视频滑动采用双播放器实例复用,长视频采用关键帧起播,页面跳转实现播放器实例迁移。优化需平衡资源占用,通过预加载量控制、并行数量

本文介绍了如何通过资源文件引入shader源码,以减少代码量并简化着色器配置流程。首先,将顶点着色器和片段着色器的源码分别存储在source.vert和source.frag文件中,并通过qrc资源文件系统进行管理。接着,使用QOpenGLShaderProgram类提供的addShaderFromSourceFile方法加载着色器源码,并自动完成编译和链接过程。相较于手动编写着色器配置代码,该方

示例本程序会⽣成⼀个合成的⾳频和视频流,并将它们编码和封装输出到输出⽂件,输出格式是根据⽂件扩展名⾃动猜测的。示例的流程图如下所示。最终调⽤到复⽤器的 write_header,⽐如FFmpeg结构体:avformat_alloc_output_context2函数在在libavformat.h⾥⾯的定义函数参数的介绍:可以看出,⾥⾯最主要的就两个函数,avformat_alloc_context

av_register_all():注册所有组件,4.0已经弃用avdevice_register_all()对设备进行注册,比如V4L2等。初始化网络库以及网络加密协议相关的库(比如openssl)负责申请一个AVFormatContext结构的内存,并进行简单初始化释放该结构里的所有东西以及该结构本身关闭解复用器。关闭后就不再需要使用avformat_free_context 进行释放。打开输

一个轮廓一般对应一系列的点,也就是图像中的一条曲线。其表示方法可能 根据不同的情况而有所不同。在OpenCV中,可以用findContours()函数从二值图 像中查找轮廓findContours)函数用于在二值图像中寻找轮廓。第一个参数,InputArray类型的image, 输入图像,即源图像,填Mat 类的 对象即可,且需为8位单通道图像。图像的非零像素被视为1,0像素值被 保留为0,所以图

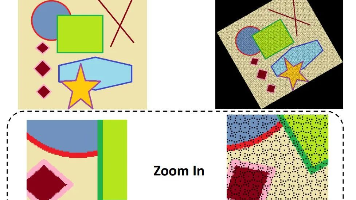

直方图广泛运用于很多计算机视觉运用当中,通过标记帧与帧之间显著的边缘和颜色的统计变化,来检测视频中场景的变化。在每个兴趣点设置一个有相近特征的直方图所构成“标签”,用以确定图像中的兴趣点。边缘、色彩、角度等直方图构成了可以被传递给目标识别分类器的一个通用特征类型。色彩和边缘的直方图序列还可以用来识别网络视频是否被复制。如图9.1所示。其实,简单点说,直方图就是对数据进行统计的一种方法,并且将统计值

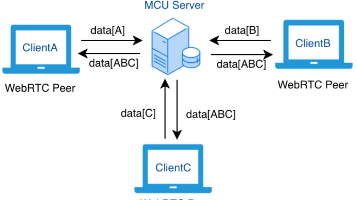

WebRTC是一套开源技术标准,实现浏览器间实时音视频通信和数据传输。其核心架构采用分层设计:Web API层为开发者提供标准化JS接口;Native C++层由浏览器厂商实现底层功能;引擎层处理音视频编解码、网络传输等核心逻辑,包括音频引擎(NetEQ、回声消除)、视频引擎(VP8编解码)和网络传输(ICE/STUN/TURN)。通信流程分为媒体协商(通过SDP协议交换编解码能力)和网络协商(通

本文探讨了音视频通讯中的QoS(服务质量保障)技术体系。QoS分为基于网络的NQoS和基于应用的AQoS,音视频领域主要关注AQoS。文章分析了音视频通讯面临的网络复杂性和多样化业务场景挑战,指出用户体验主要取决于清晰度、流畅性和实时性三个维度。针对弱网环境(拥塞、丢包、延时等),提出了四大类QoS技术:拥塞控制、信源控制、抗丢包和抗抖动。这些技术贯穿音视频通讯全链路,在媒体编解码、传输等环节发挥

图像几何变换中的前向映射与后向映射是两种关键方法。前向映射直接将原图像素坐标通过函数映射到目标图像,但可能导致无效浮点坐标、像素重叠或空洞问题(如旋转30度后出现蜂窝状空隙)。后向映射则反向计算目标图像素对应的原图位置,有效避免空洞和重叠问题,但同样需要插值处理小数坐标。实际应用中,不改变图像尺寸的变换适合前向映射,而旋转/缩放等操作多采用后向映射(如OpenCV默认的双线性插值)。两种方法各有适

OpenGL着色器编程入门摘要:本文介绍了OpenGL可编程管线中的着色器基础。现代OpenGL需要两个基本着色器:顶点着色器(处理每个顶点)和片段着色器(处理每个采样点)。着色器使用GLSL语言编写,运行时动态编译。文章详细展示了如何从文件加载着色器代码(.vert和.frag文件)、编译着色器、创建着色器程序并链接的过程。顶点着色器示例演示了GLSL 3.3核心语法,通过layout声明输入顶