简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

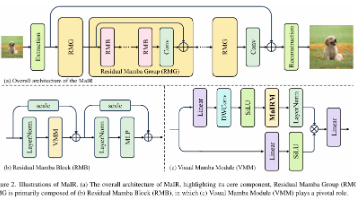

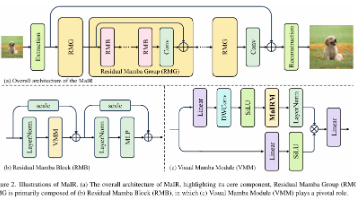

摘要:四川大学团队提出MaIR模型,一种专为图像恢复设计的Mamba架构创新。该模型通过嵌套S型扫描策略(NSS)在保持零计算成本的前提下,有效维护图像局部性和空间连续性;结合序列混洗注意力模块(SSA)实现多方向特征智能融合。实验表明,MaIR在超分辨率、去噪等14项任务中超越40个SOTA模型,PSNR/SSIM指标显著提升。其核心模块可作为即插即用组件增强现有视觉Mamba模型,官方代码已开

摘要:四川大学团队提出MaIR模型,一种专为图像恢复设计的Mamba架构创新。该模型通过嵌套S型扫描策略(NSS)在保持零计算成本的前提下,有效维护图像局部性和空间连续性;结合序列混洗注意力模块(SSA)实现多方向特征智能融合。实验表明,MaIR在超分辨率、去噪等14项任务中超越40个SOTA模型,PSNR/SSIM指标显著提升。其核心模块可作为即插即用组件增强现有视觉Mamba模型,官方代码已开

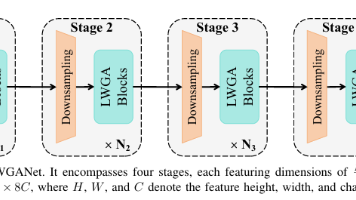

本文提出了一种轻量级群组注意力骨干网络LWGANet,用于遥感视觉任务。该网络的核心创新是轻量级群组注意力(LWGA)模块,通过特征分组并行处理,高效提取并融合从局部到全局的多尺度空间信息,解决遥感图像中目标尺度差异大的问题。LWGA模块集成了四种针对不同尺度的注意力子模块,协同工作以捕捉不同尺寸目标特征。实验表明,LWGANet在12个遥感数据集上的场景分类、目标检测、语义分割和变化检测任务中,

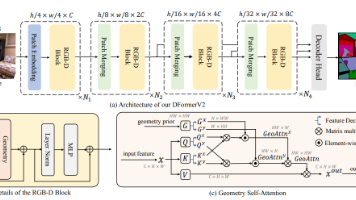

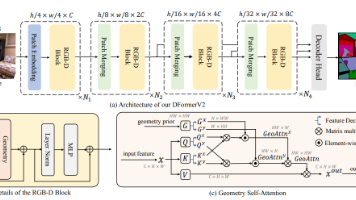

本文提出DFormerv2模型,通过几何自注意力机制将深度数据作为几何先验直接引入RGBD语义分割任务。该方法创新性地融合深度和空间几何信息,构建高效编码器,在NYU DepthV2、SUNRGBD和Deliver三大数据集上实现性能突破。实验表明,DFormerv2-L以95.5M参数取得58.4% mIoU,计算量较SOTA方法降低50%以上,展现出优异的性能与效率平衡。该研究为RGBD语义分

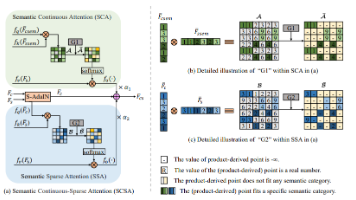

本文提出了一种即插即用的语义连续-稀疏注意力机制(SCSA),用于解决现有基于注意力的任意风格迁移方法(Attn-AST)在处理同语义内容与风格图像时出现的语义区域风格不一致、相邻区域不连续及纹理缺失问题。SCSA通过双注意力模块协同工作:语义连续注意力(SCA)确保同语义区域的整体风格一致性,语义稀疏注意力(SSA)捕捉具体纹理细节。该方法无需重新训练即可集成到CNN、Transformer和扩

本文提出DFormerv2模型,通过几何自注意力机制将深度数据作为几何先验直接引入RGBD语义分割任务。该方法创新性地融合深度和空间几何信息,构建高效编码器,在NYU DepthV2、SUNRGBD和Deliver三大数据集上实现性能突破。实验表明,DFormerv2-L以95.5M参数取得58.4% mIoU,计算量较SOTA方法降低50%以上,展现出优异的性能与效率平衡。该研究为RGBD语义分

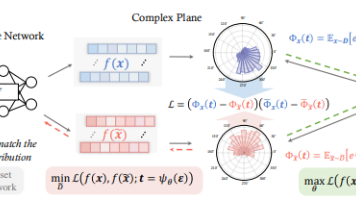

本文提出了一种创新的神经特征函数匹配(NCFM)方法用于高效数据集蒸馏。该方法通过构建minmax对抗优化框架,引入神经特征函数差异(NCFD)作为新的分布度量指标,在复数空间实现数据特征的对齐。NCFM具有三大创新点:1)基于复数相位和振幅解耦的神经特征函数度量;2)动态采样网络实现高效计算;3)层级式特征对齐机制。实验表明,在CIFAR-100等数据集上,NCFM相比现有方法内存消耗降低300

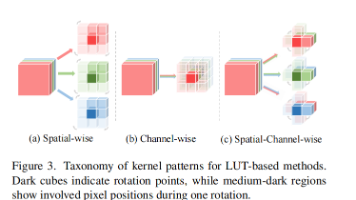

本文提出DnLUT框架,通过Pairwise Channel Mixer(PCM)和L形卷积核设计,实现了彩色图像高效去噪。PCM模块通过重组RGB通道为三对并行处理,有效捕捉通道间相关性;L形卷积核则减少50%像素重复访问,降低17倍存储需求。实验表明,DnLUT在CBSD68等数据集上的CPSNR显著优于现有LUT方法超1dB,存储仅需500KB,且可作为插件提升其他LUT方法性能。该框架在保