简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

微软KOSMOS-1多模态大模型研究综述 微软提出的KOSMOS-1是一个突破性的多模态语言模型,支持感知、生成与推理能力。该研究采用MAGNETO架构作为主干,通过在每个子层引入额外LayerNorm提升训练稳定性,并采用XPOS相对位置编码优化长序列处理。模型参数约1.6B,使用120万token批次训练3600亿token,采用"full-sentence"预处理保持语义

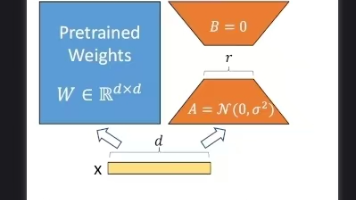

无论是火热的大模型(LLM)还是文生图模型(Stable Diffusion)微调的时候,都需要大量的GPU显存,个人的显卡上很难实现, 因此各种参数高效(Parameter-Efficient)的方法层出不穷,最受大家欢迎的就是LoRA 《LoRA:Low-Rank Adaptation of Large Language Modules》LoRA有很多的优点,节约显存,训练快,效果损失小(相当

《Mamba模型原理及实现解析》摘要:本文系统介绍了Mamba模型的核心原理,该模型基于选择性状态空间模型(SSM)架构,通过引入选择机制解决了传统Transformer在长序列处理中的计算效率问题。文章首先分析Transformer的局限性,详细阐述状态空间模型的基本原理及其离散化处理方法,并对比了Mamba与RNN、Transformer的结构差异。通过代码实现和可视化演示,展示了Mamba在

无论是火热的大模型(LLM)还是文生图模型(Stable Diffusion)微调的时候,都需要大量的GPU显存,个人的显卡上很难实现, 因此各种参数高效(Parameter-Efficient)的方法层出不穷,最受大家欢迎的就是LoRA 《LoRA:Low-Rank Adaptation of Large Language Modules》LoRA有很多的优点,节约显存,训练快,效果损失小(相当