简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大家好,我是八哥。?故事围绕三对北漂伴侣展开,聚焦真实职场生活。特别是剧中的“卷王代表”那隽,更是成为打工人热议的焦点。程序员那隽,出身贫寒,一路拼搏,。这个被同事称为“那神”的角色,不仅技术过硬,更有着令人称羡的职场智慧。说他是全剧的MVP,一点都不为过!并且,剧中深刻地展现了等社会热点问题,引发了广大打工人的强烈共鸣。今天,,以及我们普通打工人怎样才能成为职场中的佼佼者。如今的职场,可谓风云变

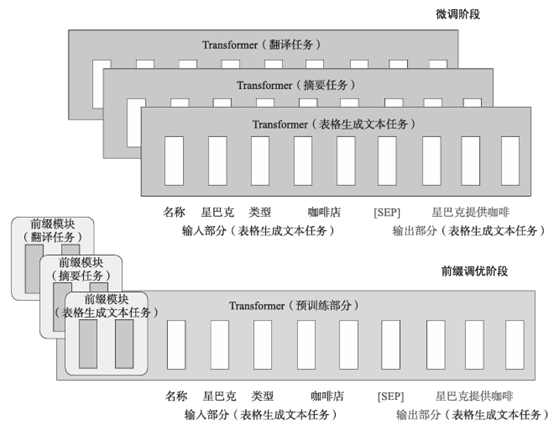

本篇文章深入分析了大型模型微调的基本理念和多样化技术,细致介绍了LoRA、适配器调整(Adapter Tuning)、前缀调整(Prefix Tuning)等多个微调方法。详细讨论了每一种策略的基本原则、主要优点以及适宜应用场景,使得读者可以依据特定的应用要求和计算资源限制,挑选最适合的微调方案。

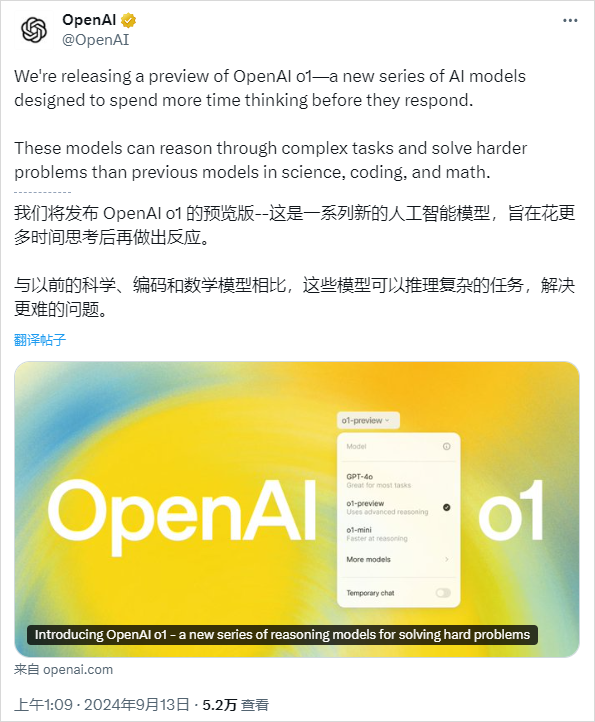

大半夜的,OpenAI抽象了整整快半年的新模型。在没有任何预告下,正式登场。正式版名称不叫草莓,草莓只是内部的一个代号。他们的正式名字,叫:这次模型的强悍,甚至让OpenAI不惜推掉了过去GPT系列的命名,重新起了一个o系列。炸了,真的炸了。我现在,头皮发麻,真的,这次OpenAI o1发布,也标志着,**“我们通往AGI的路上,已经没有任何阻碍。**在逻辑和推理能力上,我直接先放图,你们就知道,

在深入理解思维链(Chain of Thought, CoT)之前,我们先来认识两个概念,即“语言智能”和“推理”。“语言智能”可以被看作是使用基于自然语言的概念去理解经验事物,并对概念间进行推理的能力。而“推理”更常被理解为根据已知前提推出新结论的过程,这通常涉及到多个步骤并形成了关键的“中间概念”,它们有助于解决复杂问题。当我们让大型模型对复杂问题进行分解,将其转换为一步步可解决的子问题,大模

LLM(Large Language Model,大型语言模型)是指基于大规模数据和参数量的语言模型。Transformer架构:大模型LLM常使用Transformer架构,它是一种基于自注意力机制的序列模型。Transformer架构由多个编码器层和解码器层组成,每个层都包含多头自注意力机制和前馈神经网络。这种架构可以捕捉长距离的依赖关系和语言结构,适用于处理大规模语言数据。自注意力机制(Se

😝有需要的小伙伴,可以保存图片到wx扫描二v码关注免费领取【保证100%免费】🆓。

下文翻译自Timothy B Lee和Sean Trott花费两个月完成的一篇博客。语言大模型内部究竟是如何工作的?本文用最少的数学知识和术语进行解释。如今,几乎每个人都听说过LLM,并有数千万人用过它们,但是,了解工作原理的人并不多。你可能听说过,训练LLM是用于“预测下一个词”,而且它们需要大量的文本来实现这一点。但是,解释通常就止步于此。它们如何预测下一个词的细节往往被视为一个深奥的谜题。其

学习AI大模型不仅需要理论知识的积累,还需要通过实践来加深理解。上述十大网站提供了丰富的学习资源和社区支持,能够帮助你在AI大模型的学习之路上走得更远。希望你能充分利用这些资源,提升自己的技能,推动人工智能领域的发展。

😝有需要的小伙伴,可以保存图片到wx扫描二v码关注免费领取【保证100%免费】🆓。

本文从背景、来源、技术路线及性能等方面综述了11种在模型参数调优阶段进行的方法,其中前缀调优、提示调优和P-Tuning v2属于引入特定参数来减少算力消耗、提升训练速度;基于LoRA的各种方法的基本思想是添加新的旁路,对特定任务或特定数据进行微调。