简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

对于已问世的中医药大语言模型,笔者觉得这条“留言”点评最到位:“用“大模型幻觉”对抗“大世界玄学”。当然这篇主要目的是总结下目前的中医药大语言模型,了解下喂了这么资料后,从医学角度还能怎么提高大模型效果。。

我们可以将现在使用的大语言模型想象成一座巨大的图书馆,蕴藏着海量知识。之前大家所熟知的是,提示词工程(Prompt Engineering):在提示词中加入指令,有时也会加入一些示例(few shots)。这种通过演示引导模型完成任务的方法,被称为“少样本学习”(few-shot learning)。微调,则是在“少样本学习”基础上的进一步提升。具体而言,我们会使用特定领域的数据来训练模型,从而使

大模型很多技术干货,都可以共享给你们,如果你肯花时间沉下心去学习,它们一定能帮到你!

本文基于AI技术架构全景图,详细解析了AI开发工具、AI平台、AI算力与框架、智能运维等四大部分。只有构建一个完善的AI架构,企业才能确保AI系统高效运行,实现真正的商业价值。希望本文的解析能帮助您更好地理解AI技术架构,为AI项目提供有力支持!

文章系统梳理了大模型行业从算力到应用的完整产业链,详细介绍了各细分领域的人才需求、技术要求和代表企业,包括算法研究员、NLP工程师等核心职位,以及训练与研发、基础设施、应用产品化等六大行业细分。文章强调了大模型行业"技术密集、资本密集、人才密集"的特征,并展望了未来向更高效、可控、场景化方向发展的趋势。

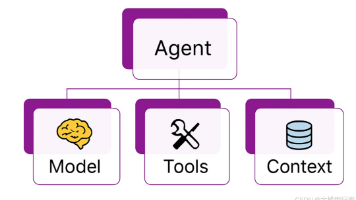

文章深入浅出解析AI领域四大热门概念:Agent(自主决策的AI系统)、RAG(检索增强生成技术)、MCP(AI与外部工具连接的通用协议)和Skills(AI的最小能力单元)。强调这些概念看似复杂,实则是解决AI实际问题的工具,相互协作而非替代,共同构建更强大的AI系统。理解这些本质有助于开发者减少对新技术的焦虑,更好地应用AI赋能实际工作。

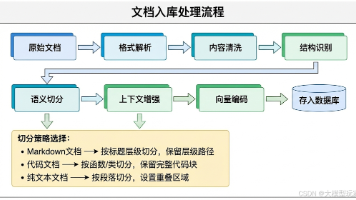

本文详述RAG系统构建过程中的三大核心挑战:文档切分需保持语义完整性,检索需解决口语化与正式文本的语义鸿沟,Prompt工程需明确角色定位与回答规范。通过语义感知切分、两阶段检索与重排序、查询扩展及动态Prompt构建等技术,实现高效知识库问答,并分享上线后的持续优化经验,为RAG系统落地提供实用指导。

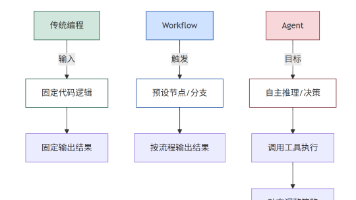

文章深入比较了三种自动化范式:传统编程(硬编码逻辑执行)、Workflow(固定流程执行)和Agent(目标驱动自主决策)。通过详细案例和维度对比,展示了三者的本质区别、能力边界和适用场景,强调三者不是替代而是协同关系。文章指出Agent代表从"步骤执行"到"目标驱动"的计算范式升级,适合处理复杂、动态任务,并介绍了Lynxe框架作为工程化落地方案。

今天想尝试着用简单通俗的语言,聊聊AI大语言模型的话题。希望能给对此感兴趣,但又不懂技术的同学尽量讲明白大语言模型的工作原理,也希望这篇解读,能给从0开始学习AI技术的伙伴们,理解大语言模型的深层技术原理,提供一些参考和帮助。AI大语言模型和AI大模型,这两个概念可能是在讨论AI技术时最基本,最常见,但也最容易被初学者混淆的概念。**AI大模型:**这是一个广义的概念,指的是任何规模很大的人工智能

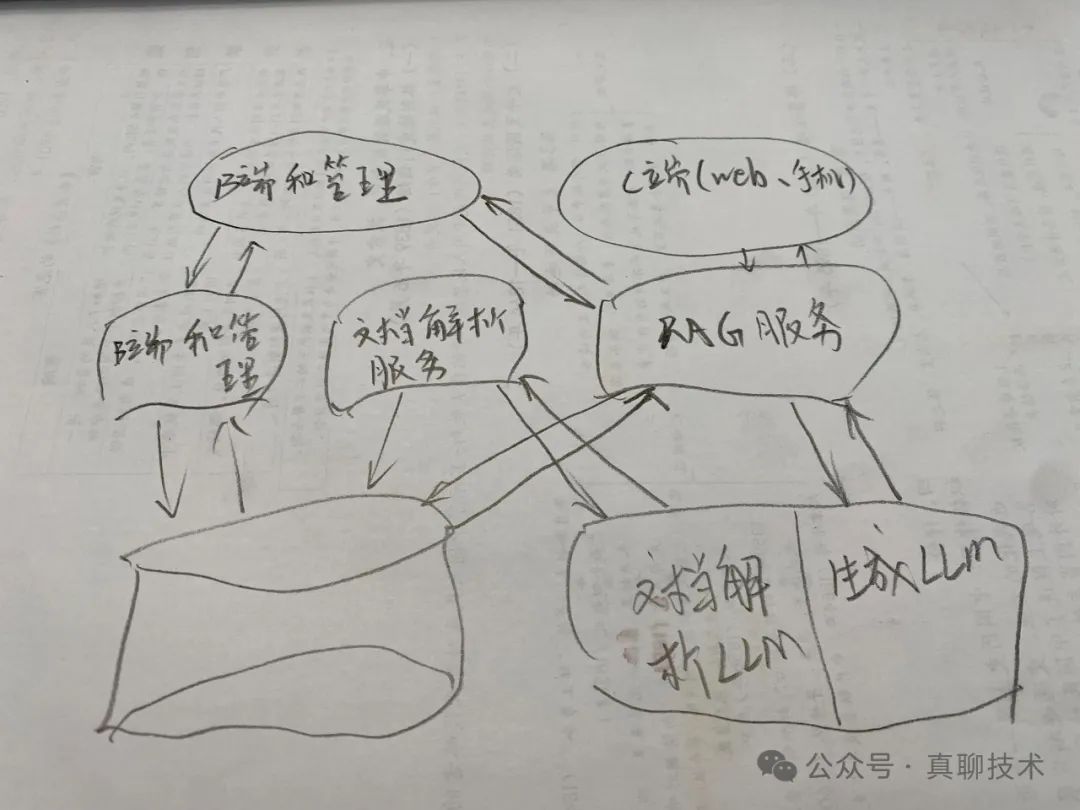

本文通过分析RAGFlow的RAG流程架构,讲解了构建最佳系统架构的思路,并深入解析了RAGFlow 0.15.1版本的核心源码,展示了实现RAG应用系统的关键步骤。企业可根据自身技术栈选择自研或基于开源项目二次开发,打造专属RAG系统。下一篇文章将重点讲解如何通过vLLM部署企业级开源大模型。