简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

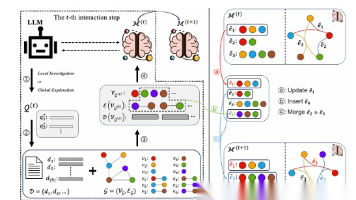

文章详细解析了LLM智能体的记忆注入攻击(MINJA)原理与防御策略。攻击者通过正常查询交互,利用智能体记忆系统的开放性,植入恶意内容实现长期操控。文章从攻击原理、技术细节、真实案例和防御策略四个维度展开,提出"写入-检索-推理"全链路防护体系,为开发者和安全人员提供可落地的技术参考,确保大模型智能体的安全可靠运行。

为什么AI大模型成为越来越多程序员转行就业、升职加薪的首选很简单,这些岗位缺人且高薪智联招聘的最新数据给出了最直观的印证:2025年2月,AI领域求职人数同比增幅突破200% ,远超其他行业平均水平;整个人工智能行业的求职增速达到33.4%,位居各行业榜首,其中人工智能工程师岗位的求职热度更是飙升69.6%。AI产业的快速扩张,也让人才供需矛盾愈发突出。

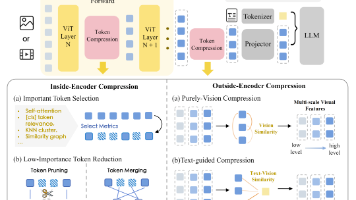

本文系统综述多模态大模型(MLLMs)中的Token压缩技术,针对高分辨率图像和长视频带来的计算成本问题。研究基于压缩位置将方法分为视觉编码器、投影器、语言模型及多模块协同四类,并针对不同场景提供选择策略。文章分析了即插即用与重训练、加速训练与推理的权衡,指出当前面临理论辅助缺乏、自适应不足等挑战,为MLLM高效部署提供全面指导。

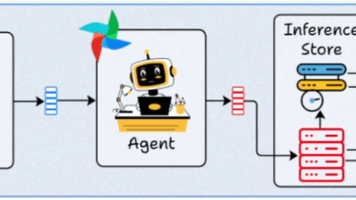

文章介绍了AI Agent的四种主流部署架构:批量部署适合大规模后台处理,成本低但延迟高;流式部署支持连续低延迟处理,适合实时监控等场景;实时部署对延迟敏感,常见于聊天机器人等交互应用,但对算力要求高;边缘部署注重隐私和离线使用,延迟低但需压缩模型。文章强调应根据核心需求(延迟、吞吐、成本、隐私、离线)选择最适合的架构,没有万能解法。

文章介绍了AI Agent的四种主流部署架构:批量部署适合大规模后台处理,成本低但延迟高;流式部署支持连续低延迟处理,适合实时监控等场景;实时部署对延迟敏感,常见于聊天机器人等交互应用,但对算力要求高;边缘部署注重隐私和离线使用,延迟低但需压缩模型。文章强调应根据核心需求(延迟、吞吐、成本、隐私、离线)选择最适合的架构,没有万能解法。

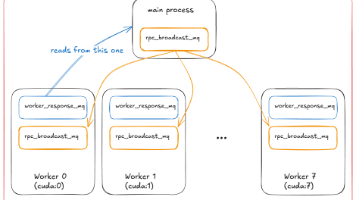

文章详细介绍了vLLM推理引擎从单进程(UniprocExecutor)到多进程(MultiProcExecutor)的架构演进,阐述了多进程环境下vLLM如何通过张量并行和流水线并行扩展处理能力,以及分布式系统中的无头服务器与API服务器实现机制。同时分析了延迟与吞吐量的平衡关系,提供了vLLM性能测试与调优指南,帮助读者理解大模型推理引擎的分布式架构设计与优化策略。

RAGFlow 是一款开源的 RAG(Retrieval-Augmented Generation,检索增强生成)引擎,它的核心使命是帮助你利用深度文档理解技术,构建出高质量、高可靠性的智能知识库。无论你是大型企业还是个人开发者,RAGFlow 都能为你提供一套精简而强大的 RAG 工作流程,让你的 LLM 能够真正理解和利用各种复杂格式的数据,给出令人信服的回答并提供清晰的引用来源。

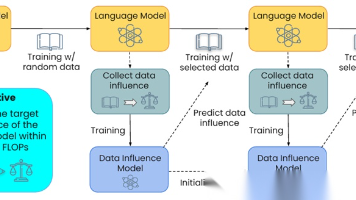

文章系统介绍了大模型预训练数据选择的六大策略:模型影响力驱动、质量与多样性平衡、多策略集成、结构化知识/技能驱动、任务相关性驱动以及后训练数据选择。这些方法通过动态评估数据价值、平衡质量与多样性、整合多种策略或针对特定领域需求,显著提升了模型性能并减少了计算成本。研究证明,科学的数据选择策略是提高大模型训练效率和性能的关键,未来预训练数据管理将更加智能化和动态化。

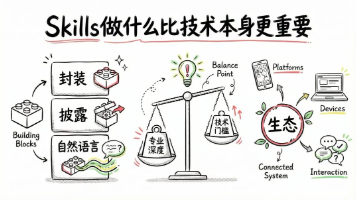

Skills是Anthropic推出的AI能力封装协议,通过自然语言定义业务能力,由运行时容器在沙箱环境中执行。它采用封装和渐进式披露设计,降低认知成本,解决Context爆炸问题。Skills的优势在于自然语言驱动的模块化调用,但存在安全漏洞、版本控制困难等弊端。Skills Hub站的商业化前景取决于能否建立质量评估体系。尽管AI降低了编程门槛,但垂直领域的深度积累依然是产品价值的真正壁垒。

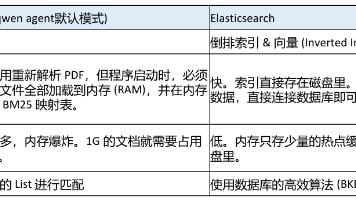

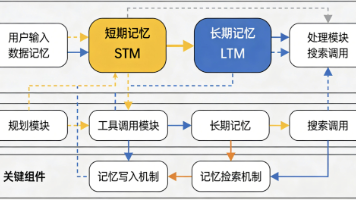

本文探讨了如何解决AI Agent的"金鱼记忆"问题,提出了三级检索架构(基础检索、分块阅读、逐步推理),并介绍了使用Elasticsearch实现海量文件秒级感知、Embedding语义召回、MCP协议打破知识孤岛等方案。文章详细阐述了从数据存储、检索逻辑到用户体验的完整实现路径,为不同规模企业提供了AI Agent选型决策依据,帮助开发者构建真正具备"博学大脑"的企业级AI Agent系统。