简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

经过一段使用DeepSeek后,感觉使用体验和ChatGPT基本差不多,回答问题的质量略有提升,因DeepSeek已开源,它的模型、模型参数权重从网上都可以下载到,所以可以基于开源的模型,在本地构建一个自己的知识库,小编这里使用的是蒸馏后的模型参数权重RAG (Retrieval-Augmented Generation)检索增强生成,是一种通过整合外部知识库来增强大模型(LLM)回答问题质量的模

DeepSeek-V3 是一个在2048 个 NVIDIA H800 GPU 的集群上进行训练得到的超大型MoE架构的大语言模型。它延续了Deepseek MoE、Deepseek V2等模型的一系列创新,进一步提出了MTP,并优化了训练的效率,取得比较好效果的同时,提高了训练的效率,节约了成本。表5、表6展示了 DeepSeek V3 为人瞩目的训练成本以及开源基准评测效果。表5. DeepSe

随着模型和语料的扩大,大型语言模型展示了从少量上下文示例中学习的能力,这被称为上下文增强学习(ICL)。利用ICL,大型语言模型可以执行各种复杂任务,例如解决数学推理问题。ICL的基本理念是从类比中汲取经验。ICL与监督学习有一个显著的区别,就是它不需要进行参数更新,而是直接在预训练的语言模型上进行预测。ICL作为一种新的范式,具有很多天然的优势:由于演示是用自然语言编写的,因此提供了一个可解释的

最近秋招发放Offer已高一段落。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中的那些弯弯绕绕。。更多实战和面试交流,文末加入我们。

Answer前习惯于最后一次。

混合专家(MoE)是一种使用许多不同的子模型(或“专家”)来提高LLMs质量的技术。两个主要组件定义了 MoE:专家 - 每个 FFNN 层现在都有一个“专家”集合,其中可以选择子集。这些“专家”通常是 FFNN 本身。路由器或网关网络 - 确定哪些令牌发送给哪些专家。在具有 MoE 的LLM的每一层中,我们发现(某种程度上是专业的)专家:“专家”并非在特定领域如“心理学”或“生物学”中专业化。最

软目标说明:教师模型输出 [0.7, 0.2, 0.1],表示类别 A 的概率为 0.7,类别 B 的概率为 0.2,类别 C 的概率为 0.1,如果是硬目标就直接选择类别 A,但如果是软目标,学生模型输出的概率分布为 [0.6, 0.3, 0.1],KL 散度会计算这两个概率分布之间的差异。当模型过大无法在单个设备(如 GPU)内存中完整训练时,它将模型的不同部分分布在多个设备上进行训练,相比于

本文整理了来自Daily Dose of Data Science最热门或最新的文章,其中极具特色的动图以生动形象的方式,帮助我们更好的理解AI中的一些核心技术,希望能够帮助大家更好的理解和使用AI。是时候准备面试和实习了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少,岗位要求还更高了。最近,我们又陆续整理了很多大厂的面试题,帮助一些球友解惑答疑,分享技术面试中

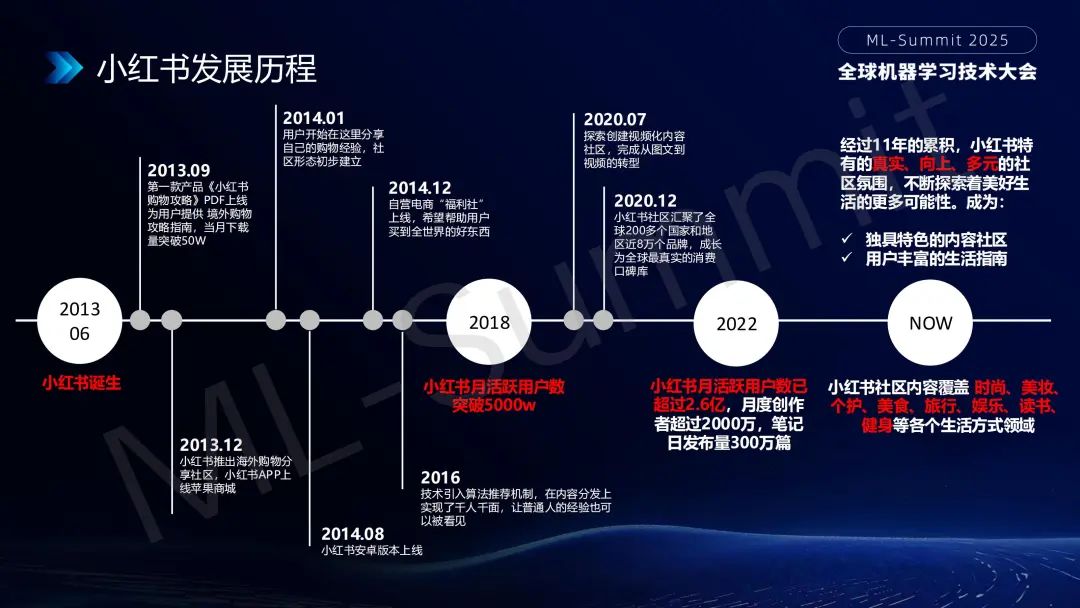

小红书推荐算法负责人严岭在2025年全球机器学习技术大会上分享了大模型在小红书推荐系统中的应用实践。小红书通过多轮筛选和排序,结合多模态内容理解技术,精准推送用户感兴趣的内容。系统还引入CES机制和多目标建模,优化用户参与度和推荐效果。大模型的应用提升了内容理解和推理能力,突破了传统推荐系统的局限,为用户提供更精准、多样化的内容推荐。

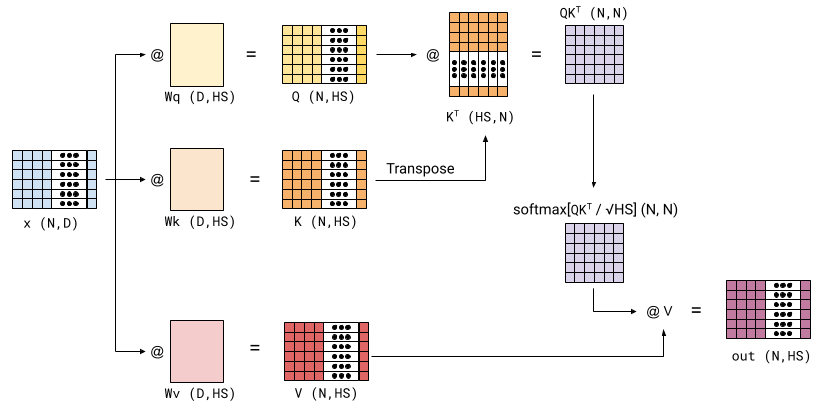

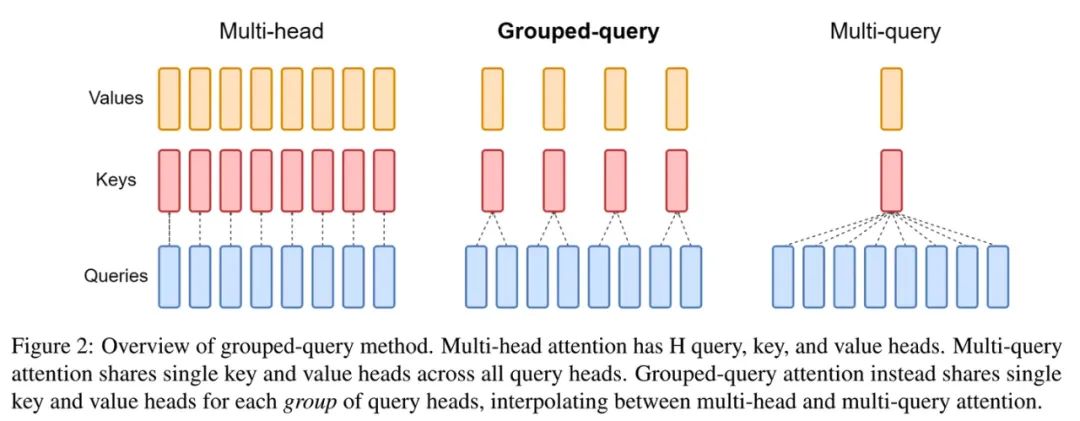

Transformer 属于算法必考题。今天这篇文章讲透Transformer :缩放、批量、多头、掩码、交叉、跨头,对刚想了解算法或面试的朋友非常友好。文章安排如下:基础缩放Attention批量Attention多头Attention掩码Attention交叉Attention跨头维度向量化最近春招和实习已开启了。不同以往的是,当前职场环境已不再是那个双向奔赴时代了。求职者在变多,HC 在变少