spark启动不成功

spark在同一节点启动多个spark master(worker)

·

spark启动不成功

1.查看报错信息

2.原因分析:

这种情况一般是在同一节点启动多个spark master(worker)

3.解决方案:

1>首先应该去停止dfs和yarn,使用命令

stop-all.sh

2> 停止之后使用命令查看当前进程

jps

3> 发现停止之后还是有master,使用命令杀死该进程即可

kill -9 3564在通过jps查看当前进程

jps4>另外两个节点同理,slave01通过jps查看当前进程

杀死该节点的worker

kill -9 2787

5>slave02 同上

6> 在master节点重新启动dfs和yarn

start-dfs.sh

start-yarn.sh7>通过jps命令查看进程

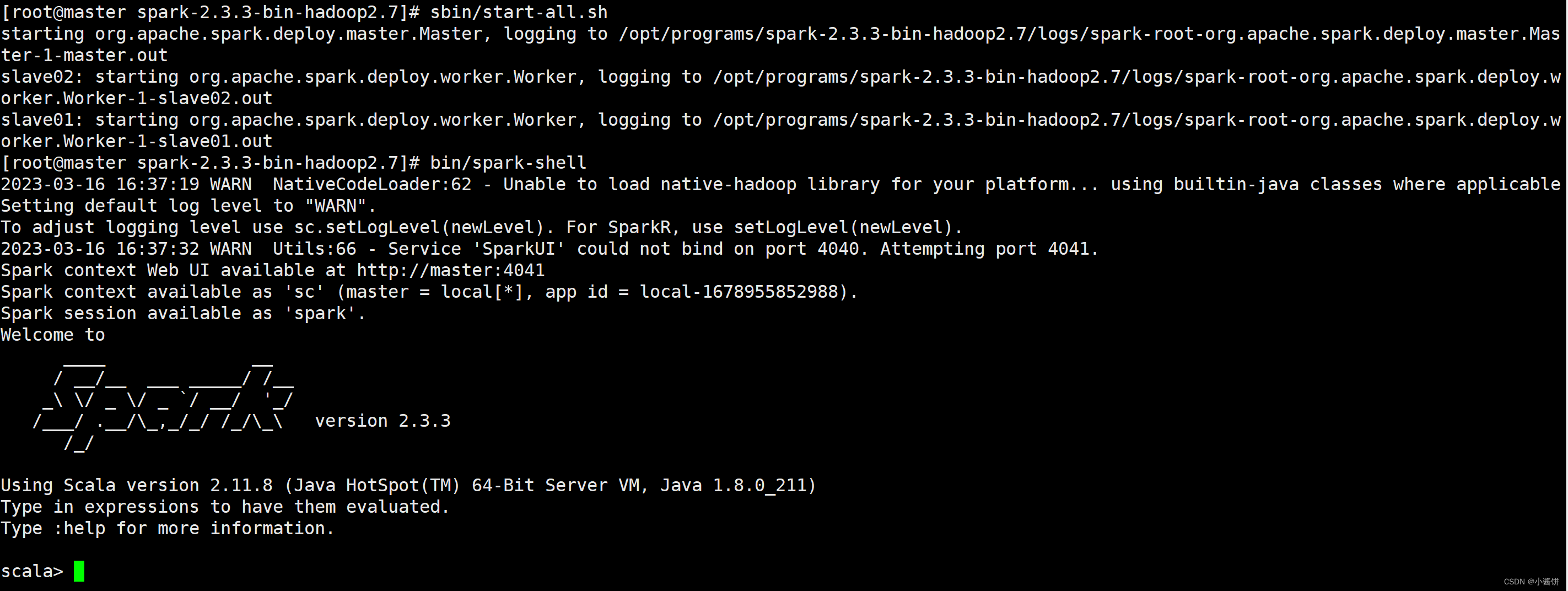

8> 重新启动spark,便可进入spark中

sbin/start-all.sh

bin/spark-shell

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)