为什么Deep Seek会生成假文献?

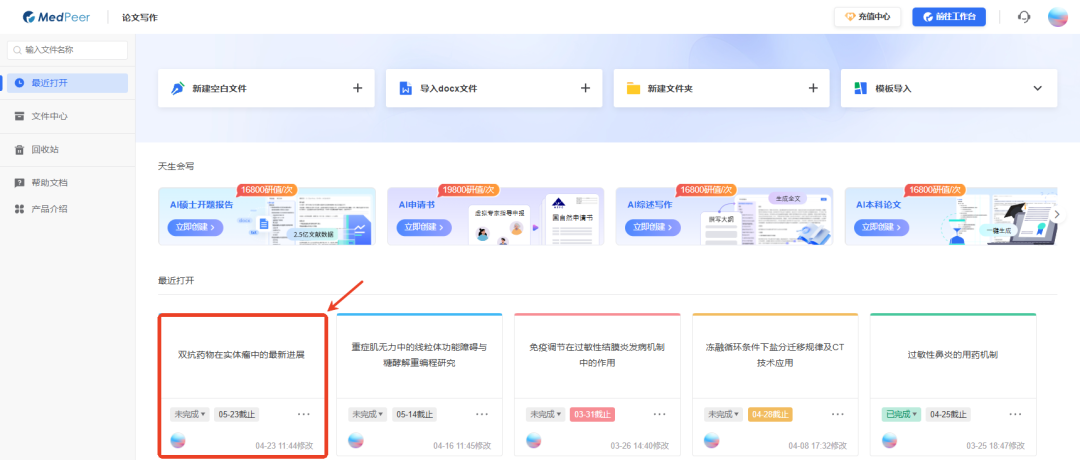

在人工智能与科研深度融合的今天,选择正确的工具不仅关乎效率,更是学术生命的守护。这种"人工+智能"的协同模式,或许正是破解"幻觉文献"困局的最佳答案,也将引领学术研究进入可信计算的新纪元。缺乏有效的验证机制。在此背景下,我们MedPeer推出的DeepSearch智能文献分析与总结工具,通过构建"真实文献库+AI分析"的创新模式,正在重塑学术研究的可信度基准。输入"双抗药物在实体瘤中的最新进展",

经常有人问:为什么用DeepSeek、豆包等大模型进行文献查询时,生成的文献看着很真,实际却查不到?

这类"幻觉文献"现象不仅影响科研效率,更可能造成严重的学术伦理风险。在此背景下,我们MedPeer推出的DeepSearch智能文献分析与总结工具,通过构建"真实文献库+AI分析"的创新模式,正在重塑学术研究的可信度基准。

一、大模型"幻觉文献"产生的技术根源

以DeepSeek为代表的大语言模型,其文献虚构问题源于三个技术特性:

首先,模型的训练数据存在时间滞后性,最新科研成果难以及时纳入知识库。当被问及2023年的新药研究进展时,模型可能基于旧数据编造看似合理的虚假结论。

其次,概率生成机制本质上具有"创造性"。在文献检索场景中,这种特性表现为:当系统未找到完全匹配文献时,模型倾向于通过语义关联"创造"不存在的文献。例如询问"CRISPR技术在帕金森治疗中的应用",模型可能虚构出标题中含相关关键词,但实际未被任何期刊收录的论文。

再者,缺乏有效的验证机制。现有大模型的生成过程如同"黑箱",用户无法追溯信息来源。斯坦福大学人工智能研究院2024年初公布的一项研究成果中表示,他们通过对三款大语言模型中提出20多万个问题后发现,三大系统的幻觉发生率竟然高达69%到88%。

二、Deep Search的真实科研守护体系

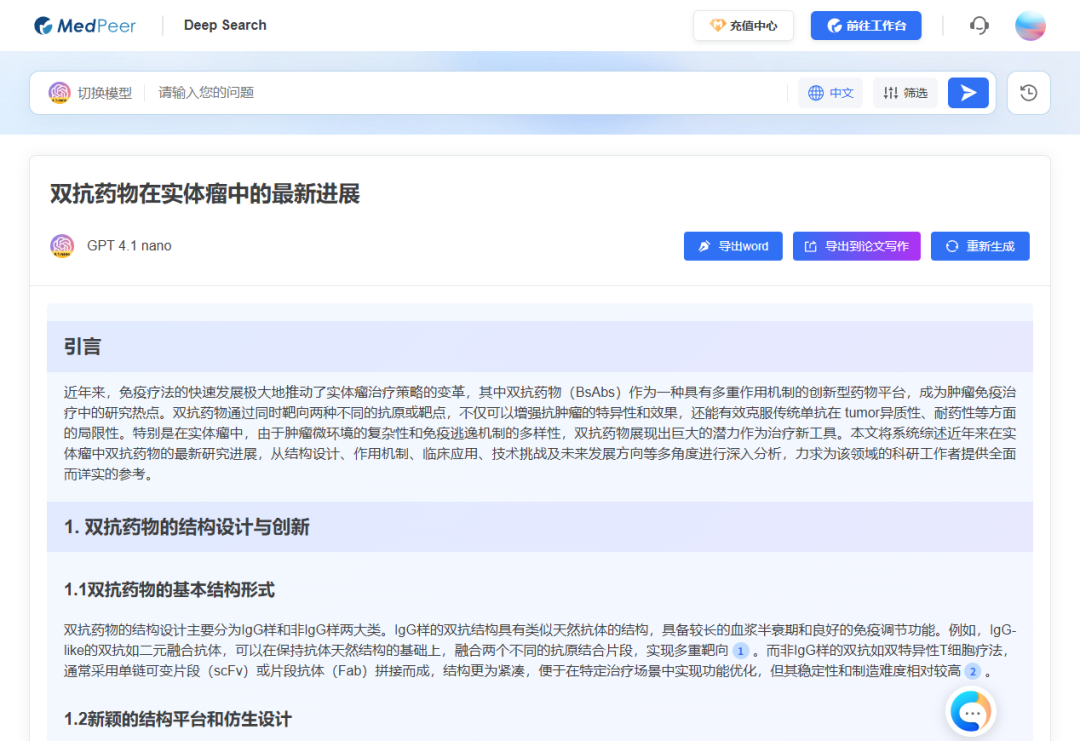

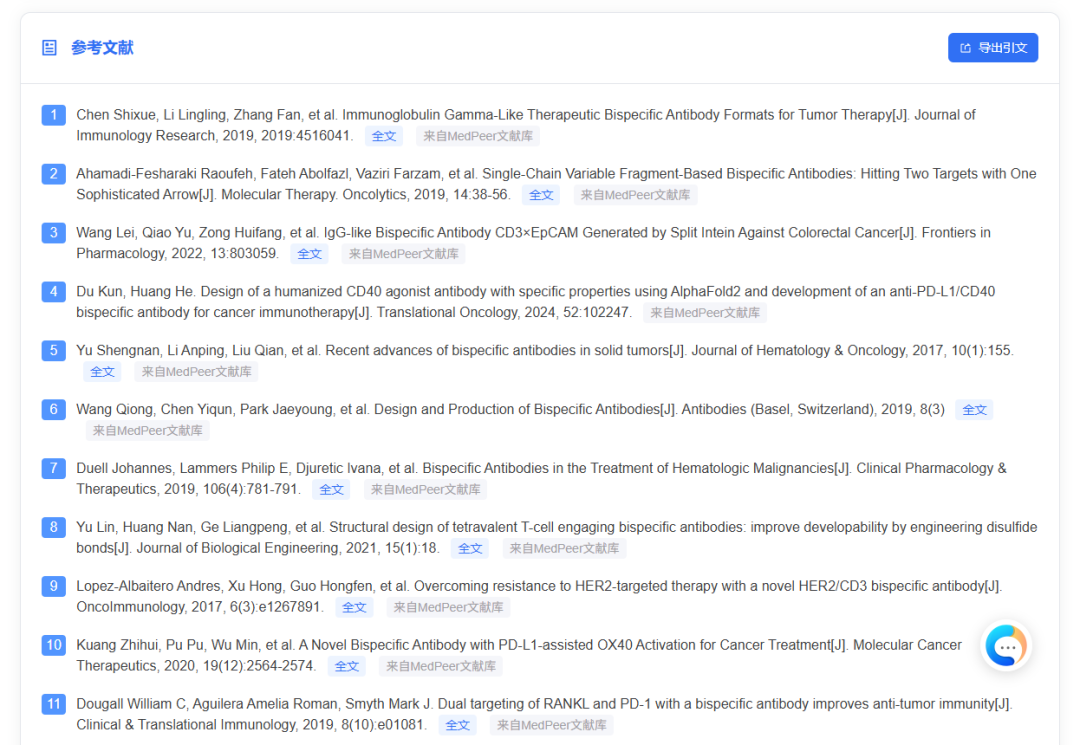

MedPeer研发的Deep Search工具,将传统数周的文献调研压缩至分钟级,引用的文献可直接点击阅读原文并导出标准引文:

1. 精准问题输入

支持自然语言提问和专业术语检索的智能转换。输入"双抗药物在实体瘤中的最新进展",系统自动解析为"(bispecific antibody) AND (solid tumor) "的检索式。

2. 智能条件筛选

可以选择不同的AI大模型,支持生成中文或者英文内容,也可以选择文献发表时间。

3. 结构化综述生成

AI自动生成包含"引言-研究现状-临床应用与研究进展-挑战与创新-趋势与展望-结论"的mini综述。系统采用证据权重算法,确保高被引文献获得更高论述权重。

4. 无缝衔接论文写作

支持导出标准引文格式(NLM、MLA、APA、AMA等),一键导入论文写作模块,继续完善与丰富。

在人工智能与科研深度融合的今天,选择正确的工具不仅关乎效率,更是学术生命的守护。DeepSearch通过将大模型的分析能力锚定在真实文献地基上,为研究者提供了兼具创新性与可靠性的智能解决方案。这种"人工+智能"的协同模式,或许正是破解"幻觉文献"困局的最佳答案,也将引领学术研究进入可信计算的新纪元。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)