AgenticAI完全指南:从零开始构建你的第一个AI智能体

本文介绍了AgenticAI(智能体AI)从被动工具到自主伙伴的范式转变。传统AI只能进行单次问答,而AgenticAI具备感知、规划、行动和记忆四大核心能力,能自主完成复杂任务。文章通过构建"AI研究助理"的实践案例,详细解析了其工作原理:通过函数调用实现工具交互,利用推理循环实现任务分解与执行。教程包含环境准备、工具定义、Prompt设计和主循环实现等完整开发流程,并探讨了

第一章:Agentic AI的黎明——从“工具”到“伙伴”的范式转移

1.1 什么是Agentic AI?

想象一下,你过去使用AI的方式,可能像是使用一个功能强大的计算器:你输入一个问题(“2+2等于多少?”),它给出一个答案(“4”)。这是一种被动响应的模式。AI是一个工具,等待你的指令。

而Agentic AI,或称“智能体AI”,则彻底改变了这一范式。它不再是一个被动的工具,而更像一个能够自主感知、规划、行动和反思的数字伙伴。你可以给它一个高层次的目标(“帮我研究一下2024年电动汽车市场的最新趋势,并生成一份简报”),然后它就能像人类专家一样,分解任务、调用工具(如浏览器、计算器)、搜集信息、进行推理,并最终完成目标。

1.2 Agentic AI的四大核心支柱

一个典型的AI智能体通常由以下四个核心组件构成:

- 感知:智能体如何理解世界和用户的指令。这通常通过解析用户的自然语言输入或观察环境数据(如API返回的JSON)来实现。

- 规划:接收到高层次目标后,智能体需要将其分解为一系列可执行的子任务。例如,“研究市场趋势”可以分解为“搜索最新报告”、“筛选关键信息”、“总结核心观点”等。

- 行动:智能体执行具体步骤的能力。这通常通过调用外部工具或API来完成,例如:

- 使用搜索引擎API查找信息。

- 调用代码解释器进行数据分析。

- 使用数据库API查询记录。

- 发送邮件或通知。

- 记忆:智能体存储和检索信息的能力。这包括:

- 短期记忆:在当前对话或任务循环中保持上下文。

- 长期记忆:将重要信息持久化存储,以便在未来的任务中使用(通常通过向量数据库和检索增强生成RAG技术实现)。

1.3 本教程目标:构建一个“AI研究助理”

在接下来的章节中,我们将从零开始,使用Python和OpenAI API,亲手构建一个具备基础能力的“AI研究助理”。这个智能体将能够:

- 接收一个研究主题。

- 自主决定使用“网络搜索”工具来查找信息。

- 对搜索结果进行总结。

- 最终生成一份结构化的简报。

第二章:基石——从传统AI到Agentic AI的飞跃

2.1 传统AI的局限:一次性的问答

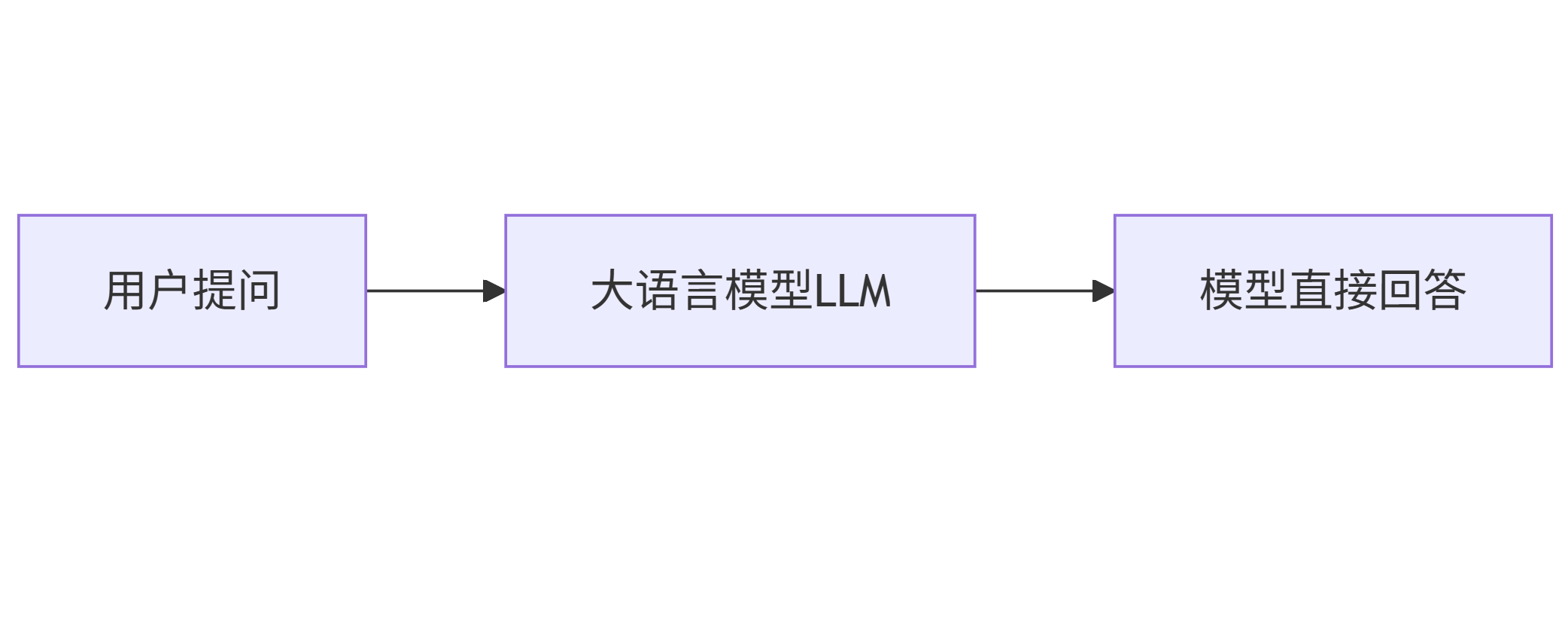

在传统的AI应用中,交互流程是线性的、一次性的。

graph LR

A[用户提问] --> B[大语言模型LLM]

B --> C[模型直接回答]

这种模式非常直接,但无法处理复杂、多步骤的任务。如果你让一个传统模型“帮我查一下天气,如果下雨就提醒我带伞”,它会无能为力,因为它没有“查天气”的工具,也没有“根据条件执行不同操作”的逻辑。

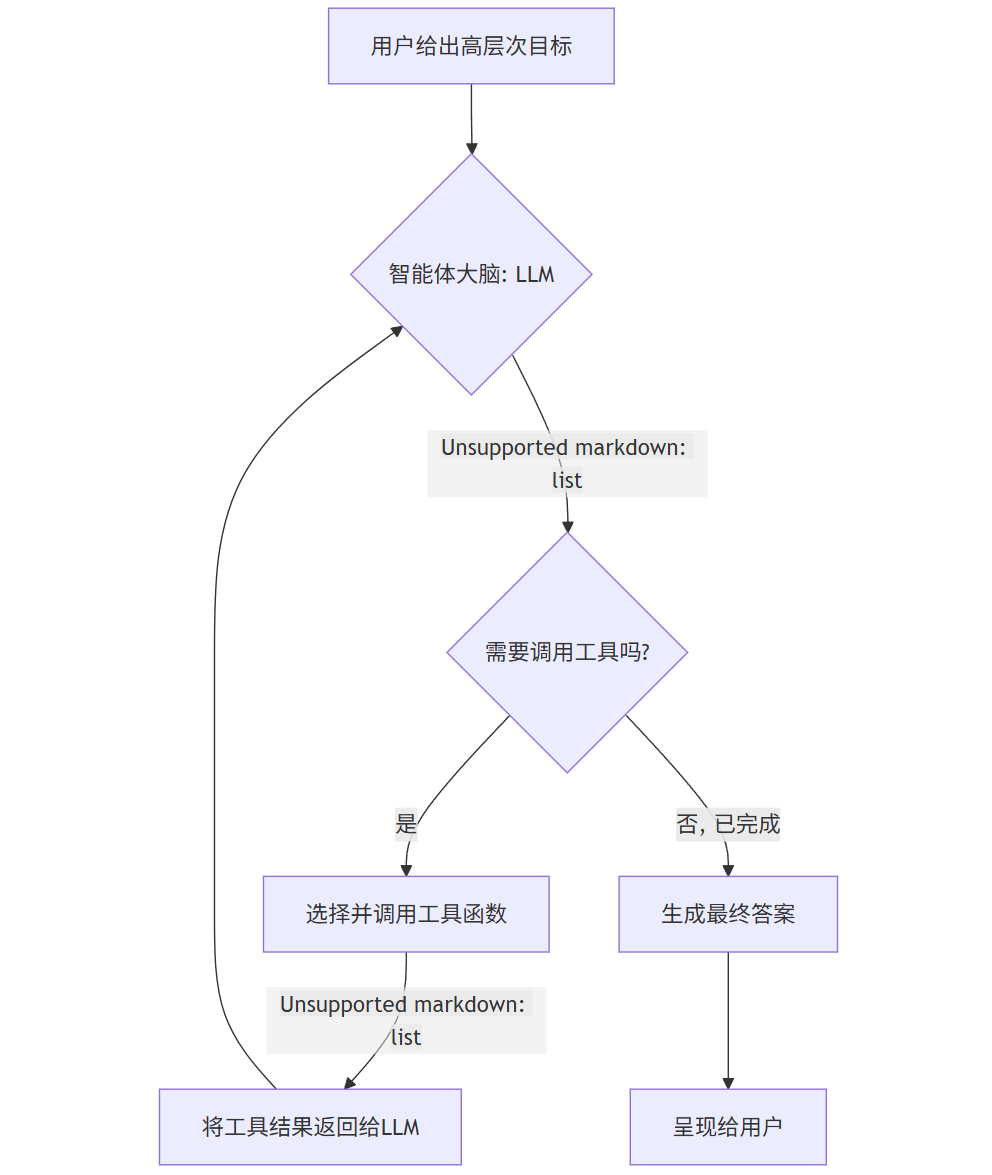

2.2 Agentic AI的核心:推理循环与工具调用

Agentic AI的魔力在于引入了推理循环和工具调用。其核心流程如下:

graph TD

A[用户给出高层次目标] --> B{智能体大脑: LLM};

B -- "1. 分析任务, 决策下一步行动" --> C{需要调用工具吗?};

C -- "是" --> D[选择并调用工具函数];

D -- "2. 执行工具, 获取结果" --> E[将工具结果返回给LLM];

E --> B;

C -- "否, 已完成" --> F[生成最终答案];

F --> G[呈现给用户];

这个流程图揭示了Agentic AI的关键:LLM不再仅仅是答案生成器,而是决策中心。它决定何时、使用哪个工具,然后根据工具返回的结果,进行下一步的思考或生成最终答案。这个“思考-行动-观察-再思考”的循环,赋予了AI智能体强大的问题解决能力。

2.3 关键技术:函数调用

现代LLM(如GPT-4、Claude 3等)提供了一个名为“函数调用”或“工具使用”的强大功能。其工作原理是:

- 定义工具:我们用JSON Schema格式,向LLM描述我们有哪些可用的函数,每个函数的名称、功能以及需要哪些参数。

- LLM决策:在接收到用户请求后,LLM不会直接回答,而是输出一个JSON对象,表示它想要调用哪个函数,以及传入什么参数。

- 执行函数:我们的代码解析这个JSON,在本地执行对应的Python函数。

- 返回结果:将函数的执行结果(例如,网络搜索的摘要)再次作为消息,发送给LLM。

- 最终生成:LLM根据函数返回的结果,生成面向用户的自然语言回答。

第三章:动手实践——构建你的第一个AI研究助理

现在,让我们卷起袖子,开始编码!

3.1 准备工作

- 环境:确保你安装了Python 3.8+。

- 库:安装必要的库。

pip install openai

- API密钥:从OpenAI Platform获取你的API密钥,并设置为环境变量(推荐)或直接在代码中使用。

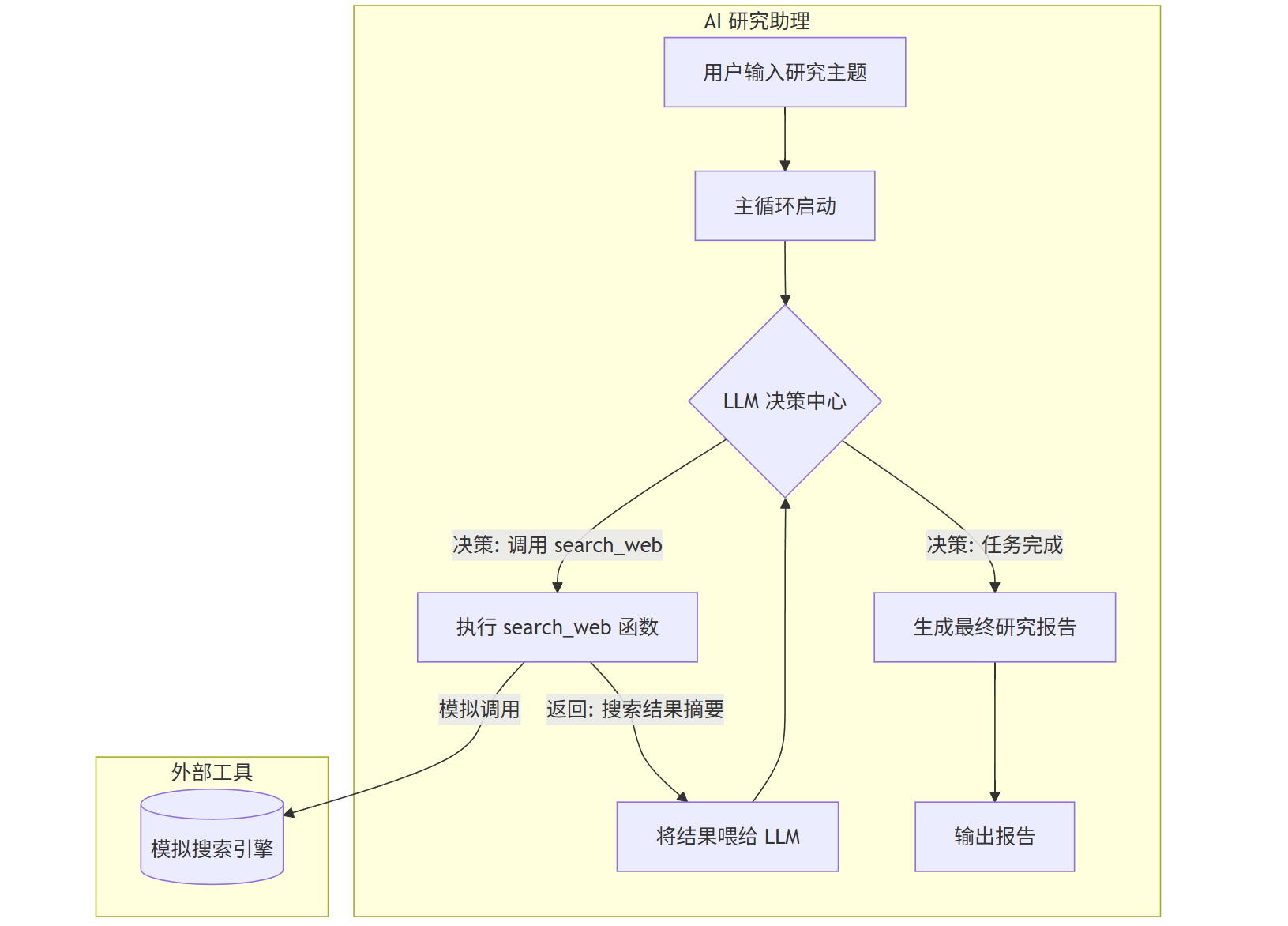

3.2 智能体架构设计

在编码前,我们先画出我们“AI研究助理”的详细工作流程图。

graph TD

subgraph "AI 研究助理"

A[用户输入研究主题] --> B[主循环启动];

B --> C{LLM 决策中心};

C -- "决策: 调用 search_web" --> D[执行 search_web 函数];

D -- "返回: 搜索结果摘要" --> E[将结果喂给 LLM];

E --> C;

C -- "决策: 任务完成" --> F[生成最终研究报告];

F --> G[输出报告];

end

subgraph "外部工具"

D -- "模拟调用" --> H[(模拟搜索引擎)];

end

3.3 代码实现:分步详解

我们将创建一个名为 ai_research_assistant.py 的文件。

第一步:定义工具函数

我们的智能体需要一个核心工具:search_web。为了简化,我们不调用真实的搜索API,而是模拟一个。

import json

from openai import OpenAI

# 模拟一个网络搜索函数

def search_web(query: str) -> str:

"""

模拟网络搜索,根据查询关键词返回预设的搜索结果摘要。

在真实应用中,这里会调用Google Search API, Bing API等。

"""

print(f"--- 正在执行工具: search_web, 查询: {query} ---")

# 模拟数据库

mock_database = {

"2024年电动汽车市场": """

2024年全球电动汽车市场持续高速增长,主要驱动因素包括:

1. 电池技术进步,成本进一步下降。

2. 各国政府补贴政策延续,尤其是欧洲和中国。

3. 主要车企如特斯拉、比亚迪、大众推出更多有竞争力的车型。

市场竞争加剧,中国品牌在海外市场扩张迅速。

""",

"人工智能最新发展": """

2024年AI领域最引人注目的发展是Agentic AI和多模态大模型。

1. Agentic AI(智能体AI)成为新的研究热点,旨在让AI能自主完成复杂任务。

2. 像GPT-4o和Gemini 1.5 Pro这样的模型,能够无缝理解和处理文本、图像、音频等多种信息。

3. AI在科学发现、药物研发等领域的应用取得突破性进展。

"""

}

# 简单的匹配逻辑

for key, value in mock_database.items():

if key in query:

print("--- 搜索完成 ---")

return value

print("--- 未找到相关信息 ---")

return "抱歉,没有找到关于该主题的最新信息。"

# 将我们的函数描述为LLM可以理解的工具

tools = [

{

"type": "function",

"function": {

"name": "search_web",

"description": "当需要研究特定主题或查找最新信息时使用此函数。",

"parameters": {

"type": "object",

"properties": {

"query": {

"type": "string",

"description": "用于搜索的关键词或短语,例如'2024年电动汽车市场'",

},

},

"required": ["query"],

},

},

}

]

第二步:设置LLM客户端与核心Prompt

Prompt是智能体的灵魂。我们需要一个清晰的系统Prompt来告诉LLM它的角色、目标和可用工具。

# 初始化OpenAI客户端

# 确保你的环境变量中设置了 OPENAI_API_KEY

client = OpenAI()

# 系统Prompt:定义智能体的身份和行为准则

SYSTEM_PROMPT = """

你是一个顶级的AI研究助理。你的任务是帮助用户研究他们给出的主题,并生成一份简洁、准确的摘要报告。

为了完成这个任务,你可以使用一个工具:'search_web'。

**工作流程:**

1. 当用户提出一个研究主题时,你必须首先使用 'search_web' 工具来查找相关信息。

2. 仔细分析 'search_web' 返回的结果。

3. 基于搜索结果,为用户生成一份结构化的最终报告。报告应包含核心发现和关键趋势。

**重要规则:**

- 你不能凭空捏造信息。所有报告内容都必须基于 'search_web' 工具返回的结果。

- 你必须且只能使用提供的工具。

- 当你准备好生成最终报告时,直接用自然语言回答,不要再尝试调用任何函数。

"""

第三步:构建智能体的主循环

这是整个智能体的核心逻辑。

def run_research_assistant(user_query: str):

"""运行AI研究助理的主函数"""

print(f"用户: {user_query}")

# 存储对话历史,这是短期记忆的基础

messages = [

{"role": "system", "content": SYSTEM_PROMPT},

{"role": "user", "content": user_query}

]

# 推理循环

while True:

# 1. 调用LLM进行决策

response = client.chat.completions.create(

model="gpt-4-turbo-preview", # 推荐使用支持函数调用的模型

messages=messages,

tools=tools,

tool_choice="auto", # 让模型自己决定是否使用工具

)

response_message = response.choices[0].message

tool_calls = response_message.tool_calls

# 2. 判断LLM是否决定调用工具

if tool_calls:

# 将LLM的回复(包含函数调用信息)添加到历史中

messages.append(response_message)

# 3. 执行工具调用

for tool_call in tool_calls:

function_name = tool_call.function.name

function_to_call = globals().get(function_name)

function_args = json.loads(tool_call.function.arguments)

function_response = function_to_call(

query=function_args.get("query")

)

# 4. 将工具执行结果添加到对话历史

messages.append(

{

"tool_call_id": tool_call.id,

"role": "tool",

"name": function_name,

"content": function_response,

}

)

# 循环继续,将结果喂给LLM进行下一步判断

print("--- LLM正在思考下一步... ---")

else:

# 5. 如果LLM没有调用工具,说明它已经准备好给出最终答案

final_answer = response_message.content

print(f"\n助理: {final_answer}")

break # 退出循环

# --- 主程序入口 ---

if __name__ == "__main__":

# Prompt示例:一个清晰的任务

task = "帮我研究一下2024年电动汽车市场的最新趋势。"

run_research_assistant(task)

print("\n" + "="*50 + "\n")

# Prompt示例:另一个任务

task_2 = "人工智能领域有什么最新发展?"

run_research_assistant(task_2)

3.4 Prompt设计技巧与示例

好的Prompt是智能体成功的关键。让我们分析一下上面的SYSTEM_PROMPT,并探讨一些设计技巧。

| 技巧 | 坏的Prompt示例 | 好的Prompt示例 (我们的SYSTEM_PROMPT) | 为什么好? |

|---|---|---|---|

| 角色扮演 | “回答问题。” | “你是一个顶级的AI研究助理。” | 赋予AI一个清晰的角色,能激发其更强的能力,使其输出更符合预期。 |

| 明确目标 | “用工具查东西。” | “你的任务是帮助用户研究他们给出的主题,并生成一份简洁、准确的摘要报告。” | 清晰地定义了最终要达成的目标,而不仅仅是过程。 |

| 步骤化指令 | “自己想办法。” | “1. 当用户提出…你必须首先使用… 2. 仔细分析… 3. 基于搜索结果,生成…” | 将复杂任务分解为具体步骤,引导LLM进行正确的推理链。 |

| 设定边界 | “别乱说。” | “你不能凭空捏造信息。所有报告内容都必须基于… 你必须且只能使用提供的工具。” | 明确的约束可以有效防止AI“幻觉”,并确保其在可控范围内行动。 |

| 指定输出格式 | “给我结果。” | “当你准备好生成最终报告时,直接用自然语言回答…” | 告诉AI在什么条件下、以何种形式输出最终结果,避免无限循环。 |

第四章:进阶探索——记忆、反思与多代理系统

我们的第一个智能体虽然功能强大,但还很初级。要构建更强大的智能体,我们需要引入更高级的概念。

4.1 记忆:让智能体拥有“过去”

我们的messages列表就是一种短期记忆。它只存在于当前任务的运行期间。一旦程序重启,记忆就消失了。

长期记忆则允许智能体跨任务、跨会话地存储和检索信息。最流行的实现方式是检索增强生成。

工作原理:

- 存储:当智能体获得新信息时,使用一个“嵌入模型”将其转换为向量,并存入向量数据库。

- 检索:当遇到新任务时,将任务也转换为向量,并在数据库中找到最相似的旧信息。

- 增强:将这些检索到的相关信息作为上下文,一并提供给LLM,帮助它更好地决策。

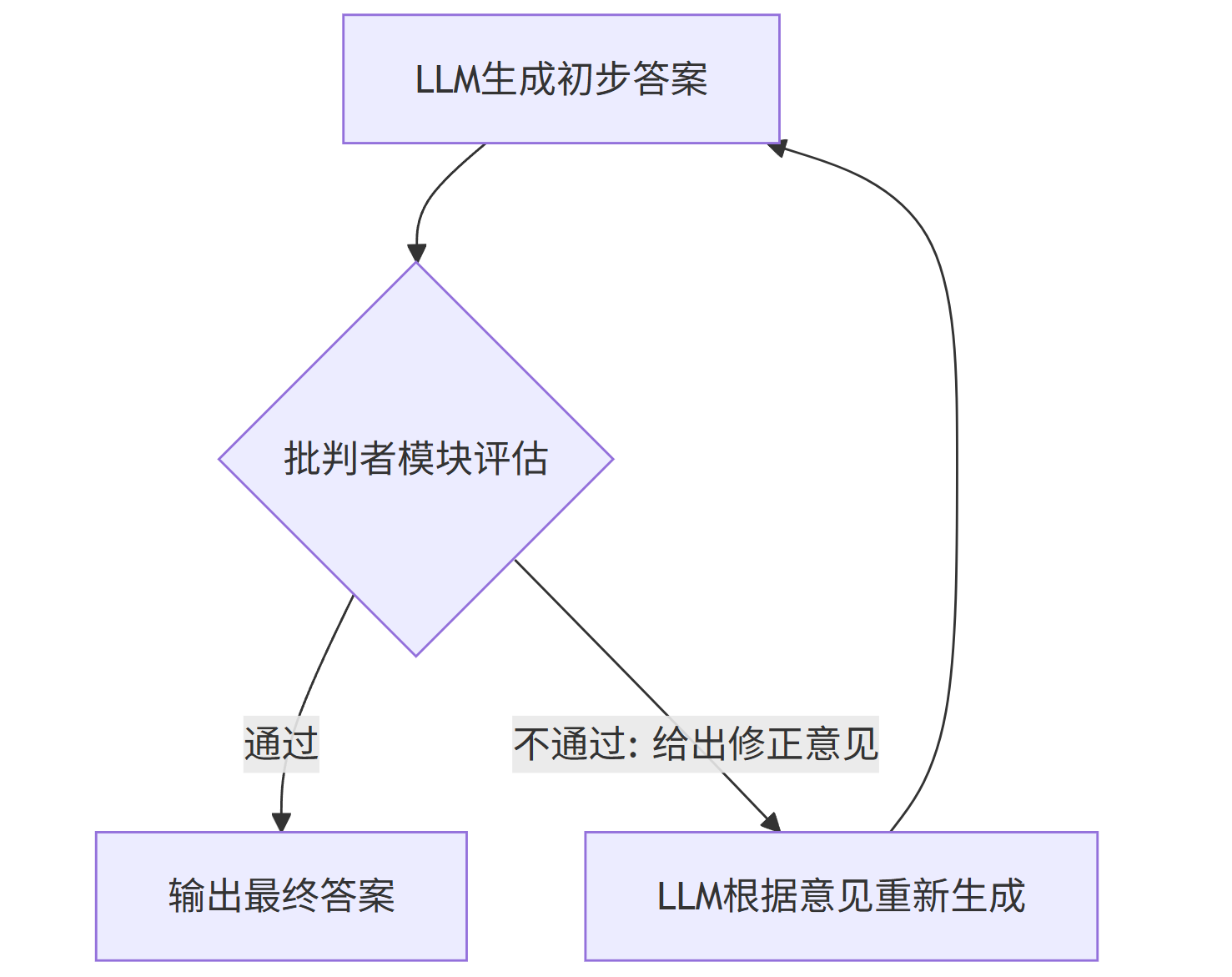

4.2 反思与自我修正:让智能体更可靠

人类会犯错,也会反思和修正。高级的智能体也应如此。我们可以在推理循环中加入一个“批判者”或“评估者”环节。

graph TD

A[LLM生成初步答案] --> B{批判者模块评估};

B -- "通过" --> C[输出最终答案];

B -- "不通过: 给出修正意见" --> D[LLM根据意见重新生成];

D --> A;

实现思路:

- 在LLM生成最终答案后,调用另一个LLM(或同一个LLM但用不同的Prompt)来评估答案的质量。

- 评估标准可以包括:事实准确性、是否完整回答了问题、逻辑是否清晰等。

- 如果评估不通过,则将评估意见反馈给主LLM,要求其重新生成。

4.3 多代理系统:团队的力量

单个智能体能力有限。更复杂的任务可以通过多代理系统来完成,就像一个专业团队。

常见模式:

- 协作模式:一个“经理”代理负责分解任务,并将不同的子任务分发给专业的“工人”代理(如“搜索代理”、“写作代理”、“数据分析代理”)。

- 辩论模式:多个代理从不同角度对同一个问题提出解决方案,通过辩论和论证,得出最优解。

第五章:应用场景与未来展望

5.1 Agentic AI的应用场景

Agentic AI的潜力是巨大的,它正在渗透到各行各业:

- 个人助理:能够真正管理你日程、预订机票、处理邮件的超级助理。

- 软件开发:AI智能体可以接收需求文档,自动编写代码、进行测试、甚至部署应用。

- 科学研究:自主设计实验、分析数据、撰写论文的“AI科学家”。

- 金融交易:实时分析市场动态,自主执行交易策略的“AI交易员”。

- 客户服务:不仅能回答问题,还能主动为客户办理业务、解决复杂问题的“AI客服”。

5.2 挑战与风险

尽管前景光明,但Agentic AI也带来了新的挑战:

- 可控性与安全性:如何确保一个自主行动的智能体不会做出有害或意想不到的行为?

- 成本:复杂的推理循环意味着多次调用LLM API,成本高昂。

- 可靠性:智能体的决策依赖于LLM的推理能力,目前的LLM仍可能犯错,导致整个任务失败。

- 伦理问题:当AI能自主行动时,责任归属问题变得复杂。

5.3 未来展望

Agentic AI是通向通用人工智能(AGI)的关键一步。未来的发展方向可能包括:

- 更强的推理能力:LLM本身的逻辑和规划能力将持续提升。

- 更自然的交互:与智能体的交互将不再局限于文本,而是语音、图像等多模态的融合。

- 更广泛的应用生态:会出现一个“App Store”式的平台,提供各种预制的AI智能体和工具。

- 人机协同:人类将从“操作者”转变为“指挥者”和“协作者”,与AI智能体共同完成创造性工作。

总结

通过本教程,我们从零开始,理解了Agentic AI的核心思想,掌握了其基本架构,并亲手构建了一个能够自主完成研究任务的AI智能体。我们学习了如何定义工具、设计高效的Prompt,并构建了关键的推理循环。

Agentic AI不仅仅是一项技术,更是一种全新的构建AI应用的思维范式。它将AI从一个被动的“问答机器”提升为一个主动的“行动伙伴”。虽然我们今天构建的智能体还很基础,但它已经揭示了未来AI的无限可能。

现在,轮到你了。尝试扩展你的AI研究助理:

- 为它添加更多工具,比如

save_to_file或send_email。 - 引入一个简单的长期记忆机制。

- 尝试构建一个包含“搜索者”和“写手”的微型多代理系统。

探索的道路才刚刚开始,欢迎来到AgenticAI的激动人心的世界!

更多推荐

已为社区贡献33条内容

已为社区贡献33条内容

所有评论(0)