【超实用】构建本地化深度研究系统:ChatGPT级能力+隐私保护,小白也能学会,建议收藏!

本文详细介绍了一个基于MCP的本地化深度研究工具构建方案,采用Linkup、CrewAI和Ollama + DeepSeek-R1等技术栈,通过多智能体协作实现ChatGPT级研究能力。该方案解决了在线工具的隐私担忧、网络依赖和定制化限制问题,最终集成到Cursor中使用,为专业人士提供了安全可控的研究工具。

在AI时代,深度研究能力已经成为了许多专业人士的刚需。ChatGPT的研究功能虽然强大,但往往受限于网络访问和数据隐私的考量。今天,我将带你一步步构建一个完全本地化的深度研究工具,它不仅能够实现ChatGPT级别的研究能力,还能确保你的数据安全和隐私保护。

一、为什么选择本地化方案?

在实际工作中,我经常遇到这样的场景:需要对敏感话题进行深度研究,或者在网络环境受限的情况下仍需要高质量的信息检索和分析。传统的在线AI工具虽然便捷,但存在几个明显的痛点:

- 数据隐私担忧:你的查询内容会被上传到云端

- 网络依赖性:离线环境下无法使用

- 定制化限制:难以根据特定需求调整研究流程

基于这些考量,我决定构建一个基于MCP(Model Context Protocol)的本地化研究工具。

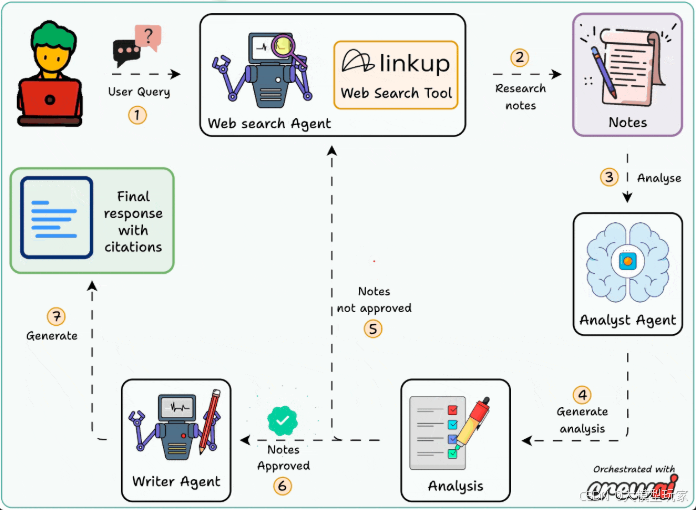

二、技术架构设计

整个系统采用多智能体协作的架构,就像一个专业的研究团队:

核心技术栈包括:

- Linkup:提供企业级的网络搜索能力

- CrewAI:实现多智能体的协同工作

- Ollama + DeepSeek-R1:本地部署的大语言模型

- Cursor + MCP:作为统一的交互界面

三、动手实现:从代码到实战

第一步:环境准备

首先,我们需要安装必要的依赖包:

pip install crewai linkup-sdk ollama mcp

接下来部署DeepSeek-R1模型:

ollama pull deepseek-r1:latest

第二步:定义网络搜索工具

Linkup提供了媲美Perplexity和OpenAI的搜索能力。让我们先封装一个搜索工具:

import os

from linkup import LinkupClient

from crewai_tools import BaseTool

from typing import Type

from pydantic import BaseModel, Field

class SearchInput(BaseModel):

"""搜索输入模型"""

query: str = Field(..., description="搜索查询内容")

depth: str = Field(default="standard", description="搜索深度:basic, standard, deep")

class LinkupSearchTool(BaseTool):

name: str = "linkup_search"

description: str = "使用Linkup进行深度网络搜索,获取最新和最相关的信息"

args_schema: Type[BaseModel] = SearchInput

def __init__(self, **kwargs):

super().__init__(**kwargs)

# 初始化Linkup客户端

self.client = LinkupClient(api_key=os.getenv("LINKUP_API_KEY"))

def _run(self, query: str, depth: str = "standard") -> str:

"""执行搜索操作"""

try:

# 调用Linkup API进行搜索

response = self.client.search(

query=query,

depth=depth,

output_type="structured"

)

# 格式化搜索结果

results = []

for item in response.get('results', []):

result = {

'title': item.get('title', ''),

'url': item.get('url', ''),

'content': item.get('content', ''),

'published_date': item.get('published_date', ''),

'relevance_score': item.get('relevance_score', 0)

}

results.append(result)

return self._format_results(results)

except Exception as e:

return f"搜索过程中出现错误: {str(e)}"

def _format_results(self, results) -> str:

"""格式化搜索结果为可读文本"""

formatted = "=== 搜索结果 ===\n\n"

for i, result in enumerate(results[:10], 1): # 限制为前10个结果

formatted += f"## 结果 {i}\n"

formatted += f"**标题**: {result['title']}\n"

formatted += f"**链接**: {result['url']}\n"

formatted += f"**发布日期**: {result['published_date']}\n"

formatted += f"**相关度**: {result['relevance_score']:.2f}\n"

formatted += f"**内容摘要**: {result['content'][:500]}...\n\n"

return formatted

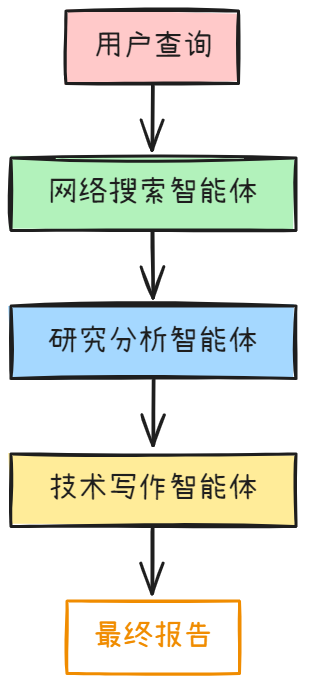

第三步:构建智能体团队

现在让我们创建三个专业的智能体:

from crewai import Agent, Task, Crew, Process

# 配置本地LLM

def get_local_llm():

return {

"model": "ollama/deepseek-r1",

"base_url": "http://localhost:11434"

}

# 网络搜索智能体

search_agent = Agent(

role='网络搜索专家',

goal='根据用户查询从互联网获取最新、最相关的信息',

backstory='''你是一位经验丰富的信息检索专家,擅长使用各种搜索策略

找到最有价值的信息源。你深知如何构造有效的搜索查询,

并能够识别高质量的信息来源。''',

tools=[LinkupSearchTool()],

llm=get_local_llm(),

verbose=True,

allow_delegation=False

)

# 研究分析智能体

research_agent = Agent(

role='研究分析师',

goal='将原始搜索结果转化为结构化的分析报告',

backstory='''你是一位资深的研究分析师,具备强大的信息整合能力。

你能够识别信息的可靠性,去除重复内容,并将散乱的信息

整理成逻辑清晰的分析框架。''',

llm=get_local_llm(),

verbose=True,

allow_delegation=True # 允许委托搜索智能体进行事实核查

)

# 技术写作智能体

writer_agent = Agent(

role='技术写作专家',

goal='将研究分析结果整合成专业、易读的报告',

backstory='''你是一位专业的技术写作专家,擅长将复杂的信息

转化为清晰、结构化的文档。你注重引用的准确性,

并能够以读者友好的方式呈现技术内容。''',

llm=get_local_llm(),

verbose=True,

allow_delegation=False

)

def create_research_crew(query: str):

"""创建研究团队并定义任务"""

# 搜索任务

search_task = Task(

description=f'''

对以下查询进行全面的网络搜索:"{query}"

要求:

1. 使用多个相关的搜索关键词

2. 寻找最新的信息(优先考虑近期发布的内容)

3. 收集来自不同来源的信息以确保全面性

4. 记录每个信息来源的URL和发布日期

输出格式:结构化的搜索结果列表,包含标题、链接、摘要和发布时间

''',

agent=search_agent,

expected_output="详细的搜索结果列表,包含至少5-10个高质量信息源"

)

# 分析任务

analysis_task = Task(

description=f'''

基于搜索结果,对查询"{query}"进行深度分析:

分析要求:

1. 验证信息的准确性和可靠性

2. 识别并去除重复或矛盾的信息

3. 按主题对信息进行分类整理

4. 标注信息来源和发布时间

5. 如需要,可以委托搜索智能体进行补充调研

输出格式:结构化的分析报告,包含关键发现、数据支撑和来源引用

''',

agent=research_agent,

expected_output="结构化的研究分析报告,包含关键洞察和完整的引用信息",

context=[search_task] # 依赖搜索任务的结果

)

# 写作任务

writing_task = Task(

description=f'''

基于研究分析结果,撰写关于"{query}"的综合性报告:

报告要求:

1. 清晰的结构:摘要、主要发现、详细分析、结论

2. 每个关键观点都要有可靠的引用支撑

3. 使用专业但易懂的语言

4. 包含完整的参考文献列表

5. 总字数控制在2000-3000字

格式要求:使用Markdown格式,便于后续处理和展示

''',

agent=writer_agent,

expected_output="专业的Markdown格式研究报告,包含完整引用和参考文献",

context=[analysis_task], # 依赖分析任务的结果

output_file=f"research_report_{query.replace(' ', '_')}.md"

)

# 创建研究团队

crew = Crew(

agents=[search_agent, research_agent, writer_agent],

tasks=[search_task, analysis_task, writing_task],

process=Process.sequential, # 顺序执行任务

verbose=True

)

return crew

第四步:封装为MCP服务器

现在我们将整个研究系统封装为一个MCP服务器:

from mcp.server import Server

from mcp.server.models import InitializationOptions

import mcp.server.stdio

from mcp.types import Tool, TextContent

import asyncio

import json

class ResearchMCPServer:

def __init__(self):

self.server = Server("deep-research-tool")

self.setup_tools()

def setup_tools(self):

"""设置MCP工具"""

@self.server.list_tools()

async def handle_list_tools():

"""列出可用工具"""

return [

Tool(

name="deep_research",

description="使用多智能体系统进行深度网络研究",

inputSchema={

"type": "object",

"properties": {

"query": {

"type": "string",

"description": "研究查询内容"

},

"depth": {

"type": "string",

"enum": ["basic", "standard", "deep"],

"description": "研究深度级别",

"default": "standard"

}

},

"required": ["query"]

}

)

]

@self.server.call_tool()

async def handle_call_tool(name: str, arguments: dict):

"""处理工具调用"""

if name == "deep_research":

return await self.execute_research(

arguments.get("query", ""),

arguments.get("depth", "standard")

)

else:

raise ValueError(f"Unknown tool: {name}")

async def execute_research(self, query: str, depth: str):

"""执行深度研究"""

try:

# 设置搜索深度

os.environ["SEARCH_DEPTH"] = depth

# 创建研究团队

crew = create_research_crew(query)

# 执行研究任务

result = crew.kickoff()

# 返回结果

return [TextContent(

type="text",

text=f"""# 深度研究报告

## 查询内容

{query}

## 研究深度

{depth}

## 研究结果

{result}

---

*本报告由本地化多智能体研究系统生成*

"""

)]

except Exception as e:

return [TextContent(

type="text",

text=f"研究过程中出现错误: {str(e)}"

)]

async def run(self):

"""运行MCP服务器"""

async with mcp.server.stdio.stdio_server() as (read_stream, write_stream):

await self.server.run(

read_stream,

write_stream,

InitializationOptions(

server_name="deep-research-tool",

server_version="1.0.0"

)

)

# 启动MCP服务器

if __name__ == "__main__":

server = ResearchMCPServer()

asyncio.run(server.run())

第五步:集成到Cursor

最后一步是将我们的MCP服务器集成到Cursor中。创建一个配置文件 mcp_config.json:

{

"mcpServers": {

"deep-research-tool": {

"command": "python",

"args": ["path/to/your/research_server.py"],

"env": {

"LINKUP_API_KEY": "your_linkup_api_key_here"

}

}

}

}

在Cursor中的配置路径: File → Preferences → Cursor Settings → MCP → Add new global MCP server

将配置文件的内容添加到MCP设置中。

四、实战测试

现在让我们测试一下我们的研究工具。在Cursor中输入:

使用深度研究工具调研"2025年人工智能在医疗诊断领域的最新进展"

系统会自动:

- 通过网络搜索智能体收集相关信息

- 由研究分析智能体进行信息验证和整理

- 技术写作智能体生成最终的研究报告

五、优势与特色

与传统的在线研究工具相比,我们的本地化方案具有以下优势:

- 隐私保护:所有数据处理都在本地进行,确保敏感信息不会泄露。

- 可定制性:你可以根据具体需求调整搜索策略、分析维度和报告格式。

- 成本控制:除了Linkup的搜索费用外,其他所有计算都在本地完成,长期使用成本更低。

- 离线能力:一旦部署完成,除了网络搜索环节,其他分析和写作都可以在离线环境下进行。

六、扩展思路

这个基础框架还有很多扩展的可能:

- 专业化定制:针对不同领域(如法律、医疗、金融)创建专门的智能体

- 数据源集成:接入更多的数据源,如学术数据库、企业内部文档等

- 多语言支持:扩展为支持多语言的研究工具

- 结果可视化:增加图表和数据可视化功能

七、总结

通过这个项目,我们成功构建了一个功能完整的本地化深度研究工具。它不仅具备了与ChatGPT相媲美的研究能力,还在隐私保护和定制化方面具有明显优势。

整个系统的核心在于多智能体的协作:每个智能体都专注于自己擅长的领域,通过合理的任务分工和数据流转,最终产出高质量的研究报告。

如果你也在寻找一个可控、安全、可定制的研究工具,不妨试试这个方案。相信它会成为你研究工作中的得力助手。

普通人如何抓住AI大模型的风口?

领取方式在文末

为什么要学习大模型?

目前AI大模型的技术岗位与能力培养随着人工智能技术的迅速发展和应用 , 大模型作为其中的重要组成部分 , 正逐渐成为推动人工智能发展的重要引擎 。大模型以其强大的数据处理和模式识别能力, 广泛应用于自然语言处理 、计算机视觉 、 智能推荐等领域 ,为各行各业带来了革命性的改变和机遇 。

目前,开源人工智能大模型已应用于医疗、政务、法律、汽车、娱乐、金融、互联网、教育、制造业、企业服务等多个场景,其中,应用于金融、企业服务、制造业和法律领域的大模型在本次调研中占比超过 30%。

随着AI大模型技术的迅速发展,相关岗位的需求也日益增加。大模型产业链催生了一批高薪新职业:

人工智能大潮已来,不加入就可能被淘汰。如果你是技术人,尤其是互联网从业者,现在就开始学习AI大模型技术,真的是给你的人生一个重要建议!

最后

只要你真心想学习AI大模型技术,这份精心整理的学习资料我愿意无偿分享给你,但是想学技术去乱搞的人别来找我!

在当前这个人工智能高速发展的时代,AI大模型正在深刻改变各行各业。我国对高水平AI人才的需求也日益增长,真正懂技术、能落地的人才依旧紧缺。我也希望通过这份资料,能够帮助更多有志于AI领域的朋友入门并深入学习。

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

大模型全套学习资料展示

自我们与MoPaaS魔泊云合作以来,我们不断打磨课程体系与技术内容,在细节上精益求精,同时在技术层面也新增了许多前沿且实用的内容,力求为大家带来更系统、更实战、更落地的大模型学习体验。

希望这份系统、实用的大模型学习路径,能够帮助你从零入门,进阶到实战,真正掌握AI时代的核心技能!

01 教学内容

-

从零到精通完整闭环:【基础理论 →RAG开发 → Agent设计 → 模型微调与私有化部署调→热门技术】5大模块,内容比传统教材更贴近企业实战!

-

大量真实项目案例: 带你亲自上手搞数据清洗、模型调优这些硬核操作,把课本知识变成真本事!

02适学人群

应届毕业生: 无工作经验但想要系统学习AI大模型技术,期待通过实战项目掌握核心技术。

零基础转型: 非技术背景但关注AI应用场景,计划通过低代码工具实现“AI+行业”跨界。

业务赋能突破瓶颈: 传统开发者(Java/前端等)学习Transformer架构与LangChain框架,向AI全栈工程师转型。

vx扫描下方二维码即可

本教程比较珍贵,仅限大家自行学习,不要传播!更严禁商用!

03 入门到进阶学习路线图

大模型学习路线图,整体分为5个大的阶段:

04 视频和书籍PDF合集

从0到掌握主流大模型技术视频教程(涵盖模型训练、微调、RAG、LangChain、Agent开发等实战方向)

新手必备的大模型学习PDF书单来了!全是硬核知识,帮你少走弯路(不吹牛,真有用)

05 行业报告+白皮书合集

收集70+报告与白皮书,了解行业最新动态!

06 90+份面试题/经验

AI大模型岗位面试经验总结(谁学技术不是为了赚$呢,找个好的岗位很重要)

07 deepseek部署包+技巧大全

由于篇幅有限

只展示部分资料

并且还在持续更新中…

真诚无偿分享!!!

vx扫描下方二维码即可

加上后会一个个给大家发

更多推荐

已为社区贡献88条内容

已为社区贡献88条内容

所有评论(0)