具身智能:从 LLMs 到世界模型(上)

25年9月来自清华和复旦的综述论文“Embodied AI: From LLMs to World Models”。具身人工智能 (AI) 是实现通用人工智能 (AGI) 的智能系统范式,是各种应用的基石,并推动着从网络空间到物理系统的演进。大语言模型 (LLM) 和世界模型 (WM) 的最新突破,引发了人们对具身人工智能的广泛关注。一方面,LLM 通过语义推理和任务分解赋能具身人工智能,将高级自

25年9月来自清华和复旦的综述论文“Embodied AI: From LLMs to World Models”。

具身人工智能 (AI) 是实现通用人工智能 (AGI) 的智能系统范式,是各种应用的基石,并推动着从网络空间到物理系统的演进。大语言模型 (LLM) 和世界模型 (WM) 的最新突破,引发了人们对具身人工智能的广泛关注。一方面,LLM 通过语义推理和任务分解赋能具身人工智能,将高级自然语言指令和低级自然语言动作引入具身认知。另一方面,WM 通过构建外部世界的内部表征和未来预测赋能具身人工智能,从而促进符合物理定律的具身交互。

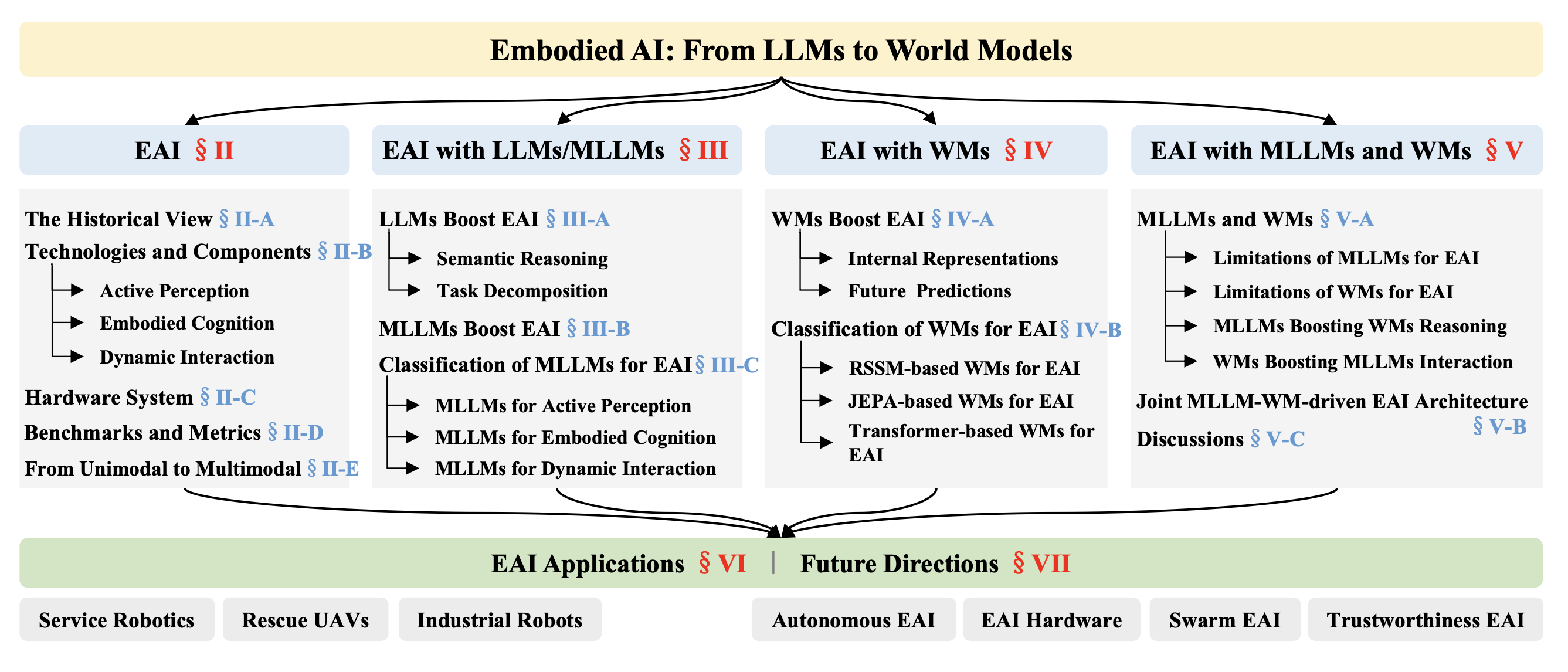

本文全面探讨具身人工智能领域从基础到前沿的文献,涵盖 LLM 驱动和 WM 驱动的著作。具体而言,首先介绍具身人工智能的历史、关键技术、关键组件和硬件系统,并从单模态到多模态的角度探讨其发展历程。然后,深入探讨具身人工智能的两个新兴领域,即基于LLM 模型/多模态 LLM 模型(MLLM)的具身人工智能和基于世界模型(WM)的具身人工智能,并详细阐述了它们在端到端具身认知和物理定律驱动的具身交互中不可或缺的作用。基于上述进展,进一步分享对 MLLM-WM 联合驱动的具身人工智能架构必要性的见解,阐明了其在物理世界中实现复杂任务的深远意义。此外,还分析具身人工智能的代表性应用,展示其在现实世界场景中的广泛适用性。最后,指出具身人工智能未来值得进一步研究的方向。

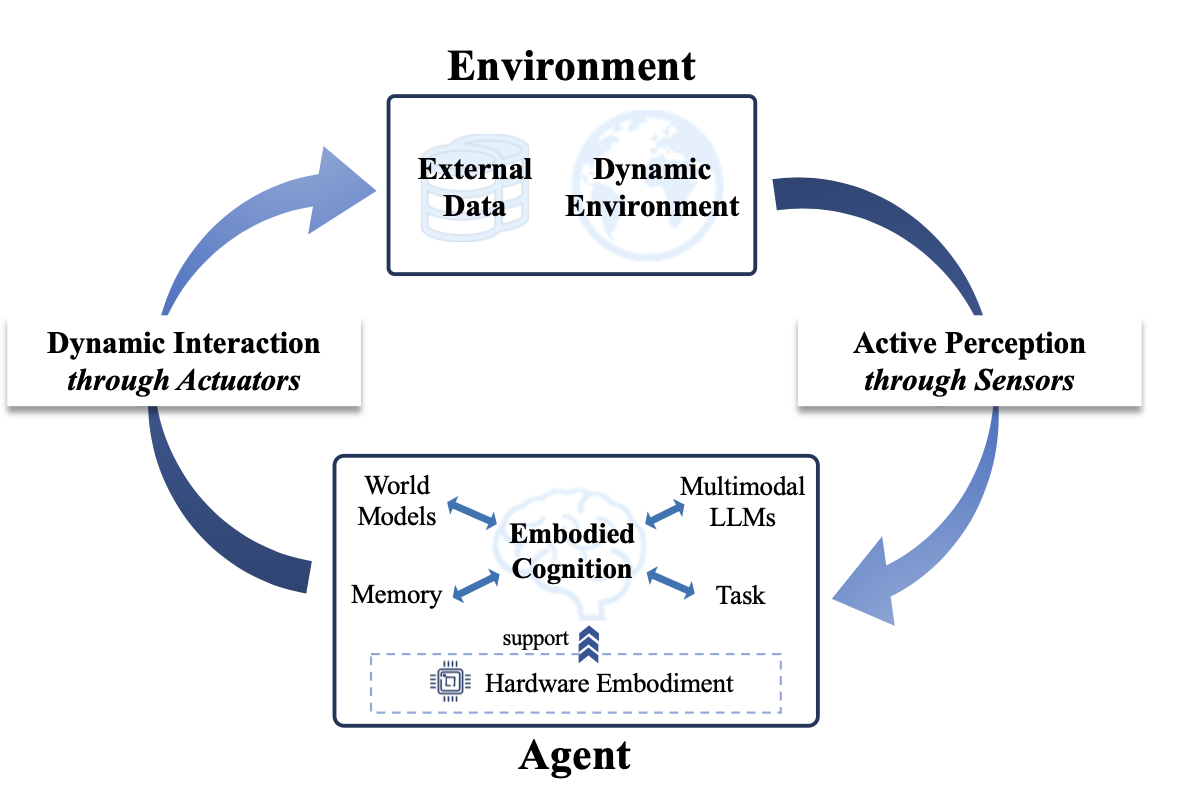

具身人工智能 (AI) 起源于艾伦·图灵于 1950 年提出的具身图灵测试 [1],旨在探索智体是否能够模仿人类智能,实现通用人工智能 (AGI)。其中,只能解决数字世界(网络空间)中抽象问题的智体,通常被定义为非具身人工智能,而能够与物理世界交互的智能体则被视为具身人工智能。具身人工智能建立在认知科学和神经科学的基础理论之上 [2], [3],该理论认为智能源于感知、认知和交互的动态耦合。如图所示,具身人工智能以闭环方式包含三个关键组成部分,即:1)主动感知(传感器驱动的环境观察),2)具身认知(历史经验驱动的认知更新),以及 3)动态交互(执行器介导的动作控制)。此外,由于计算和能耗需求不断增长,尤其是在实际部署场景中设备延迟和功耗受限的情况下,硬件具身[4]–[6] 也至关重要。

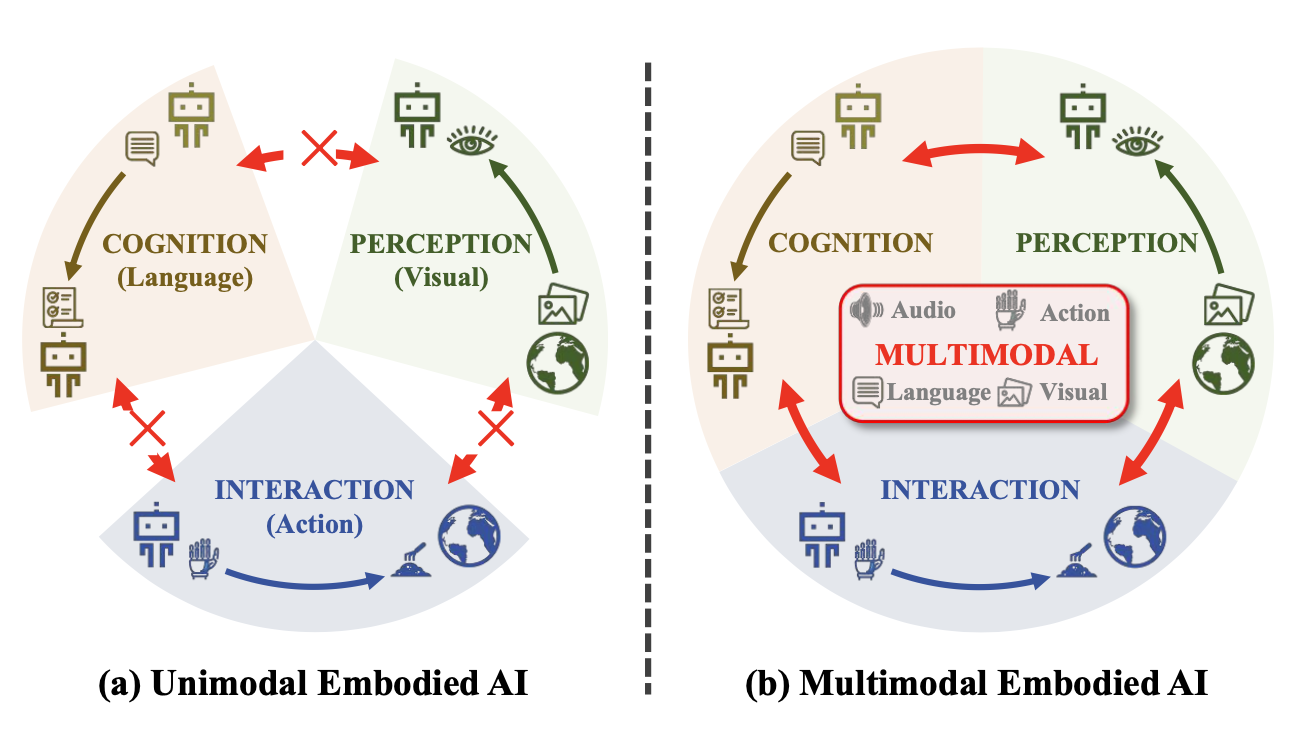

具身人工智能的发展已从单模态范式演变为多模态范式。在早期阶段,具身人工智能的研究主要集中于具有单一模态的单个组件,例如视觉、语言或动作,其中感知、认知或交互组件由一种感官输入驱动 [7], [8],例如,感知往往由视觉模态主导 [9],认知往往由语言模态主导 [10], [11],交互往往由动作模态主导 [12], [13]。虽然这些方法在单个组件内表现良好,但它们受到每种模态提供的信息范围狭窄以及跨组件模态之间固有差距的限制。具身人工智能的持续发展见证了单模态方法的局限性,推动了向多感知模态集成的重大转变 [14]–[16]。因此,多模态具身人工智能 [17], [18] 自然而然地应运而生,以创建更具适应性、灵活性和鲁棒性的智体,使其能够在动态环境中执行复杂任务。

大语言模型 (LLM) 通过语义推理 [19] 和任务分解 [20], [21] 为具身人工智能赋能,将高级自然语言指令和低级自然语言动作引入具身认知。由 LLM 驱动的代表性工作包括 SayCan [22],其 i) 提供了一个现实世界中预训练的自然语言动作库,以约束 LLM 避免提出不可行和上下文不合适的动作;ii) 使用 LLM 将自然语言指令转换为自然语言动作序列; iii) 利用价值函数验证自然语言动作序列在特定物理环境中的可行性。这些研究表明,LLM 对于旨在执行自然语言表达的高级、时间扩展指令的机器人非常有用。然而,LLM 只是整个具身人工智能系统(如具身认知)的一部分,它受限于固定的自然语言动作库和特定的物理环境,使得 LLM 驱动的具身人工智能难以实现对新机器人和环境的自适应扩展。

多模态 LLM(MLLM)[23], [24] 和世界模型(WM)[25]–[27] 的最新突破开辟了具身人工智能研究的新前沿。MLLM 可以作用于整个具身人工智能系统,将高级多模态输入和低级运动动作序列桥接到端到端的具身应用中。语义推理 [28]–[30] 利用 MLLM 的跨模态理解能力来解读视觉、听觉或触觉输入中的语义,例如识别物体、推断空间关系、预测环境动态。同时,任务分解 [31]–[33] 利用 MLLM 的顺序逻辑将复杂目标分解为子任务,并根据传感器反馈动态调整规划。然而,MLLM 通常无法根据符合物理规律的动态情况进行预测 [34],并且对环境反馈的实时适应性较差 [35]。

另一方面,世界模型(WM) 通过构建内部表征 [36]–[40] 并对外部世界进行未来预测 [41]–[44],为具身人工智能赋能。这种由 WM 驱动的具身人工智能能够在动态环境中促进符合物理规律的具身交互。内部表征将丰富的感官输入压缩到结构化的潜空间中,捕捉物体的动态、物理定律和空间结构,并允许智体推理周围环境中“存在什么”以及“事物如何行为”。同时,未来预测模拟了符合物理定律的多个时间范围内序列动作的潜奖励,从而阻止了风险或低效的行为。然而,世界模型 (WM) 驱动的方法难以进行开放式语义推理 [45],并且缺乏在没有明确先验知识的情况下进行泛化任务分解 [26] 的能力。

基于上述进展,进一步本文提出对开发联合 MLLM-WM 驱动的具身人工智能架构必要性的见解,阐明其在实现物理世界中的复杂任务方面的深远意义。MLLM 支持上下文任务推理,但忽略物理约束,而 WM 擅长物理感知模拟,但缺乏高级语义。MLLM 和 WM 的结合可以将语义智能与扎实的物理交互联系起来。例如,EvoAgent [46] 设计了一个具有联合 MLLM-WM 驱动的具身人工智能架构的自主进化智体,它可以通过自我规划、自我反思和自我控制,自主地跨环境完成各种长期任务,而无需人工干预。设计由MLLM-WM联合驱动的具身 AI 架构将主导下一代具身系统,弥合专用 AI 智体与通用物理智能之间的差距。

本文总结具身 AI 的代表性应用,例如服务机器人、救援无人机、工业机器人等,展示了其在现实场景中的广泛适用性。还指出具身 AI 的潜在未来发展方向,包括但不限于自主具身 AI、具身 AI 硬件和群具身 AI 等。

如图所示,本文组织如下:

历史视角

具身人工智能的历史演变反映了从早期哲学基础到机器人技术突破以及学习驱动范式兴起的连续转变,而大语言模型(LLM)和世界模型(WM)的最新进展正推动着其向下一发展阶段的持续转变。

具身人工智能的理论根源可以追溯到1950年,当时图灵提出了智能与身体体验有着内在联系的根本性思想[47]。20世纪80年代,认知科学进一步形式化了这一观点。Lakoff 和 Johnson 强调,人类认知源于身体体验,而非脱离身体的符号计算[48],而 Harnad 的符号基础问题则强调将符号表征与感觉运动现实联系起来的必要性[49]。20世纪80年代末和90年代机器人技术的进步将这些思想付诸实践。布鲁克斯(Brooks)提出了包容架构[50], [51],通过基于感觉运动回路的分层反应模块来促进基于行为的控制。Cog 项目[52]通过构建具有发展性学习、模仿和社交互动能力的人形机器人,进一步推进了这一方向。近年来,学习驱动范式的成功推动了具身人工智能从机器人运动控制向自适应交互的转变[53]。特别是深度学习的发展使机器人能够学习从原始传感器数据到行动策略的复杂非线性映射,显著提升了导航和操作任务[54], [55]。

虽然具身人工智能取得了显著进展,但在动态、不确定的环境中实现自我反思智能仍然是一项关键挑战。LLM/MLLM[23], [24]和WM[25]–[27]方面的最新进展,已逐渐显示出克服这些挑战的潜力。

关键技术与组件

系统地回顾一下关键技术与组件的发展。

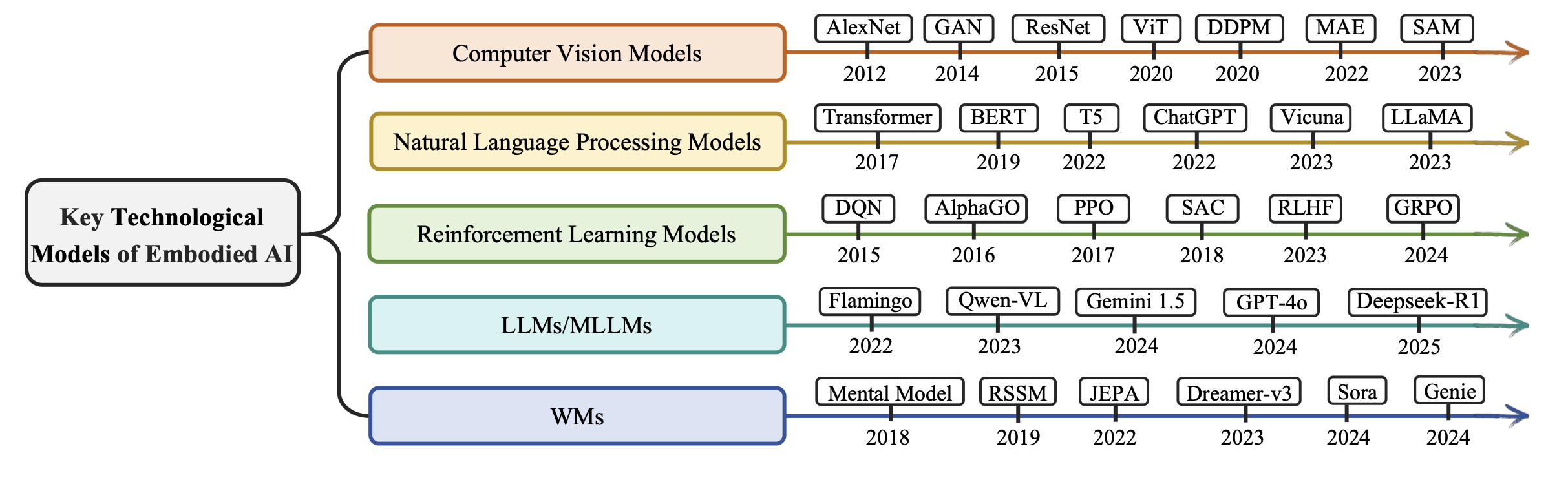

1)具身人工智能的关键技术:具身人工智能的快速发展与基础技术模型的进步密切相关,例如计算机视觉(CV)模型、自然语言处理(NLP)模型、强化学习(RL)模型、LLM/MLLM 和 WM(如图所示),这些模型可以显著增强智体的感知、认知和交互能力。具体而言,计算机视觉领域的经典模型,例如 AlexNet [56]、GAN [57]、ResNet [58]、ViT [59]、DDPM [60]、MAE [61] 和 SAM [62],为具身智能体在复杂环境中解读高维感官输入提供了感知基础。在自然语言处理 (NLP) 领域,从 Transformer [63]、BERT [64] 和 T5 [65] 等基础架构发展到 ChatGPT [66]、Vicuna [67] 和 LLaMA [68] 等大规模系统,赋予了具身智能体更强大的语言理解、任务规划和指令遵循能力。强化学习 (RL) 为智体提供了核心算法框架,使其能够通过与环境的交互进行学习。代表性方法包括 DQN [69]、AlphaGo [70]、PPO [71]、SAC [72]、RLHF [73] 和 GRPO [74]。

除了这些经典领域之外,具身人工智能 (embodied AI) 最有前景的方向之一是将 LLM/MLLM 与 WM 相结合。 LLM 和 MLLM(例如 Flamingo [20]、Qwen-VL [75]、Gemini-1.5 [76]、GPT-4o [77] 和 Deepseek-R1 [78])使智能体能够理解指令、推理多模态输入,并跨任务和环境进行泛化。相比之下,WM(例如 Mental Model [26]、RSSM [79]、JEPA [27]、Dreamer-v3 [80]、Sora [81] 和 Genie [36])使智体能够建模和预测环境动态,支持在动态和不确定环境中进行基于想象的规划和预期决策。

2)具身人工智能的关键组成部分:在这些关键技术的推动下,具身人工智能取得了快速发展。主要是如下三个关键组成部分。

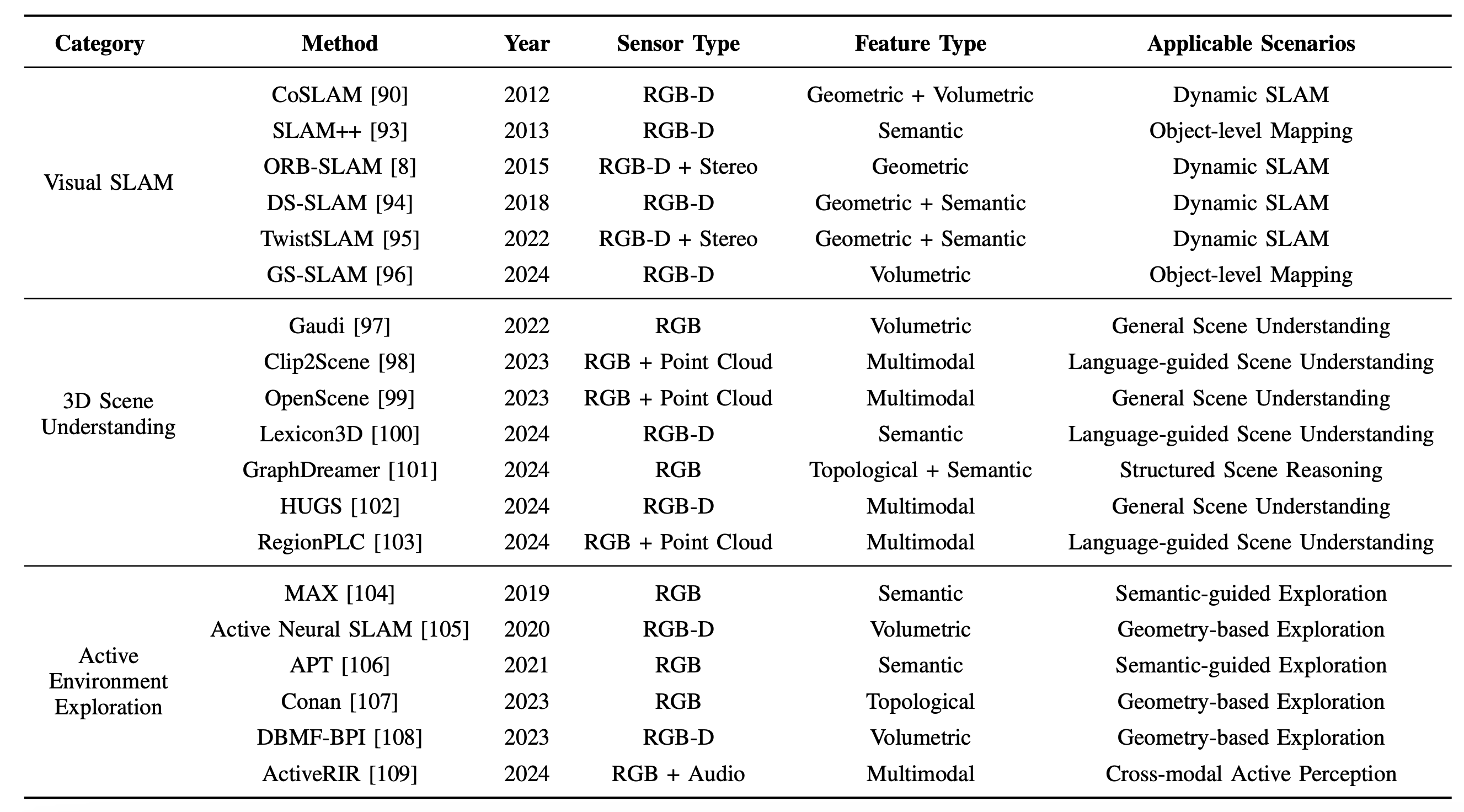

a) 主动感知:主动感知是指智体选择性地从环境观测中获取信息[16]、[82]、[83]。现有的主动感知方法大致可分为三类:视觉 SLAM、3D 场景理解和主动环境探索。为了有效地理解主动感知方法,如表所示,从传感器类型、特征类型和适用场景三个实际维度分析代表性方法。

视觉 SLAM。同步定位与地图构建 (SLAM) 是一项关键技术,它使智体能够在未知环境中定位自身并构建环境地图 [9], [84]。作为主动感知的基础技术,视觉 SLAM 得到了广泛的研究 [85], [86]。据 Wang [87] 的研究,现有方法分为基于几何和基于语义的两类。几何方法利用空间或时间线索 [8],例如密集场景流 [88], [89]、三角测量一致性 [90] 和图结构 [91], [92],在静态设置中表现良好,但在动态场景中表现不佳。相反,语义方法通过利用高级信息来改进动态环境中的定位和地图构建。早期的代表性方法包括集成目标级语义的 SLAM++ [93] 和将深度学习应用于动态场景理解的 DS-SLAM [94]。近期的模型,例如 TwistSLAM [95] 和 GS-SLAM [96],通过将几何优化与语义或生成建模相结合,进一步增强了鲁棒性。

3D 场景理解。场景理解致力于使智体能够以结构化和语义上有意义的方式感知、分割和推理复杂环境。近期的研究通过整合视觉语言模型和生成先验知识推动了这一领域的发展。早期的研究成果,例如 Gaudi [97],引入用于 3D 感知场景合成的生成模型。Clip2Scene [98] 和 OpenScene [99] 利用视觉-语言嵌入来促进标签高效和开放词汇的 3D 理解。Lexicon3D [100] 和 GraphDreamer [101] 进一步增强了结构化场景理解,它们通过结构化表示(例如场景图或语义词典)对 3D 空间中的目标级关系进行建模。同时,以 HUGS [102] 和 RegionPLC [103] 为代表的区域级多模态基础技术,结合提示和空间基础,实现了细粒度、目标条件化的三维感知。这些方法促进了整体的、与语言一致的三维理解。

主动环境探索。主动探索侧重于使智体能够通过与环境的交互自主获取信息观测。早期方法依赖于构建显式或隐式的环境模型。基于模型的代表性方法包括 MAX [104] 和主动神经 SLAM [105],它们利用预测建模和地图构建来支持在未知空间中的高效导航。相比之下,APT [106] 和 DBMF-BPI [108] 则侧重于通过直接与环境交互进行无模型探索,以减少对显式建模的依赖。近期的研究通过结合多模态感知 [109] 和语义推理 [107] 进一步增强了探索能力。

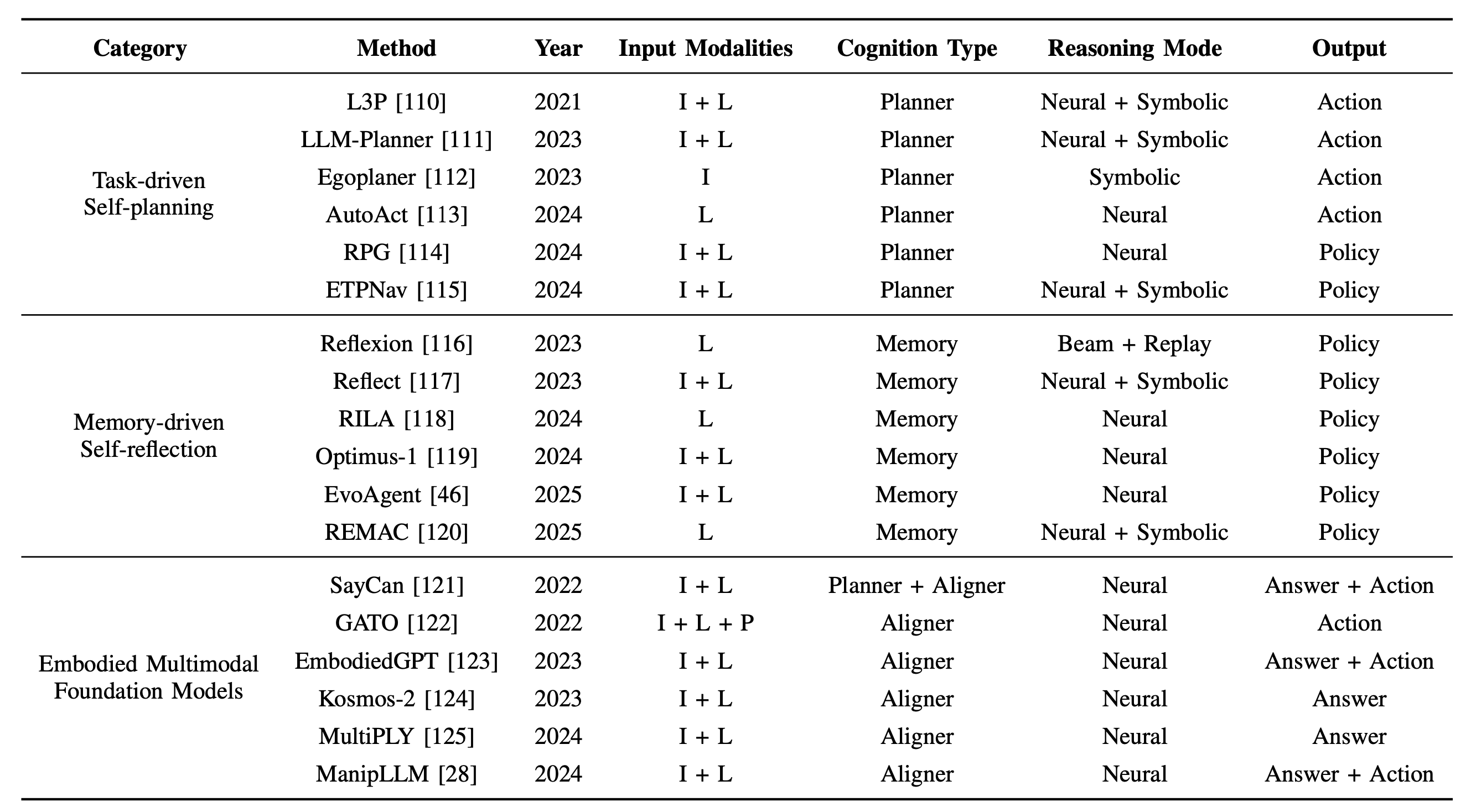

b) 具身认知:具身认知是指在交互过程中,智体对其感知和累积经验的自我反思所驱动的内部表征和推理能力 [147]– [149]。这一组件构成了具身人工智能的核心,使智体能够执行任务规划[150]、因果推理[151]和长远推理[152],[153]。近期具身认知的研究主要集中在三个方面:任务驱动的自我规划、记忆驱动的自我反思和具身多模态基础模型。下表从输入模态、认知类型、推理模式和输出类型四个角度分析代表性方法。这些维度反映具身智能体如何感知信息、形成内部模型并进行推理。

任务驱动的自我规划。在任务驱动的自我规划中,智体基于任务目标、环境背景和内部知识自主生成结构化规划,无需明确的人类指令[154]–[156]。结构化学习是一种经典的解决方案,它开发潜规划空间或直接策略映射,在训练分布内实现高效,但对分布外场景缺乏鲁棒性。代表性方法包括 L3P [110]、Egoplaner [112] 和 ETPNav [115]。最近的进展将 LLM 或生成模型融入到自规划中。LLM-Planner [111] 和 AutoAct [113] 通过将语言引导推理应用于各种任务,将 LLM 集成到规划中;而 RPG [114] 则提供了生成视角,旨在通过多模态推理统一规划和内容创建。

记忆驱动的自我反思。记忆驱动的自我反思使智体能够利用过去的经验进行长远推理、纠错和自我提升 [46], [157]。早期研究侧重于记忆处理,包括固定大小的重放缓冲区[158]–[160]和可微分记忆架构[161], [162]。最近的进展引入反思机制,即智体总结或口头表达过去的经验,以指导未来的决策。Reflexion[116]和Reflect[117]通过将口头反馈整合到行动规划中,使智能体能够迭代地自我修正,而RILA[118]将反思推理扩展到多模态语义导航。除了个体反思之外,Optimus-1[119]和REMAC[120]还集成多模态或多智体记忆,以支持长远协作。EvoAgent[46]通过将连续世界建模与记忆驱动的规划器相结合,进一步推进这一方向,实现了跨顺序任务的完全自主演化。

具身多模态基础模型。在MLLM时代,具身多模态基础模型[163]– [165]已成为统一规划、推理和其他具身认知能力的最有前景的解决方案之一。最近的进展由数据构建和模型开发共同推动。数据工作侧重于构建高质量的基准测试集,以支持可扩展且具有认知意义的评估,例如MuEP [166]、ECBench [167]、MFE-ETP [168]和EmbodiedBench [18]。在模型方面,近期的进展包括:基于 affordance 的智体(例如 SayCan [121] 和 GATO [122]),它们将语言理解与具身动作空间相结合;视觉-语言预训练方法(例如 EmbodiedGPT [123] 和 Kosmos-2 [124]),它们促进了可扩展的具身推理;以及以目标为中心的设计(例如 MultiPLY [125] 和 ManipLLM [28]),它们增强了操作和交互能力。这些模型共同致力于构建可迁移且可泛化的具身人工智能。

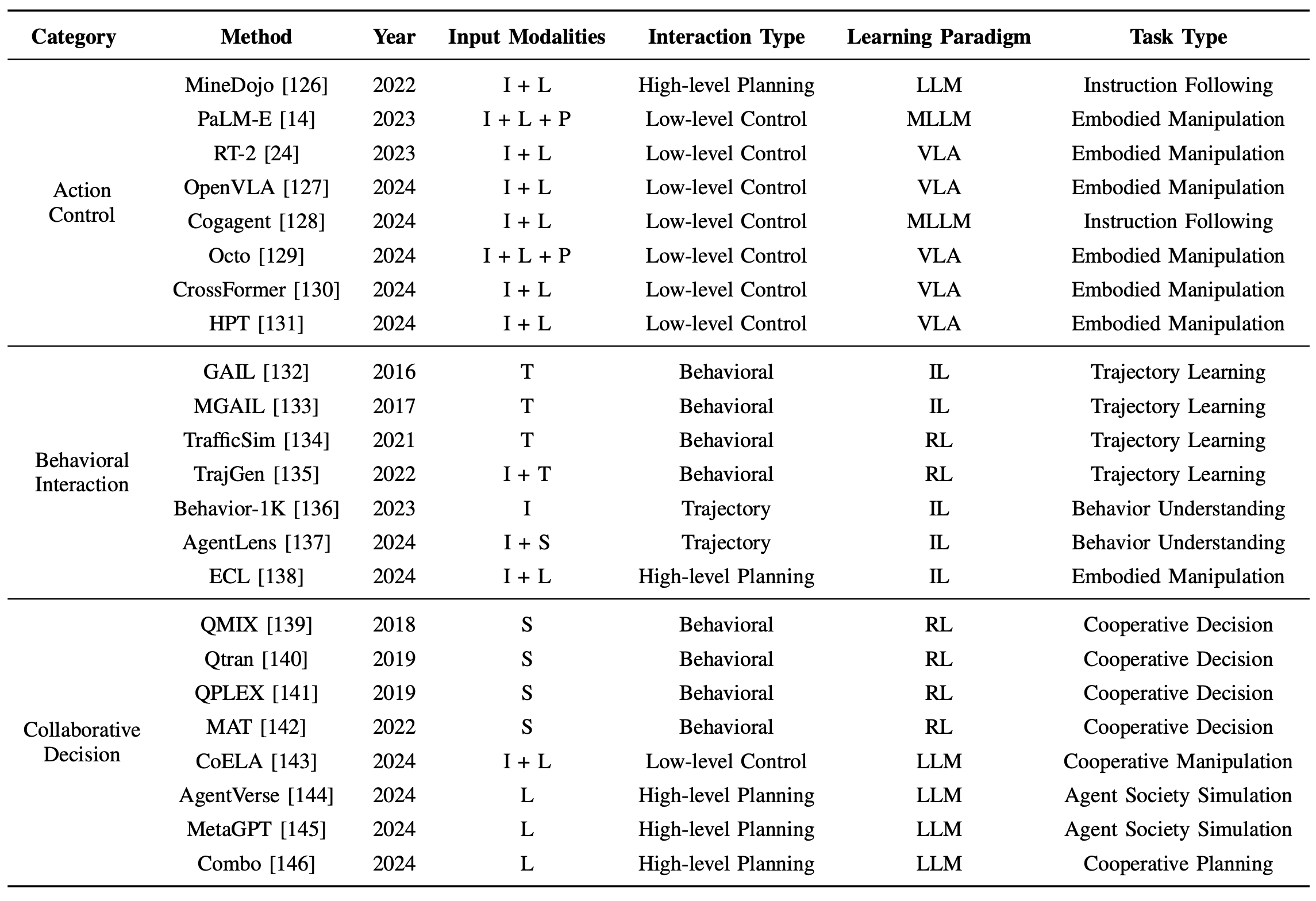

c) 动态交互:动态交互是指智体基于其感知和认知,通过动作或行为来影响环境的过程[169], [170]。现有研究强调了这种能力的重要性,它不仅使智体能够响应环境,还能改变其周围环境[171], [172]。动态交互的研究涵盖动作控制、行为交互和协作决策。为了更好地理解现有方法,从输入模态、交互类型、学习范式和任务类型四个角度分析代表性方法,如表所示。这些维度反映智体如何感知环境、确定交互的级别和结构,以及如何在动态多智体或人在环场景中生成适当的行为。

动作控制。动作控制为具身交互生成运动指令。早期的方法基于具有动态系统建模的控制理论[173], [174]或通过反复试验的强化学习[175], [176]。前者适用于结构化或重复性任务,而后者适用于高维非线性问题。最近的进展主要集中在三个方向。视觉-语言-动作 (VLA) 模型,例如 PaLM-E [14]、RT-2 [24]、OpenVLA [127] 和 CogAgent [128],集成语言引导的推理以实现灵活的控制,Ma [177] 对其进行全面的综述。像 MineDojo [126] 这样的开放式框架促进从开放世界知识中持续获取技能。此外,跨具身学习,包括 CrossFormer [130]、HPT [131] 和 Octo [129],旨在统一不同机器人和模态之间的策略学习。

行为交互。智体的行为由一系列动作组成。与动作控制相比,它强调通过有意义的动作模式进行高级控制,使智体能够以灵活且目标导向的方式进行交互。最近的进展主要集中在两个方向。模仿学习,包括 GAIL [132]、MGAIL [133]、TrafficSim [134] 和 TrajGen [135],能够高效地获取和模拟复杂行为。BEHAVIOR-1K [136] 提供了一个大规模基准,用于评估 1000 个具身任务中的行为泛化能力。行为感知增强方法,例如 AgentLens [137] 和 ECL [138],提高策略的鲁棒性和可解释性。尽管取得这些进展,但在稀疏反馈下实现可靠的长视界行为交互仍然具有挑战性。

协作决策。协作决策侧重于协调多个智体以实现共同目标,这对于多智体系统和人机协作至关重要 [178]–[180]。多智体强化学习是一种经典的解决方案,QTRAN [140]、QPLEX [141] 和 Qatten [139] 等方法通过集中训练和分散执行来解决协作问题。MAT [142] 将 MARL 重新定义为序列建模问题,以缓解多智体强化学习中的可扩展性限制。最近的进展是将 LLM 和 WM 结合起来,以增强多智体协作。MetaGPT [145]、CoELA [143] 和 AgentVerse [144] 利用 LLM 进行任务推理和协调,而 COMBO [146] 则组合模块化 WM 来支持可扩展的协作具体化决策。

硬件

随着具身人工智能的发展,模型复杂度和规模不断增长,计算和能耗需求也随之增加。具身系统通常运行在动态的现实环境中,面临着严格的延迟和功耗限制,尤其是在边缘计算领域。因此,开发在保持性能的同时优化效率的硬件友好型方向,对于实现响应迅速、能耗感知的具身智体至关重要。具身人工智能的硬件优化通常包括四个部分:硬件-觉察模型压缩、编译器级优化、域特定加速器以及软硬件协同设计。

-

硬件-觉察模型压缩:量化和剪枝 [4] 是减小模型大小和计算成本的关键技术。对于通常在低功耗嵌入式硬件上运行的具身智体来说,这些技术对于实现快速高效的推理至关重要。量化 [181] 将权重和激活映射到更低的位宽,而剪枝 [182] 则去除冗余参数。为了支持现实世界中的具身任务,例如机器人控制或视觉导航,诸如功耗、性能和面积 (PPA) 之类的硬件效率指标可以指导位宽分配或修剪比率 [183],从而能够在特定任务上权衡准确性和物理平台上的可部署性。

-

编译器级优化:编译器连接高级具身 AI 模型和硬件执行。在实时具身系统中,编译器工具链对于高效处理传感器数据和决策至关重要。基于 LLVM [184] 和 CUDA 构建的 TVM [5] 可跨平台生成优化代码。这些编译器通过运算符融合和冗余计算消除 [185] 来转换计算图,从而实现响应式行为。诸如循环重排序和平铺之类的映射策略增强了数据局部性、并行性和内存访问 [186],所有这些对于维持具身智体的低延迟推理都至关重要。

3)域特定加速器:随着计算需求的不断增长,域特定加速器(DSA)成为具身人工智能(embodied AI)的一个有前景的解决方案。从机器人到AR/VR智体,这些系统受益于专为频繁操作量身定制的快速、节能硬件。谷歌的TPU [6]通常通过PCIe与CPU和GPU集成,可加速矩阵乘法等关键运算。基于FPGA的加速器[187]允许重新配置,以适应新任务或不断变化的工作负载;CGRA 加速器[188]改进感知或控制中常见的结构化、数据流密集型计算。同时,基于ASIC的加速器[189]提供高吞吐量和高能效,非常适合在现实环境中部署高性能具身模型。

4)软硬件协同设计:分离算法和硬件设计会降低运行效率。软硬件协同设计通过算法系统和算法硬件协同优化来解决这个问题。算法系统协同优化,侧重于如何充分利用张量核和 CUDA 核等 GPU 资源来更好地支持算法[190]。算法硬件协同优化,旨在通过调整模型和硬件架构来提高部署效率。例如,可以根据网络中的算子类型和硬件的配置参数进行多目标优化[191]。还可以设计不同的数值量化方案以及匹配的硬件加速器,以更好地支持具身人工智能任务[192]。

基准测试和评估指标

标准化的基准测试和评估指标对于客观评估具身人工智能系统的性能至关重要。广泛采用的测试平台包括 Habitat [193],它为导航和交互任务提供逼真的 3D 室内环境;以及 ManiSkill [194],它提供基于物理的操作场景和多样化的目标集。像 MuJoCo [195] 这样的仿真平台能够在连续状态空间中实现精确的控制评估,而 EmbodiedBench [18] 则支持对视觉驱动智体在感知、认知和交互方面的全面评估。对于无人机应用,AirSim [196]、U2UData [197] 和 U2USim [198] 提供了具有动态障碍物的高保真空中环境。这些测试平台的复杂程度各不相同:Habitat 擅长视觉真实感,ManiSkill 擅长目标多样性,MuJoCo 擅长物理准确性,EmbodiedBench 擅长多模态集成。像 BEHAVIOR-1K [136] 这样的领域特定基准测试集,能够进一步在现实约束条件下对 1000 种日常活动进行精细评估。

关键评估指标涵盖三个关键维度:任务成功率衡量目标导向型任务(例如,目标操作或导航)的完成准确性 [24];实时响应能力量化决策延迟和对环境变化的适应速度 [199];能效率评估部署期间的计算成本(FLOPS)和功耗(瓦特)[4]。其他指标包括路径长度(用于评估导航效率)[105]、泛化得分(用于评估未知场景)[200] 以及安全违规(用于评估物理合规性)[171]。对于多智体系统,协调效率 [178] 和通信开销 [201] 提供关键见解。像 MFE-ETP [168] 这样的标准化评估协议确保跨模态比较的公平性,尽管在模拟-到-现实的迁移验证中仍然存在挑战 [177]。

从单模态到多模态

具身人工智能的发展已经从单模态系统演变为多模态系统,如图所示。最初,具身人工智能主要关注视觉、语言或动作等个体模态,其中感知、认知和交互由单一感官输入驱动 [7], [8]。随着该领域的成熟,单模态具身人工智能的局限性逐渐显现,并且出现了向整合多种感官模态的重大转变 [14]– [16]。多模态具身人工智能现在被视为创建更具适应性、灵活性和鲁棒性智体的关键,这些智体能够在动态环境中执行复杂任务 [17], [18]。

单模态具身人工智能受益于计算机视觉、自然语言处理和强化学习等基础领域的快速发展 [12], [13]。这些单模态方法擅长处理具身人工智能中的特定模块。例如,计算机视觉技术推动了主动感知模块中视觉 SLAM 和 3D 场景理解的进步 [9]。自然语言处理技术,尤其是 LLM,已成为解决具身认知模块中任务规划和长远推理的流行解决方案 [10], [11]。尽管单模态具身人工智能在独立模块中表现良好,但它始终面临两个固有的局限性。一方面,单一模态中包含的信息有限,阻碍了感知、认知和交互的性能。例如,纯视觉系统难以理解动态或模糊环境中的环境,而基于听觉的系统在现实世界噪声和信号处理方面面临挑战 [17], [202]。另一方面,多样化和异构化的模态阻碍了模块间的信息传递和共享。智体对环境的感知未能促进其认知的形成,而认知的演化也未能促进其与环境的交互。

相比之下,多模态具身人工智能已成为一种更有前景的范式 [18]。通过整合来自多种感知模态(例如视觉、听觉和嗅觉反馈)的数据,这些方法可以提供对环境更全面、更精确的理解。更重要的是,多模态具身人工智能可以促进感知、认知和交互之间更深层次的整合。多模态大语言模型 (MLLM) 和世界模型 (WM) 的最新进展使智体能够更有效地处理多模态,有望提升具身人工智能的能力 [44]、[81]、[203]。这些模型的整合被认为是在动态、不确定环境中实现多模态具身人工智能的关键一步。

。。。。。待续。。。。。。

更多推荐

已为社区贡献14条内容

已为社区贡献14条内容

所有评论(0)