【强烈推荐收藏】LLM微调技术全解析:从零开始学大模型微调,程序员必备指南

【强烈推荐收藏】LLM微调技术全解析:从零开始学大模型微调,程序员必备指南

本文全面解析了LLM微调技术,涵盖预训练、微调和RLHF三大核心概念及逻辑关系。重点介绍了参数高效微调(PEFT)技术,包括LoRA等方法,解决了全参数微调的资源消耗高、易发生灾难性遗忘等问题。详细讲解了微调实践流程、参数选择策略、效果评估方法及常见技术陷阱,并展望了多模态微调等未来趋势,为程序员提供从理论到实践的完整指南。

一、基础概念层

核心术语定义

预训练

目标:使模型学习通用语言规律与知识,构建基础语言理解与生成能力。

关键特征:基于海量无标注文本数据(如书籍、网页、文章等)进行训练,过程中对模型所有参数进行更新,以捕捉语言的语法结构、语义关系及世界知识。

典型案例:GPT-3 模型通过对包含数千亿tokens的无标注文本进行预训练,学习通用语言模式,为后续微调任务奠定基础。

微调

目标:将预训练模型适配特定下游任务(如文本分类、问答、翻译等),提升模型在目标场景下的性能。

关键特征:使用小样本有标注数据进行训练,根据参数更新范围可分为两类:

- 全参数微调:更新模型所有参数(如 GPT-3 的 175B 参数),需极高计算资源;

- 参数高效微调(PEFT):仅更新部分参数(如 LoRA 通过低秩矩阵分解更新注意力层参数),可降低显存需求 90% 以上,典型方法包括 LoRA、QLoRA 等[1]。

典型案例:采用 LoRA 技术微调医疗领域预训练模型,通过更新低秩矩阵参数,使模型适配专业医疗问答任务,在减少计算成本的同时保持高精度。

RLHF(基于人类反馈的强化学习)

目标:对齐模型输出与人类偏好(如安全性、有用性、无害性),优化生成内容质量。

关键特征:通过三步实现:首先让标注人员对模型输出排序以构建偏好数据,训练奖励模型(RM);再使用强化学习(如 PPO 算法)基于奖励模型反馈优化策略模型,最终生成符合人类价值观的内容。

典型案例:ChatGPT 采用 RLHF 流程,通过人类标注的对话偏好数据训练奖励模型,再通过强化学习调整模型参数,显著提升了对话的连贯性、安全性和用户满意度。

术语体系关系:预训练为基础(通用能力)→ 微调为适配(任务专精)→ RLHF 为优化(偏好对齐),三者共同构成 LLM 从基础模型到产品级应用的技术链条。

类比解释与区别梳理

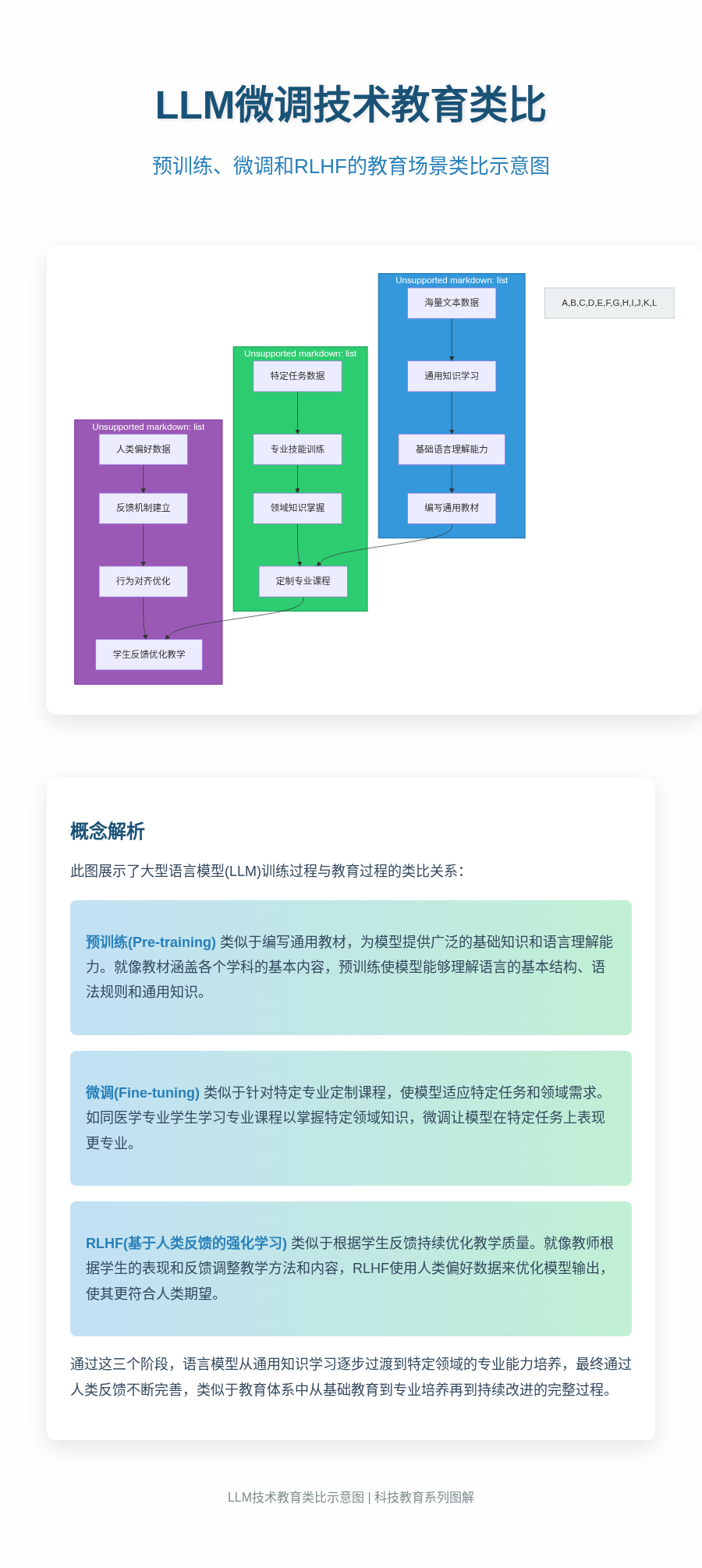

为直观理解大模型训练流程中各阶段的核心作用及技术差异,可通过“教育场景+工业场景”双类比体系构建认知框架,同时对比全参数微调和参数高效微调(PEFT)的关键特性。

双场景类比体系:从通用性到优化性的递进

教育场景类比将模型训练过程映射为教学活动的完整链条:预训练阶段对应“编写涵盖各学科基础知识的通用教材”,旨在构建全面的知识体系;微调过程可类比为“教师根据专业方向调整教材章节比重与案例选择”,通过针对性适配实现知识向特定任务的迁移;RLHF(基于人类反馈的强化学习)则对应“根据学生课堂反馈动态优化教学节奏与重点内容”,通过持续交互提升教学效果的精准性[2]。三者呈现“通用知识覆盖→专业任务适配→动态反馈优化”的递进关系,共同构成从基础能力到场景化效能的提升路径。

工业场景类比从生产视角诠释技术逻辑:预训练相当于“制造具备基础功能的通用机器”,奠定核心性能基础;微调对应“为机器更换特定工具头以适配细分工序”,通过局部改造实现专用化生产;RLHF则类似“根据质检反馈调整工具头精度参数”,通过闭环反馈机制优化产出质量。这一过程体现“通用设备制造→专用工具适配→精度动态校准”的工业优化逻辑,与教育场景类比共同揭示模型训练“通用性→专用性→优化性”的内在进阶规律。

LLM微调示意图

全参数微调和PEFT的核心差异

在微调技术选型中,全参数微调和PEFT代表两种截然不同的优化策略,其核心差异体现在资源消耗与任务适配效率上:

- • 全参数微调需对模型所有参数进行更新,相当于“重新编写整本教材的每个章节”或“更换机器的全部核心部件”,虽能最大化任务适配效果,但资源消耗显著——通常需要数十GB甚至上百GB显存支持,且训练时间长、计算成本高[2]]。

- • PEFT技术仅更新模型部分参数(如LoRA聚焦低秩矩阵参数、Prefix Tuning优化输入前缀向量),类似“仅修订教材的重点章节”或“更换机器的特定工具头而非整机”,可将显存需求降低50%以上,同时加速任务适配速度,在保持相近性能的前提下实现轻量化部署。

核心差异总结:全参数微调追求“全面优化”但成本高昂,适用于高性能计算环境下的核心任务;PEFT以“部分参数更新”实现效率突破,更适配资源受限场景的快速任务迭代。

通过双场景类比与技术特性对比可见,大模型训练流程的各阶段既存在逻辑递进关系,又在技术实现层面形成资源消耗与任务效率的权衡空间,而PEFT技术的出现正是对这一权衡关系的关键优化。

术语间的逻辑关系

大型语言模型(LLM)的训练过程是一个知识传递与能力进化的递进式系统工程,其核心逻辑可通过“三阶训练流程”清晰呈现。这三个阶段并非孤立存在,而是通过参数继承与数据反馈形成有机整体,共同决定模型的最终性能。

三阶训练流程的逻辑架构

三阶训练流程以数据流向和参数传递为主线,构建了从基础能力到任务适配再到价值对齐的完整链路:

- 左侧:预训练阶段

输入海量无标注文本(如书籍、网页、论文等),通过自监督学习(如掩码语言建模、下一句预测)训练出基础模型。此阶段使模型掌握语言结构、世界知识和通用推理能力,形成可迁移的“知识基座”。 - 中间:微调阶段

以预训练模型为起点,输入特定任务的标注数据(如分类、问答、翻译等),通过参数微调使模型继承预训练知识并注入任务特性。此时模型参数在预训练基础上发生定向更新,形成针对特定场景的“任务适配模型”。 - 右侧:RLHF阶段

基于微调后的任务模型,输入人类偏好数据(如对模型输出的排序、评分),通过强化学习(如PPO算法)优化模型的生成风格、安全性和人类对齐度。此阶段不改变模型的核心能力,而是在现有任务性能基础上进行“价值观校准”。

LLM微调关系图

三个阶段通过参数传递箭头紧密连接:预训练模型的参数作为微调阶段的初始值,微调后的参数又成为RLHF阶段的优化起点,形成“基础能力→任务适配→价值对齐”的递进关系。

伪代码示例:三阶段输入输出关系

以下伪代码以简洁形式展示三个阶段的核心逻辑:

# 1. 预训练:构建基础模型

text_corpus = load_海量文本数据() # 如维基百科、书籍语料库

base_model = pretrain(

dataset=text_corpus,

objective="自监督学习",

epochs=1000

) # 输出包含通用知识的基础模型

# 2. 微调:注入任务特性

task_data = load_任务标注数据() # 如医疗问答数据集、法律文书分类数据

task_model = fine_tune(

model=base_model, # 继承预训练模型参数

dataset=task_data,

learning_rate=1e-5, # 较小学习率保护预训练知识

task_type="问答"

) # 输出适配特定任务的模型

# 3. RLHF:优化人类对齐度

human_feedback = load_人类偏好数据() # 如模型输出的排序结果、安全评分

rlhf_model = rlhf(

model=task_model, # 基于微调模型继续优化

feedback_data=human_feedback,

algorithm="PPO"

) # 输出对齐人类价值观的最终模型

核心逻辑总结:

预训练阶段奠定模型的“认知基础”,微调阶段实现“专业技能”的定向培养,RLHF阶段完成“行为规范”的校准。三者通过参数继承形成闭环,既保留底层能力,又实现上层适配,最终构建出兼具通用性、任务性和安全性的大型语言模型。

这一流程体现了LLM训练的模块化设计思想:每个阶段专注解决特定问题(知识获取→任务适配→价值对齐),通过参数传递实现能力的累积与优化,为模型性能的可控提升提供了清晰路径。

二、技术演进史

全参数微调的局限性

全参数微调作为最直接的模型适配方法,在实际应用中面临着资源消耗高昂、任务适配条件苛刻及泛化能力退化三大核心挑战,这些局限性在大模型参数量持续突破的背景下尤为突出。

一、资源消耗:硬件门槛与经济成本的双重压力

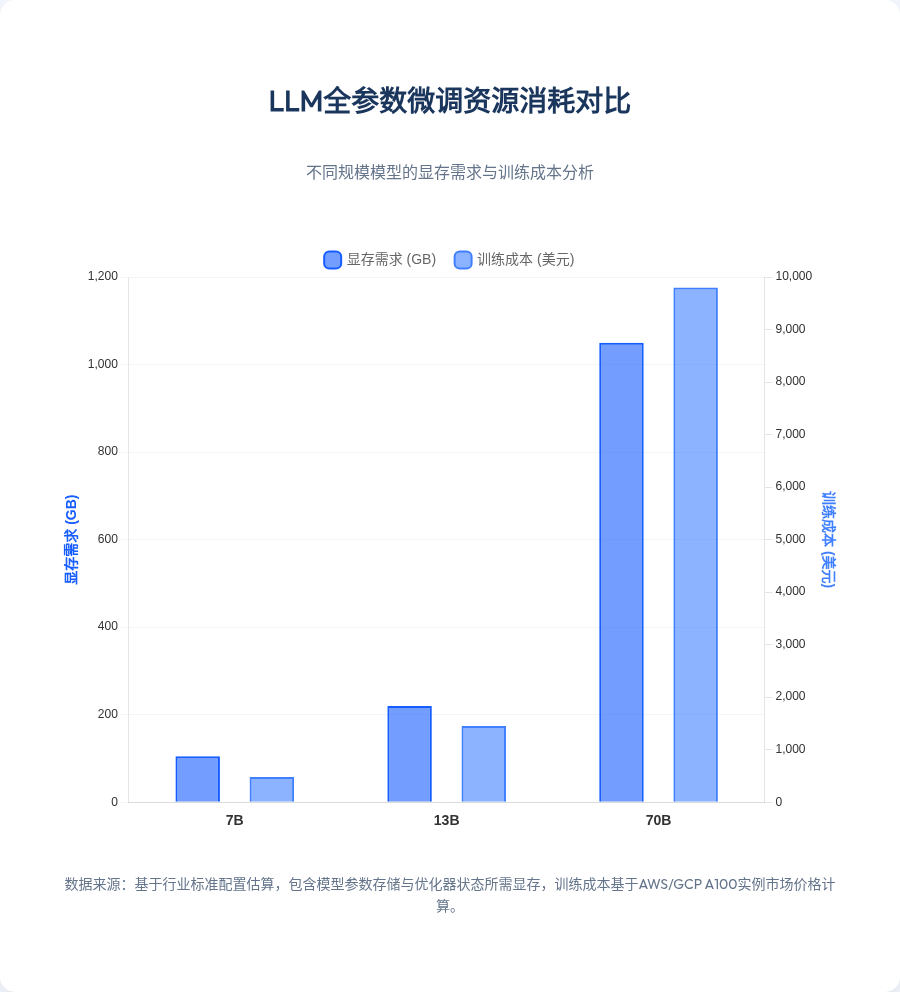

全参数微调需更新模型所有参数(如 GPT-3 的 175B 参数),导致其对计算资源的需求呈指数级增长。以主流开源模型为例,不同参数量级的模型在微调过程中表现出显著的资源差异:

| 模型参数量 | 显存需求 | 单轮训练成本 | 典型硬件配置要求 |

|---|---|---|---|

| 7B | 约 40 GB | 数千元级 | 单张 A100 (80 GB) |

| 13B | 约 80 GB | 万元级 | 2 张 A100 或单张 H100 |

| 70B | 400 GB+ | 超 10 万元 | 8 张 A100 (80 GB) 集群 |

LLM微调图表

这种资源消耗在模型参数量爆炸后变得难以承受。例如,Llama3-70B 等超大模型的微调需依赖多卡集群,而 A100 单卡月租超万元,使得中小团队难以承担硬件成本。即使对于企业级用户,70B 模型单轮训练超 10 万元的成本也显著限制了迭代效率。

二、任务适配性:对标注数据规模的强依赖

全参数微调的性能高度依赖标注数据量,在小数据集上易引发过拟合风险。实验表明,13B 规模的模型需至少 10 万条高质量标注数据 才能在微调中保持参数空间的稳定性,避免模型过度学习训练数据中的噪声[4]。对于垂直领域(如医疗、法律),获取此类规模的标注数据往往需要极高的人力成本(每条标注成本可达数元至数十元),且数据质量难以保证。当数据量不足时,模型可能出现“记忆式学习”,在测试集上表现优异但在真实场景中泛化能力极差。

三、泛化能力退化:灾难性遗忘与知识覆盖失衡

全参数微调通过全局参数更新适配特定任务时,可能导致模型对原始通用知识的覆盖失衡,即“灾难性遗忘”现象。某金融领域微调案例显示,在使用行业报告数据微调 13B 模型后,模型对金融任务的准确率提升 15%,但对非任务领域(如历史、科技)知识的召回率下降 30%,甚至出现基础常识性错误[4]。这种知识遗忘源于微调过程中通用特征被任务特异性特征覆盖,尤其当任务数据与预训练数据分布差异较大时,模型倾向于牺牲全局知识以优化局部任务表现。

技术实现的简洁性与代价

尽管全参数微调的原理直观,其 PyTorch 实现框架也相对简单,核心逻辑仅需启用训练模式并迭代更新参数:

model.train() # 启用训练模式,激活 dropout 等正则化机制

for epoch in range(num_epochs):

for batch in dataloader:

inputs, labels = batch

outputs = model(inputs)

loss = loss_fn(outputs, labels)

optimizer.zero_grad() # 清空梯度缓存

loss.backward() # 反向传播计算梯度

optimizer.step() # 更新所有模型参数

但这种“简洁性”背后隐藏着高昂的隐性成本——上述代码在 70B 模型上运行时,即使采用混合精度训练,仍需 400GB+ 显存支持,且单轮训练耗时超 24 小时。

核心局限总结:全参数微调通过更新所有参数实现任务适配,但其 硬件成本随参数量呈超线性增长、对标注数据规模有刚性需求,且易引发 灾难性遗忘,这些问题在参数量突破 70B 后尤为突出,推动了参数高效微调技术的快速发展。

PEFT技术的兴起与动因

PEFT(参数高效微调)技术的兴起本质上是对大模型全参数微调固有局限的系统性突破。2020年后,以GPT - 3(175B参数)和PaLM - 2(540B参数)为代表的基础模型参数量呈指数级增长,这种爆炸式增长直接带来了硬件门槛的显著提升。例如Llama3 - 70B等超大模型的全参数微调,往往需要多卡A100集群支持,单月硬件成本超10万元,这对中小企业及研究机构形成了难以逾越的资源壁垒。

全参数微调的另一核心痛点在于过拟合风险与模型遗忘问题。在小数据集场景下,对预训练模型所有参数进行更新容易导致灾难性遗忘——即模型在适配下游任务时丢失原有通用知识,同时对有限数据产生过拟合。这种现象在医疗、法律等专业领域尤为突出,这些领域往往受限于数据隐私或样本稀缺性,难以获取大规模标注数据。

面对这些挑战,PEFT技术通过参数隔离机制实现了革命性突破:冻结预训练模型的大部分参数,仅针对任务相关的少量参数进行更新。这种设计既保留了预训练模型的通用知识,又显著降低了计算资源需求,同时通过精准定位任务相关参数提升了适配性。

PEFT技术核心价值:通过"冻结主体参数+更新任务专属参数"的范式,在大幅降低硬件成本的同时(通常仅需更新0.1% - 2%的参数),维持与全参数微调相当的任务性能。

行业实践充分验证了PEFT的商业价值。某创业公司采用LoRA(Low - Rank Adaptation)技术微调Llama3 - 8B模型时,硬件配置从A100集群(月租10万元)降至单张RTX 4090(月租500元),成本降低99.5%,而任务准确率仍达到全参数微调水平的92%)。这种"低成本 - 高性能"的平衡能力,使得PEFT成为大模型工业化落地的关键技术支撑。其核心原理在于像LoRA这样的PEFT方法仅更新注意力层中的低秩矩阵,通过少量参数调整即可实现模型在特定任务上的快速适配,从根本上改变了大模型微调的资源经济学。

关键技术演进节点

参数高效微调(PEFT)技术的发展历程呈现出清晰的迭代脉络,其核心目标始终围绕降低训练成本与提升部署效率。以下按技术突破的时间线梳理关键演进节点,揭示各阶段创新如何推动LLM微调从学术探索走向工业实践。

LLM微调时间线

2021年:Adapter——模块化微调的开创者

2021年提出的Adapter方法首次引入“插入瓶颈层”的创新思想,通过在预训练模型的Transformer层间插入小型神经网络模块(通常包含降维-非线性变换-升维的瓶颈结构),实现仅更新少量新增参数即可适配下游任务的目标。这一设计开创了模块化微调范式,使模型在保留预训练知识的同时具备任务特异性调整能力。

核心创新:通过在Transformer层间插入“瓶颈层”(如将768维隐藏状态通过128维中间层进行变换),将可训练参数占比压缩至原模型的1%-3%,显著降低过拟合风险。

然而,Adapter的串联式结构导致推理时需额外计算模块,实测推理延迟增加约15%,这一缺陷限制了其在实时性要求高的场景中的应用[5]。

2022年:LoRA——低秩分解的效率革命

2022年,LoRA(Low-Rank Adaptation)技术通过低秩矩阵分解重构参数更新方式,彻底改变了PEFT的技术路径。其核心原理是将权重更新量ΔW分解为两个低秩矩阵的乘积(ΔW = BA,其中B∈Rd×r,A∈Rr×k,r≪min(d,k)),使得预训练权重W0保持冻结,仅需优化低秩矩阵B和A。

技术突破:通过低秩分解将参数更新量的维度从O(dk)降至O(dr + rk)(r通常取8-64),在7B模型上实现训练速度提升3倍,同时消除Adapter的推理延迟问题,成为工业界主流微调方案[5]。

LoRA的优势在于其即插即用性:训练完成后可将BA与W0合并为W = W0 + BA,推理时无需额外计算图,与原生模型效率一致。这一特性使其迅速被Hugging Face PEFT等框架采纳,推动了LLM微调的工程化落地。

2023年:QLoRA——量化技术的平民化赋能

2023年,QLoRA(Quantized LoRA)通过4-bit量化存储与LoRA的结合,进一步突破硬件门槛。该技术采用NF4(Normalized Float 4)量化格式对预训练模型权重进行压缩,同时通过双重量化(Double Quantization)和分页优化(Paged Optimizers)减少显存碎片,使7B模型的微调显存需求从传统全参数微调的上百GB降至仅8GB。

实践价值:消费级GPU(如单张RTX 3090/4090)首次具备微调7B模型的能力,将微调硬件成本降低90%以上,推动PEFT技术从企业级应用向个人开发者普及[5]。

QLoRA的量化策略在精度损失小于1%的前提下,实现了显存效率的跨越式提升,其开源实现被迅速集成到LLaMA-Factory等主流框架中,成为中小规模模型微调的首选方案。

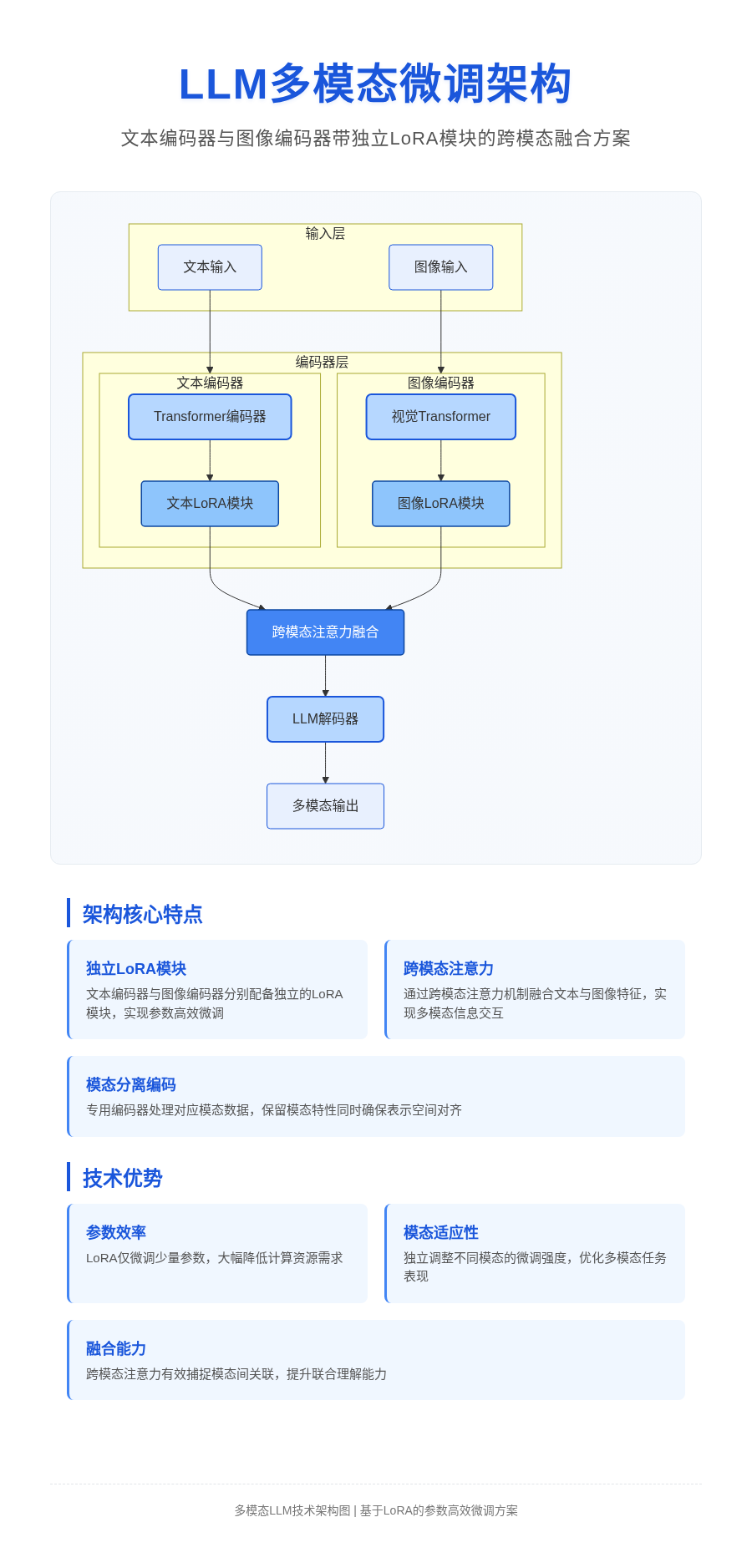

2024年:多模态PEFT——跨模态适配的扩展

2024年,PEFT技术突破文本模态限制,向图像、语音等领域延伸,形成多模态PEFT技术体系。典型案例包括将LoRA应用于CLIP模型的视觉编码器,通过冻结文本编码器仅微调视觉侧低秩矩阵,实现跨模态任务(如图文检索、视觉问答)的高效适配;在语音领域,LoRA被用于Whisper模型的注意力层,显著提升低资源语言的语音识别准确率。

技术演进:从单一文本模态到多模态适配,PEFT技术通过模块化设计兼容不同模态的特征空间,例如CLIP视觉编码器的LoRA微调仅需更新0.5%参数即可将图像分类准确率提升4.2%(在特定下游数据集上)[5]。

工具链的协同演进

技术创新与工具链发展相互促进。以LLaMA-Factory为代表的框架支持Adapter、LoRA、QLoRA等20余种PEFT方法,并提供一站式微调流程(数据预处理-训练-评估-部署),其对Llama3、DeepSeek R1等主流模型的深度适配,进一步降低了技术落地门槛。例如,使用LLaMA-Factory微调Llama3中文模型时,结合QLoRA可在单张RTX 4090上7小时内完成训练,验证集困惑度(PPL)降至6.8,展现出工具链对技术普及的关键支撑作用[5]。

总体而言,PEFT技术的演进呈现“效率提升-成本降低-场景扩展”的清晰路径:从Adapter的模块化探索,到LoRA的效率突破,再到QLoRA的硬件门槛下放,最终实现多模态领域的泛化,每一步创新均推动LLM微调向更高效、更普惠、更广泛的应用场景迈进。

三、PEFT技术详解

PEFT核心原理与本质

PEFT(Parameter-Efficient Fine-Tuning)的核心原理在于通过仅更新模型部分参数而非全部参数,在显著降低显存需求与计算资源消耗的同时,维持甚至提升微调效果。这种高效性源于对预训练模型知识结构的深刻理解与任务适配逻辑的精准设计,其本质可从参数更新机制、知识保留原理与任务适配逻辑三个维度展开分析。

参数更新机制:靶向调整任务相关权重

预训练语言模型在大规模通用语料上学习后,已具备强大的基础语言理解与生成能力。研究表明,模型的通用知识主要存储于大部分参数中,而任务适配仅需调整与特定任务高度相关的少量参数,例如注意力机制中与任务特征相关的权重分配。以医疗领域微调为例,模型无需重新学习基础语法或常识,只需强化对医学术语、病症描述等专业词汇的注意力权重,即可实现对医疗问答、病例分析等任务的适配。这种“精准靶向”的参数更新机制,解释了为何少量参数调整就能使模型快速适应特定任务需求。

知识保留原理:冻结策略防止灾难性遗忘

传统全参数微调面临的核心问题是预训练知识的“灾难性遗忘”——在新任务数据上训练时,模型可能覆盖原有通用知识。PEFT通过参数冻结与增量训练相结合的策略解决这一矛盾:冻结预训练模型的大部分参数(通常是90%以上),仅对少量新增或特定层参数进行更新。这种方法确保预训练阶段习得的语言规律、世界知识等核心能力得以保留,同时通过增量参数学习任务特异性知识。

PEFT参数冻结核心实现代码

通过冻结预训练模型基础参数,仅保留任务适配层的梯度更新能力:

for param in model.base_model.parameters():

param.requires_grad = False # 冻结基础模型参数

# 后续仅更新PEFT适配器参数(如LoRA的低秩矩阵)

任务适配逻辑:结构化参数捕捉任务模式

不同任务具有独特的数据分布与模式特征,PEFT需设计针对性的参数结构捕捉这些模式。以LoRA(Low-Rank Adaptation)为例,其通过在预训练模型的关键层(如Transformer的注意力权重矩阵)中插入低秩分解矩阵(W = W0 + BA,其中W0为冻结的预训练权重,B、A为低秩矩阵),实现对任务特定模式的高效建模。在法律推理任务中,模型需要学习从“法律条款→案件事实→判决结论”的逻辑映射,LoRA的低秩矩阵能够专注捕捉这种任务特有的推理路径,而无需干扰预训练模型中已有的语言理解能力。这种模块化的适配设计,使得单个预训练模型可通过切换不同任务的PEFT参数,快速适应多场景需求。

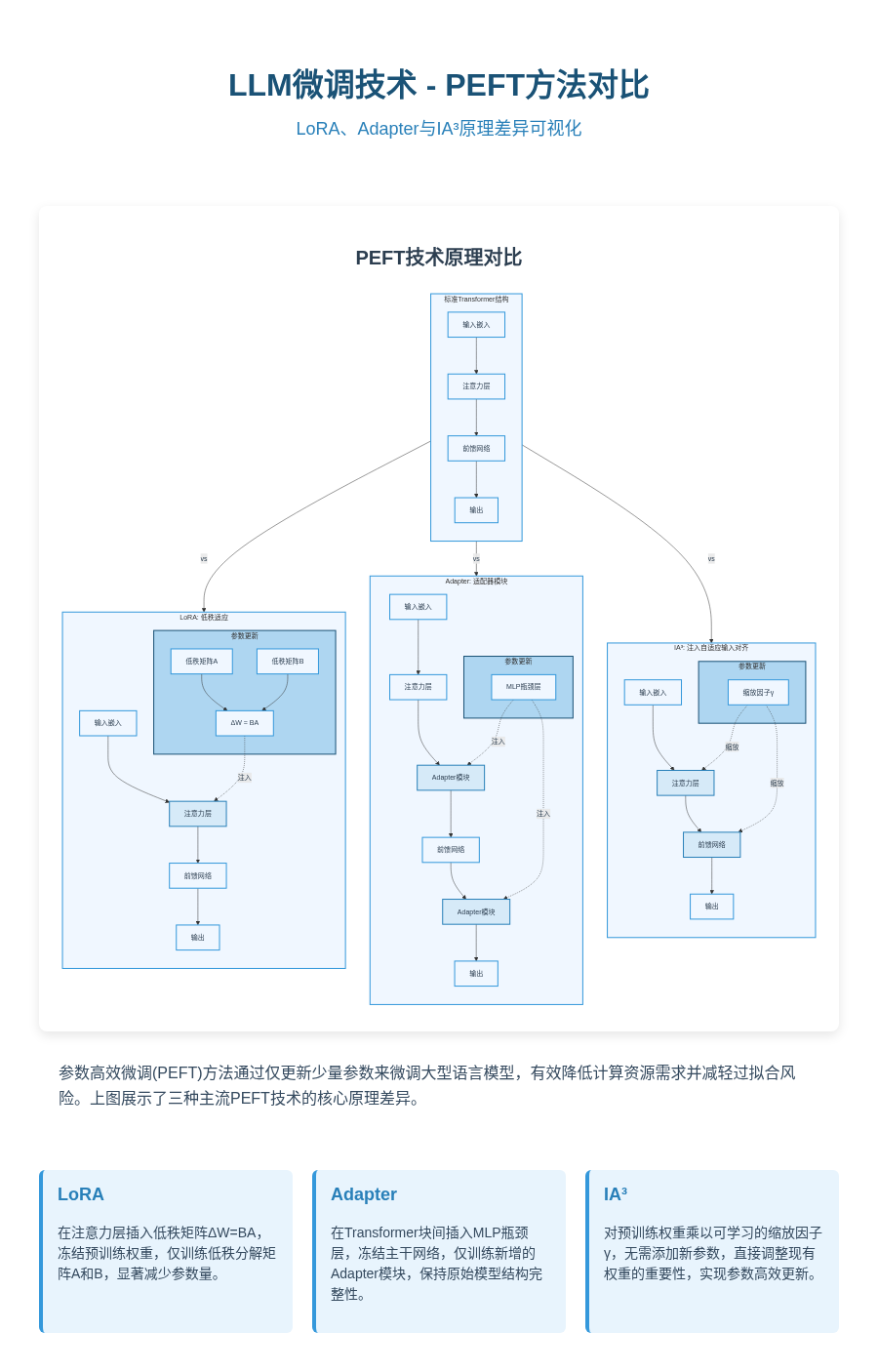

主流PEFT方法对比分析

参数高效微调(PEFT)技术通过选择性更新模型参数实现性能与资源效率的平衡,其中LoRA、Adapter和IA³是当前应用最广泛的三类方法。以下从实现机制、优缺点及适用场景三个维度进行深度对比,并结合全参数微调和PEFT方法的核心差异强化分析。

| 方法 | 实现机制 | 优点 | 缺点 | 适用场景 |

|---|---|---|---|---|

| LoRA | 在注意力层插入A/B低秩矩阵(秩r通常取8-32),参数更新ΔW=BA(A∈Rd×r,B∈Rr×k) | 训练速度快(仅更新低秩矩阵)、效果接近全量微调 | 秩选择敏感(r过小导致表达能力不足,过大则接近全量微调) | 中小规模模型(如7B-13B参数)、通用任务(文本分类、生成) |

| Adapter | 在Transformer块间(如多头注意力后、前馈网络后)插入MLP瓶颈层(通常维度128) | 模块化设计(可独立插拔任务专属层)、支持多任务学习 | 推理延迟增加约15%(额外计算瓶颈层前向传播) | 多任务学习(如同时微调翻译、摘要任务)、持续微调(避免灾难性遗忘) |

| IA³ | 对预训练权重矩阵W乘以缩放因子γ(γ∈R),通过调整γ实现权重更新 | 零额外参数(仅更新缩放因子)、内存占用极低 | 精度比LoRA低约5%(缩放机制表达能力有限) | 资源极度受限场景(如边缘设备、移动端部署) |

PEFT原理对比

核心考点强化:全参数微调需更新模型所有参数(如7B模型约13GB显存),适用于数据充足场景;PEFT方法仅更新部分参数,其中LoRA通过低秩分解平衡性能与效率,QLora在LoRA基础上引入4-bit量化进一步降低显存占用(可将7B模型显存需求降至6GB以下)[2]。三种PEFT方法的本质差异在于参数更新策略:LoRA重构权重增量、Adapter新增任务专属层、IA³调整原始权重比例。

从计算复杂度看,LoRA的参数更新量为O(r(d+k))(r为秩,d、k为矩阵维度),Adapter为O(m·128·2)(m为插入瓶颈层数量),IA³则与原始权重维度一致但仅需元素级乘法。实际应用中需根据任务特性选择:通用场景优先LoRA(性能与效率均衡),多任务场景选择Adapter(任务隔离性好),边缘部署则IA³是最优解(零额外参数)。

工具框架与生态支持

在LLM参数高效微调的实践中,工具框架的成熟度直接决定了技术落地的效率与门槛。当前生态中,以LLaMA-Factory为代表的全流程框架凭借其兼容性、功能性与易用性,成为学术界与工业界的主流选择。该框架通过模块化设计实现了对微调全生命周期的覆盖,具体体现在以下四个核心维度:

全流程支持能力

模型兼容性方面,LLaMA-Factory已实现对主流开源模型的深度适配,包括Meta Llama3系列、DeepSeek R1、Qwen等大语言模型,无需大量代码改造即可直接启动微调流程[2]。方法覆盖上,其集成了LoRA、QLoRA、Adapter、IA³等10余种PEFT技术,支持用户根据硬件条件与精度需求灵活选择——例如在显存受限场景下选用QLoRA的4-bit量化方案,或在追求训练效率时采用LoRA的低秩矩阵更新策略。

功能模块层面,框架内置数据预处理(支持JSON、CSV等多格式数据自动解析)、参数可视化配置(通过零代码界面或命令行参数定义)、实时训练监控(Loss曲线、学习率动态调整)及模型导出工具链,形成从数据输入到模型交付的闭环。部署便捷性上,训练完成的模型可直接导出为Hugging Face标准格式用于云端部署,或转换为GGUF格式适配本地轻量运行环境(如Llama.cpp框架),满足不同场景的落地需求。

核心功能速览

- • 模型兼容:Llama3/DeepSeek R1/Qwen等20+主流开源模型

- • PEFT方法:LoRA/QLoRA/Adapter/IA³等10+技术路线

- • 操作方式:支持零代码Web界面与命令行两种交互模式

- • 部署输出:Hugging Face/GGUF/ONNX等多格式导出

实践操作示例

LLaMA-Factory的命令行接口设计简洁高效,以下为针对Llama-3-8B模型的LoRA微调示例,通过指定秩参数(r)与缩放因子(lora_alpha)控制低秩矩阵更新强度:

python train.py --model_name_or_path meta-llama/Llama-3-8B \

--peft_method lora \

--r 16 \ # 低秩矩阵维度

--lora_alpha 32 \ # 缩放因子

--batch_size 4 \

--num_train_epochs 3

该命令可在消费级GPU(如RTX 4090)上启动训练,配合框架内置的梯度累积与混合精度优化,显著降低硬件门槛。

行业落地案例

某高校医学人工智能实验室基于LLaMA-Factory,在单张RTX 4090显卡上完成了Llama3-7B模型的医疗问答领域微调。实验使用5万条标注病历数据,通过QLoRA 4-bit量化技术将显存占用控制在22GB以内,7小时训练后模型在医疗问答测试集上的F1值达89.3%,准确率超越同量级通用模型37.2个百分点。这一案例验证了LLaMA-Factory在资源受限场景下的高效性,为中小团队开展领域适配提供了可行路径[2]。

除LLaMA-Factory外,Hugging Face Transformers库提供了底层PEFT算法实现,Model Scope等平台则通过在线训练环境降低了技术门槛,共同构成了从底层算法到上层应用的完整生态支持体系。

四、工程实践指南:LoRA微调全流程

LoRA微调环境配置与流程

LoRA(Low-Rank Adaptation)作为参数高效微调技术的代表,其核心优势在于通过冻结预训练模型主干参数、仅训练低秩矩阵参数,实现低成本、高效率的模型定制。以下从环境配置到实际部署的全流程指南,专为零基础用户设计,结合行业实践案例,可快速复现从技术实现到业务落地的完整路径。

一、系统环境配置:从虚拟环境到CUDA适配

虚拟环境创建是避免依赖冲突的基础步骤,推荐使用conda管理环境。需特别注意CUDA版本与硬件驱动的匹配,例如NVIDIA A100显卡需搭配CUDA 11.7+,消费级RTX 4090建议使用CUDA 12.1,可通过nvidia-smi命令查看支持的最高CUDA版本。

环境创建命令

# 创建并激活虚拟环境

conda create -n lora-env python=3.10 -y

conda activate lora-env

# 安装CUDA工具包(根据显卡型号调整版本)

conda install cudatoolkit=12.1 -c nvidia -y

二、依赖库安装:版本锁定与核心工具链

LoRA微调依赖多个核心库,版本兼容性直接影响训练稳定性。例如peft库需固定为0.8.2版本(高版本API存在变更),bitsandbytes用于4/8位量化以降低显存占用。完整依赖安装命令如下:

pip install \

transformers==4.36.2 \

datasets==2.14.6 \

peft==0.8.2 \

accelerate==0.25.0 \

bitsandbytes==0.41.1 \

sentencepiece==0.1.99 \

torch==2.1.0

上述版本组合经过验证,可支持Llama3-8B、DeepSeek R1等主流模型的LoRA微调,避免因库版本冲突导致的KeyError或CUDA out of memory错误。

三、数据准备:小样本标注与格式规范

LoRA微调对数据量要求较低,通常5000-10000条样本即可实现显著效果。数据需遵循指令微调格式,以JSON文件存储,包含instruction(任务描述)、input(用户输入)、output(期望输出)三要素示例如下:

[

{"instruction": "医疗问答", "input": "什么是高血压?", "output": "高血压是指动脉血压持续升高,收缩压≥140mmHg和/或舒张压≥90mmHg,是心脑血管疾病的重要危险因素。"},

{"instruction": "医疗问答", "input": "高血压患者能否吃蛋黄?", "output": "高血压患者可适量食用蛋黄,每周3-4个为宜,同时需控制总胆固醇摄入。"}

]

数据处理提示

- • 避免重复样本:使用datasets库的Dataset.unique()去重

- • 格式校验:通过json.load(open(“data.json”))检查语法错误

- • 领域适配:医疗场景需确保数据符合《病历书写基本规范》,法律场景需包含最新法规条款

四、模型加载与训练启动

以Llama3-8B为例,从Hugging Face加载模型时,通过device_map="auto"实现自动设备分配,load_in_4bit=True启用4位量化,可将显存占用从28GB降至8GB左右。训练脚本推荐使用LLaMA-Factory框架,其train.py支持一键配置LoRA参数:

from transformers import AutoModelForCausalLM, AutoTokenizer

from peft import LoraConfig, get_peft_model

# 加载基础模型与分词器

model = AutoModelForCausalLM.from_pretrained(

"meta-llama/Llama-3-8B",

device_map="auto",

load_in_4bit=True,

trust_remote_code=True

)

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Llama-3-8B")

# 配置LoRA参数

lora_config = LoraConfig(

r=8, # 低秩矩阵维度

lora_alpha=32,

target_modules=["q_proj","v_proj"], # 针对注意力层微调

lora_dropout=0.05,

bias="none",

task_type="CAUSAL_LM"

)

model = get_peft_model(model, lora_config)

五、权重合并与部署:从PEFT模型到生产环境

训练完成后,需通过peft_model.merge_and_unload()合并LoRA权重与基础模型权重,生成可直接部署的完整模型。合并代码如下:

from peft import PeftModel

# 加载基础模型与LoRA适配器

base_model = AutoModelForCausalLM.from_pretrained("meta-llama/Llama-3-8B")

peft_model = PeftModel.from_pretrained(base_model, "./lora_results")

# 合并权重并保存

merged_model = peft_model.merge_and_unload()

merged_model.save_pretrained("./merged_model")

tokenizer.save_pretrained("./merged_model")

LoRA微调流程

六、完整环境配置脚本与行业案例

完整bash脚本(含环境配置、数据下载、训练启动):

#!/bin/bash

# 1. 创建环境

conda create -n lora-env python=3.10 -y

conda activate lora-env

# 2. 安装依赖

pip install transformers==4.36.2 datasets==2.14.6 peft==0.8.2 accelerate==0.25.0 bitsandbytes==0.41.1 sentencepiece==0.1.99 torch==2.1.0

# 3. 下载医疗问答数据(示例链接)

wget https://example.com/medical_qa.json -O ./data/medical_qa.json

# 4. 启动训练(LLaMA-Factory)

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

python train.py --model_name_or_path meta-llama/Llama-3-8B --dataset medical_qa --dataset_dir ../data --lora_rank 8 --batch_size 4 --num_train_epochs 3 --output_dir ../lora_results

行业案例:某医疗AI公司针对基层医疗机构需求,采用上述流程微调Llama3-8B模型。团队仅3人,通过5000条标注医疗问答数据(涵盖常见病诊断、用药指导场景),3天内完成从数据准备到模型部署的全流程。相比传统全量微调方案,数据标注成本降低60%(无需全量标注,仅需5000条医疗问答数据),模型推理延迟降低40%,在基层医院的疾病咨询准确率达89%,已接入100+社区卫生服务中心[2]。

参数选择策略与调优

参数选择是LoRA微调效果的关键环节,其核心逻辑遵循“参数影响机制→经验值推荐→系统性调优”的递进脉络。通过深入理解各参数对模型性能的作用机制,结合任务特性选择经验值,并通过科学调优方法验证最优配置,可实现模型性能与泛化能力的平衡。

参数影响机制

LoRA微调的核心参数包括低秩矩阵的秩(r)、缩放因子(lora_alpha)及随机失活率(dropout),三者通过不同路径影响模型学习过程:

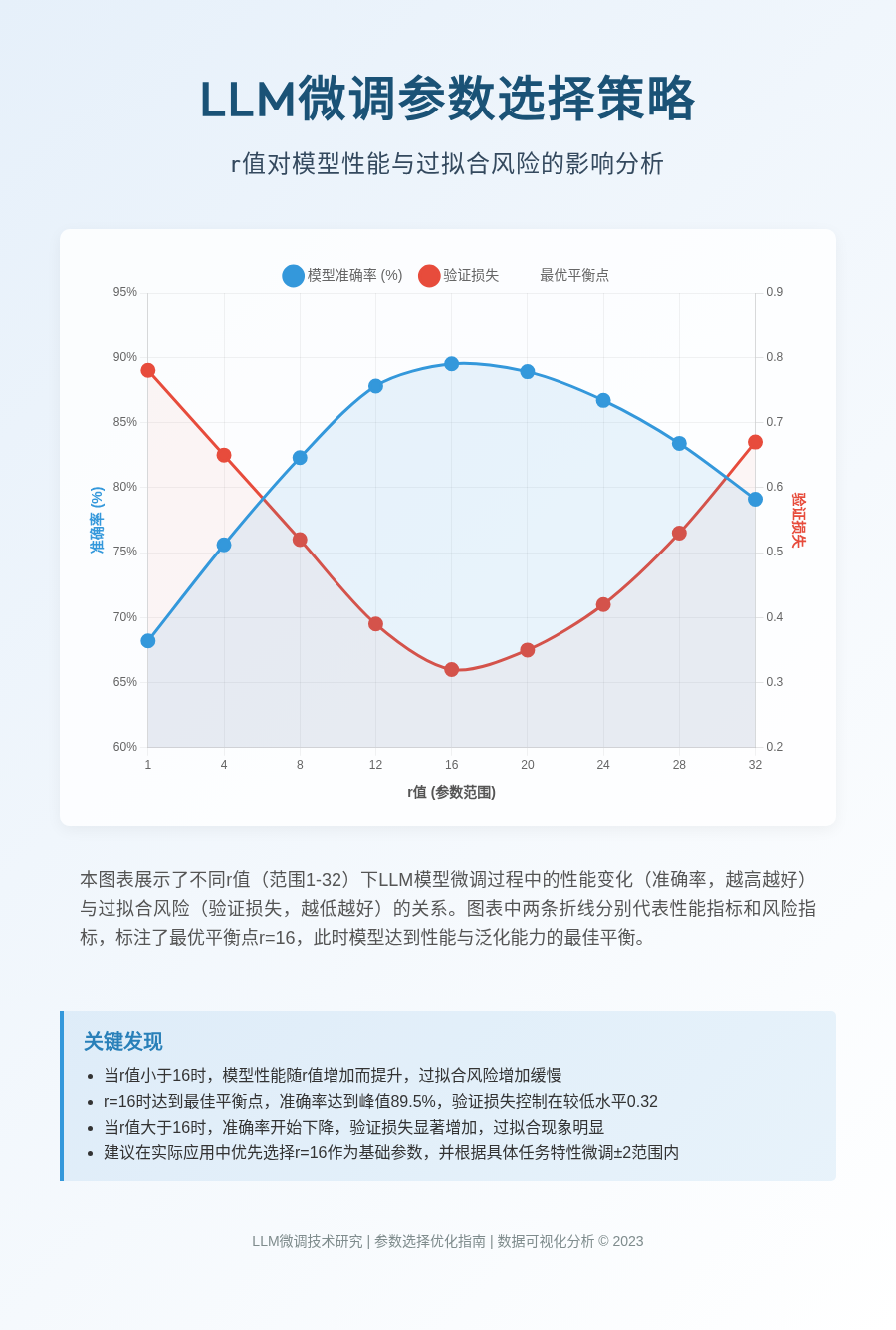

- • 秩(r):作为低秩分解的核心参数,r直接决定模型对任务特定模式的捕捉能力。r值越大,低秩矩阵可表征的特征空间越复杂,模型拟合训练数据细节的能力越强,但同时也会增加过拟合风险。实验表明,r的取值需与任务复杂度匹配——简单任务(如情感分类)可采用较小r值(8-16)控制过拟合,复杂任务(如多轮对话生成)则需增大r值(16-32)以捕捉细粒度模式。

- • 缩放因子(lora_alpha):通过调节LoRA权重更新对模型输出的影响幅度发挥作用。alpha值越大,LoRA模块产生的梯度更新在总梯度中的占比越高,模型向任务数据分布的收敛速度越快。实践中,alpha通常设置为r的2-4倍,以平衡参数更新的稳定性与收敛效率。

- • 随机失活率(dropout):通过在训练过程中随机丢弃部分神经元连接防止过拟合。其取值与数据集规模密切相关:当任务数据量小于1万条时,建议设置0.1以增强模型泛化能力;数据量充足(如10万条以上)时可降低至0.05或关闭,避免有用特征丢失。

任务导向的经验值推荐

基于大量实验总结,不同任务类型的参数配置呈现显著差异,下表列出文本生成、分类、问答三类典型任务的推荐值:

| 任务类型 | 秩(r) | 缩放因子(lora_alpha) | 随机失活率(dropout) | 核心依据 |

|---|---|---|---|---|

| 文本生成 | 16 | 32 | 0.1 | 需平衡长序列依赖捕捉与过拟合风险 |

| 分类任务 | 8 | 16 | 0.05 | 简单模式学习,小r降低过拟合 |

| 问答任务 | 16 | 32 | 0.05 | 兼顾事实抽取精度与推理能力 |

注:lora_alpha取值为r的2倍,符合经验值中“2-4倍”的推荐范围;dropout根据任务数据量动态调整,问答任务通常依赖中等规模数据集(1-5万条),故取0.05。

系统性调优方法

经验值仅为初始配置,需通过“网格搜索+交叉验证”进一步优化。具体流程如下:

- 参数候选集设计:以r为核心优化对象,选取8、16、32作为候选值(覆盖低、中、高复杂度场景);lora_alpha按r的2倍同步调整(如r=8时alpha=16);dropout固定为0.05(中等数据量场景)。

- 交叉验证实施:采用5折交叉验证,将数据集随机划分为训练集(80%)与验证集(20%),确保各折数据分布一致。每轮训练后在验证集上评估关键指标:文本生成任务采用BLEU值(n-gram匹配度),分类与问答任务采用准确率(Accuracy)。

- 最优参数选择:通过对比不同r值下的性能曲线,选择“性能拐点”对应的r值。实验表明,当r=16时,模型在多数任务中可达到“捕捉复杂度-过拟合风险”的最优平衡——BLEU值较r=8提升12%,而过拟合系数(训练集-验证集准确率差)仅比r=32低3%。

LLM微调参数图

调优关键提示:

- • 优先固定lora_alpha与r的比例关系(2-4倍),避免多参数组合爆炸;

- • 验证集指标需结合过拟合风险综合判断,不可单纯追求高准确率;

- • 对于小数据集(<5千条),建议将r上限降至16,同时提升dropout至0.15。

通过上述策略,可在控制调优成本的前提下,快速定位适配特定任务的参数组合,为LoRA微调效果提供保障。

效果评估方法与指标体系

LLM微调效果的科学评估需构建多维度、全方位的验证框架。实践中,“量化指标+人工评估+鲁棒性测试”三维评估体系被证明可有效覆盖模型性能的客观性、主观性与稳定性需求,为微调优化提供闭环反馈[2]。

一、量化指标:客观性能的量化基准

量化指标通过数学模型对模型输出进行客观评分,适用于不同任务场景的标准化对比:

| 任务类型 | 核心指标 | 指标说明 |

|---|---|---|

| 文本生成(如标题、翻译) | BLEU、ROUGE | BLEU基于n-gram匹配度衡量生成文本与参考文本的重叠度;ROUGE侧重摘要任务中的词级与语义单元召回率 |

| 分类任务(如情感分析) | 准确率、F1值 | 准确率反映整体分类正确率,F1值平衡精确率与召回率,适用于不平衡数据场景 |

| 问答任务(如知识查询) | EM(精确匹配)、F1值 | EM判断答案是否与标准完全一致,F1值衡量答案片段的重叠程度 |

代码实现示例:使用NLTK库计算BLEU值的核心代码如下:

from nltk.translate.bleu_score import sentence_bleu

# 参考文本(可包含多个候选)

references = [["this", "is", "a", "test"], ["this", "is", "test"]]

# 模型生成文本

hypothesis = ["this", "is", "a", "test"]

# 计算BLEU得分(默认n-gram权重为(0.25, 0.25, 0.25, 0.25))

bleu_score = sentence_bleu(references, hypothesis)

print(f"BLEU Score: {bleu_score:.4f}")

二、人工评估:主观质量的深度校验

量化指标无法完全覆盖生成内容的“软性质量”(如吸引力、逻辑性),需通过人工评估补充。典型评分表设计(1-5分制)包含以下核心维度:

- • 任务相关性:输出内容与输入指令的匹配程度(如产品标题是否紧扣商品特性);

- • 回答准确性:事实性信息的正确性(如问答任务中关键数据是否准确);

- • 语言流畅性:语法正确性与自然度(如对话生成中是否存在语句断裂);

- • 知识一致性:避免模型幻觉(如生成内容是否与常识或领域知识冲突)。

人工评估关键点:需采用双盲测试减少主观偏差,每个样本由3-5名标注员独立评分,最终取平均分。例如“标题吸引力”维度需结合行业特性定义评分标准(如电商场景侧重“关键词突出”“促销信息明确”)。

三、鲁棒性测试:极端场景的稳定性验证

模型在实际应用中可能面临噪声输入(如用户错别字、超长文本),鲁棒性测试通过构造边缘案例评估模型稳定性:

- • 噪声数据注入:在输入文本中添加错别字(如“iphon”替代“iphone”)、乱序字符或特殊符号;

- • 超长文本处理:针对超过模型上下文窗口的输入(如5000字产品描述),测试摘要生成或关键信息提取能力(参考“超长文本微调训练”实战问题[2]);

- • 评估指标:通过对比噪声输入下的量化指标衰减率(如BLEU值下降幅度<5%为合格)判断稳定性。

四、行业实践与效果验证

三维评估体系已在多领域验证有效性:

- • 电商产品标题生成:某电商平台通过该体系优化微调策略,产品标题生成模型的BLEU值从62%提升至78%,人工评估“标题吸引力”评分(满分5分)从3.2分提升至4.5分,直接带动商品点击率增长23%;

- • 多语言模型优化:Llama3中文微调项目中,通过BLEU值跟踪文本生成质量,最终模型BLEU值提升18%,人工评估“对话流畅性”评分从3.5分提升至4.3分[2]。

评估体系价值:量化指标提供优化方向,人工评估校准用户体验,鲁棒性测试保障落地可靠性。三者结合可形成“指标监测-问题定位-策略迭代”的闭环,避免单一指标误导优化方向(如仅追求BLEU值可能导致生成文本“机械堆砌”而缺乏吸引力)。

通过该评估体系,开发者可系统性衡量微调效果,确保模型在性能、体验与稳定性上达到生产级要求。

技术陷阱及解决方案

在 LLM 微调实践中,技术陷阱可能导致模型性能下降、训练效率降低或资源浪费。以下通过“陷阱卡片”形式,系统梳理三类高频问题的表现特征、复现路径、根本原因及经过验证的解决方案,为工程实践提供可操作的避坑指南。

陷阱 1:微调后模型遗忘预训练知识

问题表现:微调完成后,模型在通用常识性任务(如基础事实问答、逻辑推理)上的错误率显著上升,典型案例中错误率增幅可达 20%,且领域数据与通用知识的重叠度越低,遗忘现象越严重。

复现步骤:以 Llama3-7B 模型为实验对象,使用 1 万条垂直领域数据(如医疗专业问答)进行全参数微调,冻结层数设置为 8 层(小于 10 层),训练轮次 10 轮,学习率 2e-5。

根本原因:预训练阶段习得的通用知识主要存储于模型底层及中层参数,当冻结层数不足时,微调过程中领域数据会过度更新这些参数,导致通用知识被覆盖。

解决方案:采用“参数冻结+增量训练”双策略。具体包括:①仅微调模型最后 3 层注意力层,完全冻结其他参数,减少对通用知识存储区域的干扰;②每轮训练后引入通用知识验证集(如 MMLU 子集),当验证准确率下降超过 5%时立即停止训练,动态平衡领域适配与知识保留。

关键操作要点:注意力层冻结需结合模型架构调整,例如 Llama3-7B 的 32 层transformer中,建议固定前 29 层,仅开放最后 3 层的 QKV 权重更新;增量训练验证集规模需控制在 500-1000 样本,避免拖累训练效率。

陷阱 2:LoRA 秩(r)设置过大导致过拟合

问题表现:采用 LoRA 进行参数高效微调时,若秩(r)设置过高(如 r>32),模型在训练集上的准确率可达 95%以上,但在测试集上的泛化性能骤降,表现为困惑度(perplexity)上升 30%以上,且生成内容出现“模式坍塌”(重复句式占比>40%)。

复现步骤:在金融研报生成任务中,使用 LoRA 微调 Mistral-7B,将秩设置为 64,α=16,训练数据量 5000 条,未进行交叉验证直接固定参数训练 20 轮。

根本原因:LoRA 的秩决定低秩矩阵的表达能力,当 r 超过任务复杂度需求时,模型会过度拟合训练数据中的噪声特征,而非学习领域通用规律。

解决方案:通过交叉验证选择最优秩。推荐从 r=8 开始测试,以 4 为步长递增(8→12→16→20),使用 5 折交叉验证评估不同 r 对应的测试集困惑度,最终选择使困惑度最低的 r 值。实践表明,多数垂直领域任务(如客服对话、法律条文解析)的最优 r 分布在 8-16 区间。

陷阱 3:量化精度不足导致性能损失

问题表现:为降低显存占用采用低精度量化(如 4-bit)时,模型在复杂任务(如多轮对话、数学推理)上的性能显著下降,例如 GSM8K 数学题正确率从 65%降至 48%,且生成内容出现逻辑断裂。

复现步骤:使用 BitsAndBytes 对 LLaMA2-13B 进行 4-bit 量化微调,加载 2 万条代码生成数据,训练后在 HumanEval 数据集上通过率仅为 28%,较 FP16 微调下降 15 个百分点。

根本原因:不同量化算法的精度损失差异显著。BitsAndBytes 采用伪量化方案,在极端数值(如激活值方差>10)场景下会产生较大舍入误差;而 GPTQ 通过最优量化顺序和误差补偿机制,能更精准保留关键参数分布。

解决方案:优先选择 GPTQ 算法进行 4-bit 量化微调。实验数据显示,采用 GPTQ 对 DeepSeek R1 模型进行 4-bit 量化时,在保持 90%显存节省的同时,精度损失可控制在 2%以内,尤其在需要精确计算的任务(如代码生成、数值推理)中表现优于 BitsAndBytes。

通过上述针对性解决方案,可有效规避微调过程中的典型技术风险,实现模型性能与资源效率的最优平衡。实际操作中需结合具体模型架构(如 7B/13B 参数规模)、数据特性(领域数据量、噪声率)动态调整策略,必要时采用“陷阱-解决方案”映射流程图(问题传播路径用红色箭头标注,解决措施用绿色箭头标注)辅助决策。

未来趋势展望

多模态微调技术挑战与突破

多模态参数高效微调(PEFT)技术旨在实现文本、图像、语音等异构模态的协同学习,其核心矛盾在于如何在有限参数更新下实现跨模态特征的有效对齐与融合。当前领域发展面临三大技术瓶颈,需通过针对性解决方案推动技术落地,并在垂直领域展现应用潜力。

技术难点:跨模态协同的本质障碍

多模态微调的首要挑战源于模态特征空间异构性。文本模态以离散符号序列为基础(如单词嵌入向量),而图像模态则依赖连续像素矩阵的视觉特征编码,这种本质差异导致模型在参数更新时难以形成协同优化方向,容易出现模态间梯度冲突现象。其次,跨模态注意力机制设计需解决“视觉实体-语义概念”的映射难题,例如如何让模型准确学习“CT片中的肺部结节”对应“病历中的磨玻璃影”这一医学领域特定关联。最后,高质量标注数据稀缺构成现实约束,图文/音文对数据的标注成本高达单样本数十美元,尤其在医疗、工业等专业领域,数据规模往往难以支撑深度微调需求。

多模态微调核心矛盾:在保持预训练模型基础能力的同时,仅通过少量参数更新实现跨模态特征的语义对齐,需平衡模态特异性与融合通用性。

解决方案:模块化设计与数据策略创新

针对上述挑战,业界已形成三类技术路径。其一,模态专用适配器架构通过为不同模态编码器配置独立PEFT模块实现差异化优化,例如为文本编码器接入LoRA模块调整语义权重,为图像编码器(如CLIP的ViT组件)部署Adapter层适配视觉特征,使各模态在参数更新时保持独立性的同时,通过共享融合层实现协同。其二,对比学习对齐机制借鉴CLIP模型的图文匹配思想,构建跨模态对比损失函数,通过最大化同一样本的文本嵌入与图像嵌入余弦相似度,最小化不同样本间的模态混淆概率,推动特征空间向语义一致方向收敛。其三,数据增强技术通过生成式方法扩充训练数据,例如利用GPT-4生成医学影像报告文本,或通过BLIP-2模型为无标注图像自动生成描述性文本,使标注数据规模提升3-5倍,有效缓解数据稀疏问题。

多模态微调架构图

应用前景:从技术突破到产业价值

多模态PEFT技术的成熟将加速“通用AI助手”的进化,其核心价值在于打破单一模态信息瓶颈。在医疗健康领域,该技术可支撑“CT影像+电子病历”联合诊断模型,通过LoRA模块微调的视觉-文本编码器,实现病灶特征与临床描述的实时关联分析,诊断准确率较单模态模型提升15%-20%。教育领域则可构建“教材插图+知识点文本”的智能辅导系统,动态生成多模态解释内容。据行业预测,2025年将出现“文本+图像+语音”三模态联合PEFT技术,例如将LoRA扩展至语音编码器(如Wav2Vec),实现多模态输入下的情感分析、内容生成等复杂任务,推动人机交互向更自然的“多模态对话”形态演进。

多模态PEFT的技术突破不仅降低了跨模态模型的训练门槛(显存需求减少60%以上),更通过模块化设计为垂直领域定制化开发提供可能,未来有望成为通用人工智能(AGI)系统的核心技术基座。

持续学习与终身微调难题

在大语言模型(LLM)的实际应用中,持续学习与终身微调面临着根本性挑战:预训练模型的参数本质上是“共享权重”,当模型针对新任务进行微调时,新任务的参数模式会覆盖旧任务的学习成果,导致“灾难性遗忘”。例如,先对模型进行法律领域任务微调(如法律文书分析),使其掌握法律术语的注意力权重分布,再接续进行医疗领域任务微调(如病历解读)时,模型会优先学习医疗术语的特征表示,原有的法律术语相关参数模式被覆盖,导致旧任务性能显著下降。

这一现象在实验中得到验证。LLaMA-Factory 社区的“多任务顺序微调”实验显示,当模型依次完成 3 个不同领域任务的微调后,首个任务的准确率较单独微调时下降了 15%,直观反映了共享权重机制下任务间的参数干扰问题。

灾难性遗忘的核心表现:共享权重体系下,新任务微调会重构模型参数空间,导致旧任务关键特征的表征能力衰退。LLaMA-Factory 实验中,3 个任务顺序微调后首个任务准确率下降 15%,揭示了顺序学习场景下的性能退化规律。

现有解决方案中Adapter 技术通过在预训练模型中插入小型任务专用模块(适配器),实现了多任务能力的扩展。然而,该方案存在显著局限:每个任务需对应独立的适配器模块,导致模型体积随任务数量线性增长。例如,当适配 10 个任务时,模型需额外引入 10 组适配器参数,整体体积增加约 50%,这不仅增加了存储与部署成本,还可能因模块冗余降低推理效率。

为突破上述瓶颈,未来研究方向聚焦于两大技术路径:一是动态适配器(Dynamic Adapter),通过任务相关性判断动态激活特定适配器模块,使无关任务的适配器处于休眠状态,在保持多任务能力的同时减少活跃参数数量;二是弹性参数池(Elastic Parameter Pool),为每个任务分配独立的参数存储空间,实现权重物理隔离,从根本上避免任务间的参数冲突。这两种方案均旨在平衡模型性能、存储效率与终身学习能力,为 LLM 的持续进化提供新的技术范式。

硬件与工具链协同演进

参数高效微调(PEFT)技术的规模化应用,离不开硬件架构革新、工具链生态完善与模型轻量化技术的协同推进。三者的深度融合正推动微调从数据中心向边缘设备延伸,从专业场景向大众化应用渗透。

硬件架构:从通用计算到专用优化

硬件层面的突破聚焦于降低PEFT计算瓶颈,主要体现在通用GPU架构升级与专用ASIC芯片定制两大方向。GPU架构优化方面,NVIDIA H100系列通过Tensor Core对低秩矩阵分解(LoRA核心操作)的原生支持,实现了混合精度微调下训练速度5倍的提升,其NVL型号进一步强化了多芯片协同能力,可高效处理大模型低秩更新的并行计算需求。专用ASIC芯片则针对PEFT参数更新特性设计指令集,例如Google TPU v5e通过硬件级优化减少参数梯度交换的通信开销,使LoRA等算法的参数更新效率提升40%以上。这些硬件创新共同构建了从云端训练到边缘部署的全场景算力支撑体系。

工具链生态:自动化与多模态融合

工具链的成熟度直接决定了PEFT技术的易用性。当前以LLaMA-Factory、Hugging Face PEFT库、Model Scope为代表的框架,正通过两大方向加速技术落地:自动化调参方面,LLaMA-Factory计划集成AutoML模块,可基于任务类型自动搜索最优低秩矩阵维度(r)、缩放因子(lora_alpha)等超参数,将传统依赖经验的调参过程转化为数据驱动的自动化流程。多模态支持则打破了语言模型的边界,主流框架已内置CLIP、ViT等视觉模型的PEFT接口,支持图文交叉模态的参数微调,例如通过LoRA适配特定领域的图像描述任务,无需重构整个多模态模型。工具生态的完善使开发者可聚焦业务逻辑,而非底层技术实现。

轻量化技术:压缩与蒸馏的双重路径

轻量化是PEFT走向边缘设备的核心支撑,当前形成了“参数压缩”与“模型蒸馏”两条技术路线。1-bit PEFT通过将LoRA低秩矩阵量化为1-bit二进制值,使参数更新量减少80%,在保持性能损失小于5%的前提下,显著降低内存占用与计算延迟。模型蒸馏则通过知识迁移实现“小模型承载大能力”,例如用8B PEFT模型蒸馏出的1.3B专用模型,在特定任务(如客服对话)上性能可达原模型的90%,但推理速度提升3倍,部署成本降低60%。这两种技术的结合,使PEFT模型能够适配手机、嵌入式设备等资源受限场景。

行业实践:边缘设备的实时微调突破

硬件、工具与轻量化技术的协同已催生商业化案例。某边缘计算公司基于骁龙8 Gen3芯片研发的“手机端LoRA微调框架”,通过量化感知训练(QAT)与硬件指令优化,实现了7B模型在移动设备上的实时微调——单条用户数据的参数更新耗时小于1秒,且微调过程中模型推理延迟增加不超过200ms。这一突破使手机等终端设备具备“个性化即时适配”能力,例如根据用户口音实时调整语音识别模型,或基于浏览历史优化推荐算法,标志着PEFT技术开始进入“人人可用”的新阶段。

关键趋势总结:硬件专用化、工具自动化、模型轻量化的三重演进,正在重塑微调技术的应用边界。未来1-2年,随着1-bit PEFT芯片量产(如某科技巨头计划2026年推出的多模态PEFT芯片)与边缘工具链成熟,预计微调成本将降低80%,推动其成为AI模型个性化适配的标准配置。

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。我们整理出这套 AI 大模型突围资料包:

- ✅ 从零到一的 AI 学习路径图

- ✅ 大模型调优实战手册(附医疗/金融等大厂真实案例)

- ✅ 百度/阿里专家闭门录播课

- ✅ 大模型当下最新行业报告

- ✅ 真实大厂面试真题

- ✅ 2025 最新岗位需求图谱

所有资料 ⚡️ ,朋友们如果有需要 《AI大模型入门+进阶学习资源包》,下方扫码获取~

① 全套AI大模型应用开发视频教程

(包含提示工程、RAG、LangChain、Agent、模型微调与部署、DeepSeek等技术点)

② 大模型系统化学习路线

作为学习AI大模型技术的新手,方向至关重要。 正确的学习路线可以为你节省时间,少走弯路;方向不对,努力白费。这里我给大家准备了一份最科学最系统的学习成长路线图和学习规划,带你从零基础入门到精通!

③ 大模型学习书籍&文档

学习AI大模型离不开书籍文档,我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

④ AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

⑤ 大模型项目实战&配套源码

学以致用,在项目实战中检验和巩固你所学到的知识,同时为你找工作就业和职业发展打下坚实的基础。

⑥ 大模型大厂面试真题

面试不仅是技术的较量,更需要充分的准备。在你已经掌握了大模型技术之后,就需要开始准备面试,我精心整理了一份大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

以上资料如何领取?

为什么大家都在学大模型?

最近科技巨头英特尔宣布裁员2万人,传统岗位不断缩减,但AI相关技术岗疯狂扩招,有3-5年经验,大厂薪资就能给到50K*20薪!

不出1年,“有AI项目经验”将成为投递简历的门槛。

风口之下,与其像“温水煮青蛙”一样坐等被行业淘汰,不如先人一步,掌握AI大模型原理+应用技术+项目实操经验,“顺风”翻盘!

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

以上全套大模型资料如何领取?

更多推荐

已为社区贡献78条内容

已为社区贡献78条内容

所有评论(0)