企业级知识库问答系统实战:从架构到部署的完整指南,大模型入门到精通,收藏这篇就足够了!

企业级知识库问答系统实战:从架构到部署的完整指南,大模型入门到精通,收藏这篇就足够了!

本文较长,请双击屏幕收藏,以免遗失,关注我,实力宠粉。不定时分享全网唯一技术干货文档。

一、智能问答系统架构设计

1.1 整体系统架构

graph LR

A[用户输入] --> B(前端界面)

B --> C{查询类型}

C -->|文本| D[文本处理模块]

C -->|语音| E[语音识别模块]

D & E --> F[检索引擎]

F --> G[Elasticsearch]

F --> H[向量数据库]

G & H --> I[结果融合]

I --> J[大模型生成]

J --> K[结果输出]

1.2 数据存储设计

Elasticsearch索引配置:

from elasticsearch import Elasticsearch

es = Elasticsearch()

es.indices.create(

index="enterprise_knowledge",

body={

"mappings": {

"properties": {

"title": {"type": "text"},

"content": {"type": "text", "analyzer": "ik_max_word"},

"embedding": {"type": "dense_vector", "dims": 768},

"department": {"type": "keyword"},

"update_time": {"type": "date"}

}

}

}

)

数据分区策略:

二、系统开发与实现

2.1 数据预处理流水线

import pandas as pd

from langchain.text_splitter import RecursiveCharacterTextSplitter

def preprocess_data(file_path):

# 读取数据

df = pd.read_csv(file_path)

# 清洗数据

df['content'] = df['content'].apply(

lambda x: re.sub(r'[^\w\s]', '', x)

)

# 文本分块

text_splitter = RecursiveCharacterTextSplitter(

chunk_size=500,

chunk_overlap=50

)

chunks = text_splitter.split_text(df['content'])

# 生成嵌入

embeddings = embed_model.encode(chunks)

return chunks, embeddings

2.2 混合检索实现

def hybrid_search(query, top_k=5):

# 关键词检索

keyword_results = es.search(

index="enterprise_knowledge",

body={

"query": {

"match": {

"content": query

}

},

"size": top_k

}

)

# 语义检索

query_embedding = embed_model.encode([query])[0]

_, semantic_indices = faiss_index.search(

np.array([query_embedding]), top_k

)

semantic_results = [doc_db[i] for i in semantic_indices[0]]

# 结果融合

combined_results = fuse_results(

keyword_results,

semantic_results

)

return combined_results[:top_k]

2.3 大模型生成模块

from transformers import pipeline

qa_pipeline = pipeline(

"text-generation",

model="deepseek-ai/deepseek-llm-7b-chat",

device_map="auto"

)

def generate_answer(query, context):

prompt = f"""

基于以下企业知识库信息:

{context}

请回答用户问题:

{query}

要求:

1. 回答简洁专业

2. 引用知识库中的具体条款

3. 如信息不足,请明确说明

"""

response = qa_pipeline(

prompt,

max_new_tokens=300,

temperature=0.3

)

return response[0]['generated_text']

三、性能优化策略

3.1 检索效率优化

多级缓存机制:

from redis import Redis

from functools import lru_cache

redis_cache = Redis(host='localhost', port=6379, db=0)

@lru_cache(maxsize=1000)

def cached_search(query):

# 内存缓存

if query in local_cache:

return local_cache[query]

# Redis缓存

redis_key = f"search:{hash(query)}"

if redis_cache.exists(redis_key):

return json.loads(redis_cache.get(redis_key))

# 实际检索

results = hybrid_search(query)

# 更新缓存

local_cache[query] = results

redis_cache.set(redis_key, json.dumps(results), ex=3600)

return results

FAISS索引优化:

# 使用IVF索引加速

dimension = 768

nlist = 100 # 聚类中心数

quantizer = faiss.IndexFlatIP(dimension)

index = faiss.IndexIVFFlat(quantizer, dimension, nlist)

# 训练索引

index.train(embeddings)

index.add(embeddings)

3.2 生成质量优化

上下文压缩技术:

def compress_context(context, query):

# 提取关键句子

from sumy.parsers.plaintext import PlaintextParser

from sumy.nlp.tokenizers import Tokenizer

from sumy.summarizers.lsa import LsaSummarizer

parser = PlaintextParser.from_string(context, Tokenizer("english"))

summarizer = LsaSummarizer()

summary = summarizer(parser.document, sentences_count=3)

return " ".join([str(sentence) for sentence in summary])

答案验证机制:

def validate_answer(answer, context):

# 使用NLI模型验证一致性

nli_pipeline = pipeline(

"text-classification",

model="roberta-large-mnli"

)

result = nli_pipeline(

f"{context} [SEP] {answer}",

candidate_labels=["entailment", "contradiction", "neutral"]

)

if result[0]['label'] == 'contradiction':

return "抱歉,根据知识库我无法确认该信息,请咨询相关部门"

return answer

四、用户界面与交互设计

4.1 前端界面实现

<div class="chat-container">

<div class="chat-history" id="history"></div>

<div class="input-area">

<input type="text" id="query-input" placeholder="输入问题...">

<button id="voice-btn">🎤</button>

<button id="send-btn">发送</button>

</div>

<div class="feedback">

<span>回答有帮助吗?</span>

<button class="feedback-btn" data-value="1">👍</button>

<button class="feedback-btn" data-value="0">👎</button>

</div>

</div>

4.2 语音交互集成

// 语音识别功能

const recognition = new webkitSpeechRecognition();

recognition.lang = 'zh-CN';

document.getElementById('voice-btn').addEventListener('click', () => {

recognition.start();

});

recognition.onresult = (event) => {

const transcript = event.results[0][0].transcript;

document.getElementById('query-input').value = transcript;

};

4.3 反馈闭环机制

# 反馈处理服务

@app.route('/feedback', methods=['POST'])

def handle_feedback():

data = request.json

log_feedback(data['question'], data['answer'], data['rating'])

if data['rating'] < 0.5: # 负面反馈

retrain_queue.add({

'question': data['question'],

'correct_answer': data.get('corrected_answer')

})

return jsonify({"status": "success"})

五、部署与维护方案

5.1 Kubernetes部署配置

apiVersion: apps/v1

kind: Deployment

metadata:

name: knowledge-qa

spec:

replicas: 3

selector:

matchLabels:

app: qa

template:

metadata:

labels:

app: qa

spec:

containers:

- name: qa-server

image: qa-system:v2.3

ports:

- containerPort: 8000

resources:

limits:

nvidia.com/gpu: 1

requests:

memory: "8Gi"

cpu: "2"

---

apiVersion: v1

kind: Service

metadata:

name: qa-service

spec:

selector:

app: qa

ports:

- protocol: TCP

port: 80

targetPort: 8000

5.2 监控告警系统

Prometheus监控指标:

from prometheus_client import start_http_server, Summary, Counter

# 定义指标

REQUEST_LATENCY = Summary('request_latency', 'API response latency')

REQUEST_COUNT = Counter('request_count', 'Total API requests')

ERROR_COUNT = Counter('error_count', 'System errors')

@app.before_request

def before_request():

request.start_time = time.time()

@app.after_request

def after_request(response):

latency = time.time() - request.start_time

REQUEST_LATENCY.observe(latency)

REQUEST_COUNT.inc()

if response.status_code >= 500:

ERROR_COUNT.inc()

return response

5.3 数据与模型更新

自动化更新流水线:

graph TB

A[新文档接入] --> B[自动化预处理]

B --> C[增量索引更新]

C --> D[嵌入模型训练]

D --> E[在线AB测试]

E -->|效果提升| F[生产环境部署]

模型热更新实现:

def load_new_model(model_path):

global qa_pipeline

new_pipeline = load_model(model_path)

# 原子切换

with model_lock:

old_pipeline = qa_pipeline

qa_pipeline = new_pipeline

# 清理旧模型

unload_model(old_pipeline)

六、关键问题解决方案

6.1 检索质量优化

问题场景:文档更新导致检索结果过时

解决方案:

# 实时索引更新监听

from watchdog.observers import Observer

from watchdog.events import FileSystemEventHandler

class DocsHandler(FileSystemEventHandler):

def on_modified(self, event):

if event.src_path.endswith('.md'):

update_document_in_index(event.src_path)

observer = Observer()

observer.schedule(DocsHandler(), path='docs/', recursive=True)

observer.start()

6.2 生成一致性保障

问题场景:Llama Factory微调与vLLM部署结果不一致

解决方案:

def align_inference_engines():

# 统一推理配置

vllm_config = {

"tensor_parallel_size": 2,

"dtype": "float16",

"gpu_memory_utilization": 0.9

}

# 量化对齐

if use_quantization:

vllm_config["quantization"] = "awq"

set_quantization_params("awq", bits=4, group_size=128)

# 采样参数标准化

sampling_params = {

"temperature": 0.7,

"top_p": 0.9,

"max_tokens": 256

}

七、总结与演进路线

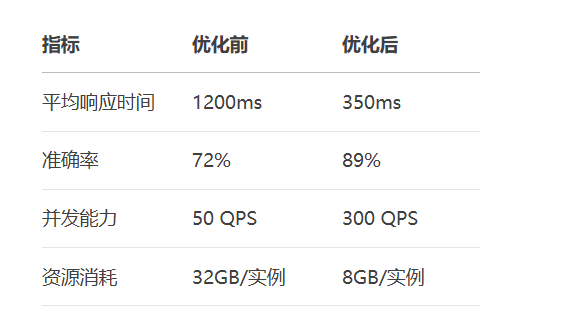

7.1 系统性能指标

7.2 演进路线图

graph LR

A[基础问答系统] --> B[多模态支持]

B --> C[个性化知识图谱]

C --> D[自动化知识发现]

D --> E[预测性智能助手]

注:系统完整实现约需15,000行代码,建议使用LangChain框架加速开发,结合Prometheus+Granfana实现全链路监控。

如果本次分享对你有所帮助,记得告诉身边有需要的朋友,"我们正在经历的不仅是技术迭代,而是认知革命。当人类智慧与机器智能形成共生关系,文明的火种将在新的维度延续。"在这场波澜壮阔的文明跃迁中,主动拥抱AI时代,就是掌握打开新纪元之门的密钥,让每个人都能在智能化的星辰大海中,找到属于自己的航向。

想入门 AI 大模型却找不到清晰方向?备考大厂 AI 岗还在四处搜集零散资料?别再浪费时间啦!2025 年 AI 大模型全套学习资料已整理完毕,从学习路线到面试真题,从工具教程到行业报告,一站式覆盖你的所有需求,现在全部免费分享!

👇👇扫码免费领取全部内容👇👇

一、学习必备:100+本大模型电子书+26 份行业报告 + 600+ 套技术PPT,帮你看透 AI 趋势

想了解大模型的行业动态、商业落地案例?大模型电子书?这份资料帮你站在 “行业高度” 学 AI:

1. 100+本大模型方向电子书

2. 26 份行业研究报告:覆盖多领域实践与趋势

报告包含阿里、DeepSeek 等权威机构发布的核心内容,涵盖:

- 职业趋势:《AI + 职业趋势报告》《中国 AI 人才粮仓模型解析》;

- 商业落地:《生成式 AI 商业落地白皮书》《AI Agent 应用落地技术白皮书》;

- 领域细分:《AGI 在金融领域的应用报告》《AI GC 实践案例集》;

- 行业监测:《2024 年中国大模型季度监测报告》《2025 年中国技术市场发展趋势》。

3. 600+套技术大会 PPT:听行业大咖讲实战

PPT 整理自 2024-2025 年热门技术大会,包含百度、腾讯、字节等企业的一线实践:

- 安全方向:《端侧大模型的安全建设》《大模型驱动安全升级(腾讯代码安全实践)》;

- 产品与创新:《大模型产品如何创新与创收》《AI 时代的新范式:构建 AI 产品》;

- 多模态与 Agent:《Step-Video 开源模型(视频生成进展)》《Agentic RAG 的现在与未来》;

- 工程落地:《从原型到生产:AgentOps 加速字节 AI 应用落地》《智能代码助手 CodeFuse 的架构设计》。

二、求职必看:大厂 AI 岗面试 “弹药库”,300 + 真题 + 107 道面经直接抱走

想冲字节、腾讯、阿里、蔚来等大厂 AI 岗?这份面试资料帮你提前 “押题”,拒绝临场慌!

1. 107 道大厂面经:覆盖 Prompt、RAG、大模型应用工程师等热门岗位

面经整理自 2021-2025 年真实面试场景,包含 TPlink、字节、腾讯、蔚来、虾皮、中兴、科大讯飞、京东等企业的高频考题,每道题都附带思路解析:

2. 102 道 AI 大模型真题:直击大模型核心考点

针对大模型专属考题,从概念到实践全面覆盖,帮你理清底层逻辑:

3. 97 道 LLMs 真题:聚焦大型语言模型高频问题

专门拆解 LLMs 的核心痛点与解决方案,比如让很多人头疼的 “复读机问题”:

三、路线必明: AI 大模型学习路线图,1 张图理清核心内容

刚接触 AI 大模型,不知道该从哪学起?这份「AI大模型 学习路线图」直接帮你划重点,不用再盲目摸索!

路线图涵盖 5 大核心板块,从基础到进阶层层递进:一步步带你从入门到进阶,从理论到实战。

L1阶段:启航篇丨极速破界AI新时代

L1阶段:了解大模型的基础知识,以及大模型在各个行业的应用和分析,学习理解大模型的核心原理、关键技术以及大模型应用场景。

L2阶段:攻坚篇丨RAG开发实战工坊

L2阶段:AI大模型RAG应用开发工程,主要学习RAG检索增强生成:包括Naive RAG、Advanced-RAG以及RAG性能评估,还有GraphRAG在内的多个RAG热门项目的分析。

L3阶段:跃迁篇丨Agent智能体架构设计

L3阶段:大模型Agent应用架构进阶实现,主要学习LangChain、 LIamaIndex框架,也会学习到AutoGPT、 MetaGPT等多Agent系统,打造Agent智能体。

L4阶段:精进篇丨模型微调与私有化部署

L4阶段:大模型的微调和私有化部署,更加深入的探讨Transformer架构,学习大模型的微调技术,利用DeepSpeed、Lamam Factory等工具快速进行模型微调,并通过Ollama、vLLM等推理部署框架,实现模型的快速部署。

L5阶段:专题集丨特训篇 【录播课】

四、资料领取:全套内容免费抱走,学 AI 不用再找第二份

不管你是 0 基础想入门 AI 大模型,还是有基础想冲刺大厂、了解行业趋势,这份资料都能满足你!

现在只需按照提示操作,就能免费领取:

👇👇扫码免费领取全部内容👇👇

2025 年想抓住 AI 大模型的风口?别犹豫,这份免费资料就是你的 “起跑线”!

更多推荐

已为社区贡献116条内容

已为社区贡献116条内容

所有评论(0)