【AI大模型前沿】Jan-v1:基于阿里云Qwen3-4B-Thinking的高性能本地运行AI模型

Jan-v1是基于阿里云Qwen3-4B-Thinking模型微调的深度研究模型,旨在通过优化推理能力和工具使用,为用户提供高效、灵活且隐私安全的AI解决方案。该模型以40亿参数规模实现了91%的SimpleQA准确率,并支持本地运行,降低了硬件门槛和使用成本,同时保障了用户数据的隐私安全。

系列篇章💥

目录

前言

在AI大模型领域,开源模型的发展一直备受关注。近期,一款名为Jan-v1的模型以其独特的本地运行能力和高性能表现引起了广泛讨论。本文将深入探讨Jan-v1模型的背景、功能、技术原理及其应用场景,为AI技术探索者提供全面的参考。

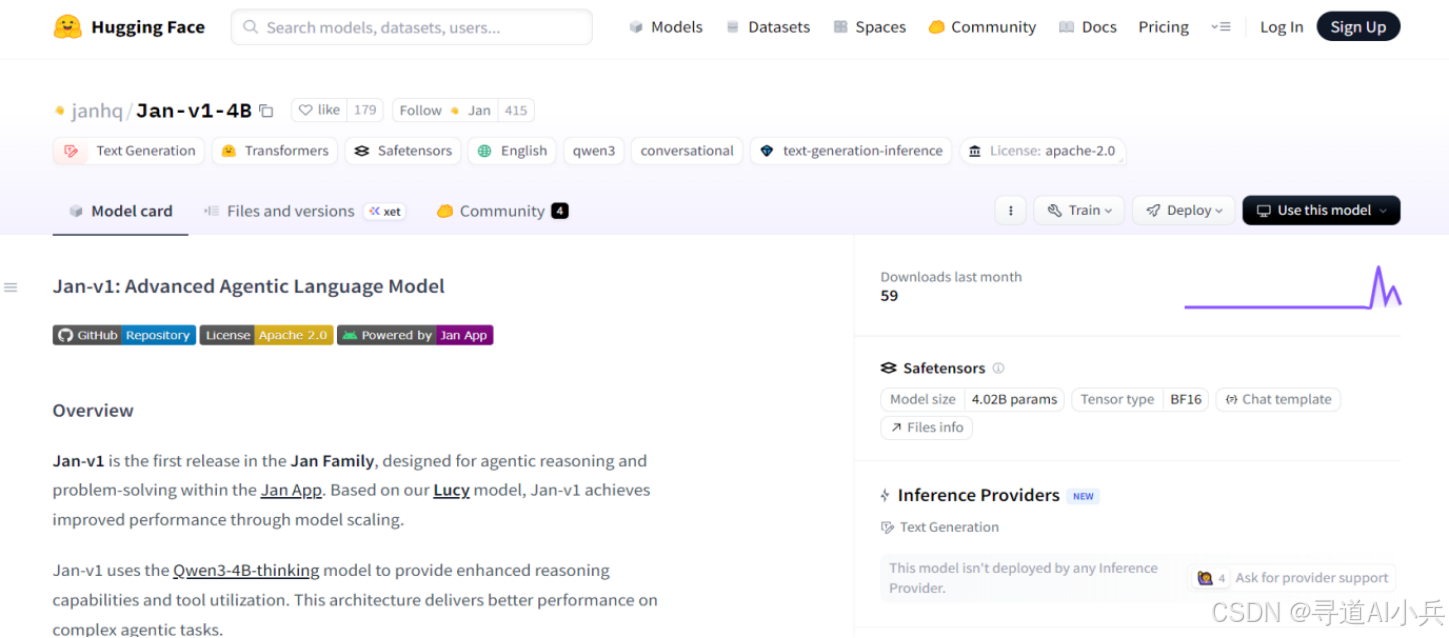

一、项目概述

Jan-v1是基于阿里云Qwen3-4B-Thinking模型微调的深度研究模型,旨在通过优化推理能力和工具使用,为用户提供高效、灵活且隐私安全的AI解决方案。该模型以40亿参数规模实现了91%的SimpleQA准确率,并支持本地运行,降低了硬件门槛和使用成本,同时保障了用户数据的隐私安全。

二、核心功能

(一)本地运行与隐私保护

1、本地运行:Jan-v1能够在本地环境中高效运行,仅需约4GB VRAM即可满足需求,无需依赖云端算力,大大降低了硬件门槛和使用成本。

2、隐私保护:与依赖云端服务的模型不同,Jan-v1确保用户数据在本地处理,避免了网络延迟和服务中断的风险,同时保障了用户数据的隐私安全。

(二)推理与工具使用优化

1、推理能力:Jan-v1在逻辑推理、工具集成以及多步骤任务处理上表现出色,通过专项优化,能够自动生成结构化的推理过程,便于用户验证和理解AI的推理逻辑。

2、工具使用:该模型支持多种工具调用,能够通过各种框架执行外部任务,为复杂的学术研究和实际应用提供了强有力的支持。

(三)长文档处理能力

1、上下文支持:Jan-v1支持长达256K tokens的上下文处理,并可通过先进的YaRN技术扩展至100万tokens,使其在处理长文档分析、复杂学术研究和深度对话场景时表现出色。

2、灵活性:相比依赖云端算力的大型模型,Jan-v1的本地运行特性为用户提供了更大的灵活性,能够根据需求进行定制和优化。

三、技术揭秘

(一)技术基础

1、Qwen3-4B-Thinking模型:Jan-v1的技术基础源自阿里云发布的Qwen3-4B-Thinking模型,该模型采用了独特的双模推理机制,包括思考模式和非思考模式。

2、双模推理机制:思考模式下,Jan-v1能够自动生成结构化的推理过程,并以特定格式呈现,使用户能够轻松验证和理解AI的推理逻辑;非思考模式则提供更高效的推理速度,适用于简单任务。

(二)微调技术

1、多阶段强化学习微调:Jan-v1通过创新的多阶段强化学习微调技术,摆脱了对传统监督微调的依赖,进一步提升了在数学、科学、编码和逻辑推理方面的能力。

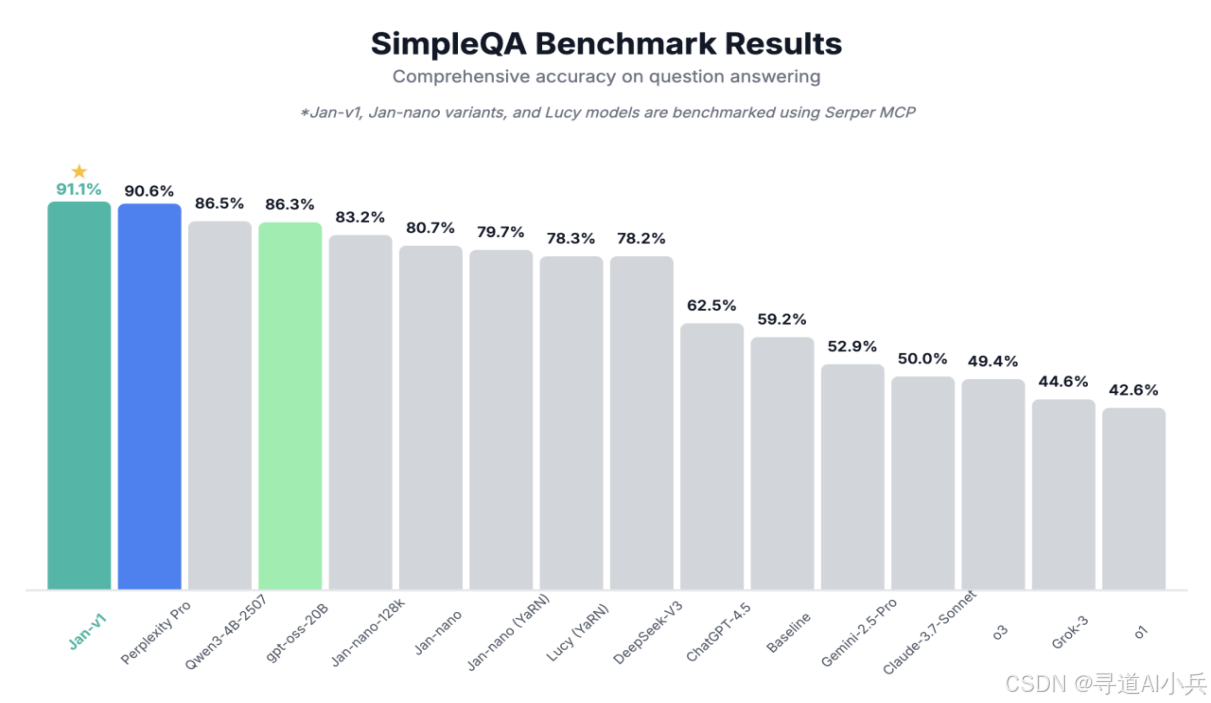

2、性能提升:通过深度微调,Jan-v1在SimpleQA基准测试中取得了91%的准确率,与商业化产品Perplexity Pro不相上下,甚至在某些方面略胜一筹。

(三)部署方式

1、vLLM和llama.cpp:Jan-v1支持vLLM和llama.cpp等多种部署方式,为开发者提供了丰富的集成选项。用户可以根据需求选择适合的部署方式,快速调用模型功能。

2、官方推荐参数:为了确保推理输出的高质量和稳定性,官方推荐的参数设置包括温度0.6、top_p0.95等,开发者可以根据实际需求进行调整。

四、应用场景

(一)深度学术研究

1、复杂问题解答:Jan-v1能够解答复杂的学术问题,生成高质量的代码,为学术研究提供强有力的支持。

2、长文档分析:支持长达256K tokens的上下文处理能力,使其在长文档分析和复杂学术研究中表现出色。

(二)智能工具调用

1、外部工具任务:Jan-v1能够通过各种框架执行外部工具任务,支持多种工具调用,为实际应用提供了灵活的解决方案。

2、多步骤任务处理:在多步骤任务处理上表现出色,能够高效完成复杂的任务链,提升工作效率。

(三)个人开发与研究

1、低资源环境下的高性能:Jan-v1在低资源环境下表现出色,仅需约4GB VRAM即可高效运行,降低了硬件门槛,适合个人开发者使用。

2、开源特性:采用Apache2.0开源许可证,允许开发者自由定制和二次开发,进一步拓展了其应用潜力。

五、性能表现

(一)SimpleQA基准测试

1、准确率:Jan-v1在SimpleQA基准测试中取得了91%的准确率,这一成绩略高于商业化产品Perplexity Pro,显示出其在事实性问答方面的强大能力。

2、性能提升:通过深度微调和模型扩展,Jan-v1在逻辑推理、工具使用和多步骤任务处理方面表现出色,性能提升显著。

(二)上下文处理能力

1、长文档支持:支持长达256K tokens的上下文处理,并可通过YaRN技术扩展至100万tokens,使其在长文档分析和复杂对话场景中表现出色。

2、灵活性:相比依赖云端算力的大型模型,Jan-v1的本地运行特性为用户提供了更大的灵活性,能够根据需求进行定制和优化。

(三)推理速度与稳定性

1、推理速度:Jan-v1在推理速度上表现出色,通过优化的双模推理机制,能够在思考模式和非思考模式之间灵活切换,满足不同场景的需求。

2、稳定性:官方推荐的参数设置确保了推理输出的高质量和稳定性,开发者可以根据实际需求进行调整。

六、快速使用

(一)集成与部署

1、与Jan App集成:Jan-v1优化了与Jan App的集成,用户可以通过简洁的界面快速调用模型功能,实现无缝连接。

2、本地部署实践

- 使用vLLM:

vllm serve janhq/Jan-v1-4B \

--host 0.0.0.0 \

--port 1234 \

--enable-auto-tool-choice \

--tool-call-parser hermes

- 使用llama.cpp:

llama-server --model Jan-v1-4B-Q4_K_M.gguf \

--host 0.0.0.0 \

--port 1234 \

--jinja \

--no-context-shift

(二)推荐参数设置

1、温度(temperature):0.6

2、top_p:0.95

3、top_k:20

4、min_p:0.0

5、max_tokens:2048

七、结语

Jan-v1模型的发布为开源AI领域带来了新的突破。其兼顾性能与隐私的设计理念,以及相对较低的资源需求,为AI技术的普及和应用开辟了新的道路。通过本地运行、推理优化和长文档处理能力,Jan-v1在深度学术研究、智能工具调用和个人开发等领域展现了强大的应用潜力。随着社区的积极参与和工具生态的不断完善,Jan-v1有望在AI研究和实际应用中发挥更大的作用。感兴趣的开发者可以访问以下项目地址,了解更多详情。

Jan-v1项目地址:https://huggingface.co/janhq/Jan-v1-4B

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索(CSDN博客之星|AIGC领域优质创作者)

📖专属社群:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,回复‘入群’ 即刻上车,获取邀请链接。

💘领取三大专属福利:1️⃣免费赠送AI+编程📚500本,2️⃣AI技术教程副业资料1套,3️⃣DeepSeek资料教程1套🔥(限前500人)

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我们,一起携手同行AI的探索之旅,开启智能时代的大门!

更多推荐

已为社区贡献9条内容

已为社区贡献9条内容

所有评论(0)