简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Kairos 3.0 是大晓机器人开发的开源世界基础模型,专注于学习真实世界的动态变化、因果关系和物理规律,并通过长时序视频生成技术实现对世界的理解和预测。其核心创新在于采用线性时间复杂度的 DiT 架构,结合滑动窗口、扩张滑动窗口和门控线性注意力机制,能够高效处理长视频序列,生成复杂且符合物理规律的动态交互场景。

Kairos 3.0 是大晓机器人开发的开源世界基础模型,专注于学习真实世界的动态变化、因果关系和物理规律,并通过长时序视频生成技术实现对世界的理解和预测。其核心创新在于采用线性时间复杂度的 DiT 架构,结合滑动窗口、扩张滑动窗口和门控线性注意力机制,能够高效处理长视频序列,生成复杂且符合物理规律的动态交互场景。

Kairos 3.0 是大晓机器人开发的开源世界基础模型,专注于学习真实世界的动态变化、因果关系和物理规律,并通过长时序视频生成技术实现对世界的理解和预测。其核心创新在于采用线性时间复杂度的 DiT 架构,结合滑动窗口、扩张滑动窗口和门控线性注意力机制,能够高效处理长视频序列,生成复杂且符合物理规律的动态交互场景。

T5Gemma 2 是基于 Gemma 3 架构的下一代编码器 - 解码器模型,首次引入了多模态与长上下文支持。相比前代,它采用共享词嵌入及合并解码器自注意力与交叉注意力机制,有效减少参数量,提供 270M - 270M(约 3.7 亿)、1B - 1B(约 17 亿)和 4B - 4B(约 70 亿)三种规模的紧凑预训练模型,适用于快速实验与终端设备部署。

TRELLIS.2是一个由微软开发的开源图像转3D生成模型,拥有40亿参数。它能够将单张图片高效地转换为高保真的3D资产,支持从512³到1536³的多分辨率输出。该模型的核心创新在于其“场无关”的O-Voxel表示法,能够稳健地处理复杂拓扑结构,如开放表面、非流形几何和内部封闭结构。此外,TRELLIS.2还支持完整的PBR材质建模,生成的3D模型具有丰富的纹理细节和逼真的材质效果。

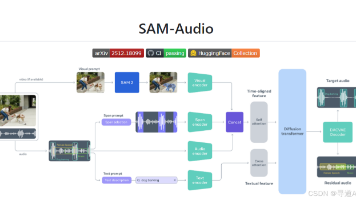

SAM Audio是Meta公司开发的首个统一多模态音频分离模型。它能够通过文本、视觉或时间跨度提示,从复杂的音频混合中分离出任何特定声音。无论是从乐队演奏中提取吉他声,还是从户外视频中过滤掉交通噪音,SAM Audio都能轻松应对。其核心是感知编码器视听(PE-AV)技术,基于大规模多模态对比学习训练而成,为音频处理带来了前所未有的灵活性和高效性。

EvoCUA(Evolving Computer Use Agent)是由美团开源的多模态智能体,专注于计算机操作自动化任务。它通过自然语言指令和屏幕截图,实现对Chrome、Excel、PowerPoint等主流应用的端到端多轮操作,显著提升了AI在真实操作系统环境中的执行能力。在权威的OSWorld评测基准中,EvoCUA以56.7%的任务成功率位居所有开源模型榜首,超越多个业界知名竞品。

TuriX-CUA是一个基于Python开发的开源AI智能体项目,其核心目标是让大语言模型具备操作电脑的能力。它通过“看屏幕-理解-操作”的循环,实现自动化任务执行,支持Windows和MacOS系统,并且可以通过MCP协议与其他AI工具集成,极大地扩展了应用场景。

Supertonic是由Supertone公司开源的一款高性能、极速离线的文本转语音(TTS)系统,专为极致性能和隐私保护而设计。它采用轻量级神经网络架构,仅包含66M参数,生成语音的速度可达167倍实时速度,是目前最快的TTS系统之一。Supertonic完全离线运行,所有处理在本地设备完成,确保隐私和零延迟响应。它支持多种语言,可无缝处理复杂文本,无需预处理,并且高度可配置,适用于多种开发环境

AutoMV是一个无需训练的多智能体系统,能够直接从完整歌曲生成连贯的音乐视频。它通过音乐信息检索提取歌曲的关键特征,如节拍、结构和歌词时间戳,然后由编剧和导演智能体协作生成剧本和拍摄计划,最终通过生成模块和验证模块完成视频制作并确保质量。这一创新的系统不仅实现了从音频和歌词到完整音乐视频的端到端生成,还具备高效、低成本和高质量的特点。