通才机器人策略中的捷径学习:数据集多样性和碎片化的作用

25年8月来自中科大和同济大学的论文“Shortcut Learning in Generalist Robot Policies: The Role of Dataset Diversity and Fragmentation”。在 Open X-Embodiment (OXE) 等大规模数据集上训练的通才机器人策略在各种任务中都表现出色。然而,它们通常难以在其训练数据的分布之外进行泛化。本文研

25年8月来自中科大和同济大学的论文“Shortcut Learning in Generalist Robot Policies: The Role of Dataset Diversity and Fragmentation”。

在 Open X-Embodiment (OXE) 等大规模数据集上训练的通才机器人策略在各种任务中都表现出色。然而,它们通常难以在其训练数据的分布之外进行泛化。本文研究这种有限泛化能力的根本原因。捷径学习——对与任务无关特征的依赖——是泛化的主要障碍。通过全面的理论和实证分析,捷径学习的两个主要因素是:(1) 各个子数据集内的多样性有限,(2) 子数据集之间的显著分布差异导致数据集碎片化。这些问题源于 OXE 等大规模数据集的固有结构,它们通常由在不同环境和具身中独立收集的多个子数据集组成。本文在数据集收集策略的重要见解是,可以减少捷径学习并增强通才机器人策略的泛化能力。此外,在获取新的、大规模数据不切实际的情况下,精心选择的机器人数据增强策略可以有效减少现有离线数据集中的捷径学习,从而提高通才机器人策略(例如 π0)在模拟和现实环境中的泛化能力。

多面手机器人策略。顺应机器学习研究的趋势,多项研究开发机器人基础模型 [6, 12, 13, 15, 43, 44, 14, 45],特别是视觉-语言-动作 (VLA) 模型 [12, 14, 7, 16, 46, 47, 48, 17, 20, 41, 49, 50, 34, 51]。通过在越来越大的机器人数据集上进行预训练 [10, 52, 5, 9, 8, 53, 11],这些模型可以生成多面手机器人策略,这些策略在各种任务中都表现出色,并表现出一定程度的泛化能力 [12, 13]。然而,[18] 的研究表明,在大规模数据集上进行训练并不能显著增强这些策略的泛化能力。具体来说,当前的模型仍然难以推广到许多环境变化,包括视角、语言、物体姿态等。最近的 VLA,例如 π0 [7]、π0.5 [41] 和 Gemini Robotics [17],通过在受控环境中收集多样化的大规模数据集,展示了增强的泛化能力。在这些环境中,某些因素(例如任务、场景类型和具体化)是固定的,而其他因素则是变化的。

神经网络中的捷径学习。众所周知,神经网络会利用虚假相关性进行决策,导致对非稳健特征或混杂因素的捷径学习,这会严重阻碍泛化 [54, 55, 56]。在视觉任务中,神经网络已被观察到依赖于多种与任务无关的因素,包括图像背景 [57, 58, 59, 60]、次要物体 [61, 62, 63, 64, 65, 66]、物体纹理 [67] 以及其他混杂因素 [68, 69]。在语言领域,最近的研究表明,大型语言模型倾向于利用数据集偏差作为捷径,在各种下游任务中进行预测 [70, 71, 72, 73]。最近的研究提出新的方法来缓解泛化机器人策略中的捷径学习问题,方法是修改训练数据 [84] 或采用无需训练的方法 [85]。 最近的研究也将信息论概念应用于机器人技术。例如,Hejna [86] 使用互信息估计器来评估单个演示轨迹的质量,以便进行数据管理,重点关注轨迹内部属性,例如动作多样性和可预测性。此外,Bai [87] 在训练过程中将信息瓶颈原理作为一种正则化技术,以减轻模型潜在表示中的冗余。近期研究越来越认识到数据质量在模仿学习中的关键作用,其影响已超越数据集大小等简单的启发式方法。例如,Belkhale [88] 从分布偏移的角度为数据质量提供了一种形式化方法,指出动作散度和转换多样性等关键的轨迹内属性对策略性能至关重要。Hejna [89] 在整个数据集层面上进行操作,解决了构建大规模异构数据混合的挑战。他们的方法 Re-Mix 使用分布稳健的优化来学习不同数据域的最优采样权重,这表明训练数据的组成对最终策略的泛化能力有着巨大的影响。最近的一项研究 [90] 也以组合的方式研究跨因素的泛化,类似于本文研究的设置。

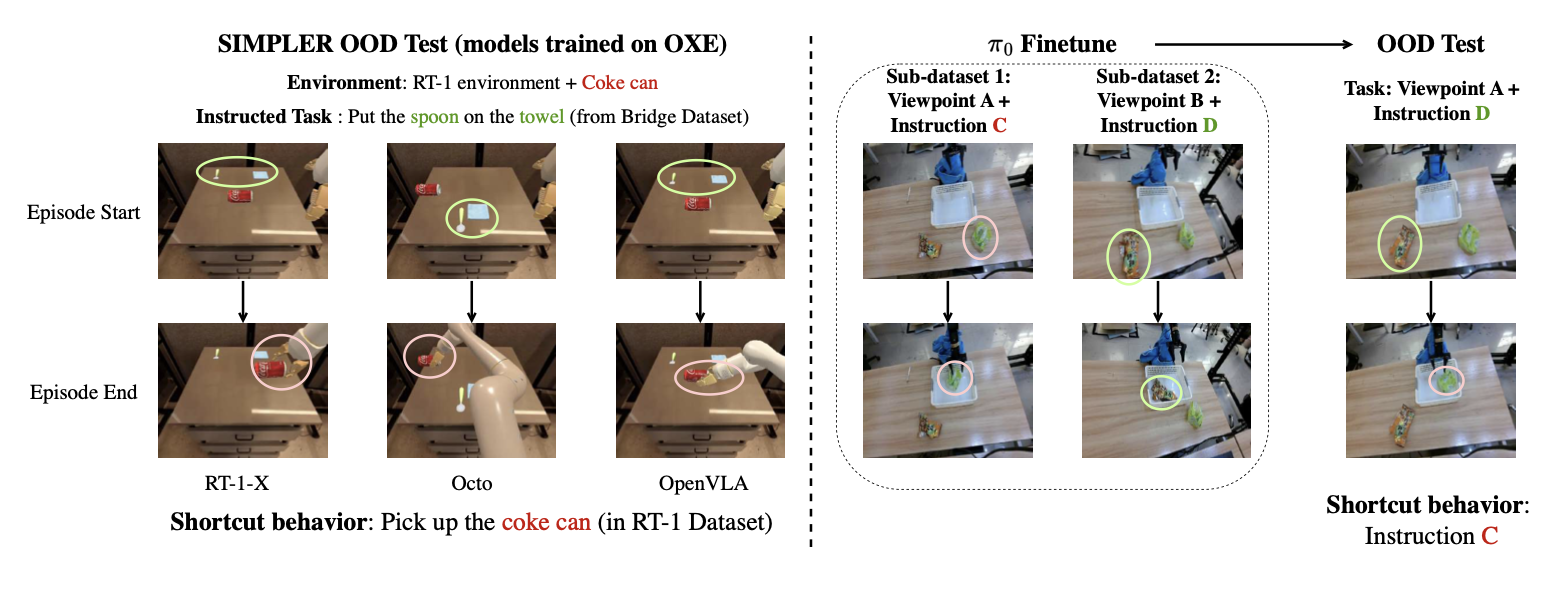

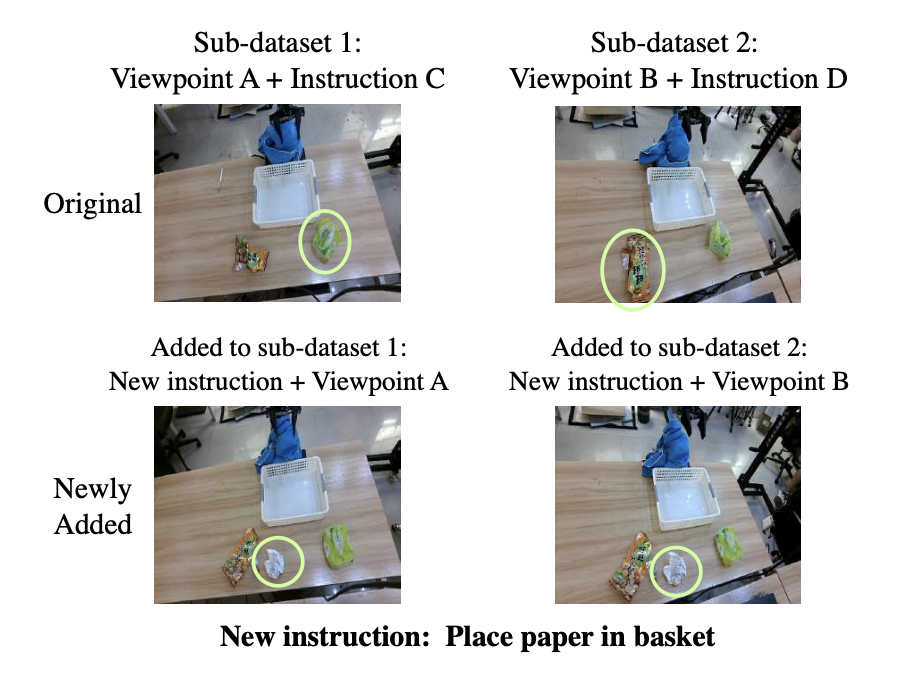

如图所示通才机器人策略中的捷径学习演示。左图:在 OXE 数据集上训练的三个通用机器人策略在 SIMPLER 环境中表现出捷径行为 [4]。尽管所有模型的任务是“将勺子放在毛巾上”(Bridge 子数据集 [5] 中存在该任务),但它们都一致地执行 RT-1 子数据集 [6] 独有的“拿起可乐”任务。右图:π0 [7] 策略在对真实数据进行微调后表现出捷径行为。该策略在两个不同的数据子集上进行微调:(视点 A,指令 C)和(视点 B,指令 D)。当从视点 A 的新配置中执行指令 D 时,该策略错误地执行指令 C。这表明该策略已经学会将视点与动作关联起来,从而忽略提供的指令。

机器人数据集多样性及碎片化分析

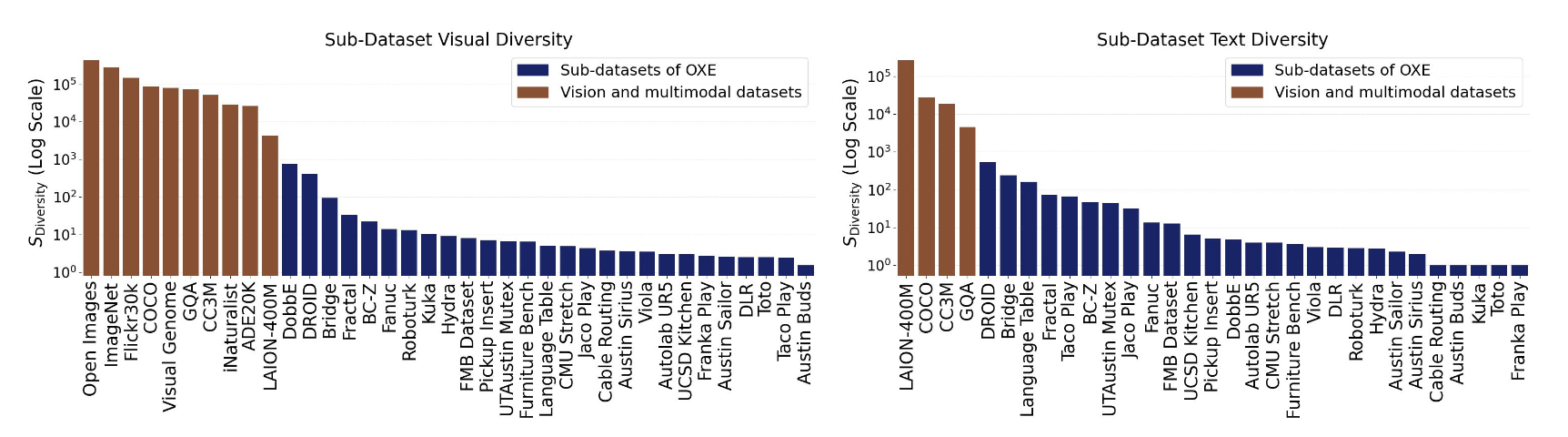

OXE 数据集 [10],是用于通用机器人策略预训练的最大的开源机器人数据集 [10, 13, 14, 7, 16, 20]。具体来说,重点关注 OXE Magic Soup++ [13],它包含 27 个来自 OXE 的子数据集,这些子数据集经过精心挑选以确保高质量,并已在多个模型中使用 [13, 14, 7, 16]。当前用于大规模预训练的机器人数据集,同样由多样化的子数据集组成 [15, 21, 22, 20]。

由于大多数通用机器人策略使用视觉观察和语言指令来制定动作,利用数据集的视觉和语言特征来衡量子数据集内部的多样性及其之间的差异性,这也与[18]的建议一致。对于视觉特征,用预训练的DINOv2 [23]和SigLIP [24]的特征串联,因为它们被证明可以提供关于图像的互补信息[25, 26]。仅关注每个情节的初始视觉观察,因为后续帧通常表现出最小的变化。语言特征使用CLIP [27]提取,因为它具有强大的视觉-语言对齐功能。

大规模机器人数据集在各个子数据集内表现出有限的多样性。如图所示,OXE 中所有子数据集的视觉和文本多样性明显低于视觉和多模态数据集。即使是旨在提高多样性的最新数据集 DROID [9],其多样性仍然明显低几个数量级。子数据集内这种有限的多样性主要源于机器人数据集收集过程中的内在限制。场景和视点等因素很难在不同事件之间发生显著变化,导致与基于 Web 的视觉语言数据集相比缺乏可移植性。另一个原因是,机器人技能是预定义的,将它们限制在狭窄的任务范围内。

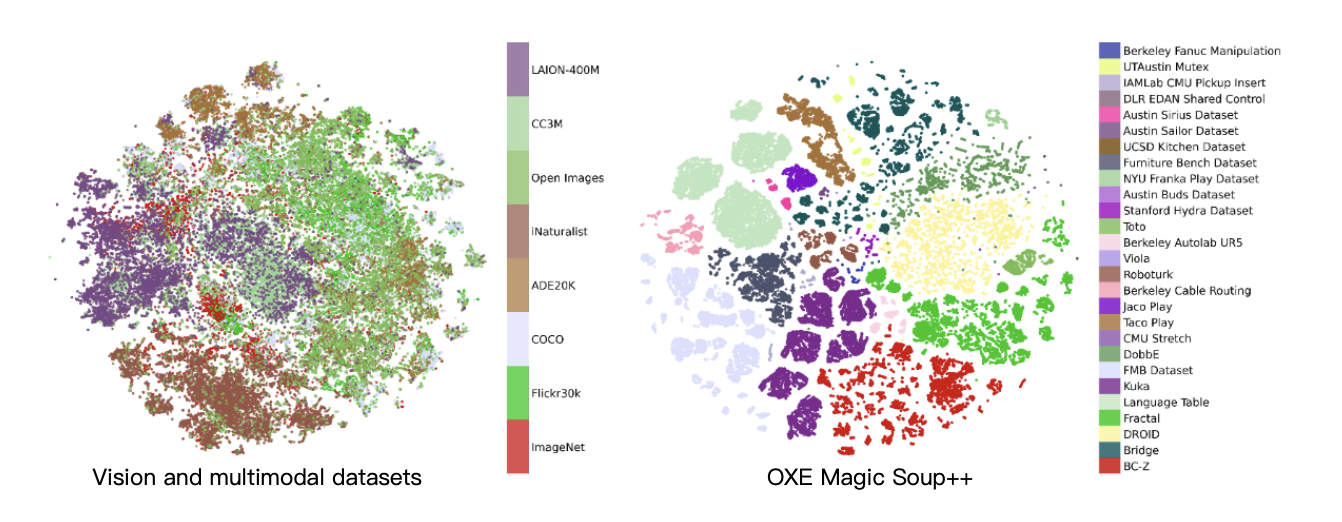

大规模机器人数据集分散在各个子数据集中。如图展示使用 t-SNE 对视觉特征进行可视化的效果。与视觉和多模态数据集(其中不同的数据集通常相互交织)不同,OXE 的子数据集表现出明显的分离性,重叠性极小。此外,一些子数据集包含多个独立的簇,从而有效地将整个数据集分割成更多规模较小的子数据集。

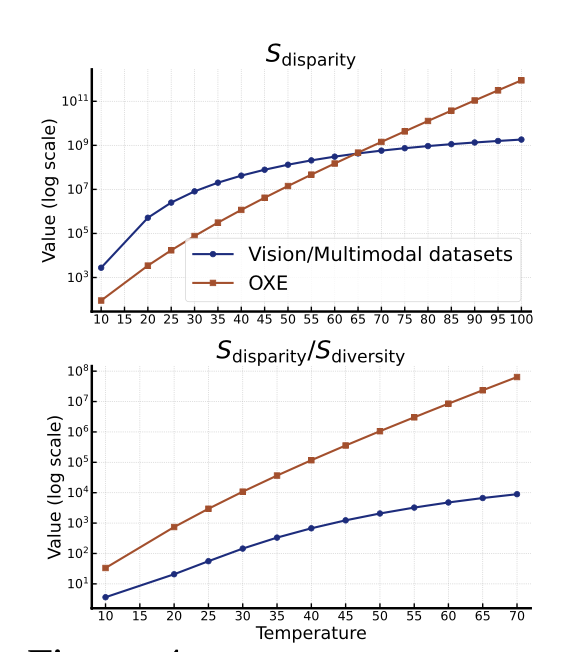

如下图顶部图展示 OXE 的视差度量 S_disparity。值得注意的是,它在较高温度下高于视觉/多模态数据集,而在较低温度下则较低。这种特性是机器人数据集的典型特征:来自不同 OXE 子数据集的数据点之间的距离集中在特定范围内。相反,来自不同视觉和多模态数据集的数据点之间的距离更加分散。造成这种模式的关键因素有两个:

(1)机器人场景通常局限于有限的室内桌面区域,这限制了最大可能距离,导致整体相似度较高,从而降低;

(2)跨子数据集的数据碎片化会阻止距离低于某个阈值,从而建立一个下限,当在较高温度下仅考虑相近的数据点时,这会导致更高的视差。

如上图底部图显示 S_disparity/S_diversity 比率,该比率整合多样性和视差指标,以评估数据集的碎片化程度。子数据集内部多样性的缺乏以及它们之间的视差的增加,都会导致子数据集表现得像散布在空间中的孤立“点”,而不是形成一个有凝聚力、相互关联的数据集。

不同子数据集的任务指令各不相同,但又相似。尽管不同子数据集之间的任务指令缺乏重叠,但与视觉和多模态数据集相比,不同子数据集的文本特征在空间上更接近。这种相似性源于机器人共享的技能,例如拾取放置和打开/关闭任务,以及同一域内文本指令的一致性。

捷径学习

在标准监督学习或模仿学习框架中,考虑观测和目标随机变量,分别表示为 x 和 y,其条件概率分布为 p(y|x)。目标是使用模型 π_θ(y|x) 来学习该分布,该模型基于从训练分布中采样的训练数据集 {x_i,y_i},其中 x ∼ p_train(x) 和 y ∼ p(y|x)。按照 [29] 中的方法,假设观测 x 由多个“观测因素”[c_1, c_2, …, c_d] 生成。例如,在操作任务中,这些因素可能包括图像背景、物体类型、物体位置、机械臂类型、语言指令等。将 u 定义为对标签 y 有因果影响的任务相关因素集合,将 v 定义为所有其他与任务无关的因素集合。形式上,真实概率满足 p(y|x = g(u, v)]) = p(y|u) 和 p(y, v) = p(y)p(v),其中 g 是因子生成模型。

捷径学习的特点是学习到的模型 π_θ 依赖于不相关的因子 v,或者等效地,π_θ(y|x) ̸= π_θ(y|u)。当在训练分布中,与任务相关的因子 u 和与任务无关的因子 v 不是独立的,即 p_train(u,v) ̸= p_train(u)p_train(v) 时,就会出现捷径学习。由于 u 和 y 之间的因果关系,v 和 y 变得相关,导致 v 和 y 之间出现虚假的相关性。因此,模型 π_θ 可能会无意中从这些虚假相关性中学习,导致 v 中的因子进行捷径学习,从而对模型在分布外数据上的性能产生不利影响。

机器人数据捷径学习背后的原因

首先建立一个数学框架来分析由多个不同子数据集组成的数据集中相关性是如何产生的。考虑一个数据集 D,其特征是两个随机变量 u ∼ p_u(u) 和 v ∼ p_v(v),其支持集 U, V ⊂ R。将 D 建模为 m 个子数据集 {D_1, D_2, …, D_m} 的混合,其中每个子数据集 D_i 都有各自的分布 u_i ∼ p_u_i (u_i) 和 v_i ∼ p_v_i (v_i),其支持集分别为 U_i 和 V_i。因此,整体支持集为 U = ∪ U_i 和 V = ∪ V_i。

为了简化分析,做出以下假设:

- 数据集内独立性:在任意给定的子数据集 D_i 中,变量 u_i 和 v_i 相互独立。

- 均匀混合:整体数据集 D 是各子数据集的均匀混合。

第一个假设近似成立,因为每个子数据集都是在受控条件下收集的,从而最大限度地减少因子间依赖关系的引入。为了量化整个数据集 D 中 u 和 v 之间的相关性,用归一化互信息,其中 I(u, v) 是标准互信息,H(·) 是香农熵;为简单起见,以下命题针对 m = 2 个子数据集的情况提出。

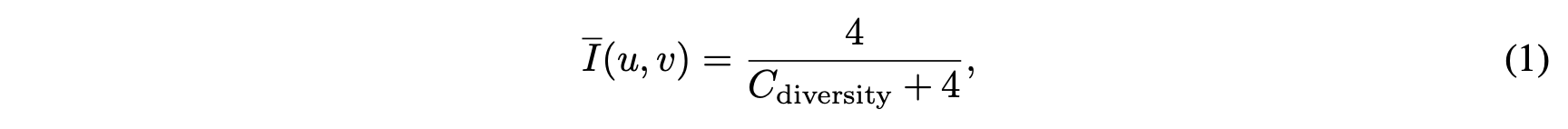

命题 1(不相交集中的互信息)。给定两个子数据集,其中两个变量的支持集不相交,即 U_1 ∩ U_2 = ∅ 和 V_1 ∩ V_2 = ∅,则 u 和 v 之间的归一化互信息为:

其中 C_diversity = H(u_1) + H(u_2) + H(v_1) + H(v_2) 是每个子数据集内熵的总和。

命题 2(重叠集中的互信息)。给定两个具有潜重叠支持集的子数据集,令 U_12 = U_1 ∩ U_2 和 V_12 = V_1 ∩ V_2。归一化互信息的范围为:

其中 C_interleave = P_u∈U_12 [p_u_1 (u) + p_u_2 (u)] + P_v∈V12 [p_v_1 (v) + p_v_2 (v)] 量化了子数据集之间的重叠(交错)程度。

假设上述数学框架能够解释捷径学习如何从大规模机器人数据集的结构特性中产生。核心假设是,模型利用的虚假相关性是数据集碎片化和数据集内缺乏多样性的直接结果。通过以下假设将数学命题与这一现实现象联系起来:

• 将机器人数据集中与任务相关的因素(例如,物体位置、语言指令)和与任务无关的因素(例如,视点、背景)分别建模为变量 u 和 v。

• 假设像 OXE 这样由许多独立收集的子数据集组成的大型数据集可以用混合模型来近似。这些子数据集内部的低多样性以及它们之间的显著差异,与命题的低熵和不相交/低重叠条件相对应。

在此假设下,数学结果为核心主张提供形式基础:

缺乏多样性会强化虚假相关性。命题 1 从数学上证明这一直觉。它表明,当子数据集高度碎片化(不相交的支持集)时,互信息(用来衡量虚假相关性的指标)与 C_diversity(用来衡量子数据集内总体多样性的指标)成反比。在这样的数据集上训练的机器人模型可以轻松学会将与任务无关的因素(例如特定的观点)与特定的子数据集关联起来,从而揭示与任务相关的因素的信息,从而创建一条捷径。

交错子数据集会削弱虚假相关性。命题 2 为这一论断提供理论支持。它表明,随着交错程度(Cinterleave)的增加,互信息的上界会收紧并趋向于零。直观地讲,当子数据集共享共同因素(例如,同一个物体从多个视角出现)时,模型就无法使用这些因素作为可靠的捷径来识别来源子数据集,从而迫使其学习真正的因果关系。

非重叠子数据集之间的差异对捷径学习的影响。虽然命题 2 阐明子数据集交集如何影响捷径学习,但非重叠子数据集之间距离的影响仍然不太清楚。OXE 数据集在子数据集之间表现出视觉和文本特征的最小交错,但文本特征距离 (u) 明显小于视觉距离 (v)。假设与任务无关的特征在子数据集中的距离越大,越会加剧捷径学习。这源于两个关键的观察结果:(1) 神经网络优先学习更简单的模式 [30, 31];(2) 特征距离越大意味着方差越大。当与任务无关的特征的子数据集间距离明显大于与任务相关的特征时,模型会优先学习这些方差较大的特征,从而形成捷径。在 OXE 中,这解释模型倾向于依赖视觉提示而不是文本指令。

LIBERO 上的实验验证

LIBERO 基准 [32] 以 Franka Emika Panda 机械臂为模拟目标,演示内容包括相机图像、语言指令和末端执行器姿态变化动作。

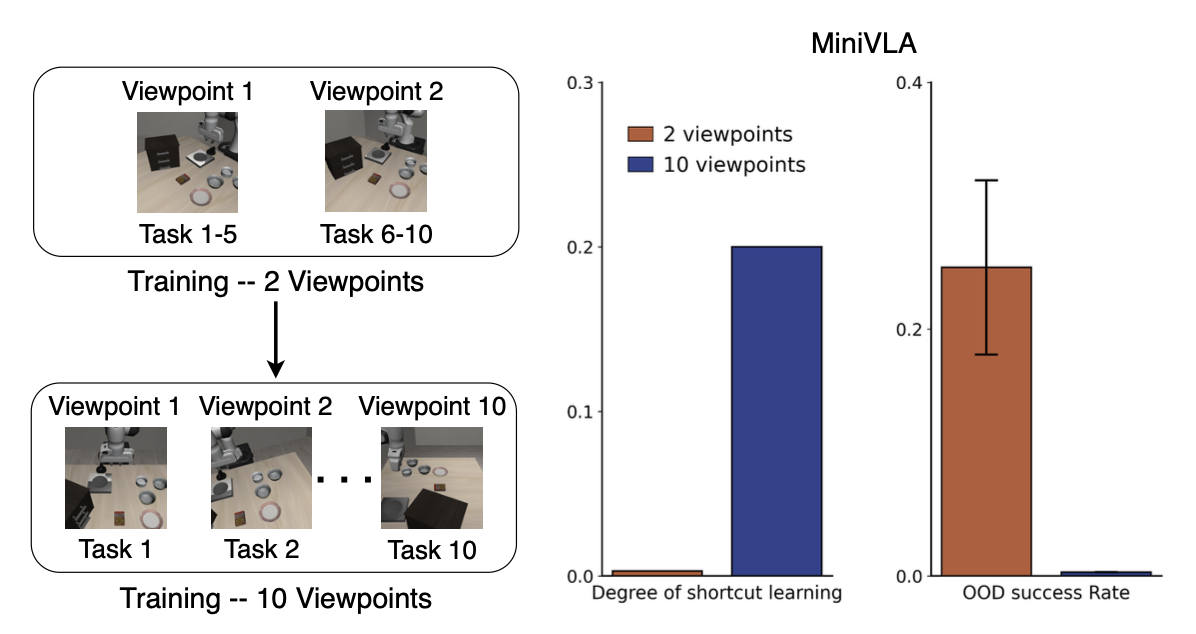

任务设置。为了通过实证验证本文理论主张,即较低的数据集内多样性和较高的数据集间差异性有助于捷径学习,在 LIBERO-Spatial 任务套件上进行受控实验。在此设置中,将任务相关因子 (u) 定义为物体的位置和相应的语言指令。相机视点作为主要的与任务无关的因子 (v),这与在 OXE 等大规模机器人数据集中观察到的跨子数据集的显著视点变化相呼应。

训练和评估方案。对于每个实验,构建一个由两个不同的子数据集 D_A 和 D_B 组成的训练数据集。每个子数据集的生成都旨在在与任务无关的视点和与任务相关的位置之间建立强烈的伪相关性。例如,D_A 中的演示仅将特定范围的视点(视点范围 A)与特定的一组物体位置(位置集 A)配对,而 D_B 中的演示则将视点范围 B 与位置集 B 配对。该模型基于 D_A 和 D_B 的组合进行训练。为了量化捷径学习,在分布外 (OOD) 配置上评估训练后的策略,其中学习的伪相关性被打破。具体而言,评估包含两种受控设置:(1) 使用来自 B 集但视点在范围 A 内的物体位置向模型分配任务;(2) 反向配对(来自 A 集的位置,来自 B 集的视点)。依赖视点捷径的模型将会失败,因为它会错误地将视点与训练时的位置关联起来,从而忽略实际的物体位置和指令。

实验变量和指标。系统地改变训练数据的属性,以分析其影响。视点多样性是指每个子数据集内视点范围的半径,而视点视差是指两个视点范围中心之间的距离。为了研究任务相关多样性和视差的影响,改变了每个子数据集中的目标位置数量(从 1 到 5)及其空间布局(交织与分离)。性能通过两个关键指标衡量:(1) OOD 成功率,取两种 OOD 设置的平均数,直接衡量泛化能力;(2) 捷径学习程度,这是一个人工评估的分数,用于量化模型基于不相关视点线索执行错误任务的倾向(分数越低越好)。为了确保公平比较,对于给定的模型,OOD 评估视点在每个实验组中保持一致(例如,一个图中的一条曲线),会改变数据多样性或视差。

模型。评估三种模型:(1)扩散策略 [33],一种纯视觉策略,不包含语言输入,采用 ResNet-18 架构;(2)MiniVLA [34],一种与 OpenVLA [14] 具有相同自回归结构的 VLA,但参数数量少于 10 亿;(3)π0 [7],一种采用流匹配目标函数的强 VLA,已在大规模机器人数据集上进行预训练。扩散策略和 MiniVLA 均从零开始训练,而用 LoRA 从预训练的检查点对 π0 进行微调,以探究在大规模机器人数据集上预训练的强大模型是否仍然容易受到捷径学习的影响。

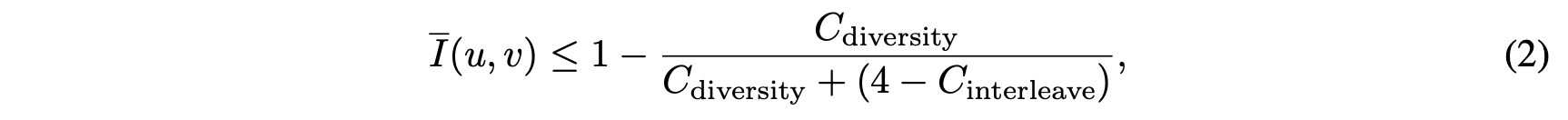

多样性并非总是有益。之前的分析表明,增加多样性通常可以减轻捷径学习的影响,因为它可以减少子数据集之间的碎片化。然而,这些结果是在假设子数据集内因子相互独立的情况下获得的。并非所有形式的多样性都能提高泛化能力。当多样性破坏子数据集内的因子独立性时(例如,OXE 的某些子数据集),碎片化现象会加剧。如图所示,将视角多样性从 2 增加到 10(同时为各个任务分配不同的视角)会引入捷径,并使 MiniVLA 的 OOD 成功率降至零(基于相同的位置和视角进行评估以确保公平性)。此处,视角多样性将原始子数据集分割成 10 个不相交的子集,加剧碎片化现象。这强调控制多样性的必要性,以便在数据收集过程中保持因子独立性并避免子数据集碎片化。

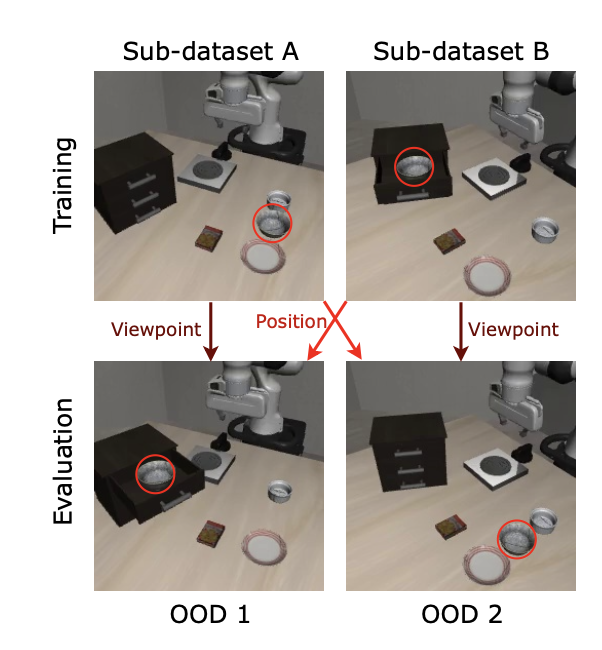

真实世界实验验证

为了在物理环境中验证理论结论,进行一项真实世界实验。使用 AgileX PIPER 机械臂和两个位于不同视点的摄像头。首先,构建两个不同的子数据集。每个子数据集代表一个摄像头视点(与任务无关的因素)和一个目标物体及其对应指令(与任务相关的因素)的独特组合。在这两个高度相关的子数据集上进行微调的 π0 模型表现出严重的捷径学习;它学会将视点与动作关联起来,而忽略语言指令。实验如图所示:

为了研究如何通过增加子数据集的多样性和减少数据集间的差异来缓解这个问题,引入新数据。具体来说,添加涉及第三个目标物体的演示,该目标物体从两个摄像头视点拍摄(如图底部所示)。这些新数据充当了原始两个子数据集之间的“桥梁”。通过这种方式,同时增加每个子数据集内的指令多样性,并减少它们之间的差异,因为它们现在共享一个共同的指令因子。

鉴于从头开始收集大规模、完美平衡的机器人数据集通常成本高昂,一个切实可行的替代方案是改进现有的离线数据集。

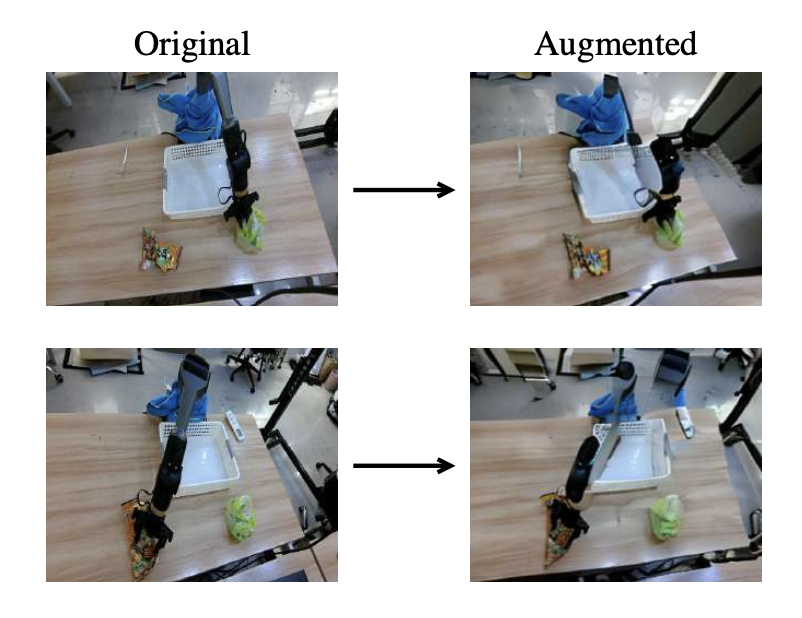

视点增强弥合视觉差距

摄像机视点与特定任务之间的虚假相关性是捷径学习的常见原因。为了解决这个问题,探索视点增强方法的使用[35, 36]。在 π0 微调实验中,从另一个子数据集的视角生成图像来合成扩展每个子数据集。具体来说,采用ZeroNVS 模型[37]将每个图像的视点 A 增强到视点 B,反之亦然,如图所示。此过程有效地打破了视点因素在子数据集之间的碎片化。表 1 的结果证明,使用视点增强数据进行微调显著降低了 π0 中的捷径学习程度,并提高了 OOD 成功率。

目标增强以统一任务分布

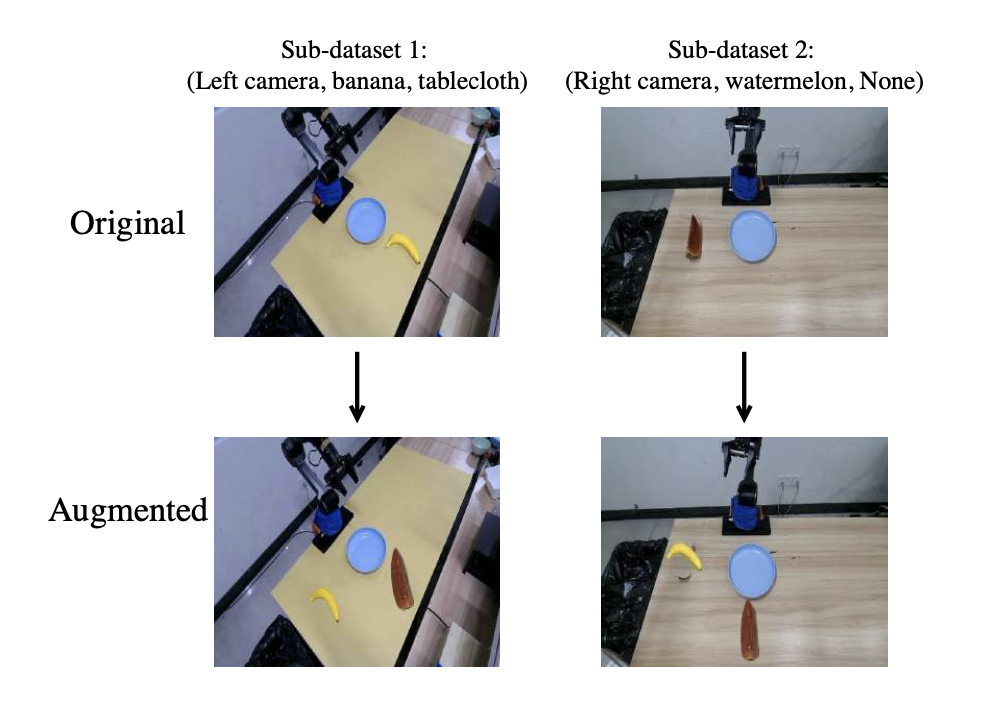

当子数据集围绕不同的目标对象组织时,对象增强技术 [38, 8, 39] 提供了一种强大的解决方案。通过以编程方式在图像之间交换目标,可以将目标分布和语言分布交织在一起,从而减少子数据集之间的差异。

在 SIMPLER 模拟环境 [4](提供 Bridge 和 RT-1 数据集的真实版本)和实际实验(如图所示)中验证这种方法。对于 SIMPLER 实验,遵循 [18] 的方法,通过在 SIMPLER 内部收集的离线数据集上微调预训练的 π0 模型来隔离真实与模拟之间的差距。该数据集包含来自预训练模型的成功轨迹。由于在不同条件(例如,具体实施方式、背景)下实现精确的物体分割和修复的复杂性,分析重点在于减少捷径行为,而非任务成功率。

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)