四:深入探索 Dify|应用类型全解析:Chatbot、Agent、Workflow、Completion

Dify是一个完整的AI应用开发平台,提供四大核心功能模块:1)Chatbot、Agent、Workflow和Completion四种应用类型,满足不同AI交互场景需求;2)可视化Prompt编排工具,支持变量、上下文管理、知识库引用和实时调试;3)多模型管理能力,兼容OpenAI、通义千问等主流模型,支持API Key配置和A/B测试。平台通过标准化组件封装大模型能力,使开发者无需编码即可构建智

🧩 Dify 核心功能概览:从应用类型到模型管理,全面掌握平台能力

在成功部署 Dify 之后,接下来最重要的一步是:理解它的核心功能体系。

Dify 不只是一个“Prompt 编辑器”,而是一个完整的 AI 应用开发平台(AI Application Platform),它将大模型的复杂能力封装成可视化、可编排、可发布的标准化组件。

本文将带你系统梳理 Dify 的三大核心模块:

- ✅ 四大应用类型:Chatbot、Agent、Workflow、Completion

- ✅ Prompt 编排界面详解:变量、上下文、调试技巧

- ✅ 模型管理与 API Key 配置:支持 OpenAI、通义千问、Azure 等主流模型

无论你是想构建智能客服、自动化助手,还是企业级知识问答系统,这篇文章都将成为你使用 Dify 的“功能地图”。

一、Dify 的四大应用类型

Dify 支持四种主要的应用模式,每种对应不同的 AI 使用场景和交互逻辑。

1. Chatbot(聊天机器人)

🎯 适用场景:问答助手、智能客服、产品导购

特点:

- 基于对话历史进行上下文理解

- 支持多轮对话管理

- 可接入知识库实现 RAG 增强回答

- 提供 Web Embed、API、SDK 多种发布方式

典型用途:

- 企业 FAQ 自动回复

- 产品使用指南机器人

- 内部员工知识查询助手

💡 小贴士:这是最常用的应用类型,适合 80% 的对话类需求。

2. Agent(智能体)

🎯 适用场景:自主决策、任务执行、工具调用

特点:

- 具备“思考+行动”能力(ReAct 模式)

- 支持 Tool Calling:调用外部 API、数据库、脚本等

- 能够进行多步推理、自我反思、循环尝试

- 可配置“规划策略”(Planning Strategy)

典型用途:

- 自动化数据查询 Agent(如:“查一下上个月销售额”)

- 社交媒体内容生成 Agent(写文案 → 发微博)

- 客户工单处理 Agent(识别意图 → 创建工单 → 发送通知)

🔍 关键能力:不是被动回答问题,而是主动解决问题

3. Workflow(工作流)

🎯 适用场景:复杂业务流程编排、条件判断、多节点协作

特点:

- 可视化拖拽式流程设计(类似低代码平台)

- 支持多种节点类型:

- LLM 节点(调用大模型)

- 工具节点(调用函数或 API)

- 条件分支(If/Else)

- HTTP 请求

- 代码执行(Python/JS)

- 知识检索

- 支持循环、变量传递、错误处理

典型用途:

- 用户咨询 → 意图识别 → 分流处理 → 生成报告

- 文章生成流程:标题建议 → 正文撰写 → 润色 → 输出 Markdown

- 表单填写自动化:自然语言输入 → 结构化解析 → 存入数据库

🧩 类比:LangChain + Zapier + Airtable 的融合体

4. Completion(补全应用)

🎯 适用场景:单次生成任务、结构化输出、模板填充

特点:

- 不维护对话历史,每次请求独立处理

- 强调输出格式控制(JSON、YAML、XML 等)

- 适合与前端表单结合使用

- 支持“变量输入”和“默认值”

典型用途:

- 自动生成邮件草稿

- 根据关键词生成 SEO 标题

- 表格数据补全(如:输入商品名 → 输出描述+标签)

📌 优势:轻量、高效、易于集成到现有系统中

二、Prompt 编排界面详解

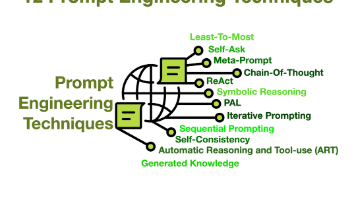

Prompt 是 Dify 的“灵魂”。平台提供了强大的可视化 Prompt 编辑器,让开发者无需手写代码即可完成复杂提示工程。

🖼️ 界面布局概览

进入任意应用的“编辑”页面,你会看到如下区域:

| 区域 | 功能说明 |

|---|---|

| 左侧栏 | 变量列表、上下文管理、知识库引用 |

| 中央编辑区 | 主 Prompt 编辑区域(支持富文本 + Markdown) |

| 右侧配置面板 | 模型参数(temperature、max_tokens)、输入输出设置 |

| 底部调试区 | 实时测试 Prompt 效果,查看 LLM 返回结果 |

🔧 核心功能详解

1. 变量(Variables)

允许用户在运行时动态传入参数。

语法:{{variable_name}}

例如:

请根据以下背景信息撰写一封邮件:

收件人:{{recipient}}

主题:{{subject}}

内容要点:{{points}}

✅ 在前端调用时,只需传入

{"recipient": "张经理", "subject": "项目进度汇报", "points": "..."}即可自动填充。

2. 上下文管理(Context)

控制 LLM 能“看到”的信息范围:

- 系统提示词(System Prompt):设定角色与风格(如“你是一个专业的法律顾问”)

- 历史消息(History):启用后支持多轮对话

- 上下文长度限制:防止超出模型 token 上限

💡 提示:合理设置上下文窗口可提升响应质量并降低成本。

3. 知识库引用(Retrieval)

在 Prompt 中插入知识库检索结果:

参考以下知识库内容回答问题:

<context>

{{retrieved_content}}

</context>

问题:{{query}}

✅ 平台会自动从知识库中检索最相关的片段,并注入此处,实现 RAG(检索增强生成)。

4. 调试与预览功能

- 点击“试运行”按钮,输入测试参数

- 查看实际发送给 LLM 的完整 Prompt

- 观察返回结果是否符合预期

- 支持流式输出预览(Streaming)

🛠️ 推荐做法:每次修改 Prompt 后都要进行至少 3 次测试,确保稳定性。

三、模型管理与 API Key 配置

Dify 的一大优势是 支持多模型厂商自由切换,你可以在同一个平台中对比不同模型的表现。

🌐 支持的模型提供商(Model Providers)

| 模型厂商 | 支持情况 | 说明 |

|---|---|---|

| OpenAI | ✅ 完全支持 | GPT-3.5, GPT-4, GPT-4o |

| Anthropic | ✅ 支持 Claude 系列 | Claude 3 Haiku/Sonnet/Opus |

| 阿里云·通义千问 | ✅ 国产模型首选 | qwen-max, qwen-plus, qwen-turbo |

| Azure OpenAI | ✅ 企业级部署必备 | 支持私有化接入 |

| Google Gemini | ✅ 支持 gemini-pro | |

| Mistral AI | ✅ 支持 mistral-large | |

| Ollama(本地模型) | ✅ 支持自建模型 | 可接入本地运行的 Llama 3、Qwen 等 |

| Hugging Face | ✅ 支持 API 接入 | 自定义模型部署 |

⚙️ 如何配置 API Key?

步骤 1:进入模型管理页面

路径:控制台 → 模型管理 → 添加模型提供商

步骤 2:选择模型类型并填写凭证

以 硅基流动 为例:

- 选择“硅基流动”

- 输入 API Key(可在 https://cloud.siliconflow.cn/me/account/ak 获取)

- 保存

OpenAI:

- 选择“OpenAI”

- 输入 API Key(可在 https://platform.openai.com/api-keys 获取) 需要魔法

- 保存

💡 高级技巧:多模型 A/B 测试

你可以为同一应用配置多个模型,在不同用户间做灰度测试:

- 用户 A → 调用 GPT-4o

- 用户 B → 调用 通义千问 max

通过对比响应质量、延迟、成本,选择最优模型组合。

✅ 总结:Dify 功能全景图

| 模块 | 核心能力 | 适用人群 |

|---|---|---|

| 应用类型 | Chatbot / Agent / Workflow / Completion | 全体用户 |

| Prompt 编排 | 变量、上下文、知识注入、调试 | 开发者、产品经理 |

| 模型管理 | 多厂商支持、API Key 管理、A/B 测试 | 运维、AI 工程师 |

Dify 的设计理念是:让 AI 应用开发像搭积木一样简单。

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)