AI新智力 | 大模型入门12:MCP协议

MCP协议是由Anthropic推出的开源标准,旨在解决大模型与外部数据源和工具的交互标准化问题。该协议通过统一接口、安全双向通信和模块化扩展,有效缓解了大模型知识更新滞后和N×M适配难题。MCP采用客户端-服务器架构,支持本地和远程连接,已形成快速发展的生态系统。但该协议存在对华技术限制、本土适配不足等问题,文章呼吁国内厂商应尽快研发自主知识产权的AI协议栈,避免在基础协议领域受制于人。目前MC

本文来源公众号“AI新智力”,仅用于学术分享,侵权删,干货满满。

原文链接:大模型入门12:MCP协议

“MCP是Anthropic推出的开源协议,用于大模型和外部数据源之间的连接和通信,有望成为AI领域的HTTP协议或者USB 接口。但是笔者更希望尽快制定出我们自主知识产权的中国版MCP协议,建设形成我们主导的【AI协议栈】。”

MCP协议的作用

在MCP出现之前存在两个问题:

大模型知识更新问题:在前文AI新智力 | AI | 大模型入门(九):RAG数据库-CSDN博客中我们提到,大模型存在知识更新问题:大模型的知识源于预训练,将大量的知识压缩到参数之中,训练完成之后大模型的所掌握的知识也就固定不变了。然而随着时间的推移,人们在应用过程中,需要大模型不断”学习“新知识。我们通过RAG等技术解决这一问题。这就引出了大模型如何与外部数据源例如RAG数据库之间的通信问题。

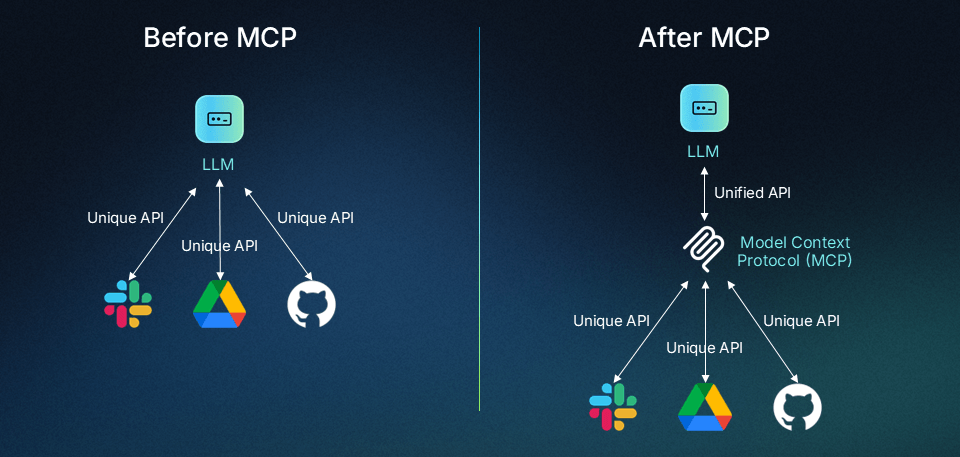

N×M 问题:对于开发者和企业来说,还有一个更棘手的问题:“N×M 问题”,其中N代表大型语言模型,M代表工具。在N方面,有许多大模型,在M方面,有无数的外部对接工具。每个大型模型提供商都有自己的协议来连接外部工具,使得潜在的集成点无穷无尽。

MCP正是解决上述两个问题的热门方案:

MCP(Model Context Protocol,模型上下文协议)是由Anthropic提出的开放标准协议,旨在解决大模型(LLMs)与外部数据源及工具之间的交互难题,目标是实现大模型与外部数据源和工具之间交互的标准化,因而其有望成为智能体开发的标准化基础协议。

注:Anthropic公司是由OpenAI(ChatGPT的开发机构)前研究副总裁达里奥·阿莫迪(Dario Amodei)、大语言模型GPT-3论文的第一作者汤姆·布朗(Tom Brown)等人共同创立的,两人因发展理念不同而从OpenAI离职。Anthropic公司背后资本主要为亚马逊公司,OpenAI公司的背后资本主要为微软公司。由此可见初创大模型企业之间的竞争其实也是老牌科技企业之间的暗战。2025年2月25日,Anthropic宣布推出Claude 3.7 Sonnet,称这是其迄今为止最智能的模型,也是市场上首款混合推理模型。Claude系列也一直与OpenAI的GPT系列模型对标竞争,并着重强调其安全性和可控性。

MCP通过标准化RAG和代理式AI实现大模型与外部数据源和工具的无缝集成,用于大模型和数据源之间建立一个安全的双向连接通道,以提高大模型的提高可扩展性和稳定性。其核心功能主要包括:

-

统一接口:规范大模型与外部资源的交互方式,避免重复开发各种类型的适配器。

-

安全双向通信:通过本地运行、权限控制和用户确认机制保护敏感数据。

-

模块化扩展:支持插件式接入数据库、API、文件系统等以便适应不同场景需求。

MCP协议架构

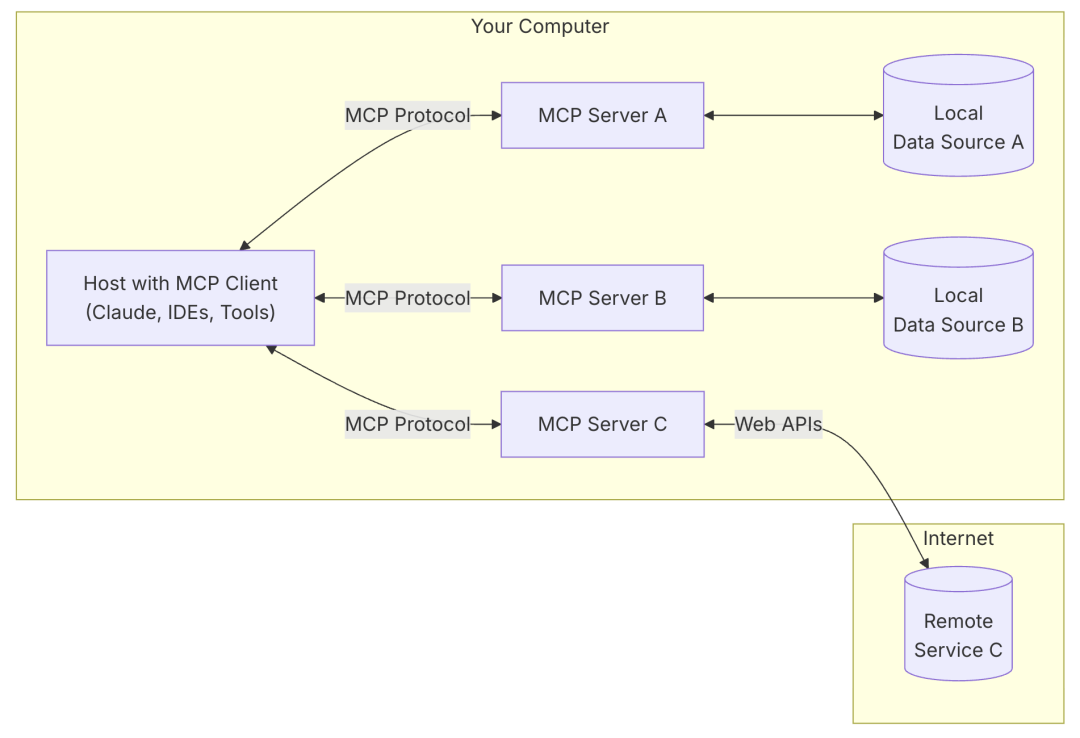

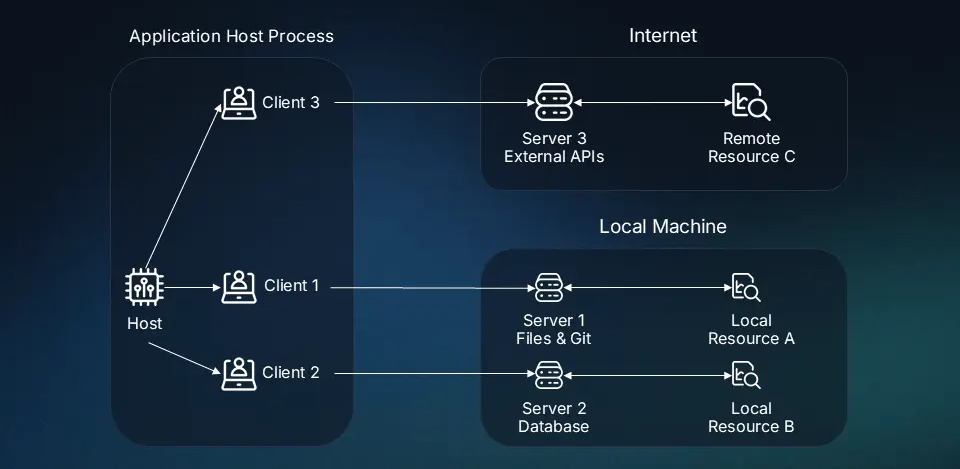

MCP为客户端-服务器架构,主要由4部分组成:

1. 宿主应用程序(AI应用)即与用户交互并发起连接的大语言模型。例如DeepSeek客户端、像 Cursor 这样的人工智能增强型集成开发环境以及标准的基于网络的大型语言模型聊天界面,也就是前文AI新智力 | 大模型入门11:私有化部署问答助手术语、工具和解决方案-CSDN博客中的“UI界面:应用开发与集成平台”。

2. MCP客户端(Client)即为集成在宿主应用程序中发起连接的客户端,用于处理与 MCP 服务器的连接,并在宿主应用程序的需求和模型上下文协议之间进行数据转换。

3. 服务器(Server)即为提供数据资源(上下文,工具和提示)的对象,它是一个轻量级程序,每个程序都通过标准化的模型上下文协议公开特定的功能。每个独立服务器通常具有专一的功能,例如数据库 PostgreSQL。

客户端和服务器之间保持1:1连接,即一个MCP客户端只能对应一个MCP服务器。由于MCP服务器与MCP客户端通信时,无须将API密钥提供给客户端,这种机制就保证了数据安全性。

4. 传输层:客户端与服务器之间的通信机制。MCP 支持两种主要传输方法:

-

标准输入输出(STDIO):主要用于本地集成,此时服务器与客户端在同一主机中。

-

HTTP+SSE(Server-Sent Events):用于远程连接,其中 HTTP 用于客户端请求,SSE用于服务器响应和流传输。

MCP交互过程

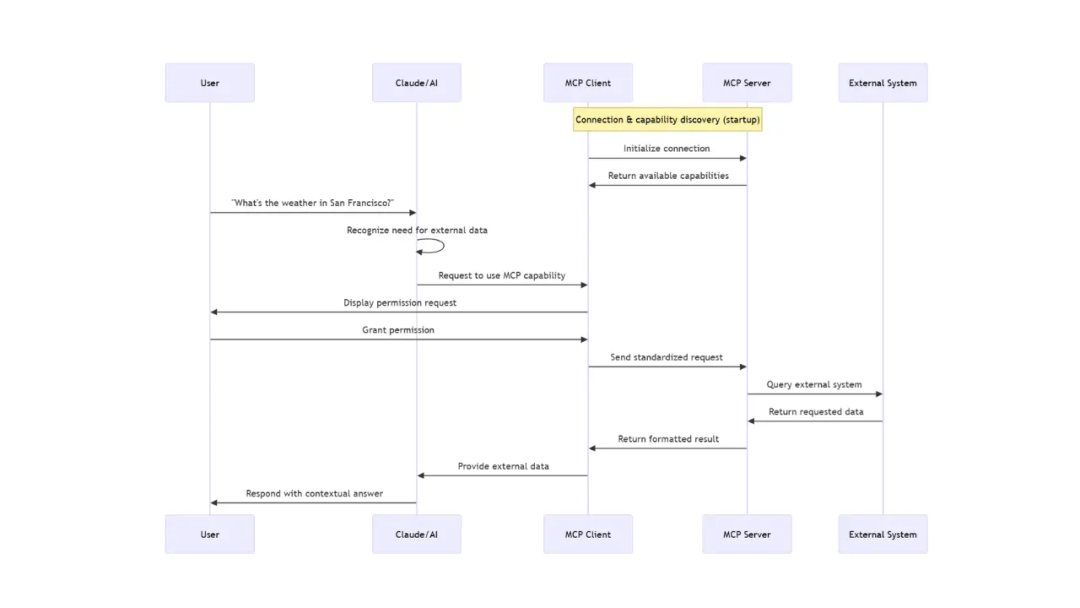

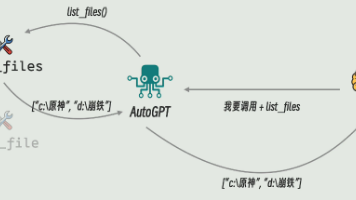

MCP客户端与服务器之间的交互过程如下:

初始连接:当MCP客户端(如DeepSeek客户端)启动时,它会连接到设备上已配置的 MCP 服务器。

功能发现:客户端询问每个服务器“你提供哪些功能?”每个服务器用其可用的工具、资源和提示进行响应。

注册:客户端注册这些服务器及功能信息,使其在对话期间可供人工智能使用。

整体过程如下图所示:

未来发展前景

自从2024年底推出以来,MCP在众多平台上迅速得到采用,创建了一个个由MCP组成的多样化生态系统,弥合了大型语言模型与外部工具之间的差距。

MCP在大语言模型(LLMs)与外部系统连接方面实现了重大飞跃,它使碎片化的生态系统标准化,并有可能解决 NxM 问题。通过使人工智能应用与工具和数据源的交互方式通用化,MCP减少了开发开销,并创建了一个更具互操作性的生态系统,在这个生态系统中,创新统一而不是各自孤立,才有利于整个行业的发展。

但也存在一定的担忧:

技术封闭:Anthropic公司自创立之初对华并不友好,与DeepSeek不同,Anthropic坚持闭源路线,其Claude系列模型仅通过API提供有限访问,且明确禁止中国开发者使用。

舆论打压:在Github趋势榜等开发者社区,Anthropic通过技术评测报告贬低中国模型性能(如声称Claude代码生成准确率高于DeepSeek),但实测数据显示DeepSeek-R1在73%场景领先。

功能适配:MCP作为Anthropic推出的协议,虽然是开源协议,MCP 的协议更新(如 0326 版流式 HTTP 传输机制优先服务于美国技术生态,其默认集成工具(如GitHub、Slack)与国内主流平台(如 Gitee、钉钉)存在接口差异。开发者需额外开发 30%-50% 的适配层代码,才能满足国产化需求。

生态歧视:Anthropic 主导的MCP开源社区(如 mcp.so)收录的 5886 个 MCP Server中,仅12%适配中国本地化服务。例如,高德地图 MCP Server 需自行开发,而官方生态优先支持 Google Maps。

因此,希望我国大模型厂商,不仅要在大模型核心层逐鹿群雄,在基础性协议的制定上也不要掉以轻心。希望国内厂商尽快制定出我们自主知识产权的中国版MCP协议,建设形成我们主导的“AI协议栈”,构建具有有力话语权的AI生态体系,切勿重蹈互联网协议(如IPv4)发展的覆辙。

参考文献:

1. https://www.descope.com/learn/post/mcp

2. https://modelcontextprotocol.io/introduction

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

为武汉地区的开发者提供学习、交流和合作的平台。社区聚集了众多技术爱好者和专业人士,涵盖了多个领域,包括人工智能、大数据、云计算、区块链等。社区定期举办技术分享、培训和活动,为开发者提供更多的学习和交流机会。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)