【AI大模型前沿】MiniCPM4.1:面壁智能重磅开源,128K长文本推理秒级响应,端侧性能狂飙7倍

MiniCPM4.1 是一个专为端侧设备量身打造的高效大型语言模型,具有 8B 参数规模。它在保持与同尺寸开源模型相当性能的同时,通过一系列创新技术实现了显著的效率提升。该模型在长文本处理、推理速度和模型压缩等方面均取得了突破性进展,使其成为端侧应用场景中的理想选择。

系列篇章💥

目录

前言

随着人工智能技术的飞速发展,大语言模型在各个领域展现出了巨大的潜力。然而,如何将这些强大的模型高效地部署到端侧设备上,一直是行业面临的挑战。面壁智能团队推出的 MiniCPM4.1 系列模型,凭借其在模型架构、学习算法、训练数据和推理系统等方面的全方位优化,成功实现了端侧大模型的极致效率与卓越性能。本文将深入剖析 MiniCPM4.1 的技术细节,探讨其在不同场景下的应用潜力,并提供快速部署与使用的实践指南。

一、项目概述

MiniCPM4.1 是一个专为端侧设备量身打造的高效大型语言模型,具有 8B 参数规模。它在保持与同尺寸开源模型相当性能的同时,通过一系列创新技术实现了显著的效率提升。该模型在长文本处理、推理速度和模型压缩等方面均取得了突破性进展,使其成为端侧应用场景中的理想选择。

二、技术揭秘

(一)稀疏注意力机制

InfLLM v2 稀疏注意力机制是 MiniCPM4.1 的核心技术之一。它通过动态选择相关上下文块,将传统 Transformer 模型中 O(n²) 的计算复杂度降低到接近线性。这一机制不仅减少了计算量,还显著降低了内存访问开销。

(二)高效训练算法

MiniCPM4.1 引入了 ModelTunnel v2,用于高效地搜索最佳预训练策略,避免了大量试错成本。此外,分块式推演(Chunk-wise Rollout)技术实现了负载均衡的强化学习,有效解决了长链思维(CoT)推理中的负载不均衡问题。

(三)极致模型量化

BitCPM4 是 MiniCPM4.1 的三元量化版本,将模型参数位宽压缩至 3 值,实现了模型位宽 90% 的极致瘦身。这种量化技术在保持模型性能的同时,大幅减少了模型存储和计算需求。

(四)高效推理框架

CPM.cu 是一个轻量级的 CUDA 推理框架,集成了稀疏注意力、模型量化和投机采样等技术,显著提高了预填充和解码速度。此外,ArkInfer 跨平台部署系统支持多后端环境的一键部署,提供了灵活的跨平台适配能力。

三、核心功能

(一)高效稀疏架构

采用 InfLLM v2 稀疏注意力机制,每个词元仅需计算与少于 5% 词元的相关性,显著降低了长文本处理的计算复杂度和内存开销。这一架构创新使得 MiniCPM4.1 在处理 128K 长文本时,相比传统模型大幅减少了缓存存储空间。

(二)双频换挡机制

根据任务类型自动切换注意力模式,长文本任务启用稀疏注意力以降低计算复杂度,短文本任务切换至稠密注意力以确保精度与速度。这种智能切换机制在保证输出质量的同时,最大化了计算效率。

(三)卓越综合性能

在多个评测基准上,MiniCPM4.1 取得了同尺寸模型第一的成绩,综合能力达到同级最优水平。无论是在知识问答、推理分析还是编程辅助等方面,MiniCPM4.1 均表现出色,展现了其强大的通用性。

(四)端侧友好

MiniCPM4.1 在 LiveCodeBench、AIME 等端侧性能测试中,推理速度比同尺寸开源模型快 3 倍以上。在 128K 长文本场景下,仅需 25% 的缓存存储空间,极大地减轻了端侧设备的计算压力。

(五)多种部署格式

MiniCPM4.1 提供了 GPTQ、AutoAWQ 等多种部署格式,方便开发者根据不同的端侧设备需求进行高效部署。

四、基准评测

(一)效率评测

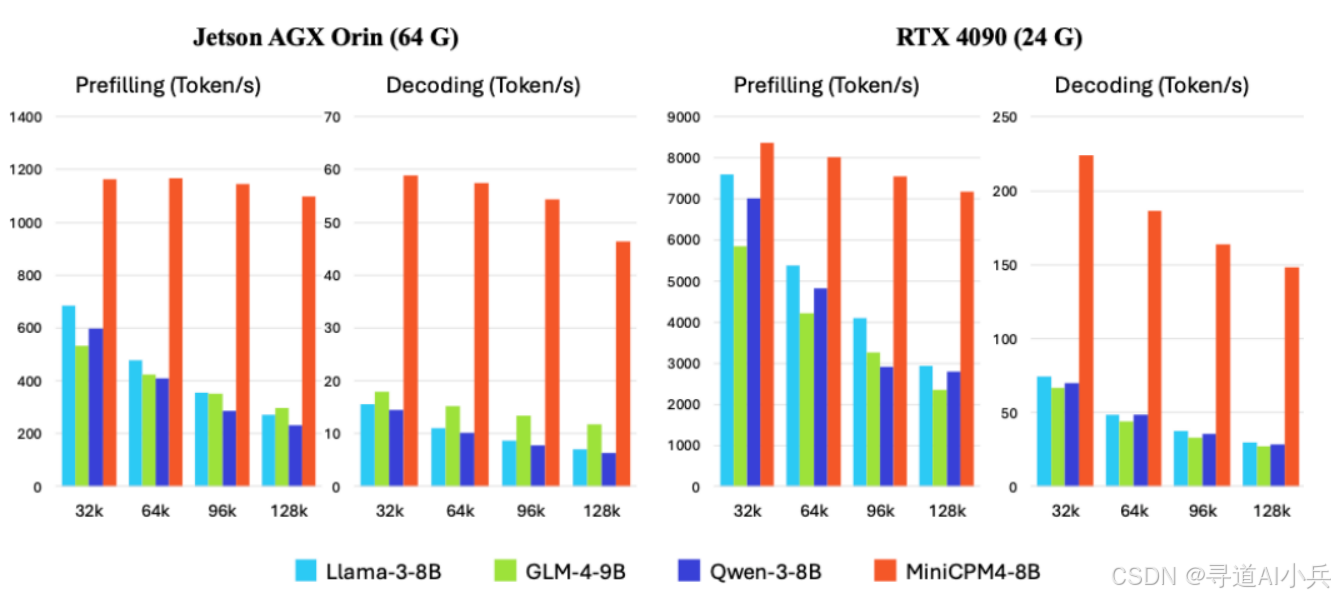

在 Jetson AGX Orin 和 RTX 4090 两款典型端侧芯片上,MiniCPM4.1 在长文本处理任务中展现出大幅领先同尺寸模型的处理速度。随着文本长度的增加,MiniCPM4.1 的性能优势愈发显著。在 Jetson AGX Orin 平台上,相较于 Qwen3-8B,MiniCPM4.1 实现了约 7 倍的生成速度提升。

(二)综合评测

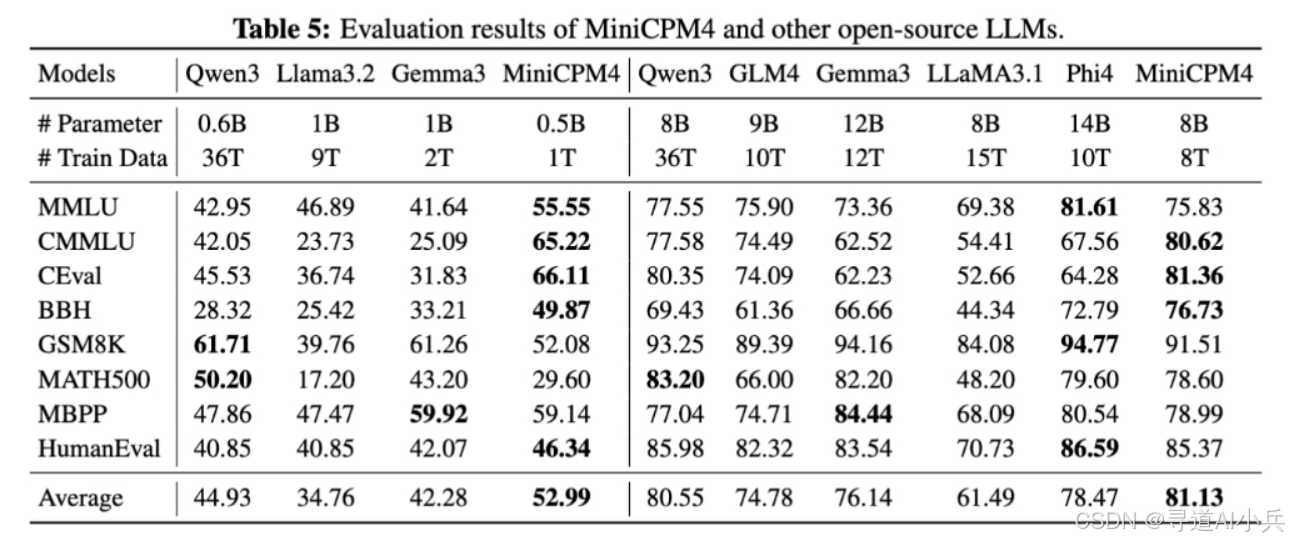

MiniCPM4.1 推出端侧 8B、0.5B 两种参数规模版本,均在同级别模型中实现了最佳性能表现。在多个综合评测基准上,MiniCPM4.1 的平均分超过了同尺寸的其他开源模型,证明了其在知识、推理、编程等多方面的强大能力。

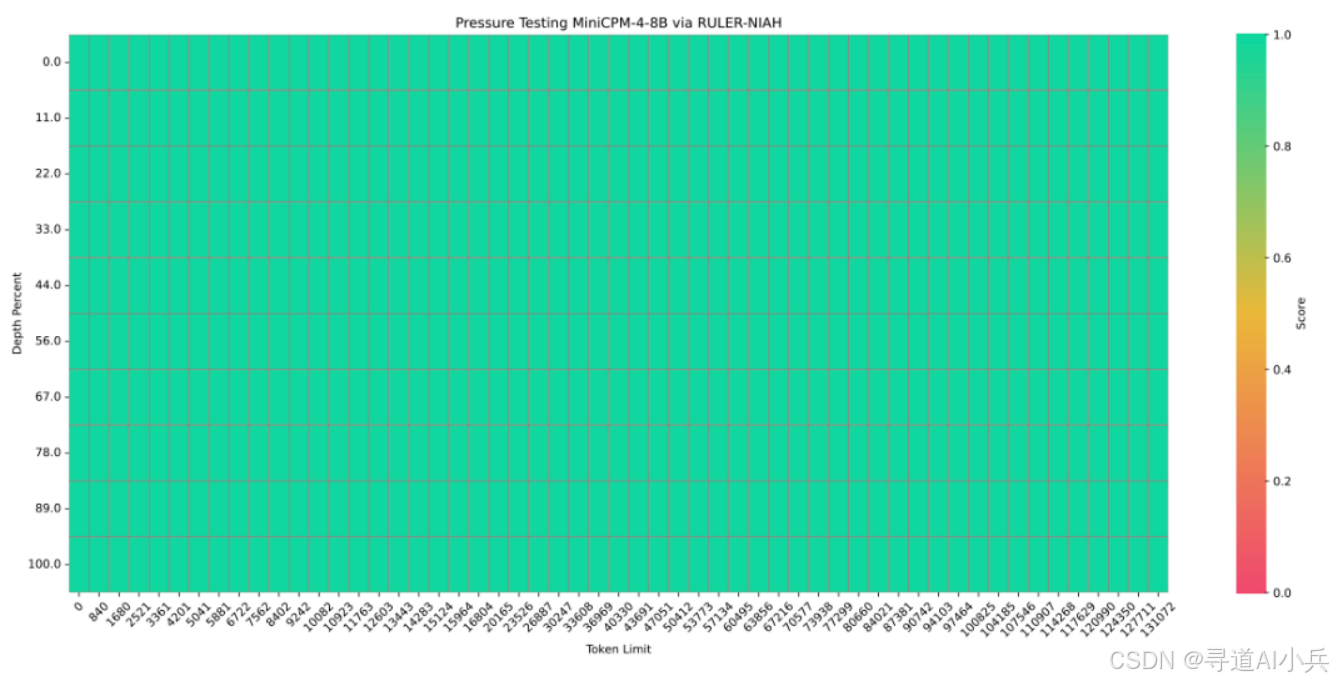

(三)长文本评测

MiniCPM4.1 基于 32K 长文本进行预训练,并通过 YaRN 技术实现长度扩展。在 128K 长文本的大海捞针任务中,MiniCPM4.1 展现出卓越的性能表现,准确率达到了 100%。

五、应用场景

(一)端侧设备应用

MiniCPM4.1 专为端侧设备设计,适用于智能手机、平板电脑、智能音箱等设备。它能在设备本地高效运行,保护用户隐私,减少对云端计算的依赖。

(二)长文本处理

稀疏注意力机制和长文本优化使 MiniCPM4.1 能高效处理长文本任务,如长篇文档生成、故事创作、技术文档编写等。

(三)知识问答与教育

凭借强大的知识理解和推理能力,MiniCPM4.1 可用于知识问答系统、智能辅导工具等教育领域应用,帮助用户快速获取准确信息,辅助学习和研究。

(四)编程辅助

在代码生成、代码补全、编程问题解答等方面表现出色,可作为开发人员的编程助手,提高编程效率和质量。

(五)内容创作

能协助用户进行创意写作、文案撰写、新闻报道等各类内容创作任务,提供灵感和写作支持。

六、快速使用

为了帮助开发者快速上手 MiniCPM4.1,以下是基于 CPM.cu 推理框架的部署实践:

(一)环境准备

确保已安装 Python 3.8 及以上版本,并安装以下依赖:

pip install torch transformers

(二)安装 CPM.cu

通过以下命令安装 CPM.cu:

git clone https://github.com/OpenBMB/cpm.cu.git --recursive

cd cpm.cu

python3 setup.py install

(三)CPM.cu推理

通过以下命令使用 EAGLE3 进行投机推理。

python3 -m cpmcu.cli \

--model-path $BASE_MODEL_PATH \

--draft-model-path $EAGLE3_DRAFT_MODEL_PATH \

--prompt-text "Tell me about Tsinghua University" \

--use-eagle3 true

(四)transformers 推理示例

从 Hugging Face 下载 MiniCPM4.1 模型,并加载推理模型:

from transformers import AutoModelForCausalLM, AutoTokenizer

import torch

torch.manual_seed(0)

path = 'openbmb/MiniCPM4.1-8B'

device = "cuda"

tokenizer = AutoTokenizer.from_pretrained(path)

model = AutoModelForCausalLM.from_pretrained(path, torch_dtype=torch.bfloat16, device_map=device, trust_remote_code=True)

# User can directly use the chat interface

# responds, history = model.chat(tokenizer, "Write an article about Artificial Intelligence.", temperature=0.7, top_p=0.7)

# print(responds)

# User can also use the generate interface

messages = [

{"role": "user", "content": "Write an article about Artificial Intelligence."},

]

prompt_text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

)

model_inputs = tokenizer([prompt_text], return_tensors="pt").to(device)

model_outputs = model.generate(

**model_inputs,

max_new_tokens=32768,

top_p=0.95,

temperature=0.6

)

output_token_ids = [

model_outputs[i][len(model_inputs[i]):] for i in range(len(model_inputs['input_ids']))

]

responses = tokenizer.batch_decode(output_token_ids, skip_special_tokens=True)[0]

print(responses)

(五)混合思考

MiniCPM4.1 支持混合思考模式,可以用于深度思考和非思考模式。用户可以通过设置 enable_thinking=True 来启用混合思考模式,设置 enable_thinking=False 来启用非思考模式。同样,用户可以直接在查询末尾添加 /no_think 来启用非思考模式。如果未添加任何特殊标记或在查询末尾添加 /think,模型将启用思考模式。

# Enable reasoning mode

prompt_text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

enable_thinking=True

)

# Enable non-reasoning mode

prompt_text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True,

enable_thinking=False

)

七、结语

MiniCPM4.1 作为面壁智能团队在端侧大模型领域的最新成果,凭借其极致的效率优化和强大的性能表现,为端侧应用场景提供了全新的解决方案。无论是长文本处理、知识问答还是编程辅助,MiniCPM4.1 均展现出卓越的性能。通过本文的详细介绍,相信读者对 MiniCPM4.1 有了全面的了解。更多详细信息,请参考以下项目地址:

项目地址

- GitHub 仓库:https://github.com/openbmb/minicpm

- Hugging Face 模型库:https://huggingface.co/openbmb/MiniCPM4.1-8B

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索(CSDN博客之星|AIGC领域优质创作者)

📖专属社群:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,回复‘入群’ 即刻上车,获取邀请链接。

💘领取三大专属福利:1️⃣免费赠送AI+编程📚500本,2️⃣AI技术教程副业资料1套,3️⃣DeepSeek资料教程1套🔥(限前500人)

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我们,一起携手同行AI的探索之旅,开启智能时代的大门!

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)