AI智能体(Agent)大模型入门【5】--本地AI模型连接到PyCharm或者编译软件使用

在上一篇文章中,我们已经介绍了如何下载已经训练好的大模型部署到本地个人计算机上,今天这一篇章就是教会大家如何在编译软件中调用使用已经部署好的大模型了,而不是在终端cmd内使用,在pycharm使用,直接在控制台输入输出。AI智能体(Agent)大模型入门【4】--下载训练好的大模型部署到本地上-CSDN博客。

目录

前言

在上一篇文章中,我们已经介绍了如何下载已经训练好的大模型部署到本地个人计算机上,今天这一篇章就是教会大家如何在编译软件中调用使用已经部署好的大模型了,而不是在终端cmd内使用,在pycharm使用,直接在控制台输入输出。

如果还没有下载安装本地大模型的话可以参考专栏文章内容或者点击一下链接进行学习下载及使用:AI智能体(Agent)大模型入门【4】--下载训练好的大模型部署到本地上-CSDN博客

部署使用本地模型

在之前的文章内已经教学过了和详细介绍了如何调用别人的模型了,这一次的话也是差不多的流程。这一篇文章就不详细介绍如何导入,以及为什么要这样子导入,如若不懂的话可以参考本专栏内的文章,或者点击链接进行跳转和学习:AI智能体(Agent)大模型入门【2】--基于llamaindx部署本地的聊天模型。-CSDN博客

该使用调用部署模型的方法还是基于在llamaindex的框架体系上。

安装llama-index-llms-openai-like模块

在pycharm的控制台或者使用cmd安装此模块

pip install llama-index-llms-openai-like然后在此前的llm.py模块内配置模型方法函数,用于创建并配置⼀个类似 OpenAI 的本地语⾔模型实例。

from llama_index.llms.openai_like import OpenAILike

def my_openai_llm(**kwargs):

llm = OpenAILike(

api_base="http://localhost:11434/v1",

model="gpt-oss:20b",

api_key="myds-r1",

temperature=0.7,

max_tokens = 4098,

timeout = 60,

**kwargs

)

return llm然后在app.py文件创建运行的程序

# 导入相关模块

# llms配置

from llama_index.core import Settings

# 聊天引擎模型

from llama_index.core.chat_engine import SimpleChatEngine

# 导入大模型相关配置

fromllms import my_openai_llm

Settings.llm = my_openai_llm()

chat_engine = SimpleChatEngine.from_defaults()

chat_engine.streaming_chat_repl() #启动聊天

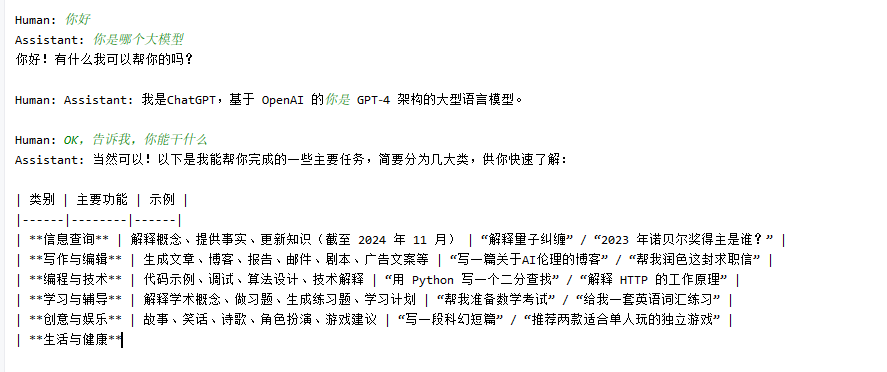

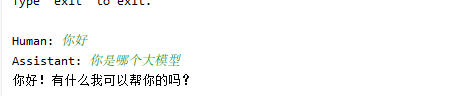

运行演示

运行app.py文件即可进行在终端对话

至于运行演示就不详细演示了,在上一个链接的文章就有展示。

出现的问题解决

1.你有可能会出现输入了第一个human然后assistant没有消息输出

然后可以在assiatant输入消息就是这样,然后得不到回应,需要等待加载一会,因为在上一篇的演示就有原因,原因是要等待它思考结束后才能进行输出。

2.还有一种可能若是打不开,程序出现报错,可能是并没有开启访问外网的工具,需要进行配置。

3.最后一种,若是没有启动该程序的话,那就是后端的ollama服务端没有启动,需要注意端口和启动

本篇章的篇幅较短,因为这个不是重要的知识内容,在下一篇章和之后的篇章教学使用ocr以及结合fastapi进行扩展演示。

更多推荐

已为社区贡献12条内容

已为社区贡献12条内容

所有评论(0)