Ubuntu部署Dify并接入蓝耘MaaS API,小白也能轻松上手大模型应用开发

环境配置与依赖安装:快速完成 Docker 安装和网络优化。Dify 平台部署:轻松搭建可视化智能应用平台。蓝耘 MaaS 平台 API 接入:与 OpenAI 兼容,实现高性能模型调用。AI 应用构建与Markdown格式化:自动化文章生成与格式化。蓝耘 MaaS API 的核心优势:高性能算力支持:GPU加速响应更快兼容OpenAI API:快速接入零门槛高性价比:更低成本调用大模型灵活扩展性

本文详细介绍了在Ubuntu环境中部署Dify智能应用平台并接入蓝耘MaaS平台API的全过程。包括使用阿里云源安装Docker和Compose、部署Dify、获取API密钥,以及构建文章生成器AI应用。通过结合Dify可视化平台与蓝耘MaaS高性能API,开发者能以较低门槛实现AI应用开发,为内容创作等场景提供强大能力,兼容OpenAI接口且高性价比。

目 录

- 引言

- 一、借助阿里云源安装Docker和Compose

- 二、拉取并部署Dify

- 三、启动Dify服务

- 四、初始化 Dify 管理员账号

- 五、安装模型供应商插件

- 六、如何获取蓝耘Maas平台API

- 七、构建 AI 应用示例

- 总结

引言

在人工智能应用快速发展的今天,如何高效部署 AI 应用并灵活调用不同的大模型能力,已经成为开发者和企业的核心需求之一。本文将详细介绍如何在 Ubuntu 环境中借助 阿里云镜像源快速安装 Docker 与 Docker Compose,并完成 Dify 智能应用平台的部署与配置。通过引入 蓝耘 MaaS 平台提供的 API 接口,我们不仅可以快速接入大规模语言模型,还能基于 Dify 构建属于自己的 AI 应用,极大地提升开发效率与使用体验。

一、借助阿里云源安装Docker和Compose

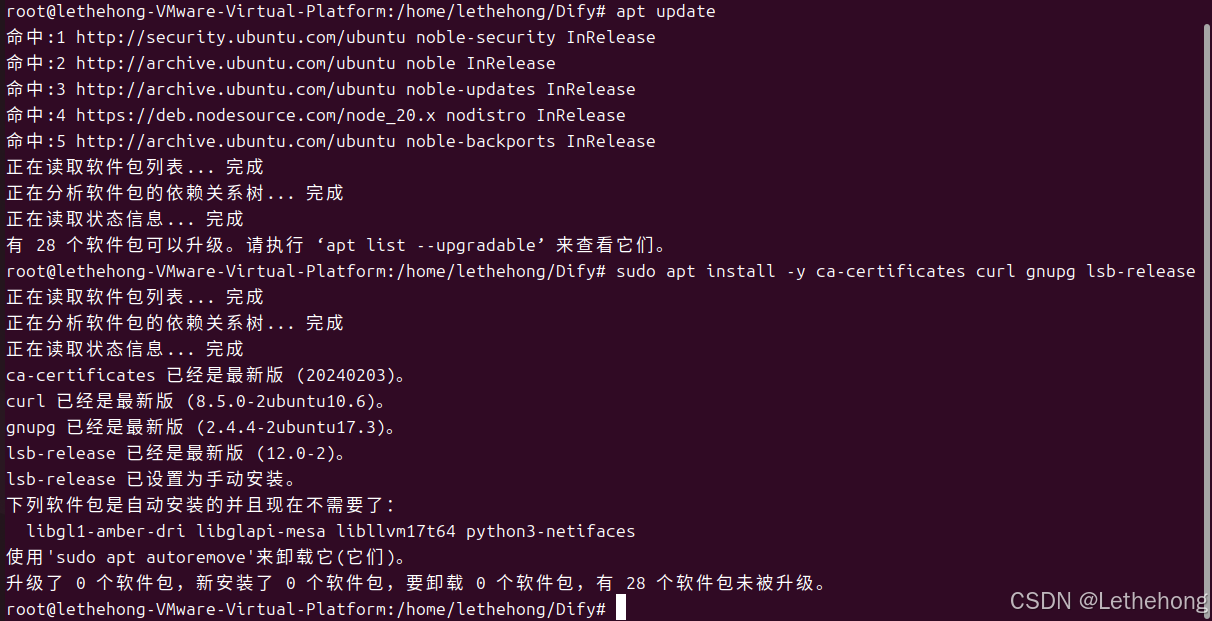

1、安装必要依赖

apt update

aptinstall-y ca-certificates curl gnupg lsb-release

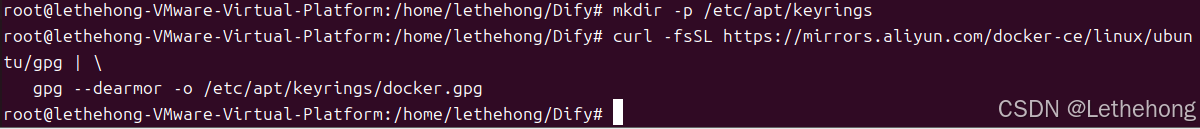

2、 添加阿里云 Docker GPG 密钥

mkdir-p /etc/apt/keyrings

curl-fsSL https://mirrors.aliyun.com/docker-ce/linux/ubuntu/gpg |

gpg --dearmor-o /etc/apt/keyrings/docker.gpg

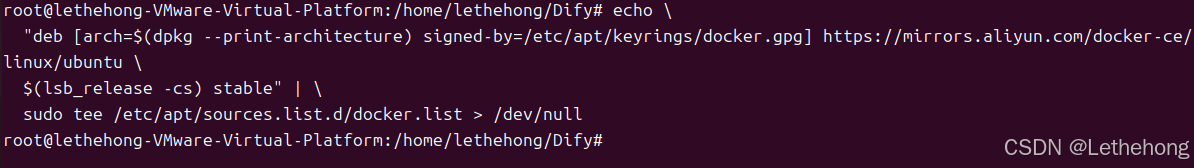

3、 写入阿里云 Docker 软件源

echo\"deb [arch=$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.gpg] https://mirrors.aliyun.com/docker-ce/linux/ubuntu \

$(lsb_release -cs) stable"|\sudotee /etc/apt/sources.list.d/docker.list > /dev/null

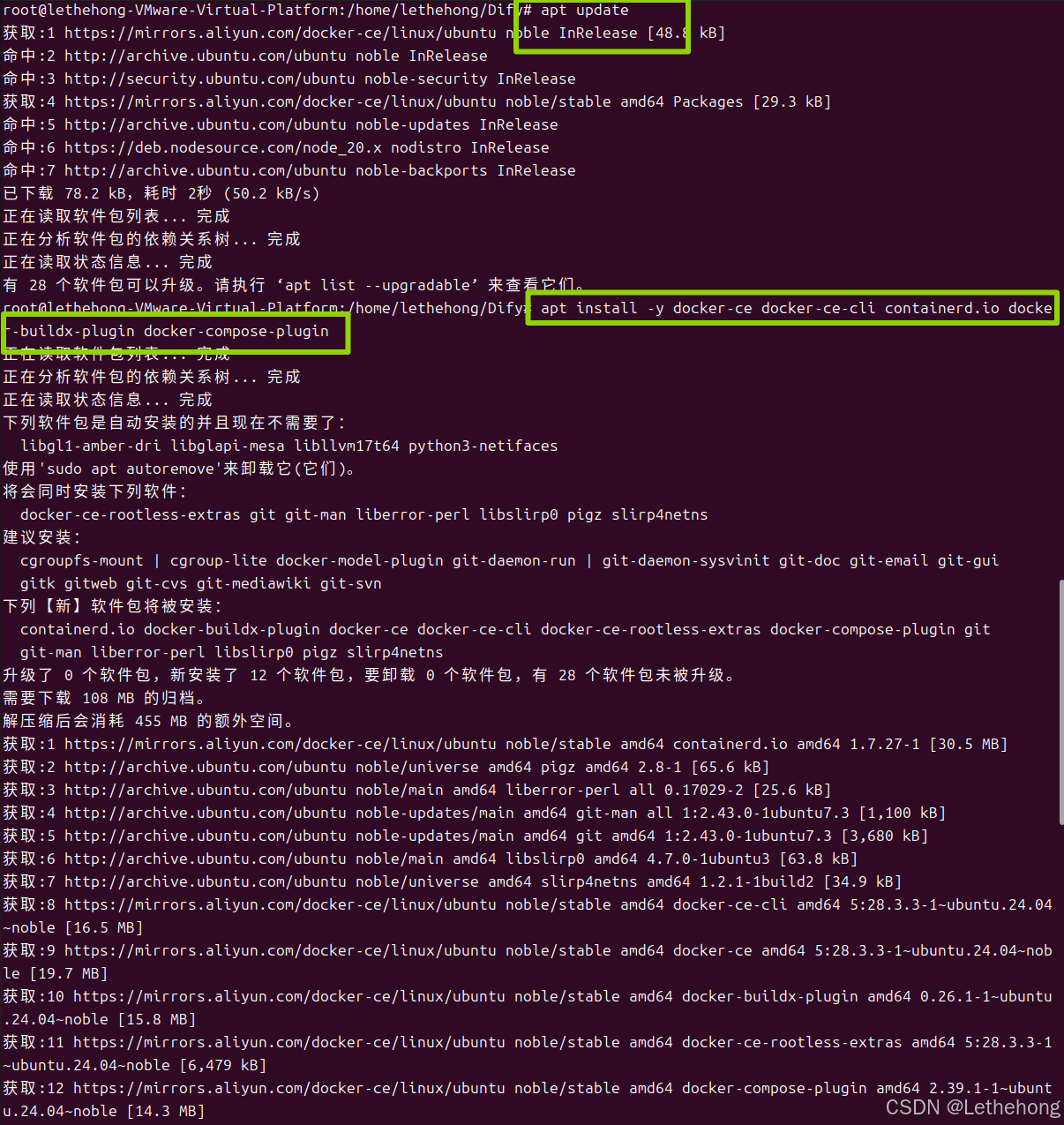

4、 安装 Docker 及 Compose 插件

apt update

aptinstall-y docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

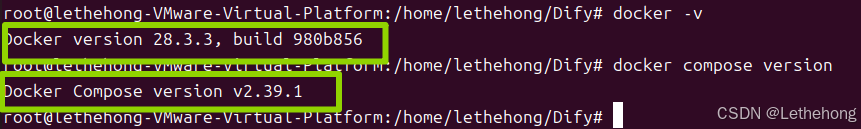

5、 验证安装

docker-vdocker compose version

二、拉取并部署Dify

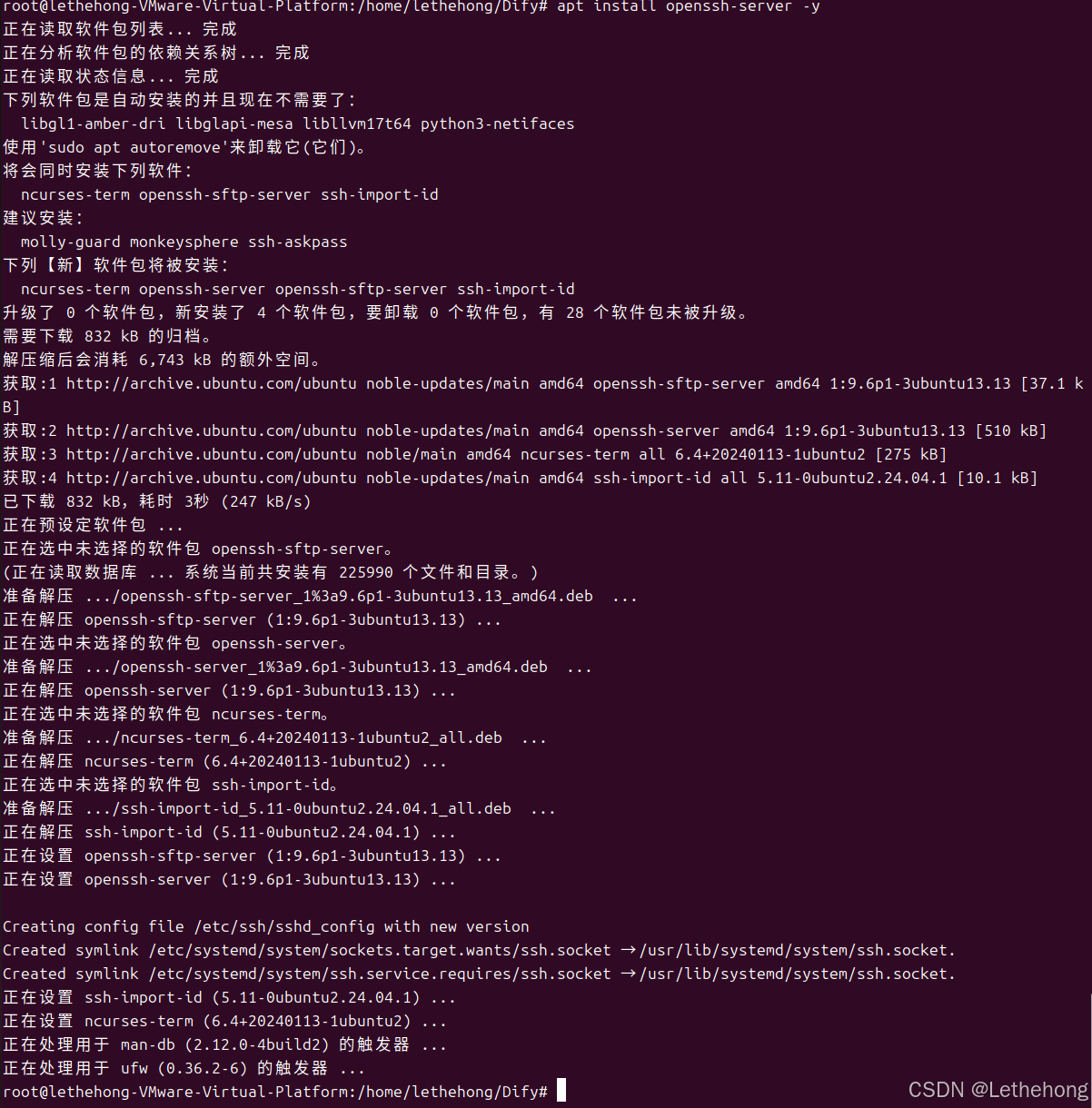

1、 安装SSH服务

apt update

aptinstall openssh-server -y

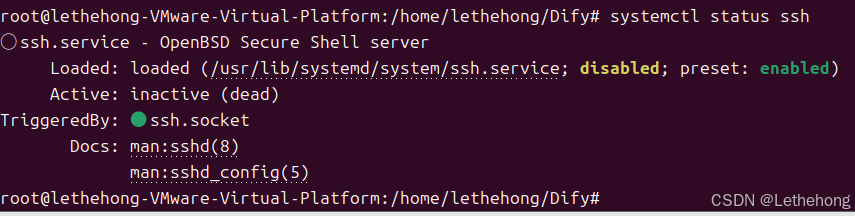

2、 查看SSH运行状态(成功)

systemctl status ssh

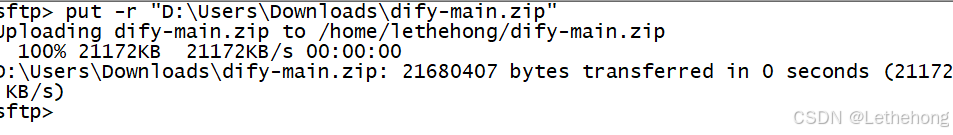

3、 可以在电脑浏览器访问并下载:

https://github.com/langgenius/dify/archive/refs/heads/main.zip

这里我在本地下载好了zip通过CRT上传到了Ubuntu里面

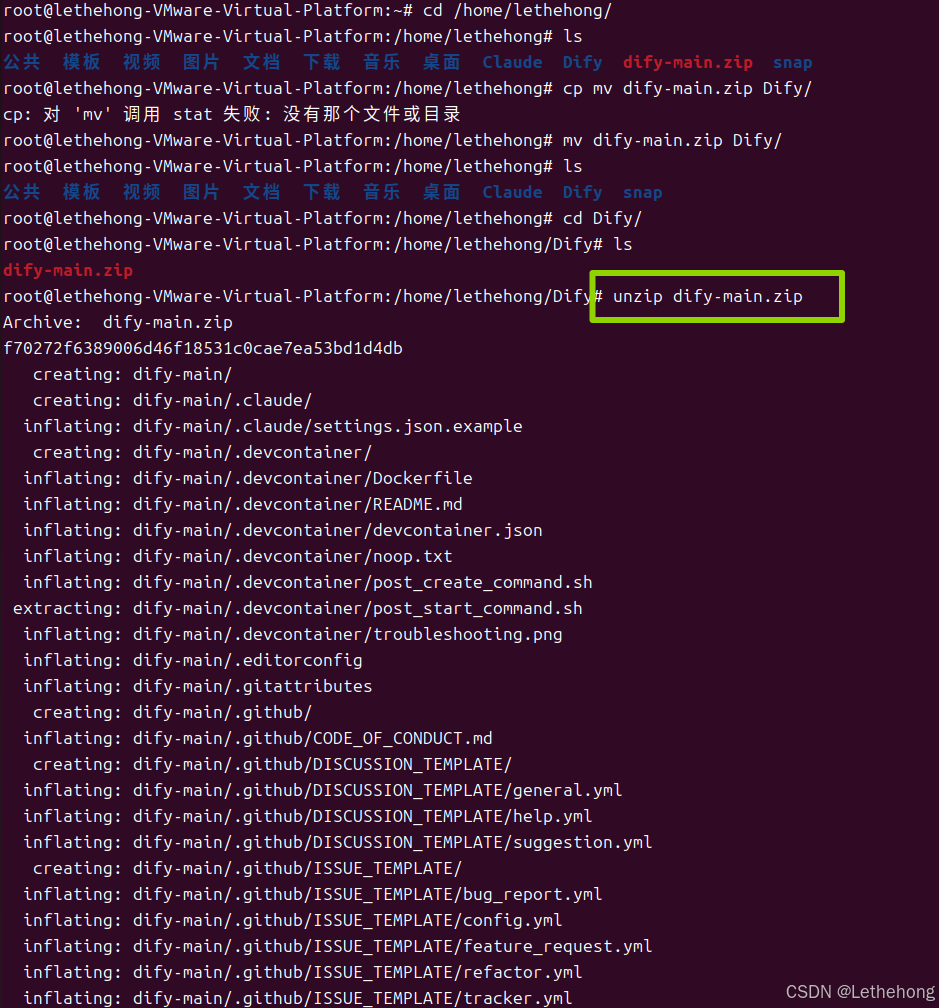

4、 解压ZIP

这里是将压缩包移动到了指定的文件夹里面后进行的解压,这样会避免很多不必要的麻烦(大家一定要看清文件路径)

unzip dify-main.zip

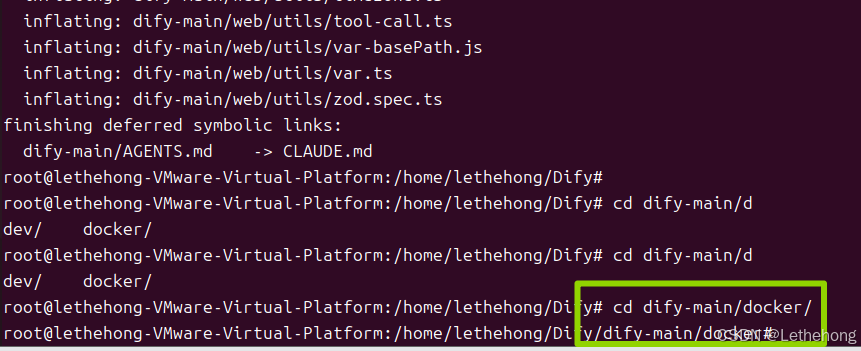

cd dify-main/docker

这里进入的是docker子目录,里面才有docker-compose.yml 配置文件

三、启动Dify服务

这里需要确保我们在docker/目录下进行,然后输入:

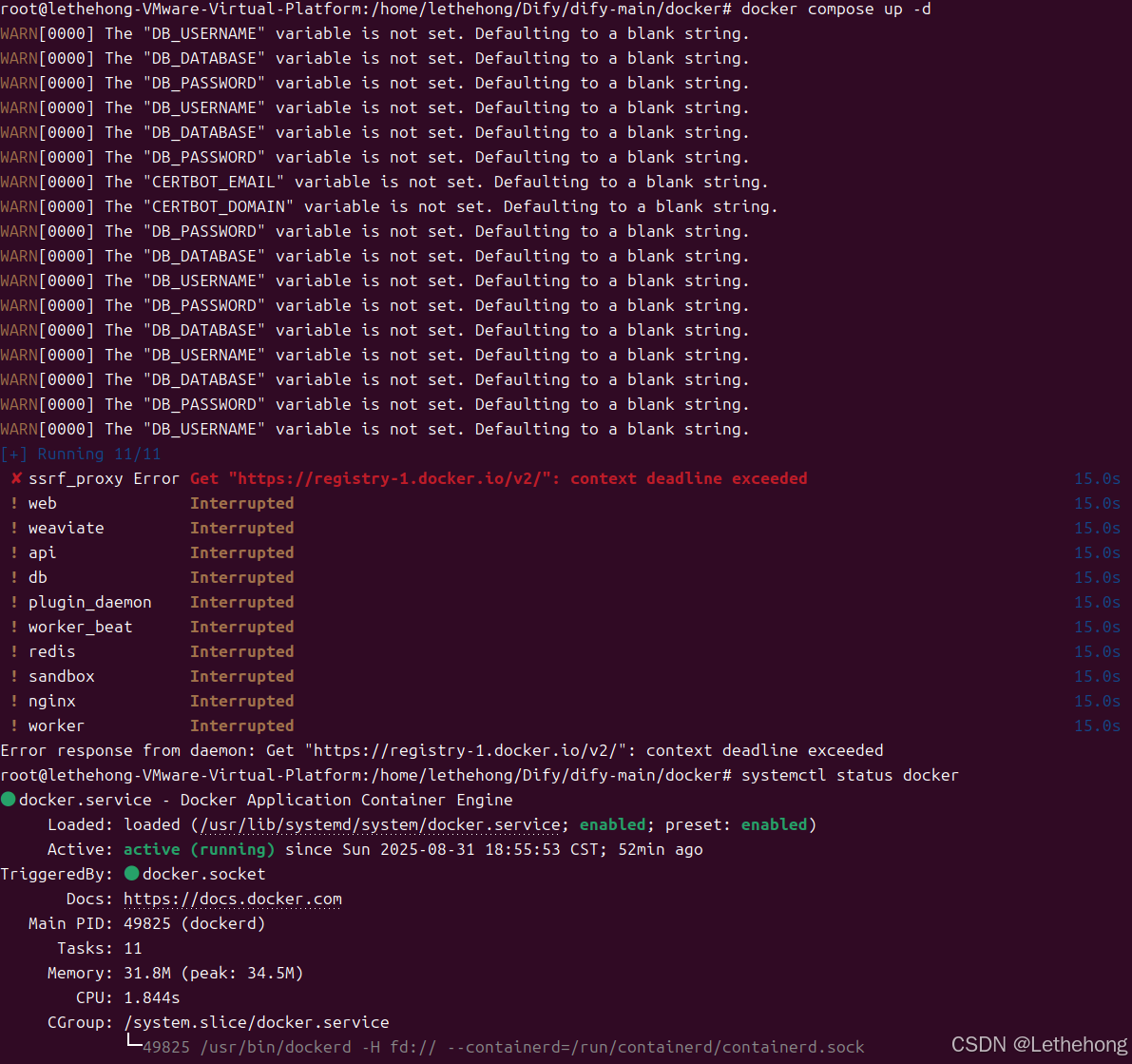

docker compose up -d

这里我在检查docker运行状态和网络都没有问题之后,决定更换源试一下

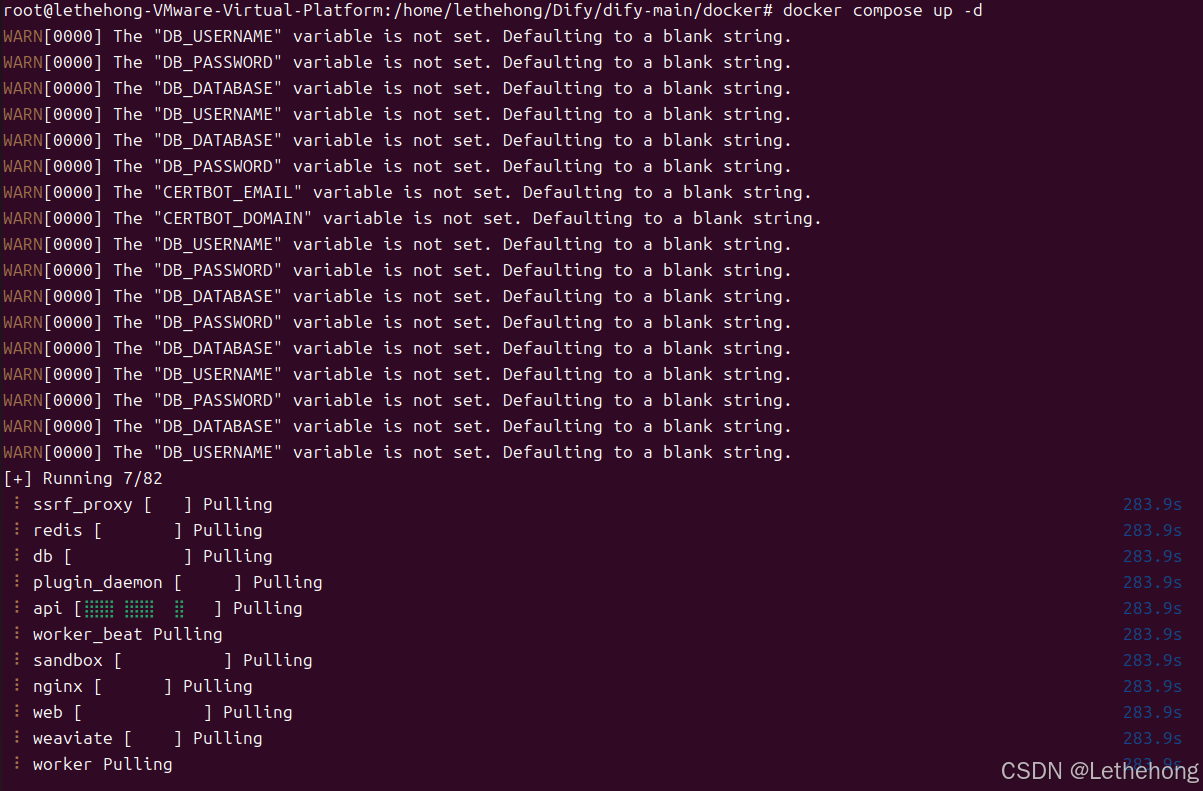

开启科学上网后

然后重新运行(这里可能时间较久)

docker-compose up -d

关于网络问题这里补充一下 遇到这个错误"Get ‘https://registry-1.docker.io/v2/’: net/http:

request canceled while waiting for connection (Client.Timeout exceeded

while awaiting headers)"的解决办法

- 网络连接问题:确保自己的网络是否能访问互联网,尝试ping一下即可。

- 镜像源访问受限:可以尝试更换为国内镜像源,配置镜像加速器。

- 增加请求超时时间:可以尝试增加 Docker 的默认超时时间,以避免超时错误。

- 代理设置:如果使用了代理,确保代理配置正确,或者尝试删除代理设置。

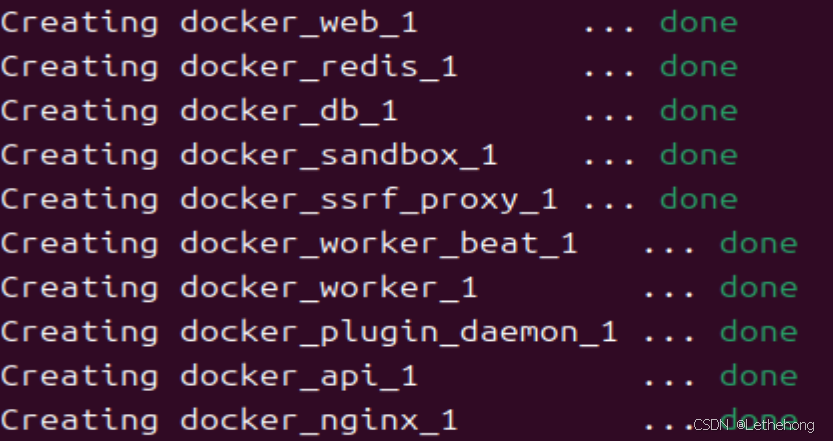

成功拉取并启动如下

遇到这个错误,重新输入启动命令即可(下载时间过长导致的)

ERROR: Get "https://registry-1.docker.io/v2/": net/http: TLS handshake timeout

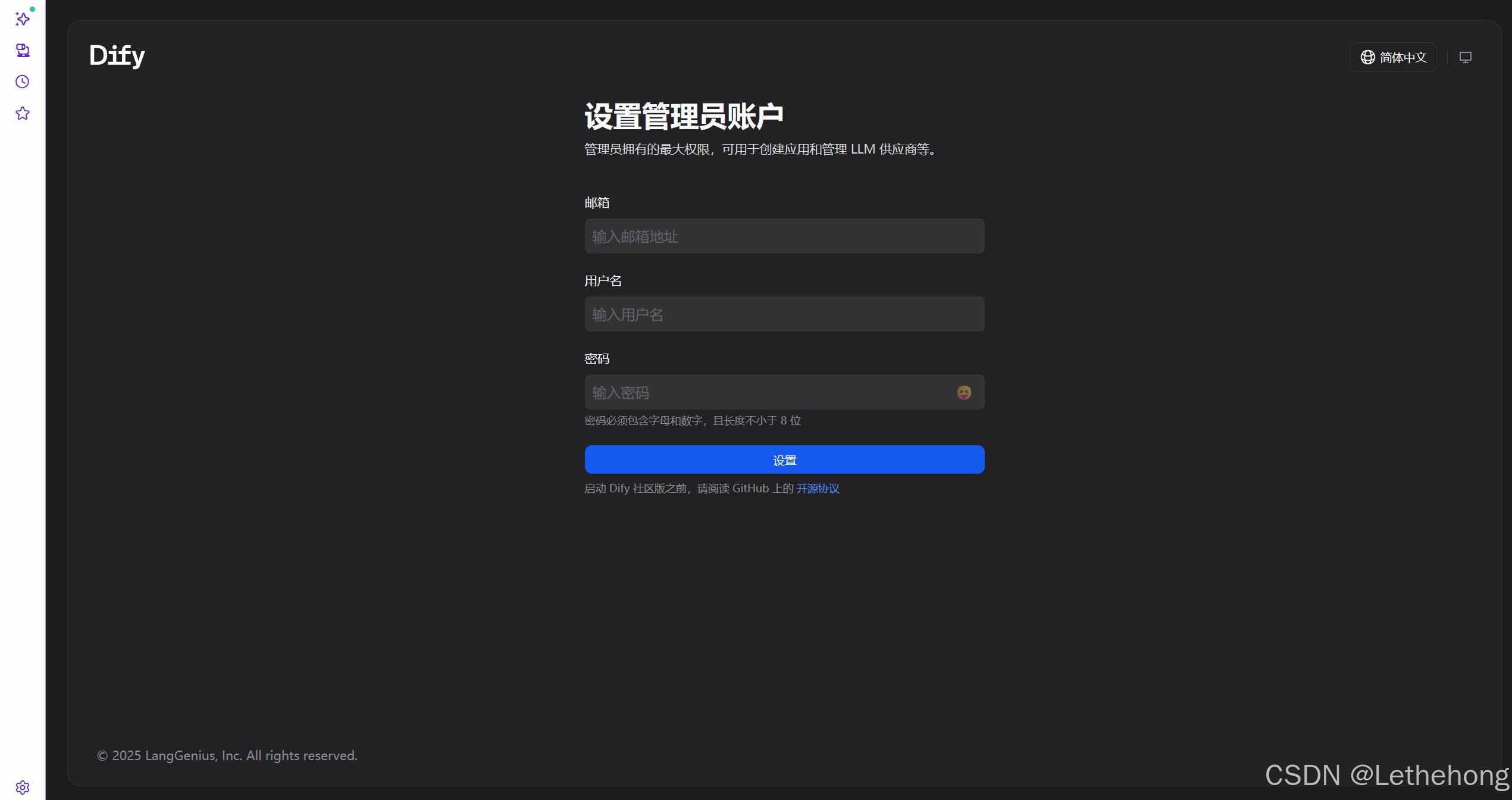

四、初始化 Dify 管理员账号

在浏览器打开:

http://你的Ubuntu主机IP/install

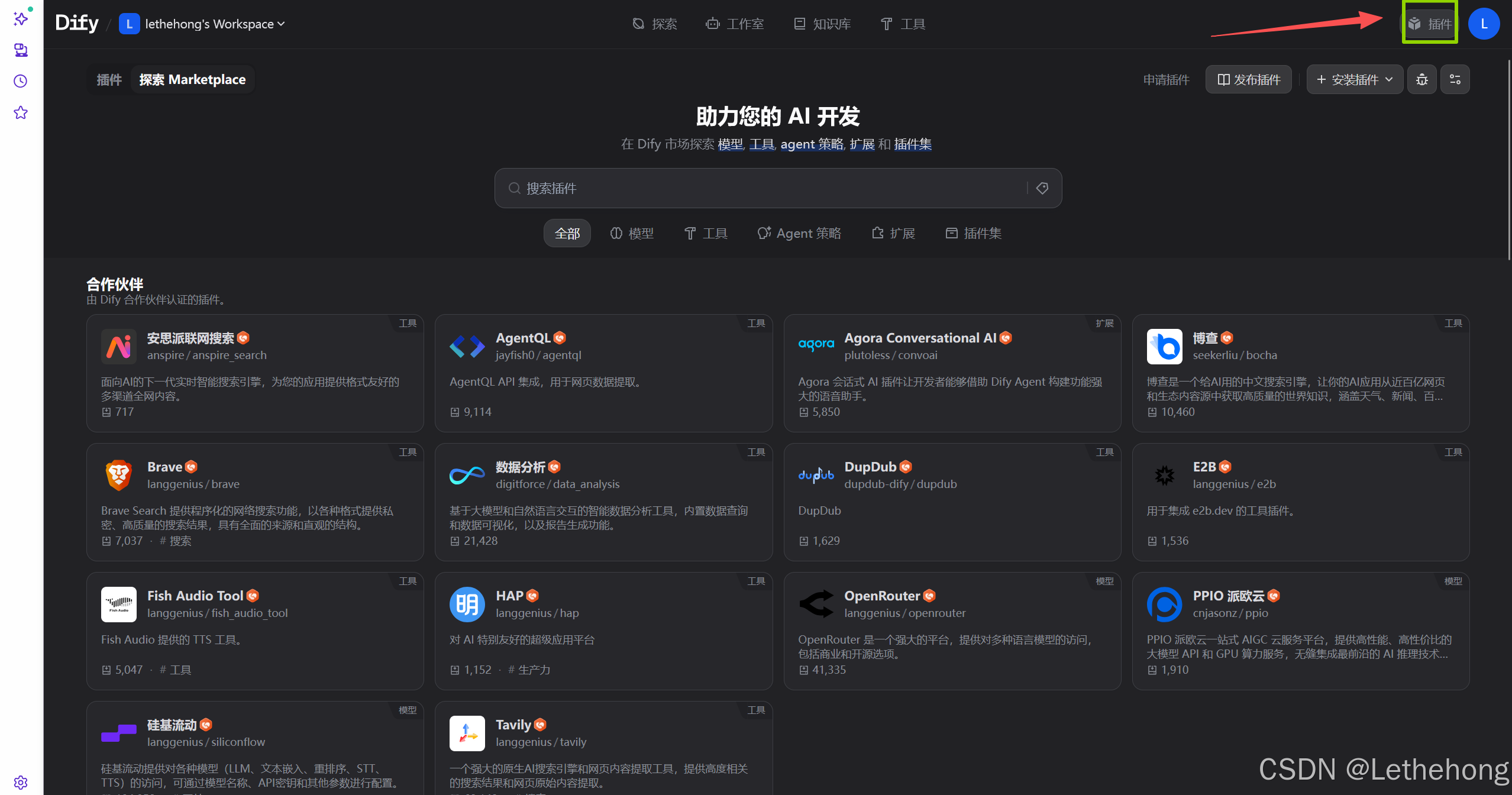

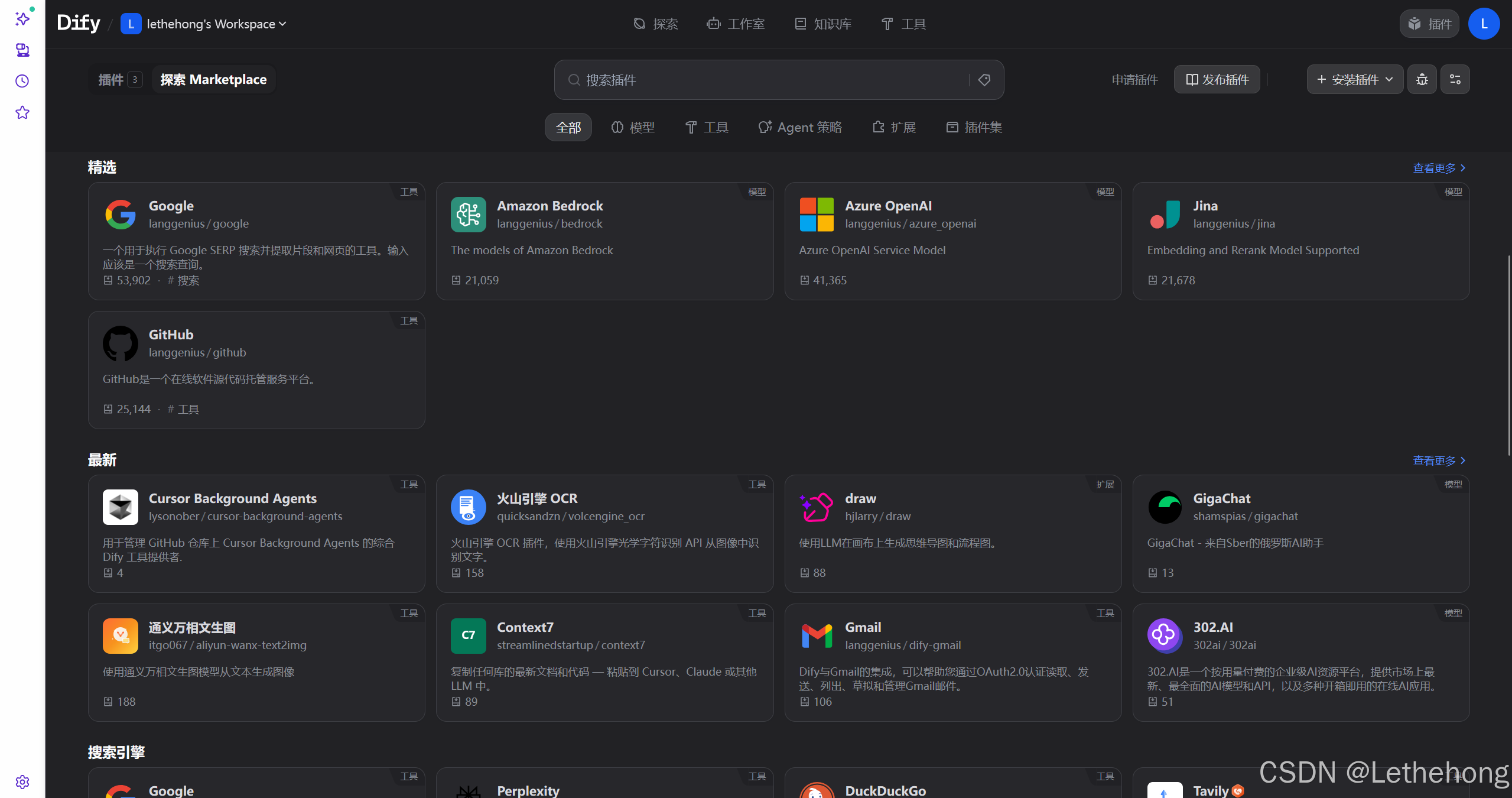

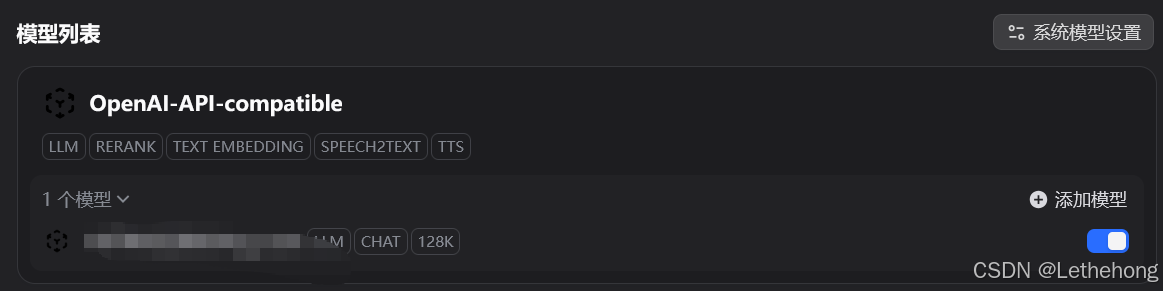

五、安装模型供应商插件

在 Dify 后台操作界面中:

- 点击右上角头像 → 插件 → Marketplace

- 安装自己需要的插件

- 前往“设置 → lanyun模型供应商”,找到OpenAI-API-compatible,然后配置 API Key 与地址以及相关配置信息即可

Dify 不自带模型,必须配置好至少一个 LLM 才能进行智能问答。

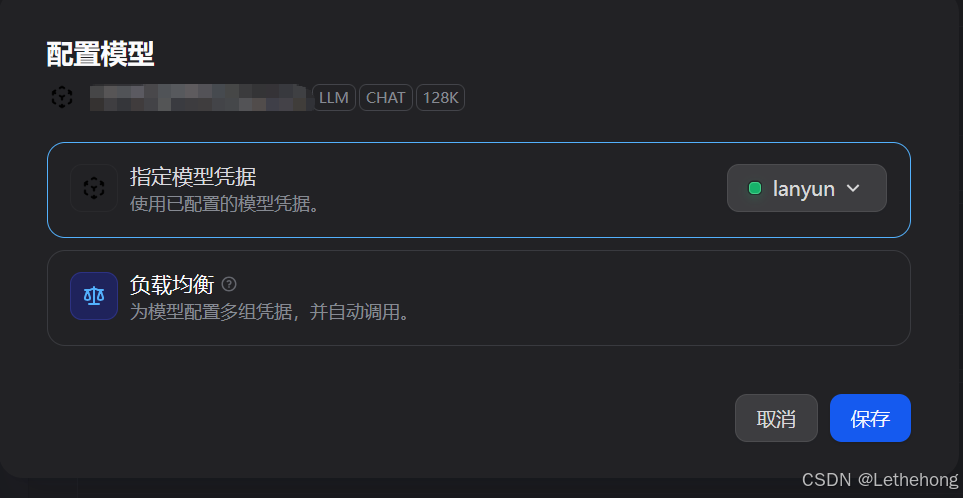

六、如何获取蓝耘Maas平台API

先说说蓝耘这个平台

如何注册蓝耘智算平台

1.点击注册链接:蓝耘智算平台

2.进入下面图片界面,输入手机号并获取验证码,输入邮箱,设置密码,点击注册在这里插入图片描述

蓝耘是一家专业的GPU算力云服务提供商,基于行业领先的灵活的基础设施及大规模的GPU算力资源,为客户提供开放、高性能、高性价比的算力云服务,助力客户AI模型构建、训练和推理的业务全流程。

这里给大家送给福利。千万 Token 资源包福利都在送,感兴趣的赶紧来吧

https://console.lanyun.net/#/register?promoterCode=18586cc762

进来之后,找到Maas平台—API KEY管理—创建API KEY即可,然后复制去OpenAI-API-compatible即可

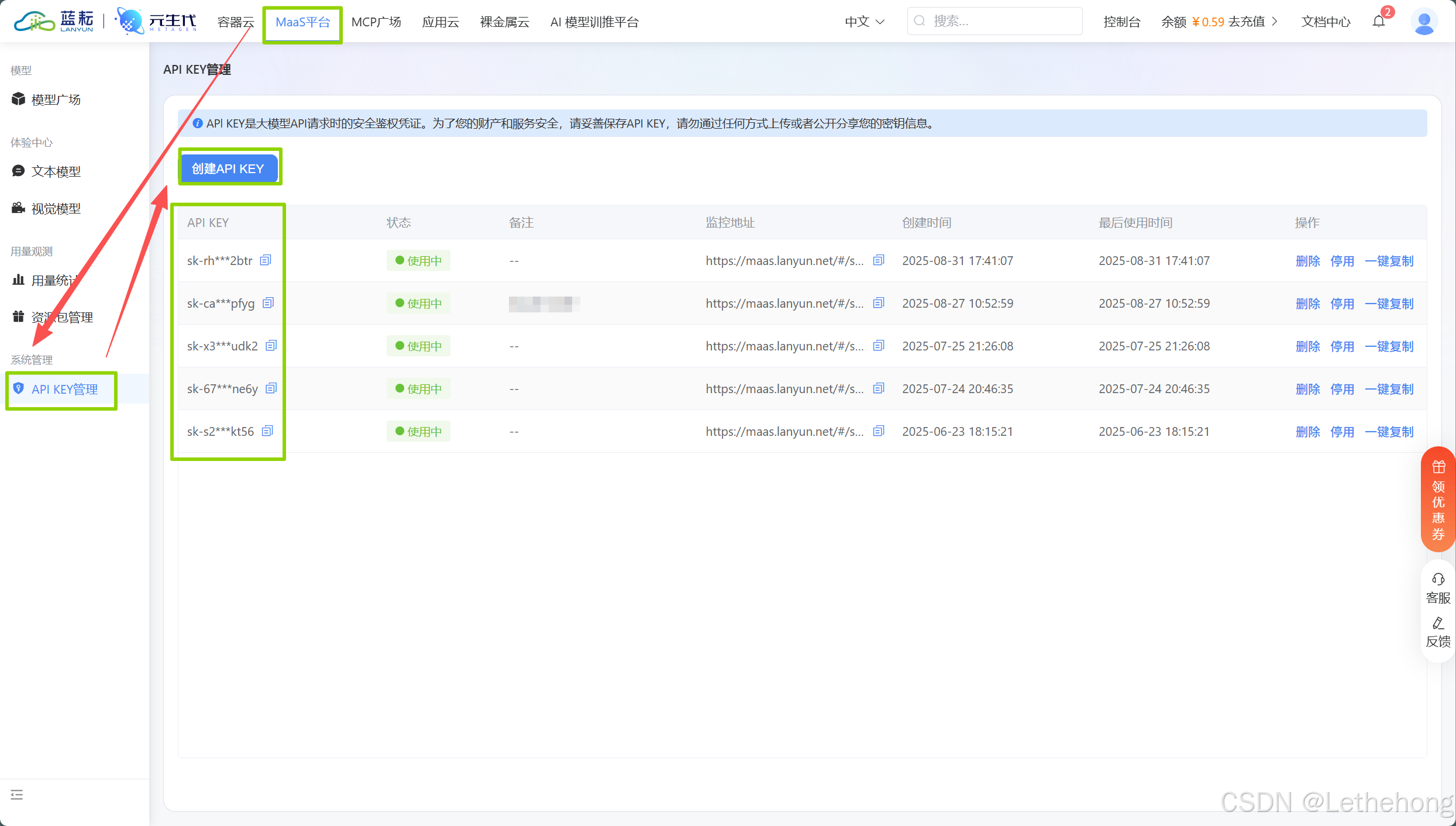

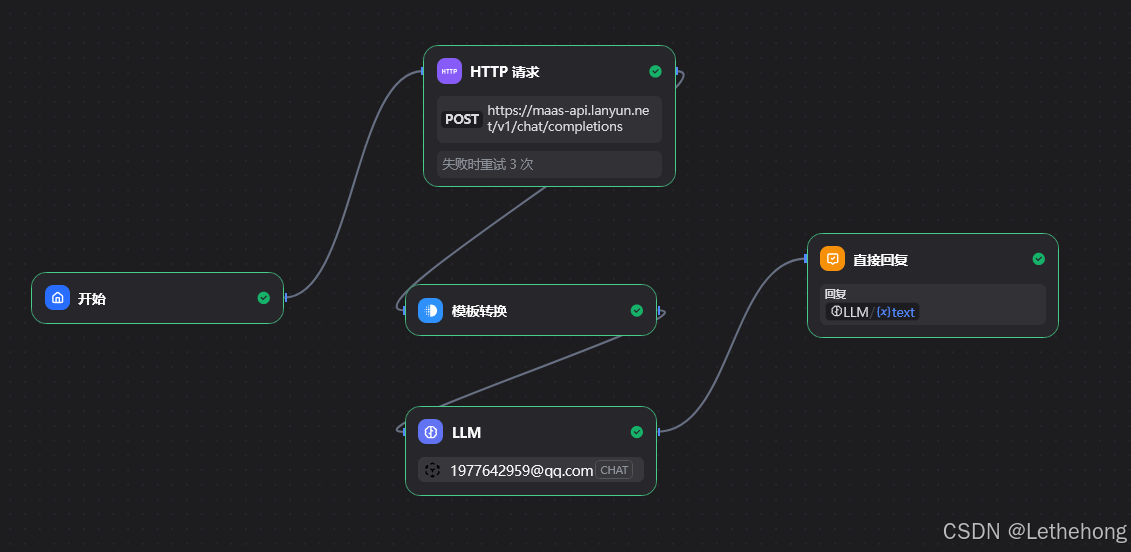

七、构建 AI 应用示例

在主界面点击“创建空白应用”,名字为文章生成器

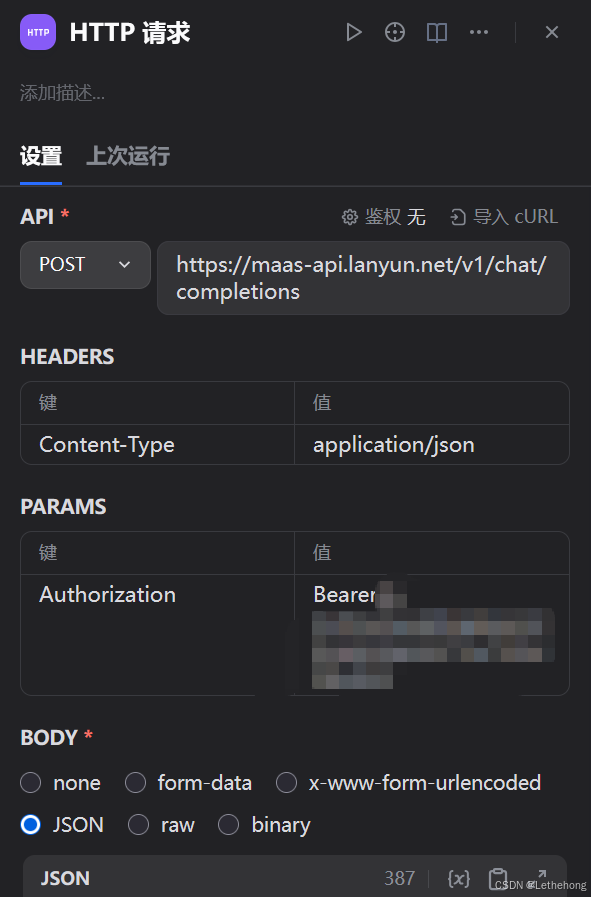

这里添加一个HTTP请求,在API选择POST请求并输入https://maas-api.lanyun.net/v1/chat/completions

配置Headers(请求头):

- 请求头1:Name(Content-Type),Value(application/json)

- 请求头2:Name(Authorization),Value(Bearer 蓝耘MaaS平台的APIKEY)

配置Body(请求体):

{"model":"/maas/deepseek-ai/DeepSeek-V3.1",

"messages":[{"role":"system",

"content":"你是一个专业的内容创作助手,擅长根据用户需求创作高质量文章。"},

{"role":"user",

"content":"请根据以下要求创作文章:\n主题:{{ $json.topic }}\n写作风格:{{ $json.style }}\n文章长度:{{ $json.length }}\n关键词:{{ $json.keywords }}\n\n请创作一篇结构清晰、内容丰富的文章。"}],

"max_tokens":2000,

"temperature":0.7}

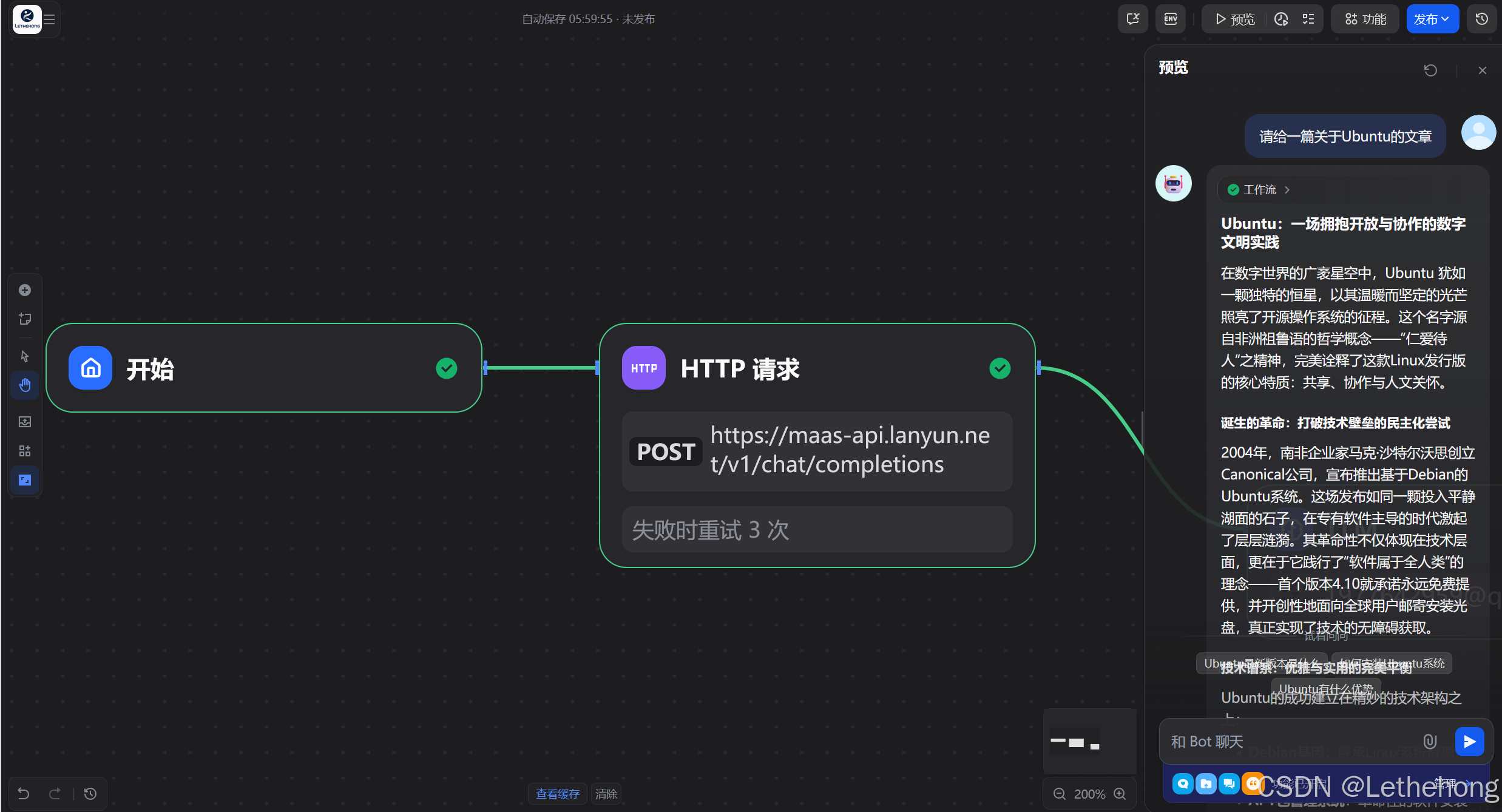

然后进行测试,没有问题,文章出来了

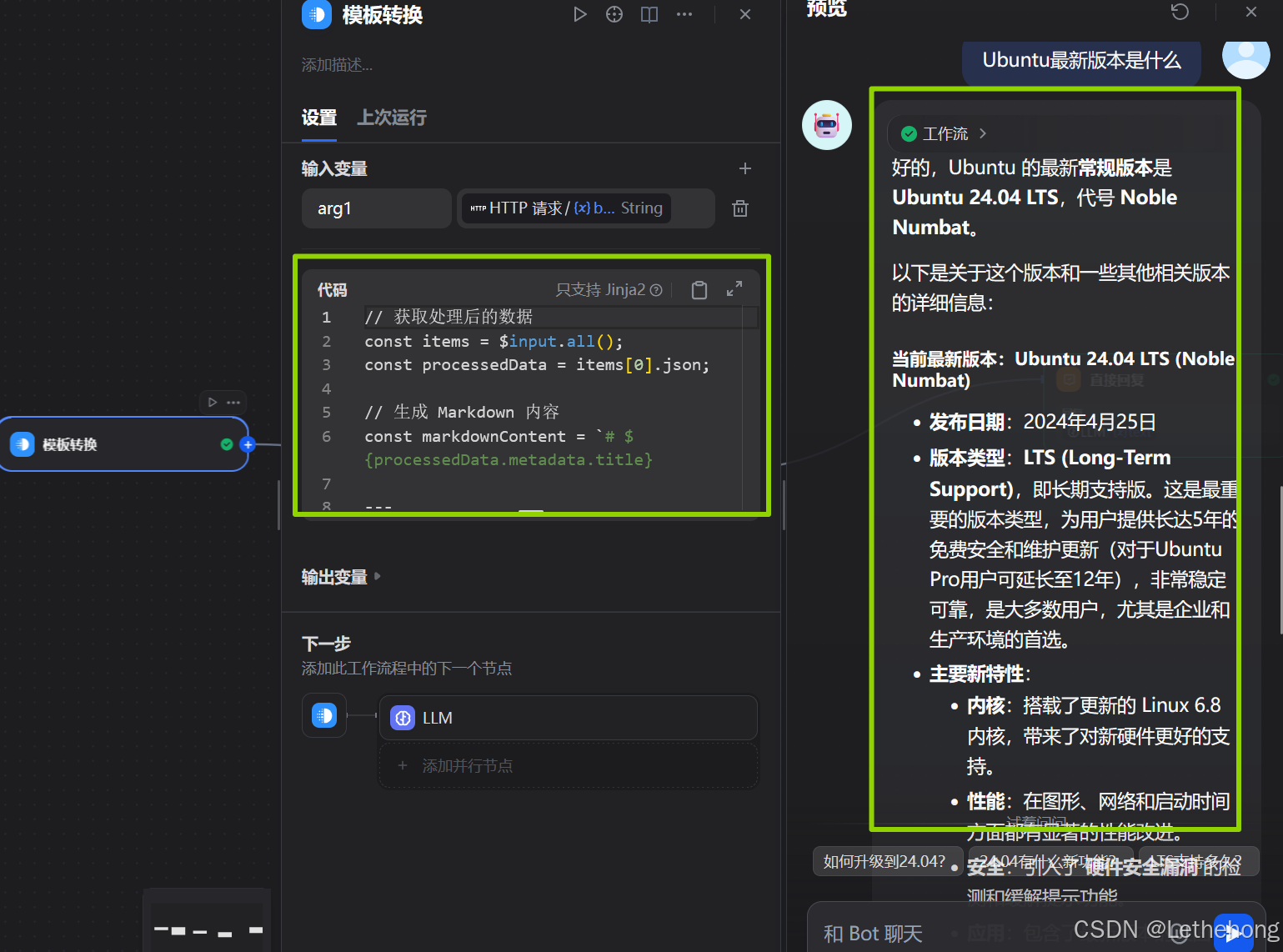

这里格式还是不太行,我想输出Markdown格式,于是我开始调整,这个里面添加模版转换节点,然后输入:

// 获取处理后的数据

const items =$input.all();

const processedData = items[0].json;

// 生成 Markdown 内容

const markdownContent =`# ${processedData.metadata.title}

---

**创建时间:** ${new Date(processedData.metadata.createdAt).toLocaleString('zh-CN')}

**字数统计:** ${processedData.metadata.wordCount} 字符

**文章风格:** ${processedData.metadata.style}

---

## 正文内容

${processedData.content}

---

## 文档信息

- **生成时间:** ${new Date().toLocaleString('zh-CN')}

- **文件格式:** Markdown (.md)

- **处理状态:** 已完成内容格式化和优化

---

*本文档由 n8n 工作流自动生成*

`;

// 生成文件名(使用时间戳避免重复)

const timestamp = new Date().toISOString().replace(/[:.]/g, '-').slice(0, 19);

const fileName =`${processedData.metadata.title.replace(/[^\w\u4e00-\u9fa5]/g, '_')}_${timestamp}.md`;

// 打印下载信息

console.log(`📁 Markdown 文件已准备完成`);

console.log(`📄 文件名:${fileName}`);

console.log(`📊 文件大小:${markdownContent.length} 字符`);

// 返回可下载的文件数据

return[{

json: {...processedData,

markdown: {

content: markdownContent,

fileName: fileName,

mimeType: 'text/markdown',

size: markdownContent.length

}},

binary: {

data: {

data: Buffer.from(markdownContent, 'utf8').toString('base64'),

mimeType: 'text/markdown',

fileName: fileName,

fileExtension: 'md'}}}];

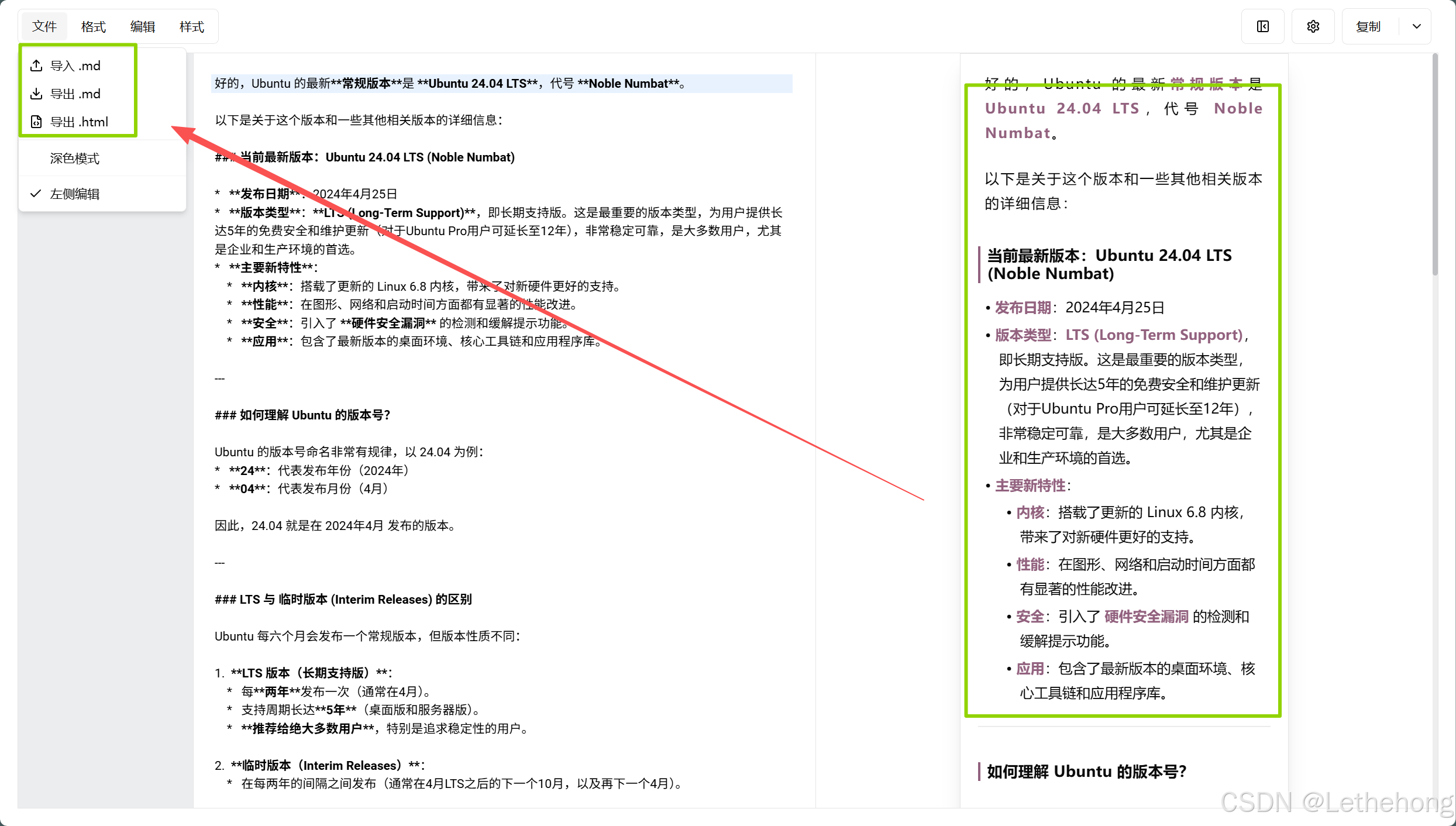

这里图片中显示内容没有问题的哈,但是无法分辨是否是按照Markdown格式输出

于是我将内容复制出来,使用在线工具进行查看,发现确实是按照Markdown格式输出。

整体的配置还是很简单,完整的工作流如下:

总结

我们完成了以下核心工作:

- 环境配置与依赖安装:快速完成 Docker 安装和网络优化。

- Dify 平台部署:轻松搭建可视化智能应用平台。

- 蓝耘 MaaS 平台 API 接入:与 OpenAI 兼容,实现高性能模型调用。

- AI 应用构建与Markdown格式化:自动化文章生成与格式化。

蓝耘 MaaS API 的核心优势:

- 高性能算力支持:GPU加速响应更快

- 兼容OpenAI API:快速接入零门槛

- 高性价比:更低成本调用大模型

- 灵活扩展性:支持多模型、多场景应用

完成了以下核心工作:

- 环境配置与依赖安装:快速完成 Docker 安装和网络优化。

- Dify 平台部署:轻松搭建可视化智能应用平台。

- 蓝耘 MaaS 平台 API 接入:与 OpenAI 兼容,实现高性能模型调用。

- AI 应用构建与Markdown格式化:自动化文章生成与格式化。

蓝耘 MaaS API 的核心优势:

- 高性能算力支持:GPU加速响应更快

- 兼容OpenAI API:快速接入零门槛

- 高性价比:更低成本调用大模型

- 灵活扩展性:支持多模型、多场景应用

通过结合 Dify + 蓝耘 MaaS API,我们能够以极低的门槛实现 AI 应用的开发与部署,为内容创作、智能问答、数据分析等场景提供更强大的能力和更高的效率。

零基础如何高效学习大模型?

你是否懂 AI,是否具备利用大模型去开发应用能力,是否能够对大模型进行调优,将会是决定自己职业前景的重要参数。

为了帮助大家打破壁垒,快速了解大模型核心技术原理,学习相关大模型技术。从原理出发真正入局大模型。在这里我和鲁为民博士系统梳理大模型学习脉络,这份 LLM大模型资料 分享出来:包括LLM大模型书籍、640套大模型行业报告、LLM大模型学习视频、LLM大模型学习路线、开源大模型学习教程等, 😝有需要的小伙伴,可以 扫描下方二维码免费领取🆓**⬇️⬇️⬇️

【大模型全套视频教程】

教程从当下的市场现状和趋势出发,分析各个岗位人才需求,带你充分了解自身情况,get 到适合自己的 AI 大模型入门学习路线。

从基础的 prompt 工程入手,逐步深入到 Agents,其中更是详细介绍了 LLM 最重要的编程框架 LangChain。最后把微调与预训练进行了对比介绍与分析。

同时课程详细介绍了AI大模型技能图谱知识树,规划属于你自己的大模型学习路线,并且专门提前收集了大家对大模型常见的疑问,集中解答所有疑惑!

深耕 AI 领域技术专家带你快速入门大模型

跟着行业技术专家免费学习的机会非常难得,相信跟着学习下来能够对大模型有更加深刻的认知和理解,也能真正利用起大模型,从而“弯道超车”,实现职业跃迁!

【精选AI大模型权威PDF书籍/教程】

精心筛选的经典与前沿并重的电子书和教程合集,包含《深度学习》等一百多本书籍和讲义精要等材料。绝对是深入理解理论、夯实基础的不二之选。

【AI 大模型面试题 】

除了 AI 入门课程,我还给大家准备了非常全面的**「AI 大模型面试题」,**包括字节、腾讯等一线大厂的 AI 岗面经分享、LLMs、Transformer、RAG 面试真题等,帮你在面试大模型工作中更快一步。

【大厂 AI 岗位面经分享(92份)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

【640套 AI 大模型行业研究报告】

【AI大模型完整版学习路线图(2025版)】

明确学习方向,2025年 AI 要学什么,这一张图就够了!

👇👇点击下方卡片链接免费领取全部内容👇👇

抓住AI浪潮,重塑职业未来!

科技行业正处于深刻变革之中。英特尔等巨头近期进行结构性调整,缩减部分传统岗位,同时AI相关技术岗位(尤其是大模型方向)需求激增,已成为不争的事实。具备相关技能的人才在就业市场上正变得炙手可热。

行业趋势洞察:

- 转型加速: 传统IT岗位面临转型压力,拥抱AI技术成为关键。

- 人才争夺战: 拥有3-5年经验、扎实AI技术功底和真实项目经验的工程师,在头部大厂及明星AI企业中的薪资竞争力显著提升(部分核心岗位可达较高水平)。

- 门槛提高: “具备AI项目实操经验”正迅速成为简历筛选的重要标准,预计未来1-2年将成为普遍门槛。

与其观望,不如行动!

面对变革,主动学习、提升技能才是应对之道。掌握AI大模型核心原理、主流应用技术与项目实战经验,是抓住时代机遇、实现职业跃迁的关键一步。

01 为什么分享这份学习资料?

当前,我国在AI大模型领域的高质量人才供给仍显不足,行业亟需更多有志于此的专业力量加入。

因此,我们决定将这份精心整理的AI大模型学习资料,无偿分享给每一位真心渴望进入这个领域、愿意投入学习的伙伴!

我们希望能为你的学习之路提供一份助力。如果在学习过程中遇到技术问题,也欢迎交流探讨,我们乐于分享所知。

*02 这份资料的价值在哪里?*

专业背书,系统构建:

-

本资料由我与鲁为民博士共同整理。鲁博士拥有清华大学学士和美国加州理工学院博士学位,在人工智能领域造诣深厚:

-

- 在IEEE Transactions等顶级学术期刊及国际会议发表论文超过50篇。

- 拥有多项中美发明专利。

- 荣获吴文俊人工智能科学技术奖(中国人工智能领域重要奖项)。

-

目前,我有幸与鲁博士共同进行人工智能相关研究。

内容实用,循序渐进:

-

资料体系化覆盖了从基础概念入门到核心技术进阶的知识点。

-

包含丰富的视频教程与实战项目案例,强调动手实践能力。

-

无论你是初探AI领域的新手,还是已有一定技术基础希望深入大模型的学习者,这份资料都能为你提供系统性的学习路径和宝贵的实践参考,助力你提升技术能力,向大模型相关岗位转型发展。

抓住机遇,开启你的AI学习之旅!

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)