DeepSeek本地化部署教程

随着DeepSeek的火爆盛行,它在多个领域取得了突破性进展,各大厂商纷纷跟进。你是否也跃跃欲试呢?本教程将全方位带领大家,根据以下步骤,可以帮助大家有效避坑,确保一次部署成功。闲话少叙,直接上干货。

随着DeepSeek的火爆盛行,它在多个领域取得了突破性进展,各大厂商纷纷跟进。你是否也跃跃欲试呢?本教程将全方位带领大家零基础部署DeepSeek R1模型,根据以下步骤,可以帮助大家有效避坑,确保一次部署成功。闲话少叙,直接上干货。

误区

在开始之前呢,我们先谈一下大家经常碰到的疑惑:

- “我电脑没有GPU可以运行LLM大模型吗?”

- “GPU太老,是不是跑不了LLM大模型”

- “我要玩AI,是不是必须买GPU,买什么GPU呢?”

- “你连GPU是啥都不知道,玩啥AI”

- “......”

上述诸如此类的问题,是否似曾相识呢?还有很多就不一一罗列啦!

我只想说:GPU是加速卡,有固然好,但运行LLM大模型或AI模型,CPU也未尝不可。

环境准备

本教程的DeepSeek部署,基于以下环境,供大家参考。

- 操作系统:Windows 10 / Ubuntu Linux

- CPU:x86架构 / ARM架构

- 部署工具:Ollama

安装步骤

请按照如下顺序流程逐步操作,成功部署 So Easy!

1、下载Ollama

请根据自己的实际情况,选择下载的版本,各版本安装流程略有差异,但使用方式是一样的。

2、安装Ollama

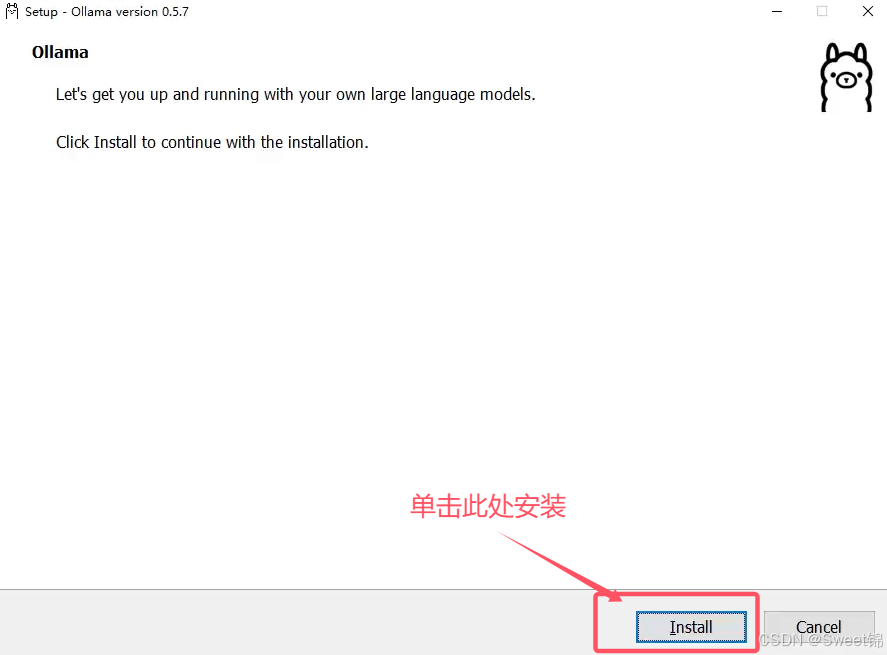

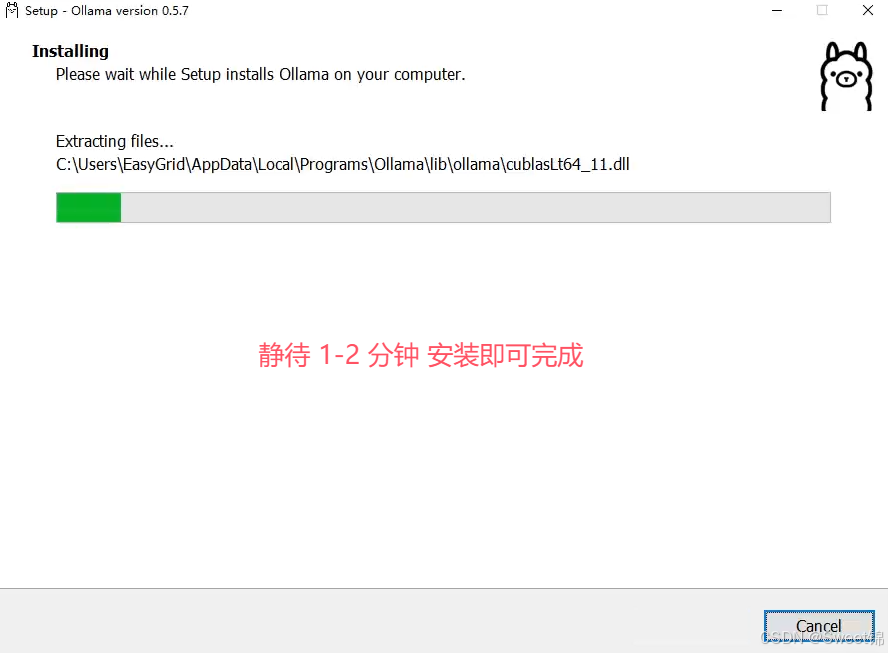

2-1、Ollama Windows版

- 双击安装,安装步骤如下图所示:

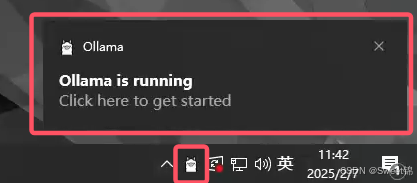

Ollama Windows版本,基本上是一键安装,非常简单,安装完毕后,右小角会出现Ollama小图标。

2-2、Ollama Linux版

(1)通过官方脚本一键安装

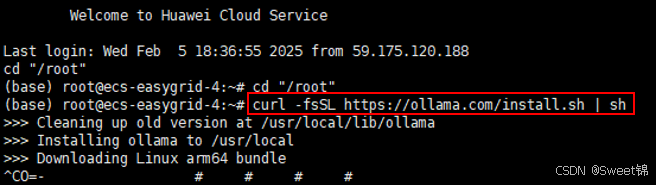

curl -fsSL https://ollama.com/install.sh | sh在Shell中,执行如上脚本,如下图所示:

注:由于众所周知的原因,国内通过此方式安装,堪称龟速,基本上很难成功(采用官方的安装方式,肯定让你痛苦不堪呦)!

(2)手动安装(靠谱)

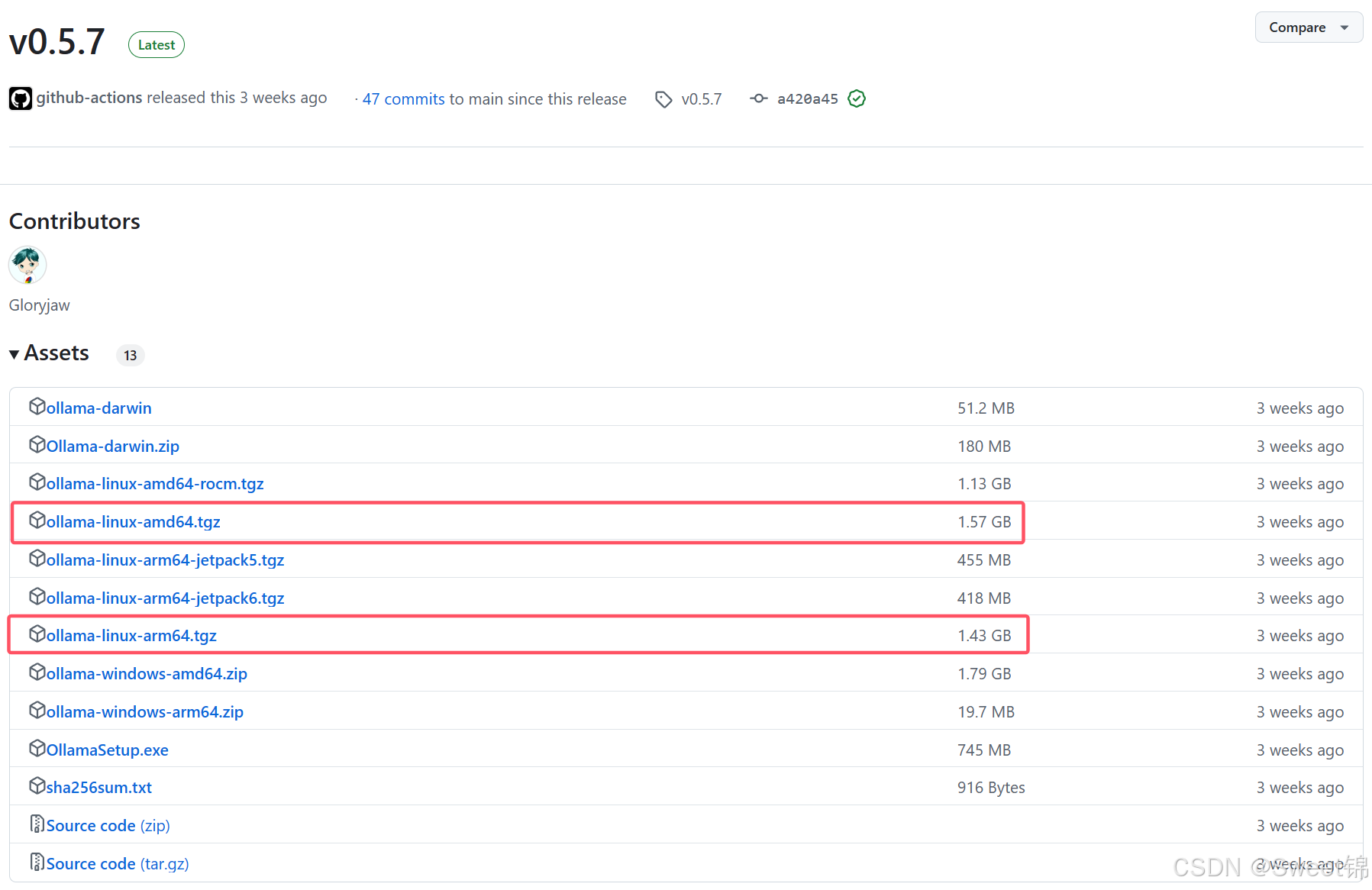

- 从Github下载安装包

Ollama Github Release Page

https://github.com/ollama/ollama/releases/tag/v0.5.7Ollama Linux x86架构下载地址

https://ollama.com/download/ollama-linux-amd64.tgzOllama Linux ARM架构下载地址

https://ollama.com/download/ollama-linux-arm64.tgz注:后两个链接看似是官网地址,实则最后都会跳转到Github下载,只不过会方便一些,它会自动定位到最新版本的安装包。

- 解压安装

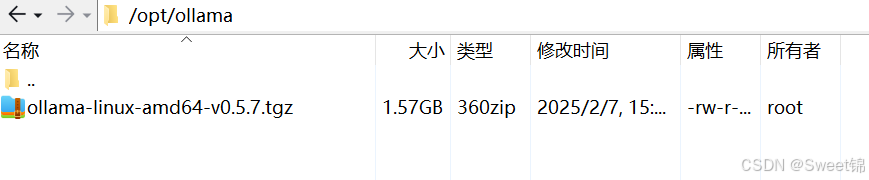

a)在 /opt 目录下创建 ollama 目录:

mkdir /opt/ollamab)将下载的安装包拷贝到此目录,如下图所示:

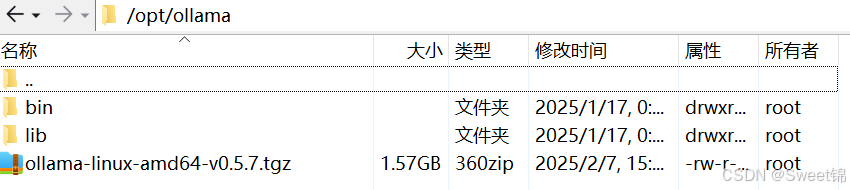

c)进入此目录,并解压

cd /opt/ollamatar -xzvf ollama-linux-amd64-v0.5.7.tgz解压完成后,如下图所示:

- 将 Ollama 添加到环境变量,便于在任意地方使用

将如下内容,添加到 /etc/profile 文件中:

export OLLAMA_HOME=/opt/ollama

export PATH=$OLLAMA_HOME/bin:$PATH使环境变量立即生效:

source /etc/profile- 将 Ollama 作为系统服务,便于开机自动启动

第一步:创建服务文件,并添加配置项

创建文件 /etc/systemd/system/ollama.service

touch /etc/systemd/system/ollama.service添加如下内容到此文件中

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/opt/ollama/bin/ollama serve

User=root

Group=root

Restart=always

RestartSec=3

Environment="OLLAMA_HOST=0.0.0.0"

Environment="OLLAMA_KEEP_ALIVE=-1"

Environment="OLLAMA_MODELS=/opt/ollama/models"

Environment="PATH=$PATH"

[Install]

WantedBy=default.target第三步:启用此服务配置,并启动Ollama服务

sudo systemctl daemon-reload

sudo systemctl enable ollama输出如下内容即成功。

Created symlink /etc/systemd/system/default.target.wants/ollama.service → /etc/systemd/system/ollama.service.启动Ollama服务

sudo systemctl start ollama3、验证Ollama

- 在 cmd 或 shell 中 输入如下命令:

ollama -v输出如下结果,即表示Ollama安装成功

ollama version is 0.5.7部署 DeepSeek R1 模型

DeepSeek R1 模型地址

https://ollama.com/library/deepseek-r1注:在这里可以看到多种尺寸的R1模型,请根据自己的实际需求选择。本教程采用1.5b尺寸的。

- 部署模型

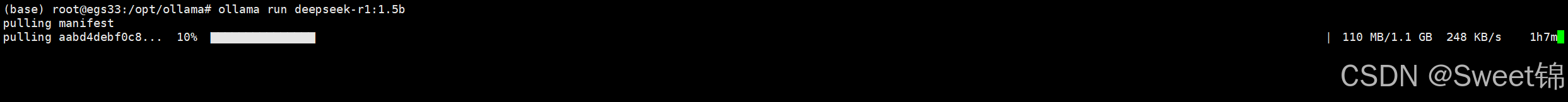

ollama run deepseek-r1:1.5b注:输入此命令后,ollama会自动下载模型并运行,等待完成即可。下载过程如图所示:

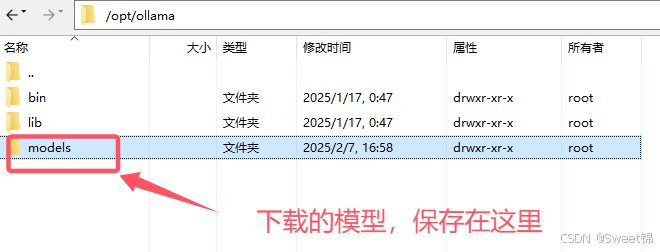

此时,/opt/ollama 目录结构如下:

与 DeepSeek R1 交互

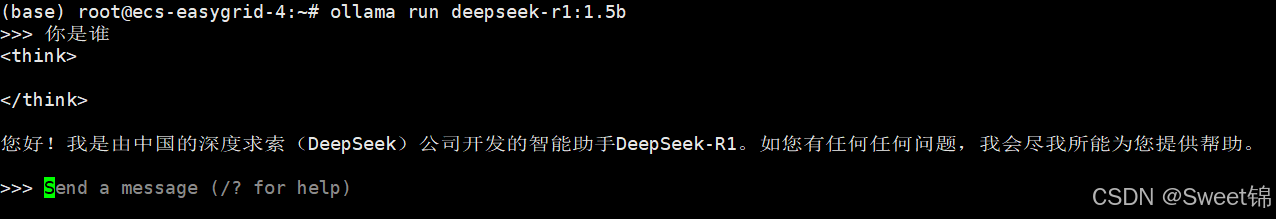

- 通过终端交互,如下图所示:

- 通过REST调用 R1 大模型

curl http://localhost:11434/api/chat -d '{

"model": "deepseek-r1:1.5b",

"messages": [

{

"role": "user",

"content": "你是谁?"

}

],

"stream": false

}'输出结果如下:

{

"model":"deepseek-r1:1.5b",

"created_at":"2025-02-07T09:14:10.124220416Z",

"message": {

"role": "assistant",

"content":"\u003cthink\u003e\n\n\u003c/think\u003e\n\n您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所能为您提供帮助。"

}

,

"done_reason":"stop",

"done":true,

"total_duration":2827133849,

"load_duration":24253134,

"prompt_eval_count":6,

"prompt_eval_duration":105377000,

"eval_count":40,

"eval_duration":2654455000

}至此分享结束!快来自己动手体验吧!

Enjoy It!

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)