【深度学习】如何用PyTorch构建一个VGG16网络?(附代码)

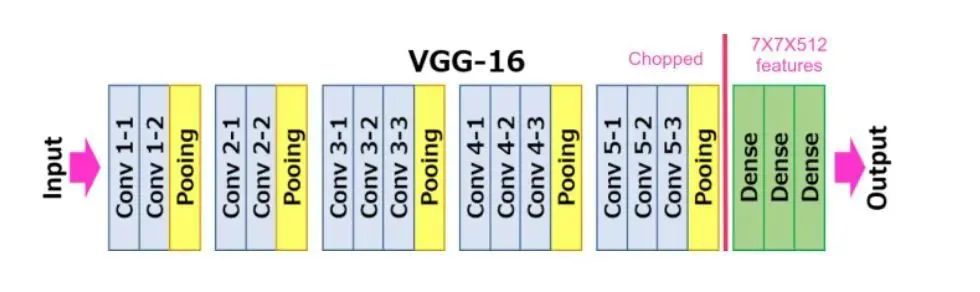

VGG16网络是一个经典的卷积神经网络模型,由Karen Simonyan和Andrew Zisserman于2014年提出。它在ImageNet图像分类比赛中取得了当时最好的成绩,被广泛应用于计算机视觉领域。VGG16网络的主要特点是使用了多个连续的卷积层和池化层,并且在每个卷积层和池化层之后都使用了ReLU激活函数。这种设计可以帮助网络逐步提取图像的特征,使得网络具有更好的表达能力。网络架构

VGG16网络是一个经典的卷积神经网络模型,由Karen Simonyan和Andrew Zisserman于2014年提出。它在ImageNet图像分类比赛中取得了当时最好的成绩,被广泛应用于计算机视觉领域。VGG16网络的主要特点是使用了多个连续的卷积层和池化层,并且在每个卷积层和池化层之后都使用了ReLU激活函数。这种设计可以帮助网络逐步提取图像的特征,使得网络具有更好的表达能力。

网络架构

VGG16网络的具体结构如下:

输入层:的图像

第1段卷积层:卷积核,64个通道

第2段卷积层:卷积核,64个通道

第1个池化层:最大池化

第3段卷积层:卷积核,128个通道

第4段卷积层:卷积核,128个通道

第2个池化层:最大池化

第5段卷积层:卷积核,256个通道

第6段卷积层:卷积核,256个通道

第7段卷积层:卷积核,256个通道

第3个池化层:最大池化

第8段卷积层:卷积核,512个通道

第9段卷积层:卷积核,512个通道

第10段卷积层:卷积核,512个通道

第4个池化层:最大池化

第11段卷积层:卷积核,512个通道

第12段卷积层:卷积核,512个通道

第13段卷积层:卷积核,512个通道

第5个池化层:最大池化

第1个全连接层:4096个神经元

第2个全连接层:4096个神经元

第3个全连接层:1000个神经元(对应ImageNet数据集中的1000个类别)

输出层:Softmax层,用于将神经网络输出转换为各个类别的概率值 总共有16层卷积层和全连接层,因此被称为VGG16。该网络的参数量达到了约1.38亿个,训练需要较长时间和大量的计算资源。

代码实现

构建VGG16网络的PyTorch代码如下:

import torch

import torch.nn as nn

class VGG16(nn.Module):

def __init__(self, num_classes=1000):

super(VGG16, self).__init__()

# 第一段卷积层

self.conv1 = nn.Sequential(

nn.Conv2d(in_channels=3, out_channels=64, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=64, out_channels=64, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=2, stride=2)

)

# 第二段卷积层

self.conv2 = nn.Sequential(

nn.Conv2d(in_channels=64, out_channels=128, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=128, out_channels=128, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=2, stride=2)

)

# 第三段卷积层

self.conv3 = nn.Sequential(

nn.Conv2d(in_channels=128, out_channels=256, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=256, out_channels=256, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=256, out_channels=256, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=2, stride=2)

)

# 第四段卷积层

self.conv4 = nn.Sequential(

nn.Conv2d(in_channels=256, out_channels=512, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=512, out_channels=512, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=512, out_channels=512, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=2, stride=2)

)

# 第五段卷积层

self.conv5 = nn.Sequential(

nn.Conv2d(in_channels=512, out_channels=512, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=512, out_channels=512, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.Conv2d(in_channels=512, out_channels=512, kernel_size=3, stride=1, padding=1),

nn.ReLU(inplace=True),

nn.MaxPool2d(kernel_size=2, stride=2)

)

# 全连接层

self.fc = nn.Sequential(

nn.Linear(in_features=512*7*7, out_features=4096),

nn.ReLU(inplace=True),

nn.Dropout(),

nn.Linear(in_features=4096, out_features=4096),

nn.ReLU(inplace=True),

nn.Dropout(),

nn.Linear(in_features=4096, out_features=num_classes)

)

def forward(self, x):

x = self.conv1(x)

x = self.conv2(x)

x = self.conv3(x)

x = self.conv4(x)

x = self.conv5(x)

x = x.view(x.size(0), -1)

x = self.fc(x)

return x这段代码定义了一个名为VGG16的类,继承自nn.Module。在__init__函数中,定义了VGG16网络的各个层次,包括5段卷积层和3个全连接层。在forward函数中,将输入数据通过各个层次进行前向传播,输出最终的预测结果。需要注意的是,在输入数据时,需要将数据的shape从转换为,可通过torch.transpose函数实现:

# 将输入数据从 [batch, channel, height, width] 转换为 [batch, height, width, channel]

x = torch.transpose(x, 1, 3)此外,这段代码还使用了PyTorch中的各种神经网络模块,如nn.Conv2d、nn.ReLU、nn.MaxPool2d、nn.Linear等,这些模块可以帮助我们方便地定义神经网络,并自动实现反向传播算法,从而加快网络训练的速度。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)