【机器学习】tf.nn.softmax

1、概念softmax是一个激活函数。tf.nn.softmax(logits, # 输入:全连接层(往往是模型的最后一层)的值,一般代码中叫做logitsaxis = None,name = Nonedim = None)作用:softmax函数的作用就是归一化。输入:全连接层(往往是模型的最后一层)的值,一般代码中叫做logits输出:归一化的值,含义是属于该位置的概率,一般代码叫做probs

目录

2、softmax、softmax loss、cross entropy之间的关系

20230515 周一

softmax函数能够将差距大的数值距离拉的更大,from torch.nn.functional.softmax介绍。

1、概念

softmax是一个激活函数。

tf.nn.softmax(

logits, # 输入:全连接层(往往是模型的最后一层)的值,一般代码中叫做logits

axis = None,

name = None

dim = None

)- 作用:softmax函数的作用就是归一化。

- 输入:全连接层(往往是模型的最后一层)的值,一般代码中叫做logits

- 输出:归一化的值,含义是属于该位置的概率,一般代码叫做probs,例如输出[0.4, 0.1, 0.2, 0.3],那么这个样本最可能属于第0个位置,也就是第0类。这是由于logits的维度大小就设定的任务的类别,所以第0个位置就代表第0类。softmax函数的输出不改变维度的大小。(该样本属于各个类的概率)

- 用途:如果做单分类的问题,那么输出的值就取top1(最大, argmax); 如果做多分类问题,那么输出的值就取topN。

2、softmax、softmax loss、cross entropy之间的关系

从全连接层到损失层之间的计算

这张图的等号左边部分就是全连接层做的事,W是全连接层的参数,我们也称为权值,X是全连接层的输入,也就是特征。从图上可以看出特征X是N*1的向量,这是怎么得到的呢?这个特征就是由全连接层前面多个卷积层和池化层处理后得到的,假设全连接层前面连接的是一个卷积层,这个卷积层的输出是100个特征(也就是我们常说的feature map的channel为100),每个特征的大小是4*4,那么在将这些特征输入给全连接层之前会将这些特征flat成N*1的向量(这个时候N就是100*4*4=1600)。解释完X,再来看W,W是全连接层的参数,是个T*N的矩阵,这个N和X的N对应,T表示类别数,比如你是7分类,那么T就是7。我们所说的训练一个网络,对于全连接层而言就是寻找最合适的W矩阵。因此全连接层就是执行WX得到一个T*1的向量(也就是图中的logits[T*1]),这个向量里面的每个数都没有大小限制的,也就是从负无穷大到正无穷大。然后如果你是多分类问题,一般会在全连接层后面接一个softmax层,这个softmax的输入是T*1的向量,输出也是T*1的向量(也就是图中的prob[T*1],这个向量的每个值表示这个样本属于每个类的概率),只不过输出的向量的每个值的大小范围为0到1。

2.1、softmax

共用C个类别(C个节点),第i个节点输出的概率S_i。

z_i如下图,是原始节点的输出,logits。

2.2、cross entropy

在线性回归问题中,常常使用MSE(Mean Squared Error)作为loss函数,而在分类问题中常常使用交叉熵作为loss函数,特别是在神经网络作分类问题时,并且由于交叉熵涉及到计算每个类别的概率,所以交叉熵几乎每次都和sigmoid或者softmax函数一起出现。(sigmoid/softmax + cross entropy)

(1) 二分类

在二分类的情况下,对于每个类别我们的预测的到的概率为p和1-p。此时表达式为:

![]()

其中:

表示样本i的label,正类为1,负类为0

表示样本i预测为正的概率

(2) 多分类(每个类别的损失函数相加)

多分类问题实际上就是对二分类问题的扩展:

其中:

- M 表示类别的数量

表示该类别和样本i类别是否相同,相同为1,不同为0

表示对于观测样本i属于类别j的预测概率

例如:

那么求其Loss:

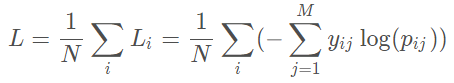

对所有样本的Loss求平均

3、softmax loss结论

先说一下结论

当 cross entropy 的输入 p 是softmax的输出时,cross entropy等于softmax loss。

是输入的概率向量 p 的第 j 个值(

是预测为第 j 个类别的概率,更具体一点

是样本 i 预测为第 j 个类别的概率),所以如果你的概率是通过softmax公式得到的,那么cross entropy就是softmax loss。(i个样本(1-N),j个类别(1-M))

softmax loss如下:

刚才的多分类的cross-entropy是

N个样本(i=1),M个类别(j=1)

首先L是损失。Sj是softmax的输出向量S的第j个值,前面已经介绍过了,Sj表示的是这个样本属于第j个类别的概率。yj前面有个求和符号,j的范围也是1到类别数M,因此y是一个1*M的向量,里面的M个值,而且只有1个值是1,其他M-1个值都是0。那么哪个位置的值是1呢?答案是真实标签对应的位置的那个值是1,其他都是0。所以这个公式其实有一个更简单的形式:

当然此时要限定j是指向当前样本的真实标签。

来举个例子吧。

假设一个5分类问题,然后一个样本I的标签y=[0,0,0,1,0],也就是说样本I的真实标签是4,

1、假设模型预测的结果概率(softmax的输出)p=[0.1,0.15,0.05,0.6,0.1],可以看出这个预测是对的,那么对应的损失L=-log(0.6),也就是当这个样本经过这样的网络参数产生这样的预测 p 时,它的损失是-log(0.6)。

2、那么假设p=[0.15,0.2,0.4,0.1,0.15],这个预测结果就很离谱了,因为真实标签是4,而你觉得这个样本是4的概率只有0.1(远不如其他概率高,如果是在测试阶段,那么模型就会预测该样本属于类别3),对应损失L=-log(0.1)。

3、那么假设p=[0.05,0.15,0.4,0.3,0.1],这个预测结果虽然也错了,但是没有前面那个那么离谱,对应的损失L=-log(0.3)。我们知道log函数在输入小于1的时候是个负数,而且log函数是递增函数,所以-log(0.6) < -log(0.3) < -log(0.1)。

简单讲就是你预测错比预测对的损失要大,预测错得离谱比预测错得轻微的损失要大。

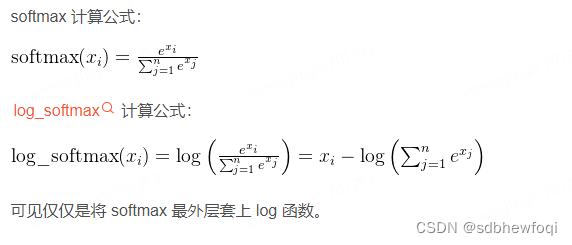

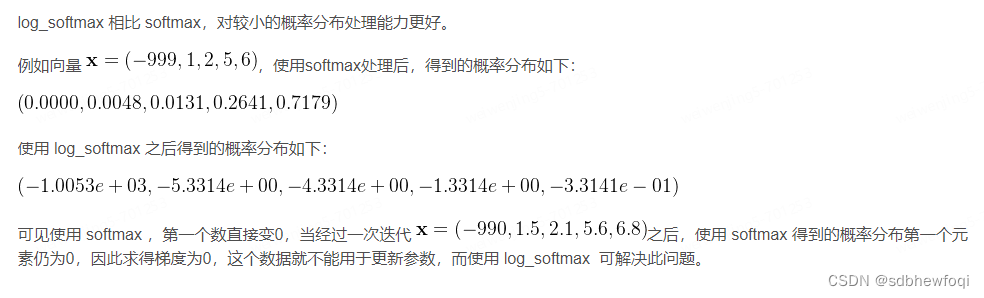

4、torch.nn.functional.log_softmax 函数解析

该函数将输出向量转化为概率分布,作用和softmax一致。

相比softmax,对较小的概率分布处理能力更好。

因此,log_softmax与softmax的区别在于输出的形式不同,softmax输出的是概率分布,而log_softmax输出的是对数概率分布。

在实际应用中,log_softmax通常用于计算损失函数,而softmax则用于预测。

torch.nn.functional.log_softmax 函数解析-CSDN博客

参考:

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)