简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要: InstructGPT通过三阶段训练实现语言模型与人类偏好对齐:1)监督微调(SFT)使模型初步遵循指令;2)奖励模型(RM)学习人类偏好排序;3)强化学习(RLHF)结合PPO算法优化输出,通过KL散度约束平衡创新与稳定性。该方法解决了模型幻觉问题,奠定ChatGPT等技术基础,并推动DPO等后续优化方案的发展。核心创新在于“生成-评价-优化”闭环,首次系统性融合人类反馈,成为大模型对齐

摘要:CLIP(Contrastive Language-Image Pre-training)是OpenAI 2021年提出的多模态预训练模型,通过对比学习将图像与文本语义对齐。其核心突破在于摆脱固定类别标签限制,利用4亿图文对预训练视觉-语言联合表征,实现高效的zero-shot迁移。模型采用双编码器结构(图像/文本),通过对比损失学习跨模态相似性。推理时通过prompt工程将下游任务转化为图

清华大学DeepSeek使用手册

清华大学DeepSeek使用手册

OCR大模型2024-2025最新研究

selective attention简单且无需额外参数的选择性注意力机制,通过选择性忽略不相关信息并进行上下文剪枝,在不增加计算复杂度的情况下显著提升了Transformer模型的语言建模性能和推理效率。

清华大学DeepSeek使用手册

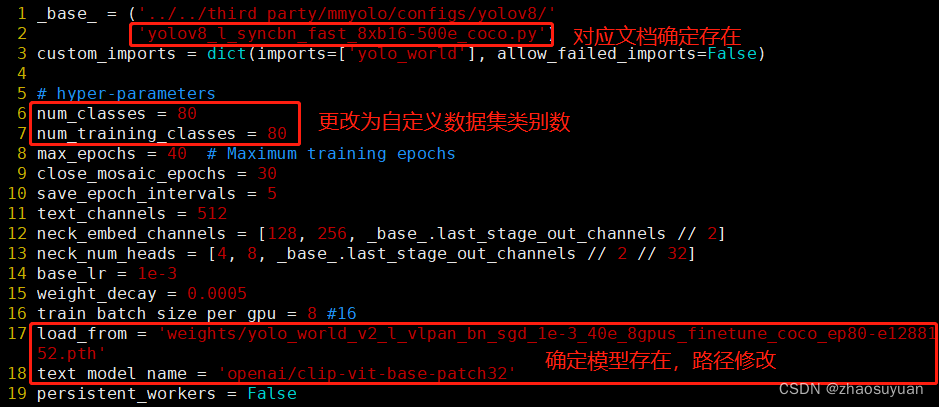

yoloworld训练自定义数据集

GPT-1:核心思想是将无监督学习作用于监督学习模型的预处理目标,先通过在无标签的数据上学习一个通用模型,然后根据问答和常识推理等特定自然语言处理任务微调模型,半监督学习。强化学习:强化学习并不是对数据本身学习,而是在给定的数据环境中,让智能体学习如何选择一系列行动,来达成长期累积收益最大化的目标,强化学习本质是学习一套决策系统而非数据本身。GPT-2:在语言模型领域,所有监督学习都可以看作无监督

torch转onnx。