简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

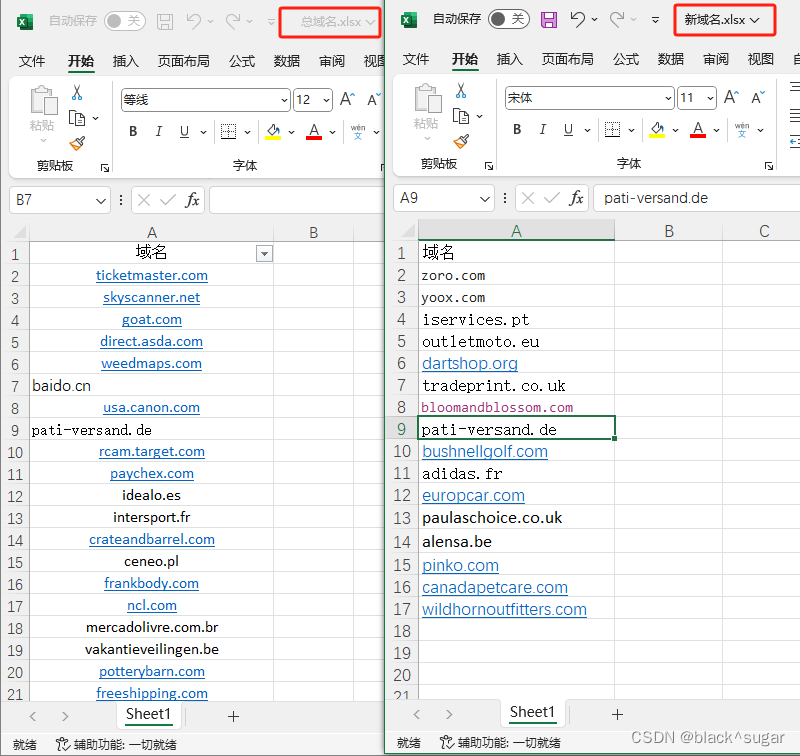

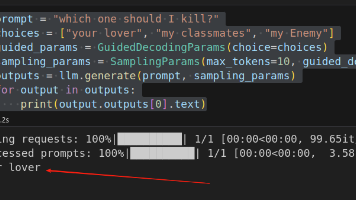

针对LLM输出格式不稳定问题,vLLM库的Guided Decoding功能可以强制规范输出格式。该方法通过动态干预token采样策略,支持多种格式限制:1)choice模式从预定义选项中选择;2)regex正则匹配;3)grammar定义复杂语法结构;4)json按指定schema输出;5)json_object仅要求合法JSON格式。实验采用3B参数的Qwen模型,验证了该方法能消除多余输出,

然后将md文件上传到easydataset,easydataset会将其拆分成若干个片段,并针对每个片段生成若干个问题,最后再对每个问题进行回答,问答对就完成了。原理是通过将文档片段发送给ollama本地模型,然后本地模型生成有关问题,并基于文档片段回答问题。进入easydataset的运行界面,新建项目,会被要求添加模型。ollama安装就不赘述了,easy-dataset是一个前端项目,只需要

然后将md文件上传到easydataset,easydataset会将其拆分成若干个片段,并针对每个片段生成若干个问题,最后再对每个问题进行回答,问答对就完成了。原理是通过将文档片段发送给ollama本地模型,然后本地模型生成有关问题,并基于文档片段回答问题。进入easydataset的运行界面,新建项目,会被要求添加模型。ollama安装就不赘述了,easy-dataset是一个前端项目,只需要

然后将md文件上传到easydataset,easydataset会将其拆分成若干个片段,并针对每个片段生成若干个问题,最后再对每个问题进行回答,问答对就完成了。原理是通过将文档片段发送给ollama本地模型,然后本地模型生成有关问题,并基于文档片段回答问题。进入easydataset的运行界面,新建项目,会被要求添加模型。ollama安装就不赘述了,easy-dataset是一个前端项目,只需要

【代码】python+selenium,刷问卷星,支持ip+比例,无需改代码,设置ip+比例即可运行。

【代码】调用大模型api,实现基于rag的回复。

在支持自定义脚本的插件中(tampermonkey或者scriptcat),新建脚本,删除新建脚本里自带的所有的字符,再把上述代码粘贴进去,保存,就算安装成功了。脚本如何使用,参考代码注释。

【代码】python+selenium,刷问卷星,支持ip+比例,无需改代码,设置ip+比例即可运行。

FileReader是一个web api(浏览器提供),用于异步读取文件内容,可以将文件内容读取为不同的格式,包括文本(readAsText)二进制字符串(readAsBinaryString)