简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

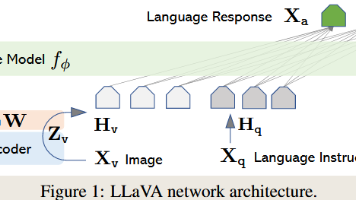

LLaVA系列模型通过创新的视觉-语言对齐架构,推动了多模态AI的发展。关键技术包括:1)使用CLIP/SigLIP视觉编码器提取图像特征;2)采用MLP投影层将视觉特征映射到文本嵌入空间;3)逐步提升输入分辨率(224→672px)并支持动态切块处理;4)优化训练策略(两阶段训练、数据混合)。最新版本LLaVA-NeXT和OneVision进一步增强了OCR能力,支持多图像/视频输入,并通过Si

CLIP沟通文本和图像的桥梁。SOTA的视觉任务模型需要固定的监督数据对,比如-大象,-兔子。这种方式在特定数据集上能够拥有很好的性能,但是在其他未知类别上的性能就会急剧下降。这种监督形式限制了模型的通用性,因为需要额外的数据来重新训练模型。一个识别和的模型并不能识别和。传统的图像任务都是使用one-hot编码进行,每一类都有其独特的数字标签,比如背景为0,是1,是2,计算机只需要将像素分类成0,

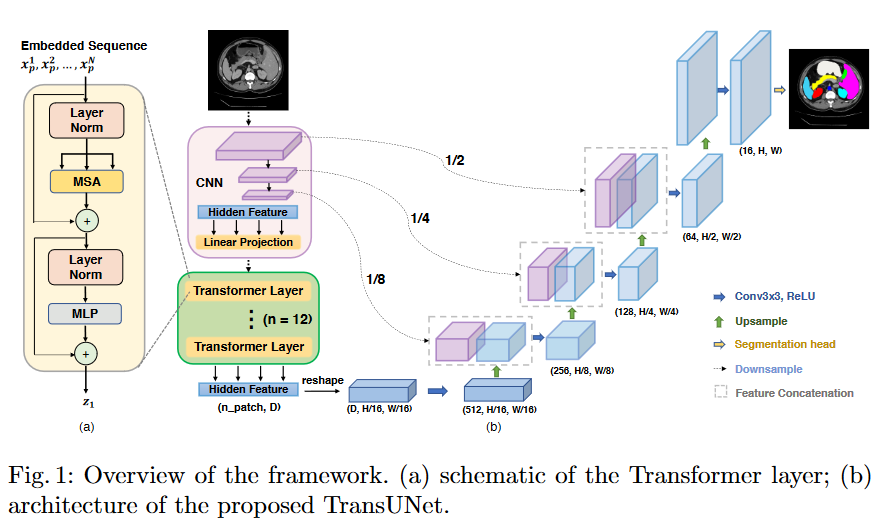

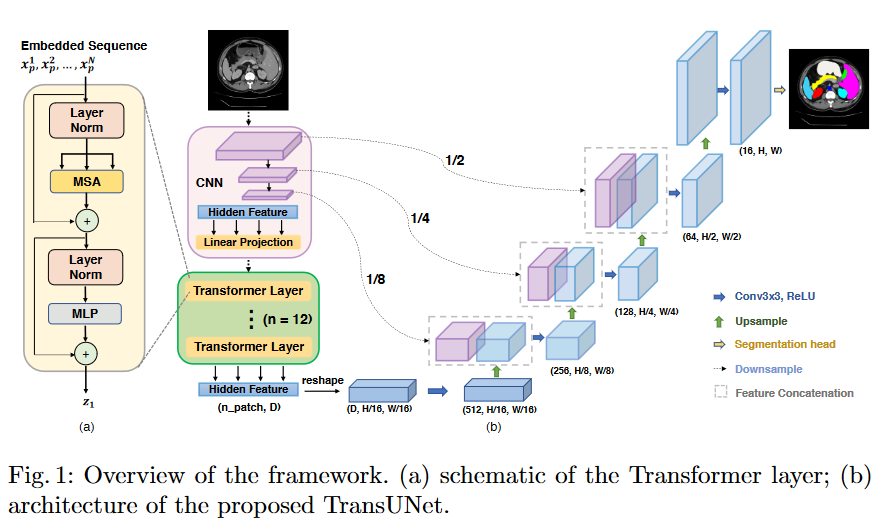

本文介绍了医学图像处理领域的TransUnet模型,TransUnet模型主要由ResNet50、Vision Transformer组成。

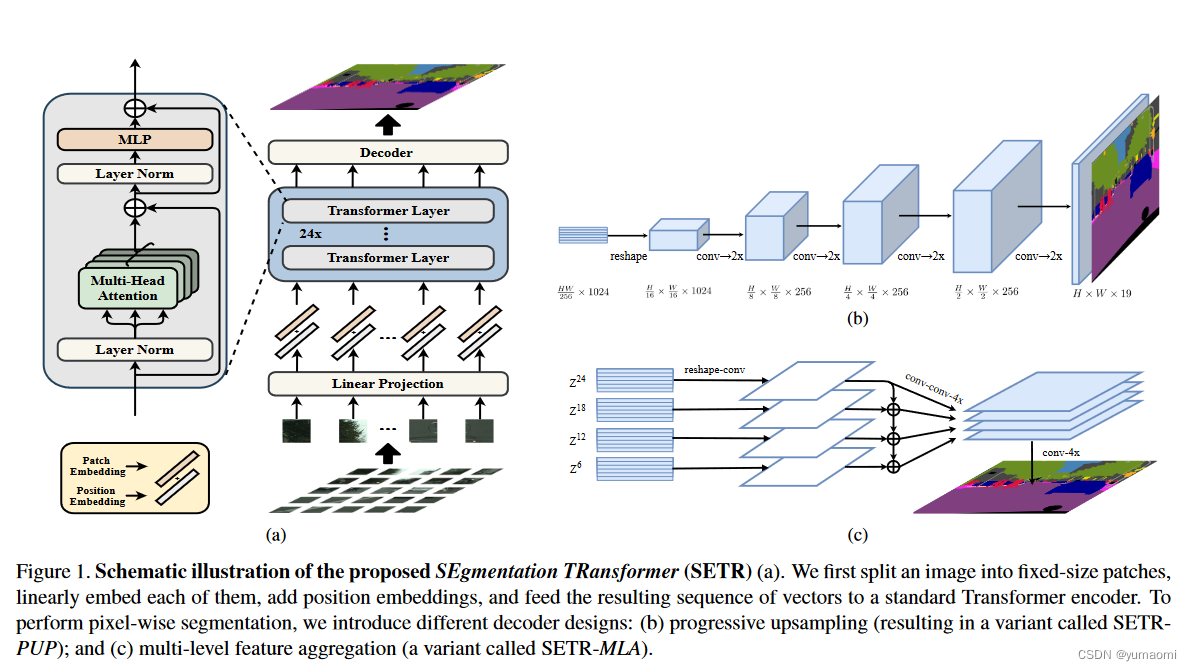

SETR:《Rethinking Semantic Segmentation from a Sequence-to-Sequence Perspectivewith Transformers》重新思考语义分割范式,使用Transformer实现语义分割。本文介绍了SETR和VIT如何在语义分割中实现,介绍了Self-Attention机制和Multi Head Self Attention机制,在

本文介绍了医学图像处理领域的TransUnet模型,TransUnet模型主要由ResNet50、Vision Transformer组成。