简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

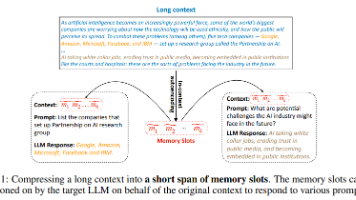

本文提出了一种基于大型语言模型(LLM)的上下文内自编码器(ICAE),通过将长上下文压缩为紧凑记忆槽来优化模型性能。ICAE采用两阶段训练:先在文本数据上通过自编码和语言建模目标进行预训练,再通过指令数据进行微调。实验表明,基于Llama模型的ICAE仅增加1%参数即可实现4倍上下文压缩,显著降低推理延迟和内存消耗,同时保持了良好的信息保留能力。研究还发现ICAE的记忆机制与人类相似,并展示了其

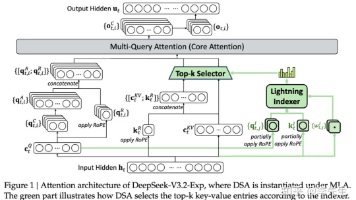

详解DeepSeek V3.2新引技术——“DeepSeek Sparse Attention”(DSA)稀疏注意力机制

本文提出了一种基于大型语言模型(LLM)的上下文内自编码器(ICAE),通过将长上下文压缩为紧凑记忆槽来优化模型性能。ICAE采用两阶段训练:先在文本数据上通过自编码和语言建模目标进行预训练,再通过指令数据进行微调。实验表明,基于Llama模型的ICAE仅增加1%参数即可实现4倍上下文压缩,显著降低推理延迟和内存消耗,同时保持了良好的信息保留能力。研究还发现ICAE的记忆机制与人类相似,并展示了其

手把手教会实现Transformers实战项目——文本分类实例

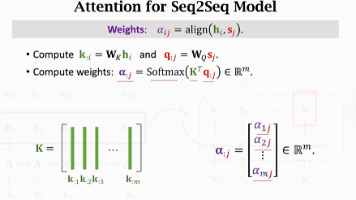

机器翻译——Sequence to Sequence模型介绍,详细讲解Seq2Seq模型底层逻辑,以及实现过程

机器翻译——Sequence to Sequence模型介绍,详细讲解Seq2Seq模型底层逻辑,以及实现过程

一篇文章给你讲明白transformer中的KV缓存

LLM搭模型学习路线第一章节——Prompt提示词工程本文章将带你了解什么是Prompt提示词工程,以及优化提示词的方法

手把手教会实现Transformers实战项目——文本分类实例