简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在强化学习中,奖励函数(Reward Function)和价值函数(Value Function)是两个核心但作用截然不同的概念。以下是它们的详细区别及具体示例:

我们推出了第一代推理模型,DeepSeek-R1-Zero 和 DeepSeek-R1。 DeepSeek-R1-Zero 是一个通过大规模强化学习(RL)训练的模型,没有经过监督微调(SFT)作为初步步骤,展示了卓越的推理能力。通过强化学习,DeepSeek-R1-Zero 自然涌现出许多强大且有趣的推理行为。然而,它也面临一些挑战,例如可读性差和语言混合问题。为了解决这些问题并进一步提升推理性

我们研究了在通用深度神经网络模型中直观物理理解的出现,这些模型经过训练以预测自然视频中被遮掩的区域。利用“违背期望”框架,我们发现,在学习到的表征空间中进行预测的视频模型,能够展示对多种直观物理属性的理解,例如物体永恒性和形状一致性。相比之下,在像素空间中进行视频预测的模型,以及通过文本推理的多模态大型语言模型,其表现更接近随机水平。我们对这些架构的比较表明,同时学习一种抽象表征空间并预测感官输入

本章内容涵盖:- 编写一个类似GPT的大型语言模型($LLM$),该模型可以被训练以生成类人文本- 归一化层激活值以稳定神经网络训练- 在深度神经网络中添加捷径连接,以更有效地训练模型- 实现Transformer模块以创建不同规模的GPT模型- 计算GPT模型的参数数量及存储需求在上一章中,你学习并实现了多头注意力机制,这是大型语言模型的核心组件之一。在本章中,我们将编写大型语言模型的其他构建模

我们推出了第一代推理模型,DeepSeek-R1-Zero 和 DeepSeek-R1。 DeepSeek-R1-Zero 是一个通过大规模强化学习(RL)训练的模型,没有经过监督微调(SFT)作为初步步骤,展示了卓越的推理能力。通过强化学习,DeepSeek-R1-Zero 自然涌现出许多强大且有趣的推理行为。然而,它也面临一些挑战,例如可读性差和语言混合问题。为了解决这些问题并进一步提升推理性

AI视频生成正经历一场革命,其质量和真实感正在迅速提升。这些进展引发了一场激烈的科学辩论:视频模型是否在学习“世界模型”,从而发现物理定律——或者说,它们只是一些精巧的像素预测器,在没有理解现实物理原理的情况下实现视觉真实感?我们通过开发Physics-IQ来回应这一问题,这是一个全面的基准数据集,只有通过对各种物理原理的深入理解才能解决,例如流体动力学、光学、固体力学、磁学和热力学。我们发现,在

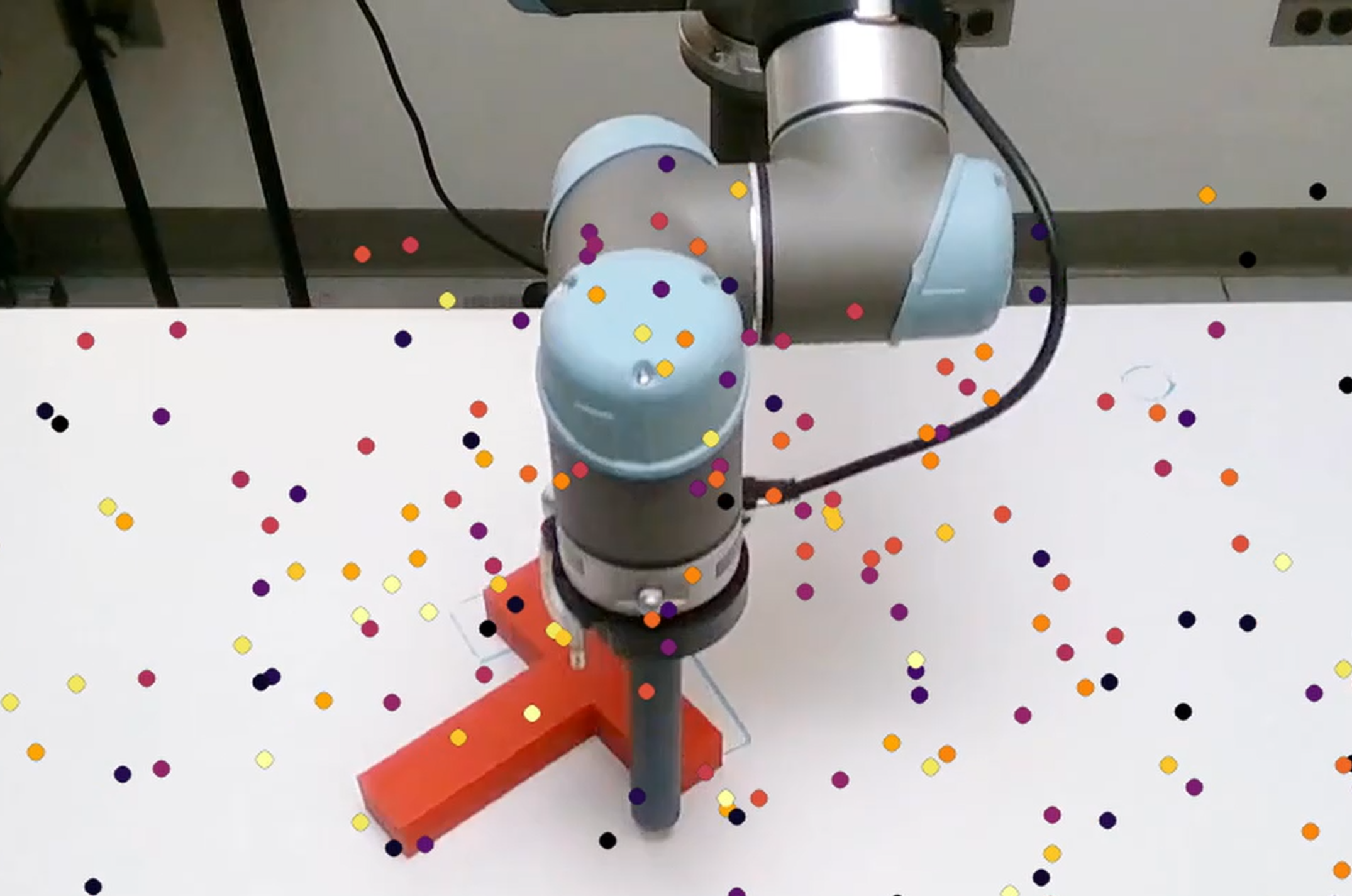

运行官方代码库中提供的Colab代码:vision-based environment(二)(5)

mAP是目标检测中最常用的评估指标,综合反映模型在不同召回率下的平均精度表现。其核心是计算每个类别的平均精度(AP),然后对所有类别的AP取平均。

假设你正在训练一个生成模型(例如变分自编码器,VAE),希望通过神经网络生成逼真的图像。在这个过程中,你需要从某个分布中**随机采样**潜在变量(Latent Variable)来驱动生成过程。但当你尝试直接采样时,会发现一个致命问题:**“随机性”阻断了反向传播的梯度传递**,导致模型无法优化!这就是 **重参数化技巧(Reparameterization Trick)** 诞生的背景。它被广泛

为什么在输入数据时要将形状从 (H, W, 3)(OpenCV的BGR格式)转换为 (3, H, W)(PyTorch的CHW格式)?