简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文深入解析了大模型训练的六种分布式并行策略:基础并行策略(数据并行DP、张量并行TP、流水线并行PP)、长序列并行策略(序列并行SP、上下文并行CP)和稀疏化并行策略(专家并行EP)。作者结合实践经验,详细介绍了每种策略的核心原理、实现方式和优缺点,特别强调了数据并行中的All-Reduce操作、张量并行的矩阵分割技巧以及流水线并行的微批次调度方法。文章还提到ZeRO优化技术如何解决内存瓶颈问题

摘要:GPT-5引入"智能路由器"架构,实现了专家模型的动态协同,标志着大模型从"全能单体"向"专业协同"的范式转变。文章分析了其基于对话类型、任务复杂度、工具需求和用户意图的四大路由决策支柱,对比了其在响应速度、资源优化等方面相较于GPT-4的突破性进步。同时探讨了该架构的技术实现路径、调试困难等挑战,并提供了开源工具构建方案。作者认为

本文介绍了安装LangChain相关开发环境的步骤。通过执行pip install命令,安装了包括langchain、openai、langserve、fastapi、uvicorn和sse_starlette在内的多个Python包及其依赖项。安装过程中自动下载并安装了所需的各种组件,如数据处理库dataclasses-json、网络请求库httpx、高性能JSON解析器orjson等。这些工具

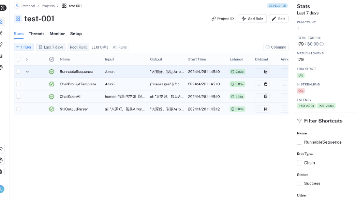

本文介绍了AI生产力工具LangSmith的Tracing功能实操指南。主要内容包括:1)环境准备,需安装相关库并获取API key;2)LangChain程序与LangSmith平台的对接方法;3)使用LangSmith调试Prompt的技巧;4)在线数据标注和收集操作,为后续自动化评估做准备。文章指出LangSmith能有效解决LLM应用生产级维护需求,包括指标监控、Prompt版本管理、系统

ChatGPT 已迅速崛起为全球现象级 AI 工具,每周活跃用户超 7 亿,其中 73% 为非工作场景使用。OpenAI 最新报告显示,用户主要应用集中在七大领域:实用指南(29%)、信息获取(24%)、内容创作(24%)、技术帮助(5%)、多媒体处理(7%)、自我表达(2.4%)等。文章提供了针对这些场景的实用提示模板,如学习辅导、流程指导、创意头脑风暴、信息对比分析等,帮助用户高效获取 AI

本文分享了企业级RAG系统的实战经验。作者基于在制药、金融等行业构建10余个RAG系统的实践,总结了关键挑战和解决方案:1)优先进行文档质量检测并分类处理;2)采用层级化分块策略替代固定分块;3)构建专业领域元数据架构;4)实施混合检索方法。文章详细介绍了文档评分系统、分层检索等技术实现,并对比了不同模型的成本效益(Qwen可节省85%成本)。核心观点认为企业RAG的成功70%依赖工程能力,20%

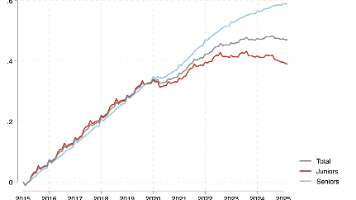

最近一两年,你可能经常听到这样的讨论:“人工智能会不会取代我的工作?“AI工程师饱和了吗?“我现在学什么专业才不会被AI淘汰?这些问题反映的焦虑是真实的,但前提本身就被简化了。无需再纠结于"人工智能将取代所有工作"这样的绝对论断。现实况景远比这复杂得多,其实际影响也更值得我们认真分析。大量证据表明,就业市场正经历结构性、根本性的变革。传统"从初级岗位逐步晋升"的职业路径,已经不再能自动保障成功。但

本文介绍了训练Tokenizer的方法,重点讲解了BPE、WordPiece和Unigram等子词分词算法。BPE通过合并高频字符对构建词表,WordPiece基于语言模型似然选择合并,Unigram则采用概率模型优化词表。文章详细演示了使用Hugging Face库训练BPE Tokenizer的完整流程,包括数据准备、配置设置和模型训练。不同Tokenizer各有优缺点:基于词的方法简单但词表

大模型量化技术概述与实战 本文系统介绍了大语言模型(LLM)量化技术,涵盖从基础概念到前沿算法的全面解析。主要内容包括: 核心概念: 量化目标:降低显存占用和计算成本,同时保持模型性能 量化方式:训练感知量化(QAT)与训练后量化(PTQ) 量化粒度:逐层、逐通道、逐组等不同粒度选择 量化对象:权重、激活值和KV缓存的量化策略差异 经典算法剖析: RTN:最基础的量化方法,适合小模型 LLM.in

大模型数据处理实战:从原始文本到高效数据管道 本文系统介绍了大模型开发中的数据预处理全流程,涵盖环境配置、工具选型到核心分词技术。重点讲解了处理100GB+文本数据的高效方法,包括流式处理原理和分布式计算架构。详细解析了BPE、WordPiece和SentencePiece三种主流分词算法的实现原理与技术特点,并提供了完整的代码示例。文章还分享了数据清洗的关键步骤和优化策略,如HTML标签处理、文