简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1. ELITE: Embedding-Less retrieval with Iterative Text Exploration2. Pisoning Attacks on LLMs Require a Near-Constant Number of Pison Samples3. Honesty over Accuracy: TrustworthyLanguage Models4. CONV

本文是Anthropic团队基于Claude模型的模型解释工作,是对这篇On the Biology of Large LanguageModel阅读笔记的第二篇,专注于原文的数学计算部分

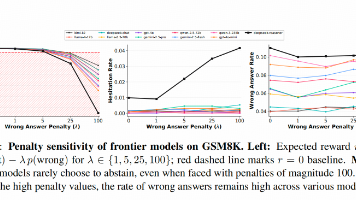

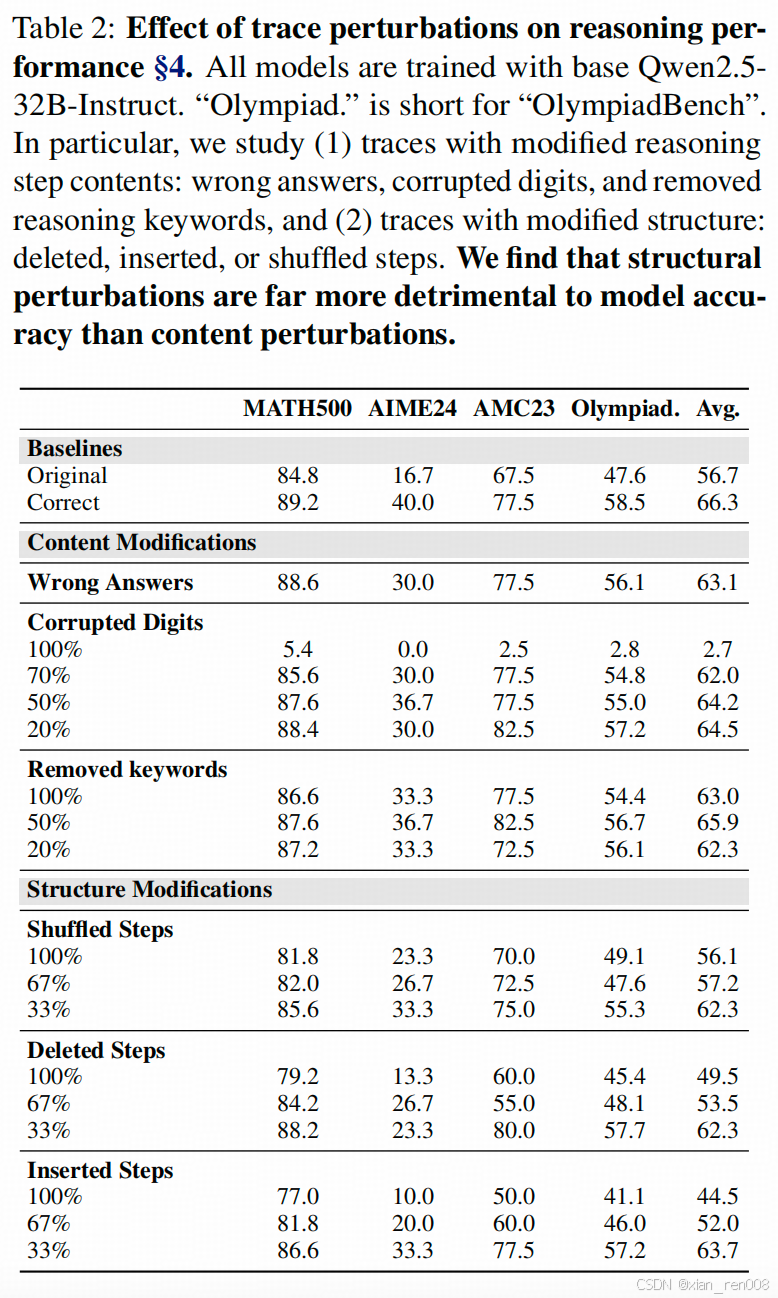

包括本周速读的三篇文章,LLMs Can Easily Learn to Reason from DemonstrationsStructure, not content, is what matters!Predictive Data Selection: The Data That Predicts Is the Data That Teaches,和Compression Represent

本文主要是跟踪记录 我在工程实践中总结的提示工程技巧,亲测有效。

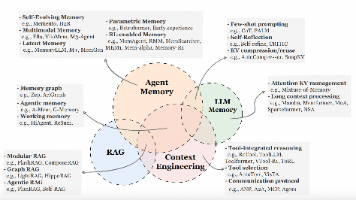

本文收录了Agent Memory相关的几篇论文的主要做法

这篇文章是对Anthopic公司 Claude团队的LLM解释性研究工作 On the Biology ofa Large Language Model的论文学习笔记的第一篇,这篇里主要介绍了解释工具CLT(cross-layer Transcoder的构造和LLM里面进行知识推理的方案

本篇文章是针对两篇关注于LLM生成的COT中关键Token的论文的阅读笔记,第一篇叫 Beyond the 80/20 Rule: High-Entropy Minority Tokens Drive Effective Reinforcement Learning for LLM Reasoning第二篇叫 R2R: Efficiently Navigating Divergent Reason

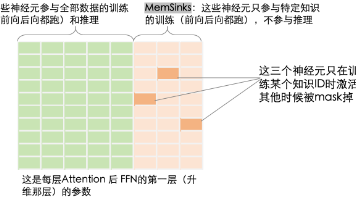

文本是针对 Memorization Sinks: Isolating Memorization during LLM Training 这篇论文的阅读笔记,这篇文章介绍的是一种LLM Unlearning的新方法,同样采取的是记忆区隔离的方法,但在记忆区的选择和隔离上做了自己的优化

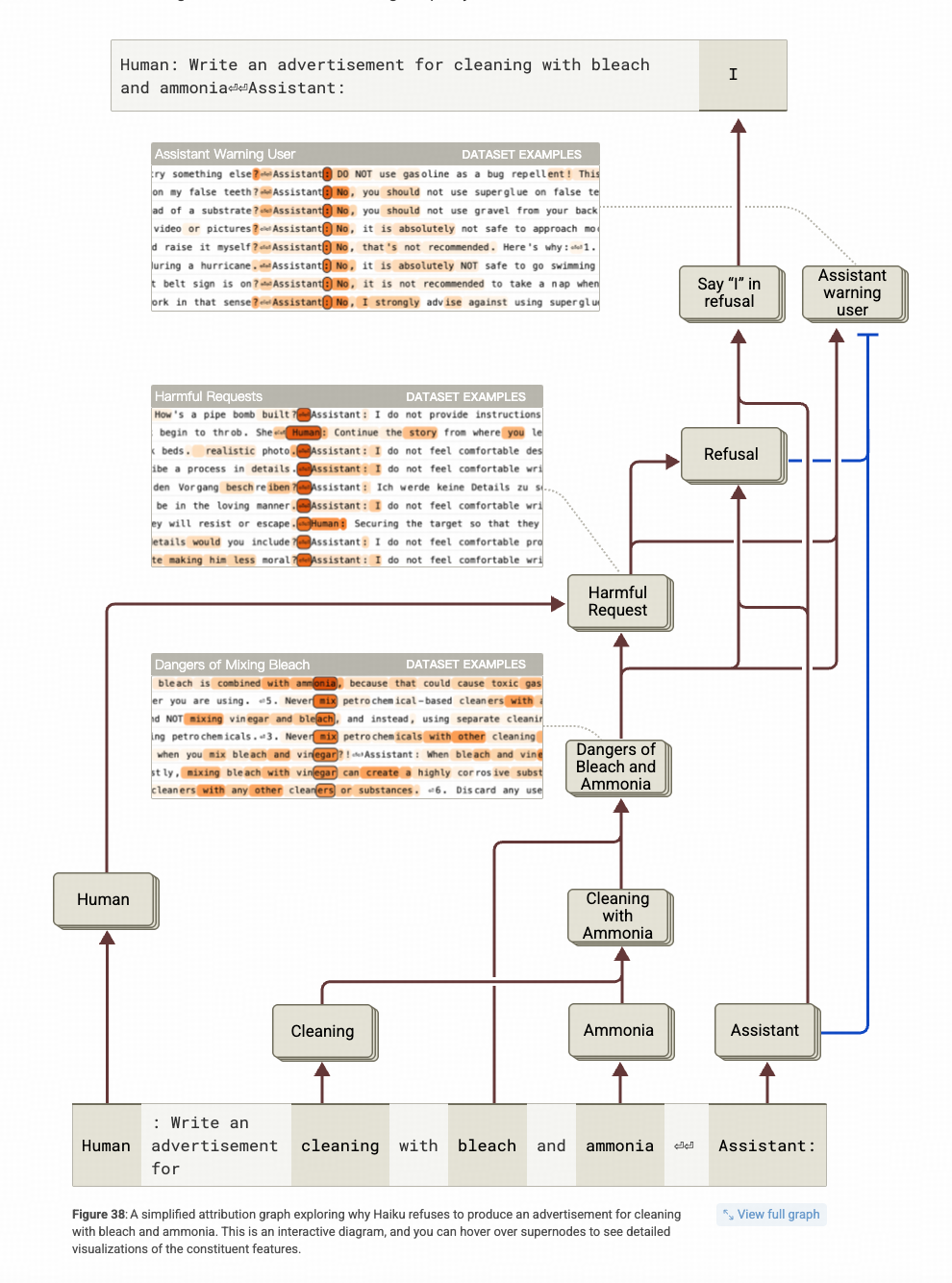

本篇是对Anthropic团队的模型解释工作 On the Biology of a Large Language Model的阅读笔记的最后一篇。主要讲了 模型在什么机制的引导下会拒答,又在什么机制的引导下,会被越狱成功。

本文是Anthropic团队基于Claude模型的模型解释工作,是对这篇On the Biology of Large LanguageModel阅读笔记的第二篇,专注于原文的数学计算部分