简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

我们从一个抽象基类(ABC)开始,定义一个标准接口,所有 LLM 引擎包装器都必须遵循它。这确保了一致性和可互换性。任何继承自 EngineLM 类都必须实现generate方法。pass在这里,我们定义了 ChatVLLM 类,它是 EngineLM 接口的具体实现。该类负责格式化提示、调用 vLLM 服务器的 API 以及解析响应。

我们从一个抽象基类(ABC)开始,定义一个标准接口,所有 LLM 引擎包装器都必须遵循它。这确保了一致性和可互换性。任何继承自 EngineLM 类都必须实现generate方法。pass在这里,我们定义了 ChatVLLM 类,它是 EngineLM 接口的具体实现。该类负责格式化提示、调用 vLLM 服务器的 API 以及解析响应。

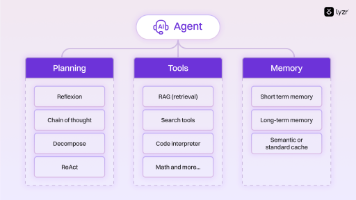

其次,LLM 能够提供此类反馈。对于涉及多个方面的复杂任务,如果每个方面都由单独的 LLM 调用来处理,则 LLM 通常表现更佳,这样可以集中精力关注每个特定方面。当任务复杂性较高时,我们可以使用workflows的可预测性和一致性优点来解决流程固定的任务,而智能体则更适合需要大规模灵活性和模型驱动决策的场景。在LLM应用领域,成功的关键不在于构建最复杂的系统,而在于构建最符合自身需求的系统。从简

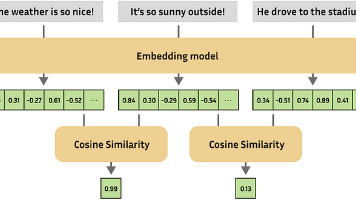

使用nltk进行切块,这样便于llm更好的处理。我们配置了 Matryoshka 损失函数 ,指定了用于截断嵌入的维度。内部损失函数 MultipleNegativesRankingLoss(可参考:https://sbert.net/examples/sentence_transformer/training/matryoshka/README.html) 可帮助模型

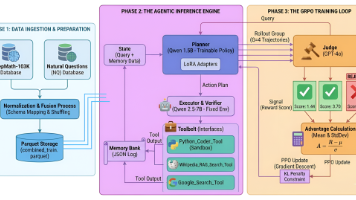

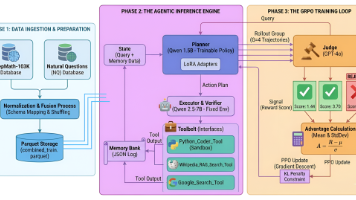

我们介绍第一代推理模型:DeepSeek-R1-Zero 和 DeepSeek-R1。DeepSeek-R1-Zero 是一个完全通过大规模强化学习(RL)训练而无需监督微调(SFT)作为初步步骤的模型,展示了显著的推理能力。通过RL,DeepSeek-R1-Zero 自然地展现出许多强大且有趣的推理行为。然而,它也遇到了一些挑战,如可读性差和语言混合问题。为了解决这些问题并进一步提高推理性能,我

想象一下,你和一个朋友聊天,他总是忘记你说过的所有话,每次对话都从零开始。你是什么感受?不幸的是,如今大多数人工智能系统都是如此。它们确实很智能,但却缺少一个至关重要的东西:记忆。我们先来谈谈人工智能中“记忆”的真正含义以及它为何如此重要。

将AI Agent视为一个功能强大的助手,他需要明确的指令和相关信息才能做好工作。上下文工程是设计和管理围绕 AI Agent的信息生态系统(称为“上下文”)的过程。这是为了在正确的时间以正确的格式向代理提供正确的信息,以便它能够准确有效地执行任务。与侧重于制定单一、措辞良好的指令的提示工程不同,上下文工程是更广泛的系统级方法,它涉及编排指令、对话历史记录、记忆和外部数据等多个组件来指导代理的行为

在开始之前,让我们先介绍一下RAG基础知识。RAG 主要包括两个步骤: 检索 (从数据库中查找相关信息)和生成 (使用 GPT 等 LLM 根据检索到的信息生成响应)。这有助于帮助LLM在真实数据中生成正确答案来避免“幻觉”(编造事实)。示例:您问人工智能:“气候变化政策的最新情况是什么?”,传统的 RAG 会将查询嵌入为向量,在向量数据库中搜索文档中的类似文本块,并将它们提供给 LLM 以获得响

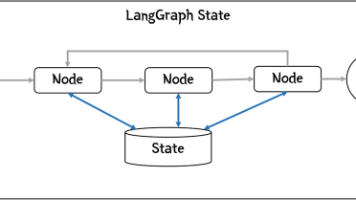

GraphState 类会定义智能体需要的字段,StateGraph会返回一个用于构建图的构建器,在构建器上逐渐增加node和edge,从而可以构建完整的Graph。

ChatGPT 发布: 2022 年 11 月 30 日,OpenAI 推出了基于 GPT-3.5 的 ChatGPT,这是首个主流的语言学习管理(LLM)应用。ChatGPT 保留了用户熟悉的聊天机器人界面,但其背后是经过庞大互联网语料库训练的先进语言学习管理技术。Transformer 架构: GPT(生成式预训练 Transformer)基于 Google 于 2017 年推出的 Trans