简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

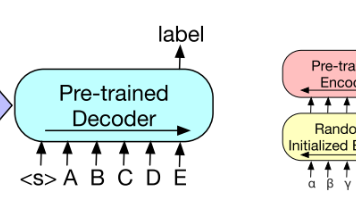

【论文阅读】BART: Denoising Sequence-to-Sequence Pre-training for NaturalLanguage Generation, Translation

作者使用最近提出的ELI5数据集来测试模型生成长自由格式答案的能力。我们发现BART比以前最好的工作高出1.2 ROUGE-L,但数据集仍然具有挑战性,因为答案仅由问题弱指定。

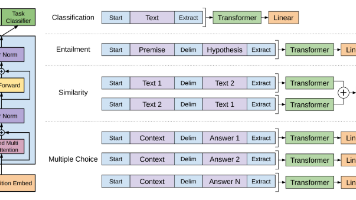

【论文阅读】Improving Language Understandingby Generative Pre-Training

自然语言理解包括文本蕴涵、问题回答、语义相似度评估和文档分类等广泛的任务。尽管大量未标记的文本语料库丰富,但用于学习这些特定任务的标记数据很少,这使得判别训练模型难以充分执行。我们证明,通过在不同的未标记文本语料库上对语言模型进行生成式预训练,然后对每个特定任务进行判别性微调,可以实现这些任务的巨大收益。与以前的方法相反,我们在微调期间利用任务感知输入转换来实现有效的传输,同时需要对模型体系结构进

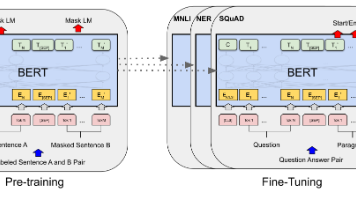

【论文阅读】BERT:Pre-training of Deep Bidirectional Transformers forLanguage Understanding

我们引入了一种新的语言表示模型BERT,它代表来自transformer的双向编码器表示。与最近的语言表示模型(Peters et al., 2018a;Radford et al., 2018)不同,BERT旨在通过在所有层中对左右上下文进行联合条件反射,从未标记的文本中预训练深度双向表示。因此,预训练的BERT模型可以通过一个额外的输出层进行微调,从而为广泛的任务(如问答和语言推理)创建最先进

到底了