简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

还是习惯了用CSDN的编辑方式,因为旁边可以看到写了啥。DQN-ETF强化学习-滚动-经验保存反复学习版AI强化学习ETF策略-DQN智能体-滚动训练简单etf动量轮动策略simple_etf_1这里为simple_etf_2的初始版本实验。因为还是初始的一个成功,这里先记录下流程。和前言1的对比如下:两者的滑点,交易时间,佣金设置相同下,etf也相同下:收益上,现在比之前策略要好,但是持有体验上

前一阵一直学c++ ,今天终于算学了个大概,把之前一段搞的分布式通信记录下。ROS的版本:Melodic板子:Jeson Nano 4GB镜像:ubuntu 18.04首先要在电脑上装ros才可以实现分布式通信,主要是为了在电脑上运行rviz,nano装小车上跑rviz有点耗算力。还没在电脑上装ROS的直接跳到第四步。提示:以下是本篇文章正文内容,下面案例可供参考其他在另外板子上实现分布式通信也是

本学期的大作业,要求完成多智能体PPO的乒乓球对抗环境,这里我使用IPPO的方法来实现。【游戏ai】从强化学习开始自学游戏ai-1非侵入式玩像素小鸟的第一部分。想着这次做IPPO的自博弈,应该会好上手不少,但是实际情况,这个Pettingzoo里的环境,还是有些bug的,经过修改后,可以达到良好的效果。效果见:(欢迎star)

这里为复现论文ddpg时,遇到的4个细节,及如何将它实现。参考复现代码:等等(其余相关参考会细节处体现)适用于:已经知道ddpg原理,但发现借用的代码不work时,来寻求更符合原论文代码的人群。FreeRL(欢迎star)ddpg在原论文是针对continue环境提出的,这里仅实现了continue形式的ddpg,后续有空会再补写一个离散域环境的ddpg。即使有了一个好的框架和算法,DDPG还是会

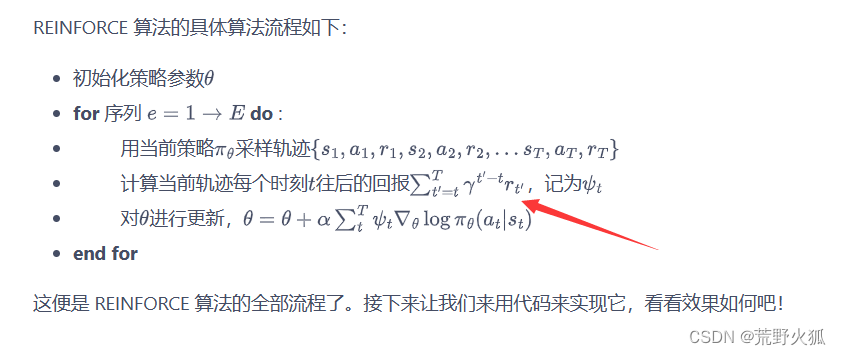

参考:《动手学强化学习》作者:张伟楠,沈键,俞勇动手学强化学习 网页版动手学强化学习 github代码动手学强化学习 视频强化学习入门这一篇就够了!!!万字长文(讲的很好)强化学习入门(第二版)读书笔记我做了一个思维导图很方便理解之后学习完会在这里一直更新。补充一下要下载的库#第5章#第7章这里仅记录下学习时遇到的问题,已经学了一个月了,只是忙于毕设没空来更新一下学习进度,发现踏入门槛后学习强化学

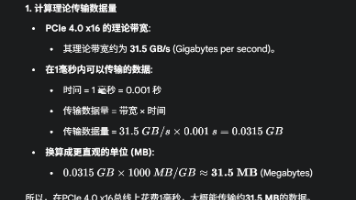

简单记录下配置强化学习电脑需要注意的,和了解的。2024年618个人装机:硬盘可以改成 致钛tiplus7100 1tb都可以当时差不多1.5w差不多,618下来1.3w左右,现在在同等价格下配置还能再高一点。

本学期的大作业,要求完成多智能体PPO的乒乓球对抗环境,这里我使用IPPO的方法来实现。【游戏ai】从强化学习开始自学游戏ai-1非侵入式玩像素小鸟的第一部分。想着这次做IPPO的自博弈,应该会好上手不少,但是实际情况,这个Pettingzoo里的环境,还是有些bug的,经过修改后,可以达到良好的效果。效果见:(欢迎star)

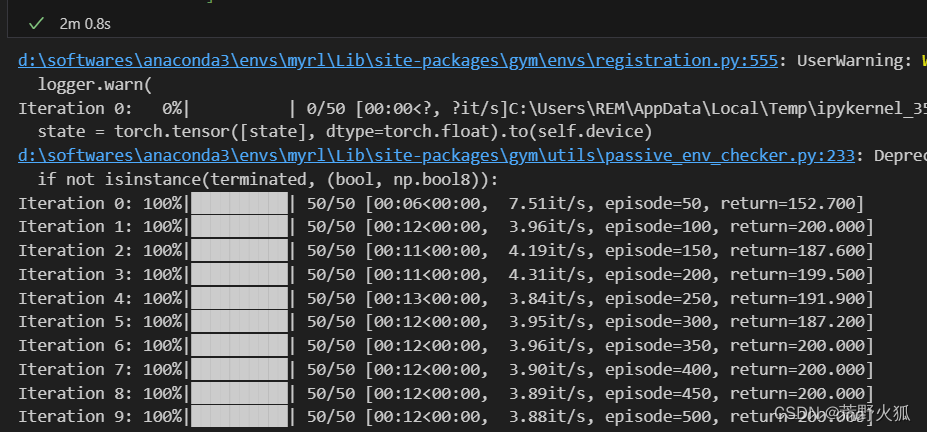

将其中所有的trick都用上即为Rainbow_DQN。效果如下:(学习曲线)具体实现细节,代码中有较为详细的阐述。

一般来说,对于ppo这种类在线策略的深度学习算法:1、对于原代码全是gpu训练的(上面例子),需要改三处,注意第三处,可改可不改第4处。2、全cpu训练的,前两处加的不变,第三处的修改有变化,:(这里也要特别注意,否则也会报同时用两个设备的错误)即:在模型训练时,把所有要计算的tensor张量加到gpu中。如下所示:顺口记法:对于在线的策略(无经验池的策略),大体框架改两处,对应设备改一处,否则会

按导师要求学习了一下多目标强化学习,我看的论文是论文题目:A Generalized Algorithm for Multi-Objective Reinforcement Learning and Policy Adaptation(一种用于多目标强化学习和策略适应的广义算法)复现代码:暂未上传复现结果:环境为gym的deep-sea-treasure-v0环境。