简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

成为创作者,源于亚马逊AWS的Codewhisperer,现在它已改名叫Amazon Q 了,但我对CSDN的创作热情还是一如既往。简单来说,就是打开灵犀X1的脑子(里面本来是空的),把手机装进去,用性价比更高、功能更丰富、算力更强、普及率更广的手机,来当它的脑子。有了这个开源,我们就可以基于智元的核心组件,打造自己的人形机器人产品,并借助开源代码快速完成整机工程,降低了研发成本和门槛。这一年来,

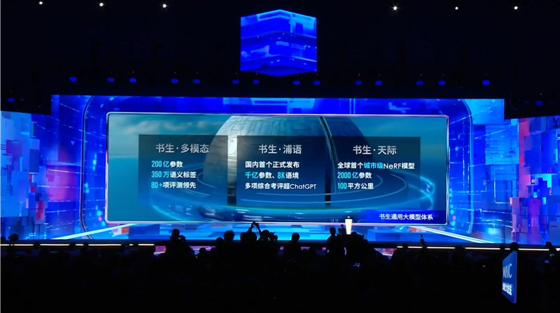

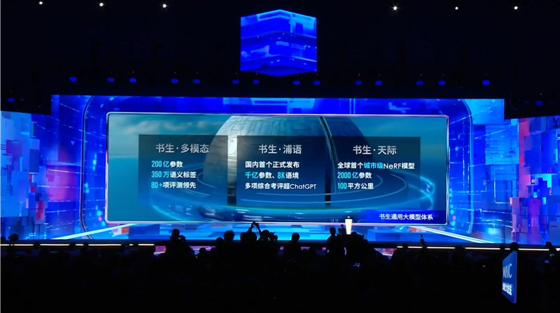

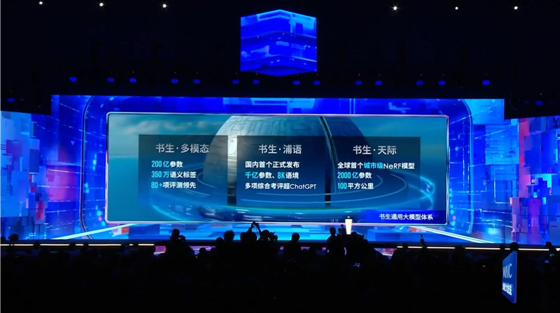

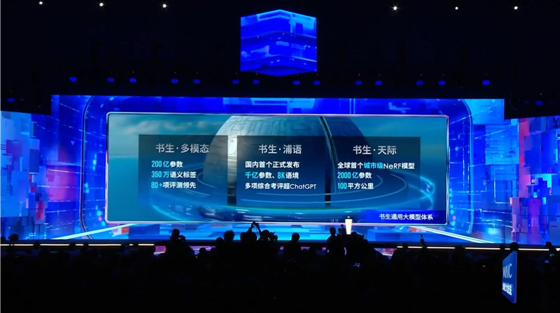

在人工智能的发展道路上,大模型无疑成为了重要的突破口。从专用模型到通用大模型,它们在解决特定任务和应对多种任务、多种模态方面都展现出了强大的能力。本文记录书生浦语大模型的开源历程及其全链路开源体系。

传统的预训练策略主要依赖于大规模语料库的迭代训练,然而,这种方法在模型规模不断扩大时,面临着训练效率低下、计算资源消耗巨大等问题。为此,InternLM2提出了进化式预训练策略——InternEvo。

在人工智能的发展道路上,大模型无疑成为了重要的突破口。从专用模型到通用大模型,它们在解决特定任务和应对多种任务、多种模态方面都展现出了强大的能力。本文记录书生浦语大模型的开源历程及其全链路开源体系。

在人工智能的发展道路上,大模型无疑成为了重要的突破口。从专用模型到通用大模型,它们在解决特定任务和应对多种任务、多种模态方面都展现出了强大的能力。本文记录书生浦语大模型的开源历程及其全链路开源体系。

lnternLM是一个基于互联网的大型语言模型,它是基于Transformer架构构建的,包含数十亿个参数。

lnternLM是一个基于互联网的大型语言模型,它是基于Transformer架构构建的,包含数十亿个参数。

模型部署是指将训练好的模型在特定环境中运行的过程,以便将其应用到实际生产中。这个过程需要解决模型框架兼容性和运行速度的问题。LMDeploy是一个用于部署大模型的工具箱,由上海人工智能实验室开发。它使用C++/CUDA进行推理,并对外提供Python/gRPC/HTTP接口和WebUI界面。LMDeploy支持tensor parallel分布式推理,并支持fp16/weightint4/kv c

Finetune中文译为“微调”,深度学习中需要在深层网络中不断进行训练更新模型的参数(权重)拟合能实现预期结果的模型。“微调”的原理就是利用已知的网络结构和已知的网络参数,修改output层为我们自己的层,微调最后一层前的若干层的参数,这样就有效利用了。

传统的预训练策略主要依赖于大规模语料库的迭代训练,然而,这种方法在模型规模不断扩大时,面临着训练效率低下、计算资源消耗巨大等问题。为此,InternLM2提出了进化式预训练策略——InternEvo。