简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要: 本文探讨了在视觉大模型(VLM)结构化信息抽取中,如何在无法提供样例(few-shot)的情况下通过提示词工程确保数据真实性。核心策略包括:1)严格禁止默认选项,强制模型基于实际图像内容输出;2)建立“所见即所得”的绑定关系,防止模型脑补;3)通过JSON Schema精确约束输出格式。文章提出将抽象原则转化为可执行规则,如OCR未识别时输出空字符串、选项编号与物理位置严格对应等,使提示词

摘要: 提示词质量比模型选择更能决定大语言模型结构化信息抽取项目的成败。文章总结了从非结构化文本提取字段的三阶段提示词演进:1)基础规则版(定义模糊);2)边界强化版(硬性触发条件);3)示例增强版(判例驱动)。关键发现是few-shot示例的影响力超过抽象规则,需覆盖真实复杂场景并严格对齐规则。通过将提示词视为"可测试的规格文档",采用结构化模板、强约束表达和迭代闭环机制,可

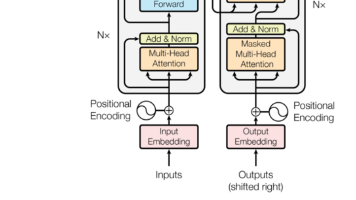

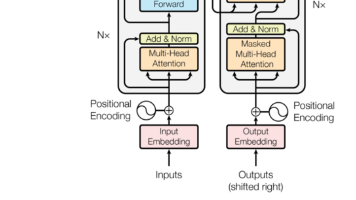

Transformer输入部分的三个关键细节:1)词嵌入乘以√d_model以平衡词向量和位置编码的幅度,防止位置编码淹没语义信息;2)使用register_buffer注册位置编码,使其随模型保存但不参与训练;3)相加时用[:,:x.size(1)]动态截取位置编码,适配不同长度的输入序列。这些机制共同确保输入信息(语义+位置)的有效融合和稳定训练。

《大模型时代的量化与微调技术:QLoRA的突破与实现》 文章摘要: 本文深入探讨大语言模型(LLM)在实际应用中的落地挑战与解决方案。随着模型参数规模膨胀至数十亿甚至数千亿,传统全参数微调方法面临严峻的硬件资源限制。为解决这一难题,研究社区提出了模型量化和参数高效微调(PEFT)两条路径。其中,QLoRA技术通过4-bit量化、分块处理、双重量化等创新方法,首次实现在24GB显存的消费级GPU上微

Transformer架构中位置编码(PE)采用"相加"而非其他方式融合词向量的原因可概括为:1)保持语义与位置信息的可分离性;2)不破坏词向量原有分布;3)天然兼容注意力计算;4)计算高效;5)经过实践验证。其本质是注入位置信息而不干扰语义表示,这一设计理念在RoPE等现代编码方案中得以延续。对于RAG开发者而言,理解PE原理有助于优化文档切分、检索和生成效果。

LoRA微调技术解析:高效适配大模型的实用指南 LoRA(低秩自适应)是一种参数高效的大模型微调方法,通过冻结原始模型权重、仅训练小型适配器模块,显著降低计算资源需求。其核心原理是将权重变化矩阵分解为两个低秩矩阵的乘积,使参数量减少1-2个数量级。关键超参数秩r的选择需平衡任务复杂度(简单任务r=4-8,复杂任务r=16-32)和数据量(少量数据用小秩防过拟合)。实战中,LoRA优势显著:消费级显

LoRA微调技术解析:高效适配大模型的实用指南 LoRA(低秩自适应)是一种参数高效的大模型微调方法,通过冻结原始模型权重、仅训练小型适配器模块,显著降低计算资源需求。其核心原理是将权重变化矩阵分解为两个低秩矩阵的乘积,使参数量减少1-2个数量级。关键超参数秩r的选择需平衡任务复杂度(简单任务r=4-8,复杂任务r=16-32)和数据量(少量数据用小秩防过拟合)。实战中,LoRA优势显著:消费级显

《大模型时代的量化与微调技术:QLoRA的突破与实现》 文章摘要: 本文深入探讨大语言模型(LLM)在实际应用中的落地挑战与解决方案。随着模型参数规模膨胀至数十亿甚至数千亿,传统全参数微调方法面临严峻的硬件资源限制。为解决这一难题,研究社区提出了模型量化和参数高效微调(PEFT)两条路径。其中,QLoRA技术通过4-bit量化、分块处理、双重量化等创新方法,首次实现在24GB显存的消费级GPU上微

Transformer架构中位置编码(PE)采用"相加"而非其他方式融合词向量的原因可概括为:1)保持语义与位置信息的可分离性;2)不破坏词向量原有分布;3)天然兼容注意力计算;4)计算高效;5)经过实践验证。其本质是注入位置信息而不干扰语义表示,这一设计理念在RoPE等现代编码方案中得以延续。对于RAG开发者而言,理解PE原理有助于优化文档切分、检索和生成效果。

Transformer输入部分的三个关键细节:1)词嵌入乘以√d_model以平衡词向量和位置编码的幅度,防止位置编码淹没语义信息;2)使用register_buffer注册位置编码,使其随模型保存但不参与训练;3)相加时用[:,:x.size(1)]动态截取位置编码,适配不同长度的输入序列。这些机制共同确保输入信息(语义+位置)的有效融合和稳定训练。