简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大模型自我反思被定义为两阶段的问同一个问题,但是思考多次。

大模型自我反思被定义为两阶段的问同一个问题,但是思考多次。

hdparm 测试中,7112 MB/s 的缓存读取速度表示从内存(RAM)直接读取数据的理论极限速度(依赖内存性能),而236 MB/s 的缓冲磁盘读取速度反映物理磁盘(如硬盘或SSD)的实际连续读取性能,两者差异源于内存(电子传输)和磁盘(物理/接口限制)的本质区别。一般来说大模型都是10GB以上的,但是我发现服务器上面的机械硬盘只有 700KB/s的加载速度,这十分慢。在运行程序的时候,我发

我在跑大模型推理的时候,遇到了上面的错误。首先有一个问题需要考虑:我希望模型可以在gpu上面推理,但是我默认了模型会自动加载到gpu上面。。。解决方法检查llama模型是不是正确加载到gpu,一半出现 c10:Half 这个类型,模型很大概率是加载到CPU上面去推理的,所以只要修改到gpu上就不会报错了模型推理的时候,记得加上autocase最后代码因为是修改R2genGPT的,所以代码如下:

hdparm 测试中,7112 MB/s 的缓存读取速度表示从内存(RAM)直接读取数据的理论极限速度(依赖内存性能),而236 MB/s 的缓冲磁盘读取速度反映物理磁盘(如硬盘或SSD)的实际连续读取性能,两者差异源于内存(电子传输)和磁盘(物理/接口限制)的本质区别。一般来说大模型都是10GB以上的,但是我发现服务器上面的机械硬盘只有 700KB/s的加载速度,这十分慢。在运行程序的时候,我发

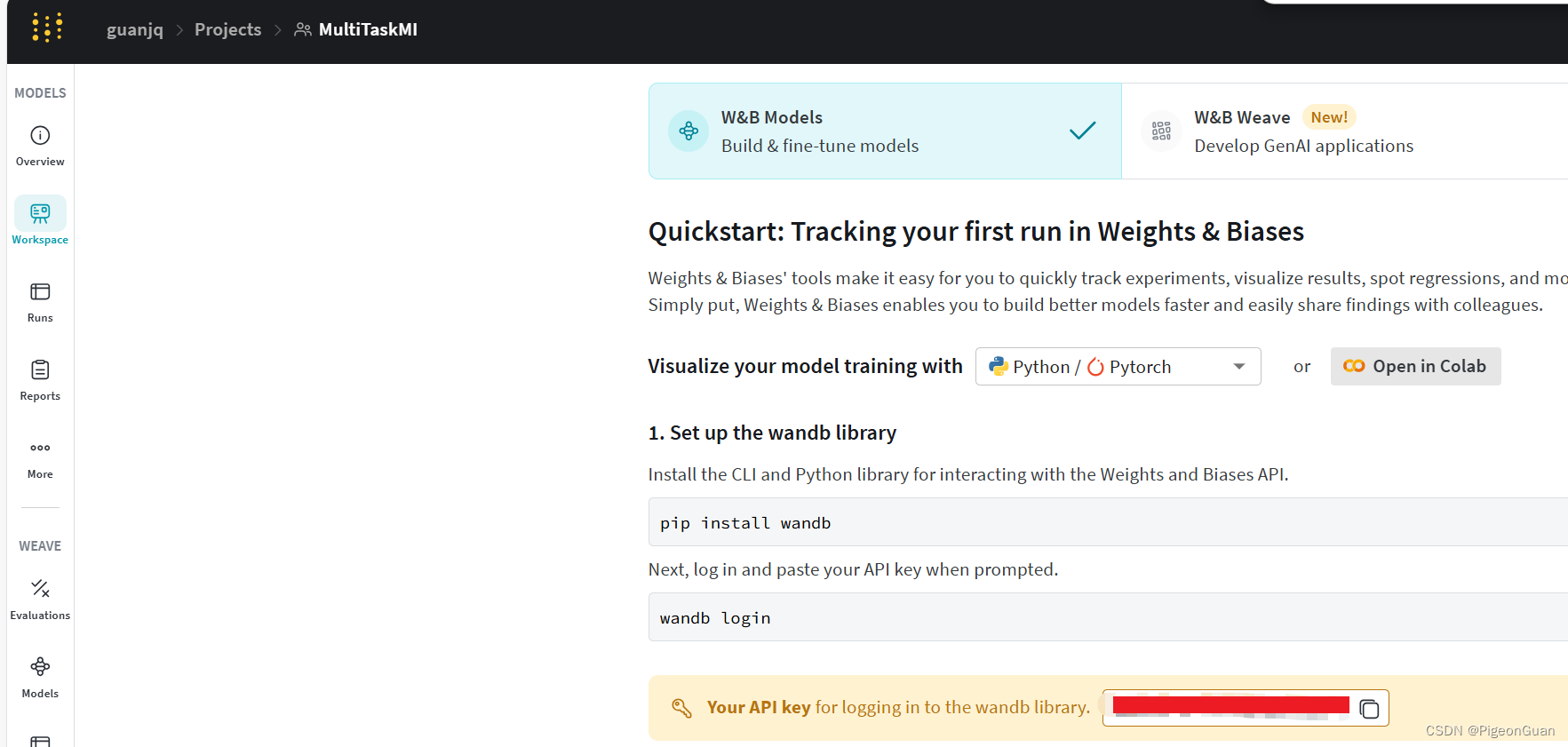

好像新建一个项目会显示api key,目前还没有找到api key显示的地方(x。