简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Transformer模型采用Encoder-Decoder架构处理序列数据。Encoder通过多头自注意力机制提取输入特征,Decoder结合掩码自注意力和编码器输出来生成输出。关键组件包括:1)BPE分词和位置编码处理输入;2)多头自注意力捕捉上下文关系;3)Decoder使用掩码防止信息泄露。该架构在NLP和CV领域均有应用,如Vision Transformer通过图像分块嵌入适配视觉任务

论文摘要:该研究系统评估了处理表格数据的深度学习方法,指出当前模型因测试标准不一而难以比较的问题。作者提出了两个简单高效的基线模型:ResNet-like架构和改良的FT-Transformer,通过统一实验框架在11个数据集上验证其性能。实验表明,FT-Transformer综合表现最优且稳定,但传统梯度提升树(GBDT)仍具竞争力。研究还开发了基于注意力机制的特征重要性解释方法,为表格数据深度

论文摘要:该研究系统评估了处理表格数据的深度学习方法,指出当前模型因测试标准不一而难以比较的问题。作者提出了两个简单高效的基线模型:ResNet-like架构和改良的FT-Transformer,通过统一实验框架在11个数据集上验证其性能。实验表明,FT-Transformer综合表现最优且稳定,但传统梯度提升树(GBDT)仍具竞争力。研究还开发了基于注意力机制的特征重要性解释方法,为表格数据深度

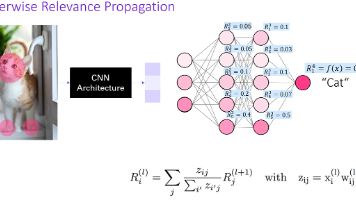

本文提出了一种改进Transformer模型可解释性的新方法。针对现有注意力可视化方法(如Attention Rollout)存在的模糊性和无关区域高亮问题,作者基于Deep Taylor分解原理,提出融合梯度信息和相关性传播的解决方案。该方法通过创新性地处理Transformer特有的自注意力机制和跳跃连接结构,实现了更准确、类别特定的决策过程可视化。实验表明,该方法在图像分类和文本情感分析任务