简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

由于Transformers提出的目的是为了解决NLP领域的问题,导致先前以Transformers为变种的序列模型,都是以点为注意力去进行序列预测,这其实会导致信息利用瓶颈。针对这一问题,Autoformer提出了自相关机制(Auto-Correlation Mechanism)代替自注意力机制,使得模型以序列的形式,选取过去重要的序列片段,做为值得注意的序列片段,而非以某个点的形式。同时,Au

大模型,即大语言模型(LLM),指大规模语言模型(LLM)是指包含数千亿(或更多)参数的Transformer语言模型。这些模型是在大规模文本数据上进行训练的,例如GPT-3,PaLM和LLaMA。LLM展现了理解自然语言和解决复杂任务(通过文本生成)的强大能力。目前,LLM以Transformer为主要架构,Transformer相对于传统的RNN架构,所有token可以同时捕捉长距离依赖关系,

大模型,即大语言模型(LLM),指大规模语言模型(LLM)是指包含数千亿(或更多)参数的Transformer语言模型。这些模型是在大规模文本数据上进行训练的,例如GPT-3,PaLM和LLaMA。LLM展现了理解自然语言和解决复杂任务(通过文本生成)的强大能力。目前,LLM以Transformer为主要架构,Transformer相对于传统的RNN架构,所有token可以同时捕捉长距离依赖关系,

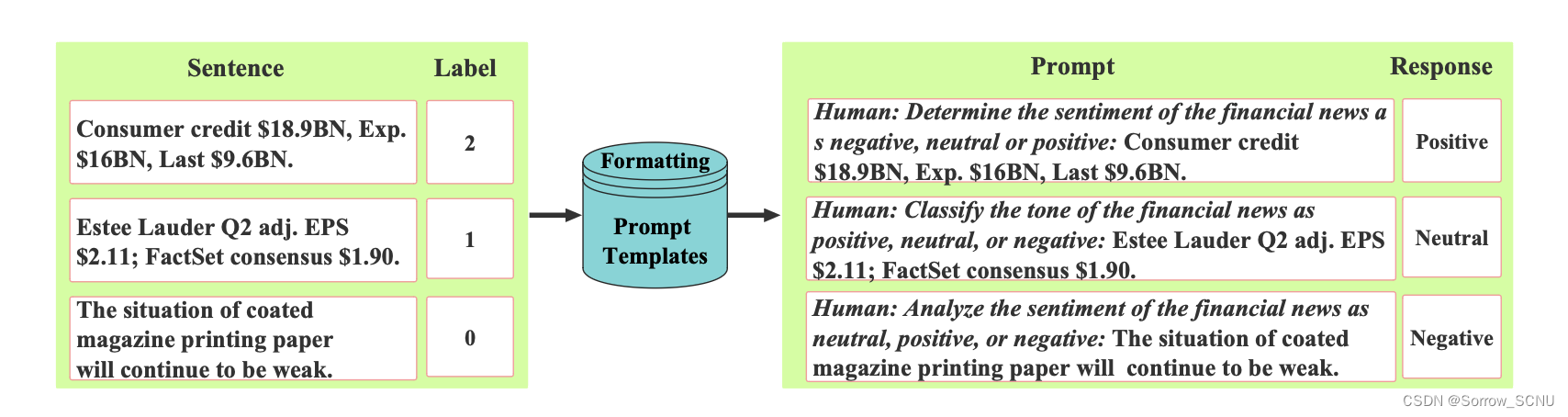

该文章利用LLM(大语言模型)进行可解释的金融时间序列预测。专注于NASDAQ-100股票数据集,并且利用公开的历史股票价格、公司信息数据、最近的金融新闻,对公开的LLAMA-13B模型进行基于指令的微调。通过性能对比后,发现微调后LLM可以理解指令并生成可解释的预测并实现合理的性能,同时如果对LLM加以COT方法指导,效果将会更好。本文章主要针对金融领域的情感分析,利用金融领域的文章、新闻、社交

大模型,即大语言模型(LLM),指大规模语言模型(LLM)是指包含数千亿(或更多)参数的Transformer语言模型。这些模型是在大规模文本数据上进行训练的,例如GPT-3,PaLM和LLaMA。LLM展现了理解自然语言和解决复杂任务(通过文本生成)的强大能力。目前,LLM以Transformer为主要架构,Transformer相对于传统的RNN架构,所有token可以同时捕捉长距离依赖关系,

大模型,即大语言模型(LLM),指大规模语言模型(LLM)是指包含数千亿(或更多)参数的Transformer语言模型。这些模型是在大规模文本数据上进行训练的,例如GPT-3,PaLM和LLaMA。LLM展现了理解自然语言和解决复杂任务(通过文本生成)的强大能力。目前,LLM以Transformer为主要架构,Transformer相对于传统的RNN架构,所有token可以同时捕捉长距离依赖关系,

大模型,即大语言模型(LLM),指大规模语言模型(LLM)是指包含数千亿(或更多)参数的Transformer语言模型。这些模型是在大规模文本数据上进行训练的,例如GPT-3,PaLM和LLaMA。LLM展现了理解自然语言和解决复杂任务(通过文本生成)的强大能力。目前,LLM以Transformer为主要架构,Transformer相对于传统的RNN架构,所有token可以同时捕捉长距离依赖关系,