简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

是一个大模型训练与微调框架,旨在简化大规模语言模型(LLM)的微调、评估和部署流程,帮助开发者和研究人员更高效地定制和优化模型。

在同一集群内整合 NVIDIA、AMD、Apple Silicon、昇腾、海光、摩尔线程 等异构 GPU/NPU,兼容 Linux、Windows、macOS,把分散设备汇聚为可共享的算力池,提升资源利用率并降低 TCO。提供 OpenAI 兼容 API、RBAC 认证与访问控制、配额/计量、全链路可观测,支持从 Hugging Face 快速部署开源模型,业务侧几乎零改造接入。平台侧进行最佳

Ubantu22系统部署RAGFLOW,在之前的博文中记录过,有需要的可以点击查看linux服务器部署ragflow+ollamaUbantu系统离线部署ollama可参考博文基于linux服务器Ubantu20.04的离线Ollama安装(手动安装成功)请注意区分ollama版本,最新的最好,至少要满足拉取需要模型的要求本篇教程从ollama拉取deepseek并连接上RAGFLOW开始。

RAGFlow 可以为各种规模的企业及个人提供一套精简的 RAG 工作流程,结合大语言模型(LLM)针对用户各类不同的复杂格式数据提供可靠的问答以及有理有据的引用。是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种 LLM 运行器,如 Ollama 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。四、知识库内容召回对

它支持在Linux、Windows、macOS上管理 NVIDIA、AMD、Apple Silicon、昇腾、海光、摩尔线程等异构 GPU,覆盖 LLM、VLM、Embedding、Reranker、扩散图像、语音 STT/TTS 等多类型模型提供OpenAI 兼容 API 与可视化控制台,便于快速搭建企业级私有模型服务。项目采用Apache License 2.0,代码托管于 GitHub。

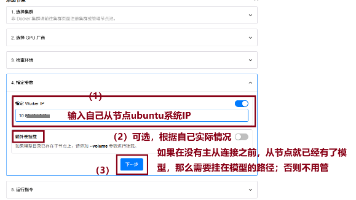

部署服务器要求:操作系统:Ubuntu 22.04 / CentOS 7.6 64 位系统CPU/内存:4C/8GB 以上磁盘空间:100GB对应的查看命令如下(1)查看操作系统版本(2)查看cpu信息lscpu(3)查看内存信息free -h(4)查看磁盘空间df -h。

是一个可扩展、功能丰富且用户友好的自托管 AI 平台,旨在完全离线运行。它支持各种 LLM 运行器,如 Ollama 和 OpenAI 兼容的 API,并内置了 RAG 推理引擎,使其成为强大的 AI 部署解决方案。

想要让RAGFLOW利用GPU资源跑起来,可以选择docker-compose-gpu.yml启动。(但是官网启动案例是×86平台的不是NVIDIA GPU的,docker-compose-gpu.yml又是第三方维护,所以稍有问题)下面是修改后的完整docker-compose-gpu.yml文件,可以直接复制。

是一个大模型训练与微调框架,旨在简化大规模语言模型(LLM)的微调、评估和部署流程,帮助开发者和研究人员更高效地定制和优化模型。