简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

论文分享➲ Improving Reasoning Performance in Large Language Models via Represen | 通过表征工程提升大语言模型的推理性能

通过简单的表征工程,无需训练即可提升LLM的推理性能。

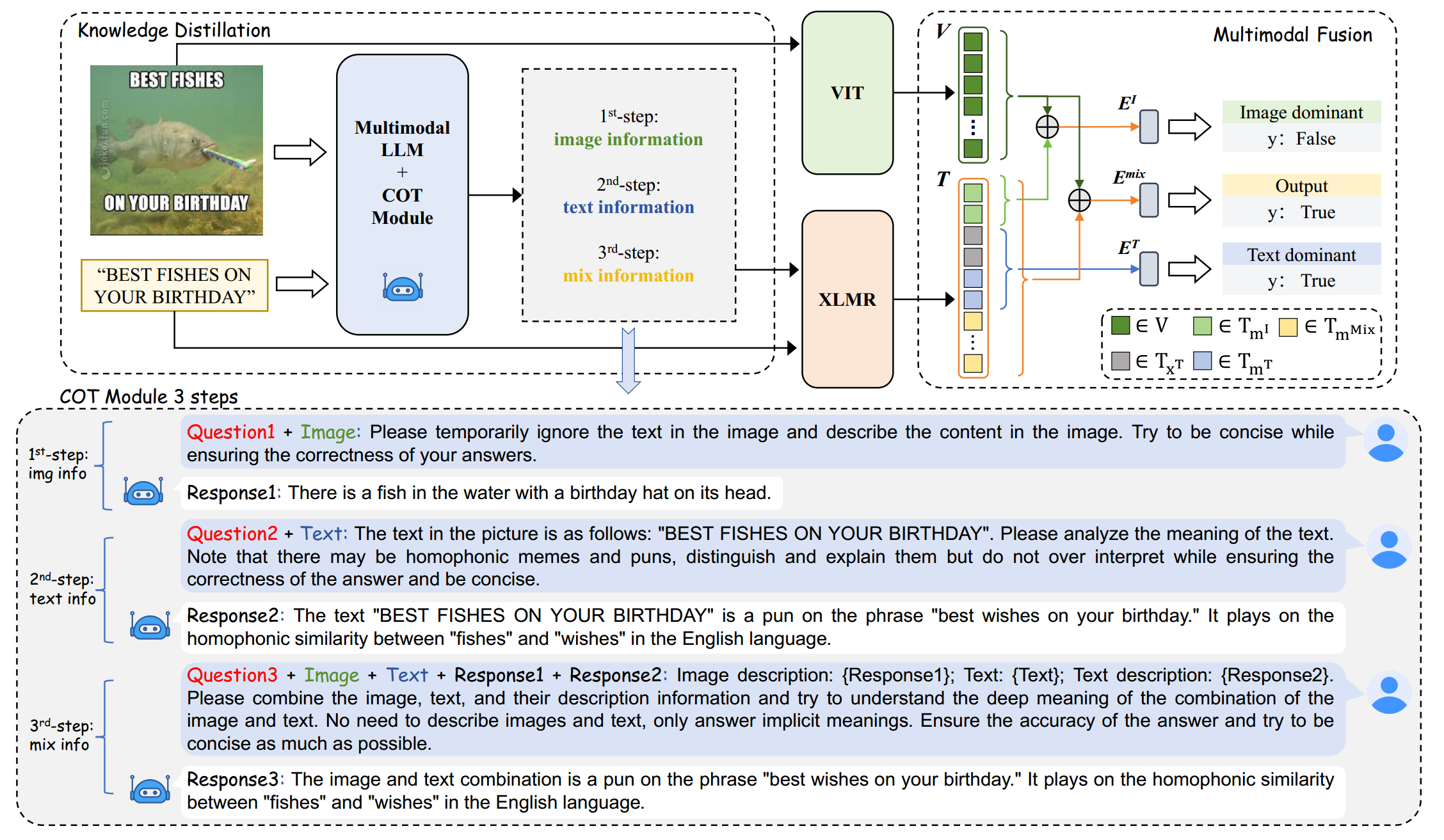

论文分享➲ Exploring Chain-of-Thought for Multi-modal Metaphor Detection | 探索用于多模态隐喻检测的思维链

隐喻在广告和网络梗图中十分常见。然而,网络梗图的自由形式往往导致高质量文本数据的缺乏。隐喻检测需要对文本和视觉元素进行深度解读,需要大量的常识知识,这给语言模型带来了挑战。为应对这些挑战,本文提出了一个名为 C4MMD 的简练框架,该框架利用思维链(CoT)方法进行多模态隐喻检测。

论文分享➲ INTERNET OF AGENTS | 智能体互联网:编织异构智能体网络用于协同智能

是时候给Agent们建立一个属于它们的互联网了

论文分享➲ arXiv2025 | TTRL: Test-Time Reinforcement Learning

Pull LLMs up by its own bootstraps!

论文分享➲ arXiv2025 | TTRL: Test-Time Reinforcement Learning

Pull LLMs up by its own bootstraps!

到底了