简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

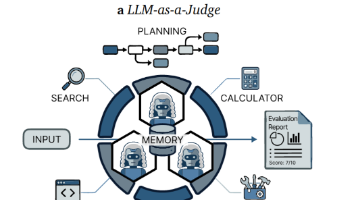

LLM即评委通过利用大语言模型进行规模化评估,彻底改变了人工智能评价范式。然而,随着评估对象日益复杂化、专业化与多步骤化,LLM即评委的可靠性正受到内在偏见、浅层单次推理以及无法对照现实观测验证评估结果的制约。这推动了向智能体即评委的范式转变——智能体评委通过任务规划、工具增强验证、多智能体协作与持久记忆等技术,实现了更鲁棒、可验证且细致入微的评估。尽管智能体评价系统正快速涌现,该领域仍缺乏统一框

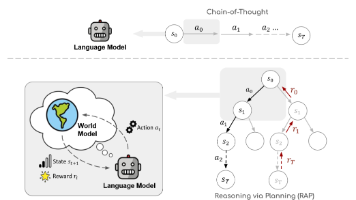

RAP聚合(第3.4节):对于数学推理等仅需最终答案的任务,可运行多次MCTS(不同随机种子),对多条轨迹的答案进行多数投票(majority voting)。,这是因为LLM动作空间巨大且随机,无法像围棋那样枚举所有合法动作(附录A:“对于开放域问题,无法枚举所有可能行动”)。自我评估)在后续迭代中被UCT公式惩罚,实现错误回溯(backtracking of errors)。(包含四维度信号)

通过提示工程构建世界模型的本质,是利用LLM的上下文学习能力,通过精心设计的少样本示例和角色指令,将其从文本生成器重新配置为状态转移模拟器。这一过程不涉及模型参数更新(“我们采用冻结的大型语言模型”,第6节),而是通过提示词c′c'c′的条件分布pst1∣statc′pst1∣statc′实现世界模型的功能。

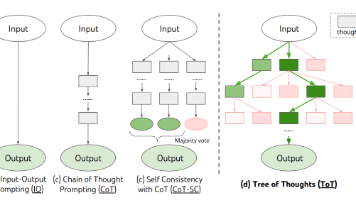

总结:四篇论文构成了从"简单提示"(CoT)到"解码策略"(CoT-SC)再到"搜索与规划"(ToT/RAP)的演进谱系。后续研究需在理论严谨性(如证明搜索/规划的必要性条件)和工程实用性(如降低计算成本)之间寻求平衡。研究背景与动机(原文定位:Introduction, Section 1)研究背景与动机(原文定位:Introduction, Section 1)研究背景与动机(原文定位:Int

该论文提出了一个系统性的LLM推理增强框架,将世界模型与MCTS规划相结合,在特定基准测试上展示了显著性能提升。然而,其理论体系高度依赖LLM作为可靠世界模型和奖励评估器的假设,缺乏对这些关键组件准确率的独立验证,且未充分讨论计算成本与扩展性限制。在工程实践中,其提示工程的复杂性和计算开销可能限制其广泛应用。

大语言模型(LLMs)已展现出卓越的推理能力,尤其是在思维链(CoT)提示的引导下。然而,LLMs有时仍会难以解决对人类而言相对简单的问题,例如在特定环境中生成实现给定目标的行动方案,或执行复杂的数学与逻辑推理。这一缺陷源于一个关键事实:LLMs缺乏内部世界模型来预测世界状态(如环境状态、中间变量值)并模拟行动的长期结果。这使得LLMs无法执行类似人类大脑的审慎规划,即探索替代推理路径、预测未来状

本文摘要: 针对语言模型在复杂推理任务中的局限性,研究者提出"思维树"(ToT)框架,通过系统性探索多路径推理提升问题解决能力。该框架将问题分解为连贯的中间思维单元,允许模型生成多样化候选方案(如独立采样或顺序提议),并引入语言模型自我评估机制作为搜索启发式。实验表明,在24点游戏(成功率从4%提升至74%)、创意写作和填字游戏中,ToT显著优于传统思维链方法。该研究融合了人类

作者明确指出的核心问题位于Introduction第1段与第2段:瓶颈一(决策机制限制):当前LLM(如GPT-4、PaLM)受限于"token-level, left-to-right decision-making",即自回归的逐词元从左至右决策模式。作者声称此模式在应对需要exploratory reasoning(探索性推理)、strategic lookahead(策略性前瞻)或init

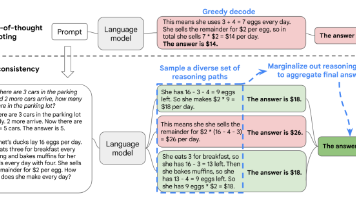

本文提出了一种新的解码策略"自洽性"(Self-Consistency),用于改进思维链(CoT)提示中的贪心解码方法。核心观点是:复杂推理问题存在多种正确推理路径,通过采样多样化路径并选取最一致的答案,可显著提升推理准确性。该方法完全无监督,无需额外训练或标注。实验表明,在算术和常识推理任务上,自洽性相比贪心解码取得显著提升(如GSM8K +17.9%),且对采样参数和模型规

本文提出"自洽性"解码策略,通过生成多样化推理路径来提升语言模型的推理能力。该方法首先采样多条思维链,然后选择最一致的答案。实验表明,在算术推理(GSM8K提升17.9%)和常识推理(StrategyQA提升6.4%)等任务上,自洽性显著优于传统贪婪解码。该方法无需额外训练或标注,可直接应用于预训练模型,为复杂推理任务提供了简单有效的解决方案。