简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

把图像 embedding 线性或非线性投影到语言 embedding 空间,让语言模型把图像当成前缀上下文一起处理。这样模型结构简单,推理快,还能发挥 LLM 强大的语言理解与推理能力。如果你想,我也可以画张图解释它和 Q-former 或 cross-attention 的对比流程图~4o。

Problem || Answers || Solutions # DeepScaleR用的ORM而非PRM,通过final result来奖励。看来训练推理框架都脱离不开Verl。训练集大约40.3k条。

正在看,发现很灵魂讲的!比如,他会穿插一些基本思考(如图所示),方便大部分DLer去学习RL的思维转型。#与上一篇一样,只不过这个是原文,vx-gzh的排版更舒服。GRPO\PPO #以下我都强烈推荐看!

在计算机视觉与自然语言处理交叉领域中,指代表达理解(Referring Expression Comprehension, REC)一直是研究的关键方向。这一任务要求模型能够基于自然语言描述,在图像中精准定位相应的目标对象。然而,传统视觉模型在面对多实例指代任务时表现出明显局限:大多数仅针对单一实例优化,难以应对现实世界中"一条指令对应多个目标物体"的复杂场景。这种局限源于传统模型对语言理解的浅层

尝试加入B友的工作,或者进入百度技术生态部实习或工作,原因是这个工作有利于phd期间工作的进展。艾兄有百度生态技术部b站搞llm机器人那个哥们儿的微信。和梓行哥讨论 机器人LLM训练{① 仿真环境 ② 训练过程 ③ 数据集 ④ 相关资料 ⑤ 算力配置 ⑥ 是否能搭建积木或者造房子}看到Bilibili有个百度技术生态部的老哥做的实物。交流:宋老师、通研院、上交积极问问题老哥(腾讯RobotsX)做

Uniapp适用领域搞外包可以,做持续可维护高质量的产品,不太适合。Unia2021年了,uniapp发展的怎么样了?来自某乎用户()[1]:从19年将信将疑接触,到2020年一边写一边骂,到现在,我基本认可。认可的原因:1、技术选型方面:公司产品有全平台运营的需求,前端技术多基于vue开发,且有成本要求,所以在多次选择中都把它作为首选。如果只需要做app的话,其实有很多其他的替代方案,像weex

突然心血来潮,想到卡尔曼滤波器是否能和深度学习结合。于是从谷歌学术上搜了一下,发现现在这方面的工作还没有太多结合。Top 期刊 TNNLS 2021 有一篇最新工作。ICLR 2020 出现一篇 Kalman Filter Is All You Need 的文章,但目前从开源的审稿意见来看,凶多吉少。其余的,大部分出自于一个 Guy Revach 学者(团队)。...

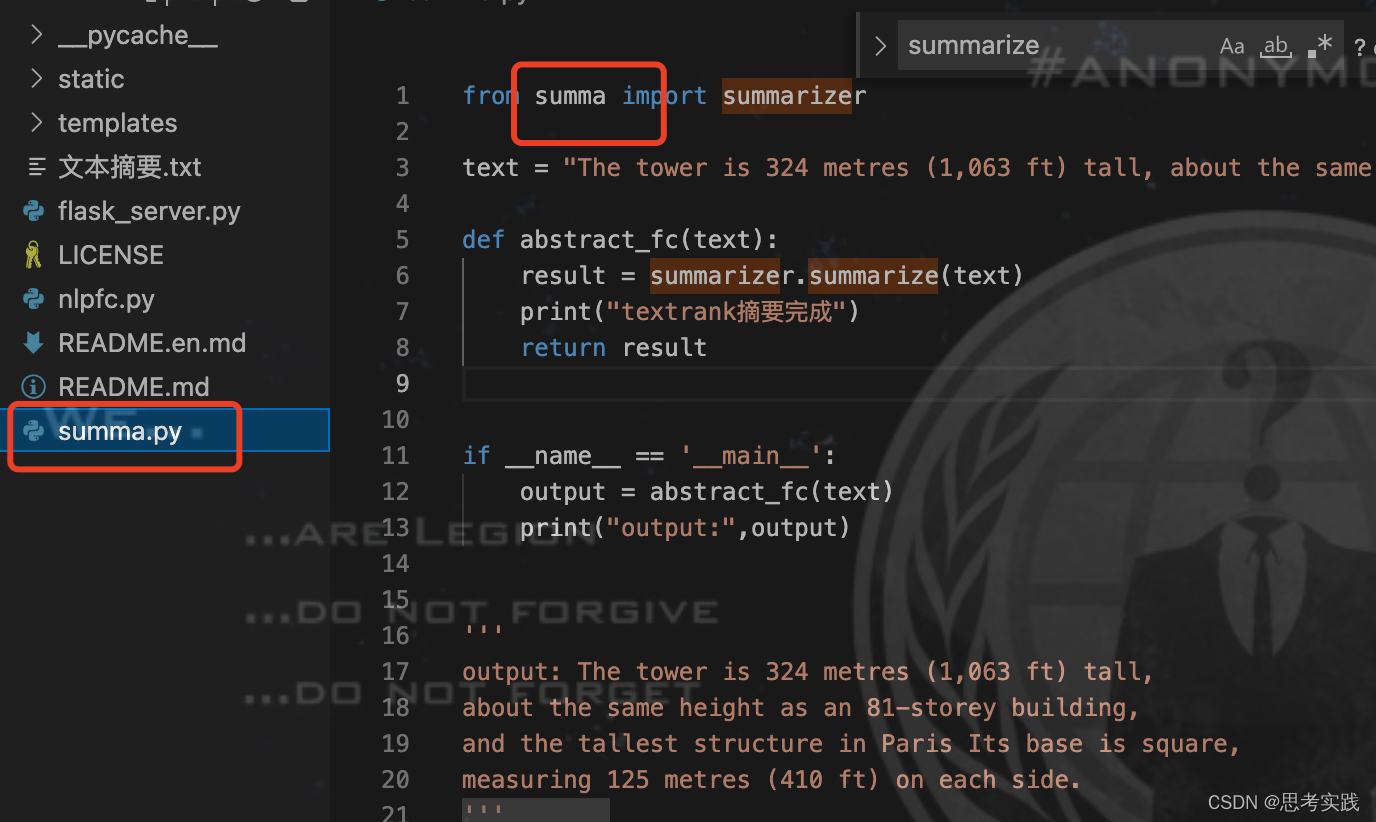

这里我补充一个情况,这个错误应该属于常识错误,但今天还是踩到了,和大家分享一下下。我导入的包名称不能与我的文件名称相同,否则就会报这样的错ImportError: cannot import name 'summa'更一般的情况也给大家分享:ImportError :cannot import name xxxxxx 的三种类型的解决方法_Activewaste-CSDN博客_cannot imp

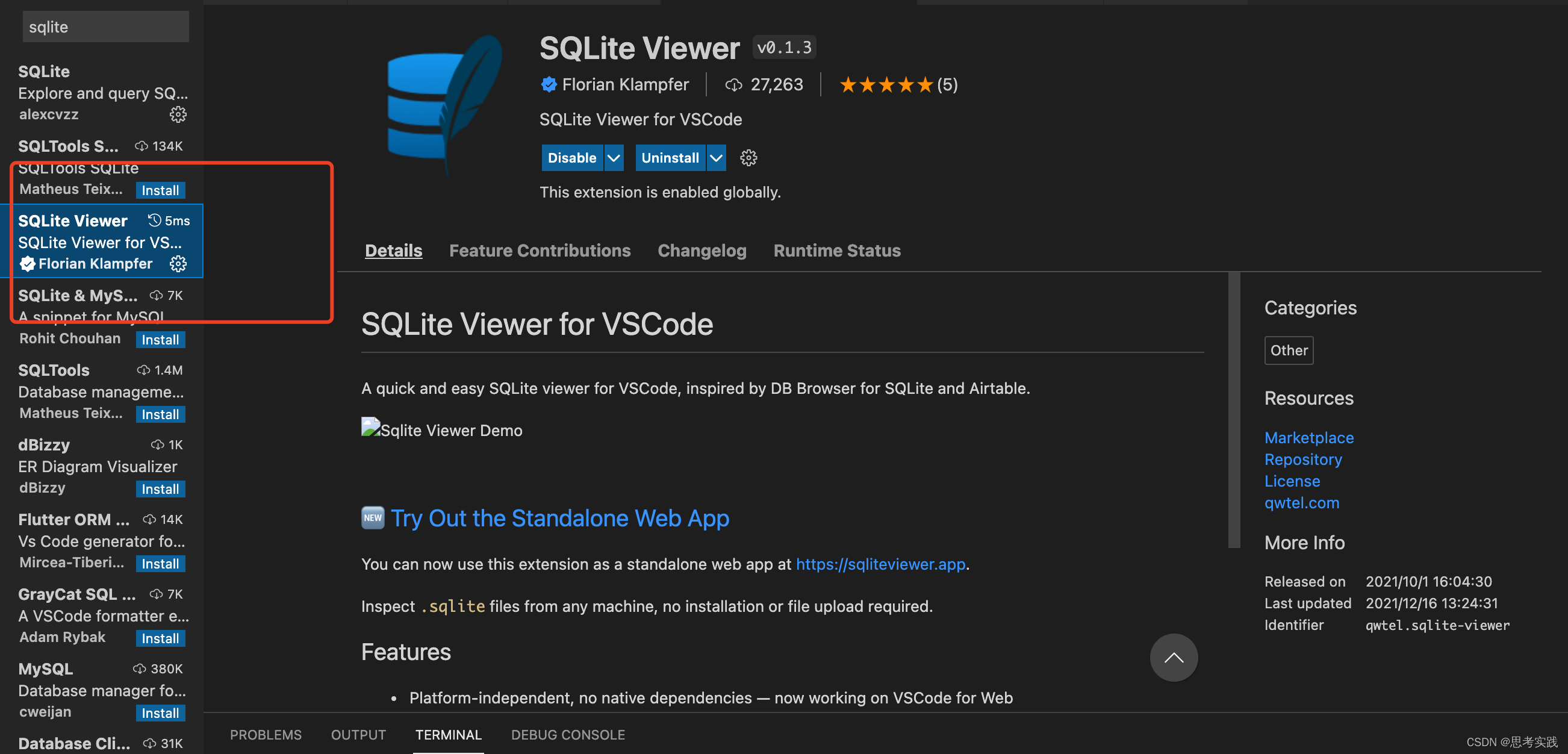

直接去插件市场下载一个SQLite Viewer就行了

数据挖掘课程讲到的算法,太忙了,先填个坑,回头填。DHP algorithmis an optimization of A-priori algorithm.So what's the shortage of A-priori?参考资料数据挖掘关联规则挖掘改进算法DHP_音程的博客-CSDN博客_dhp算法关联规则DHP算法详解_北望花村-CSDN博客_dhp算法...