简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

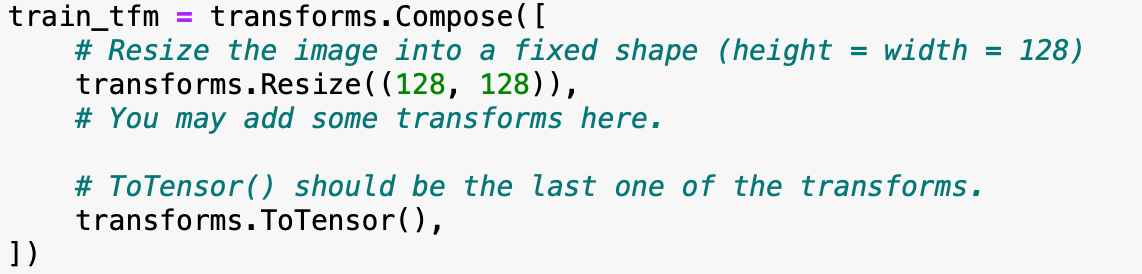

李宏毅2023机器学习作业HW02解析和代码分享

李宏毅2023机器学习作业HW02解析和代码分享

李宏毅2024生成式人工智能导论 中文镜像版指导与作业

这里是李宏毅老师2024年生成式人工智能导论的大陆镜像版的索引文章,你可以在不翻墙的情况下完成课程的所有作业。制作与分享已经获得李宏毅老师的授权,非常感谢老师!

PEFT微调:在大模型中快速应用 LoRA

你将了解到:peft 和 lora 之间有什么关系?get_peft_model 怎么使用?如何知道应用 LoRA 后模型的参数变化量?如何使用 `merge_and_unload()` 合并 LoRA 权重?认识报错:`TypeError: Expected state_dict to be dict-like...`

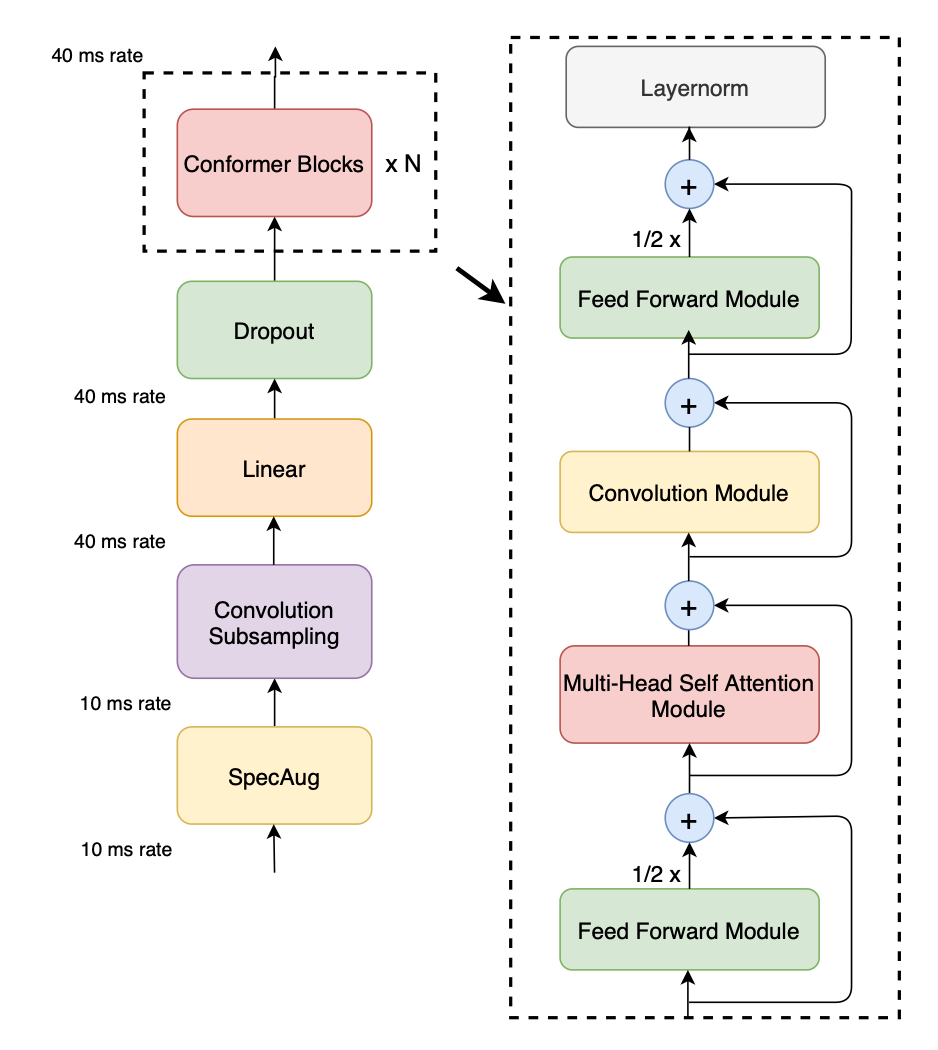

李宏毅2023机器学习作业HW04解析和代码分享

李宏毅2023机器学习作业HW04解析和代码分享

李宏毅2023机器学习作业HW06解析和代码分享

李宏毅2023机器学习作业HW06解析和代码分享

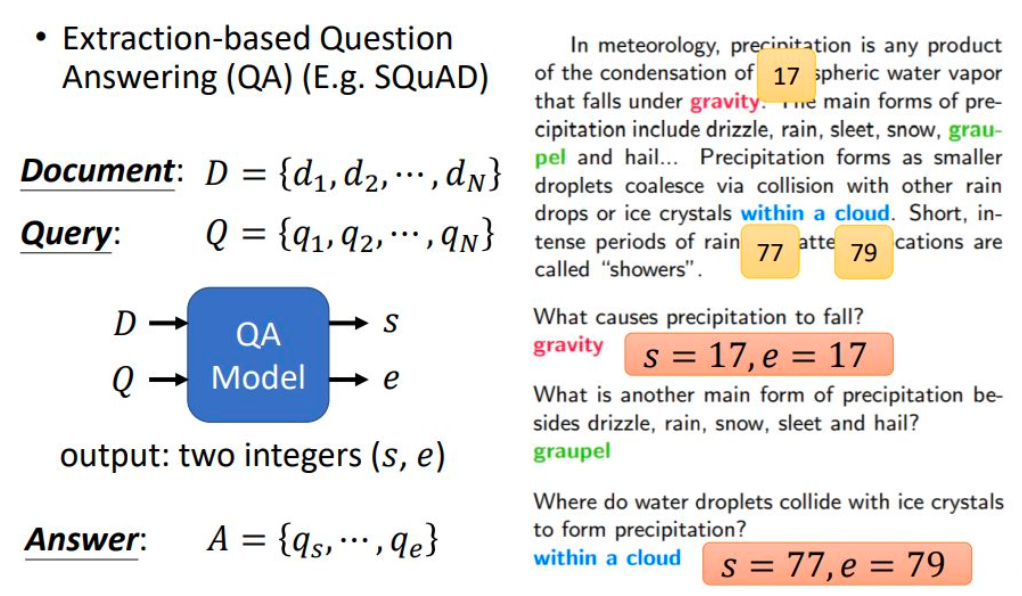

李宏毅2023机器学习作业HW07解析和代码分享

李宏毅2023年春机器学习课程作业7的引导与代码分享

生成式人工智能导论 Homework 02 样例展示

生成式人工智能导论(INTRODUCTION TO GENERATIVE AI 2024 SPRING) Homework 02 样例展示

李宏毅2023机器学习作业HW05解析和代码分享

李宏毅2023机器学习作业HW04解析和代码分享

李宏毅2023机器学习作业HW03解析和代码分享

李宏毅2023机器学习作业HW03解析和代码分享